2024年末から2025年初頭にかけて、OpenAIの推論モデルo1とo3の登場により、AGI実現への期待が一気に高まった。しかし2025年後半には、推論能力の汎用化の限界、推論時間スケーリングのコスト制約、強化学習の効率問題などが明らかになり、予測は再び保守的な方向へと振れた。技術的進歩は依然として継続しているものの、AGI実現には当初の期待よりも時間を要する可能性が高まっている。それでも、かつて数十年先と考えられていたAGIが、今や10年以内に実現すると多くの専門家が予測する状況は、依然として驚くべき変化である。

推論モデルの登場と短期予測の高まり

AGI、つまり汎用人工知能へのタイムラインについてお話ししましょう。2024年末から2025年初頭にかけて、OpenAIが史上初の推論モデル、すなわちo1とo3をリリースした後、変革的な汎用人工知能への短期タイムラインがAI業界を席巻しました。

しかし2025年後半になると、奇妙なことが起こりました。世論は完全に逆方向へと振れ、AIが本当に世界を揺るがすかもしれない時期についての人々の予測は、そもそも推論モデルが登場する以前よりもさらに先へと延びてしまったのです。

一体何が起こったのでしょうか。単なる雰囲気やムードの変動だったのでしょうか。混乱でしょうか。それとも、根本的に予想外の研究結果が連続して出たということでしょうか。私自身もこのことを理解しようと努めてきましたが、ここで私が考え出した最良の説明をお伝えします。

o1やo3のような推論モデルは、AI企業の内部でも、外部の一般社会でも、大きな影響を及ぼしたようです。サム・アルトマンは昨年1月、「私たちは今、AGIの構築方法を知っていると確信している」と宣言しました。DeepMindのデミス・ハサビスは、通常はもっと慎重なのですが、AGIはおそらく3年から5年先だと述べました。

そしていつものように、AnthropicのDario Amodeiが最も色彩豊かな言い回しをしました。彼は「データセンターの中の天才たちの国」を発表し、今後2年から3年以内にそれを手に入れる可能性が高いと述べたのです。

また、AI 2027として知られるAGIシナリオも大規模に取り上げられました。このシナリオでは、2027年にAI研究開発が完全に自動化され、それが強力な再帰的自己改善ループにつながり、いわゆる「知能爆発」が起こるというものです。この物語への大規模な報道と関心は、確実に雰囲気を変えました。私が働いている80,000 Hoursでさえ、AI 2027のストーリーについて動画を作り、とんでもない数の再生回数を獲得しました。正確な数字は言いませんが、この動画を投稿する頃には確実にもっと増えているでしょうから。

ある程度、このすべての誇大宣伝は、人々が実際に信じていたことよりも少し先走っていました。AI 2027シナリオを発表したとき、その執筆者たちは、AIについて合理的に考えられる限り最も強気な人々でしたが、それでも彼らは、実際には彼らのストーリーで起こることよりも1年半後まで、超人的なコーダーは現実には手に入らないだろうと考えていました。

しかし人々は本当に興奮し、そして再び考えを変えたのです。では、それを引き起こしたいくつかの技術的要因を見ていきましょう。

推論の汎用化への期待と現実

推論モデルが登場したとき、私を含む多くの人々が非常に興奮した理由は、謎でも何でもありません。それらが登場したとき、前世代のAIがひどく失敗していた多くのことを、突然できるようになったと感じられたからです。

しかし、時間が経つにつれて、その輝きが薄れていったのはなぜでしょうか。業界内の人々やAI愛好家の間での希望は、数学やコーディングのように簡単にチェックできる領域での強化学習が、正しい答えを得たかどうかをチェックするのがはるかに難しい、より混沌とした他の領域にも汎用化するだろうというものでした。

人々はこれが機能するかもしれないと期待する傾向がありました。なぜなら、指示に従い、ユーザーに役立つようにモデルを微調整することは、ユーザーがAIモデルに求める傾向のあるほぼすべての異なることに対して、驚くほどうまく汎用化していたからです。

しかし2025年が進むにつれて、推論の汎用化では同じことが実際には起こっていないことが明らかになりました。推論するように最適化された推論モデルは、数学や論理やコーディングではるかに優れていましたが、突然それらから外挿して、例えばフライトを予約したり、実際に機能するイベントを企画したりすることはできませんでした。

あるAI企業の上級スタッフメンバーが最近私に語ったところによると、この全体的な経験により、彼は実際にはAGIへのタイムラインを長く見積もるように更新したそうです。なぜなら、それまでは、簡単にチェックできる領域からチェックできない領域への汎用化の可能性が、本当に急速な、おそらく予想外に急速な能力の向上への一つの実現可能な道だったからです。そして今、彼はそれが基本的に除外されたと見ていたのです。

多くの人々は、この自律性の問題が、AnthropicのClaude Opus 4.5とClaude Code、そして2026年1月時点でのClaude Coworkの登場により、今まさに変化しつつあると考えています。しかし、たとえそれが人々が期待し、一部の人々が予想しているほどうまくいったとしても、それはAnthropicがこれらの自律性タスクに特化してモデルを訓練したからであって、当初私たちがある種無料で得られると期待していた推論タスクからの魔法のような汎用化のおかげではありません。

推論時間スケーリングの限界

推論モデルが特定の種類の問題を解決する際にはるかに優れた結果を出すようになった大きな理由は2つあります。

1つは、実際に推論がより優れていること、つまり基本的により賢く、より論理的で、かなりの時間スレッドを維持できるようになったことです。もう1つは、尋ねられた各質問について考える時間がはるかに長く与えられたことです。以前のモデルはほとんど考える時間を与えられておらず、質問されたときに頭に浮かんだ最初のことをほぼそのまま口に出すだけでした。

推論モデルの初期には、最初のこと、つまり実際により賢くなることと、2番目のこと、いわゆる「推論時間スケーリング」のどちらがどれだけの働きをしているのか、見分けるのがかなり難しかったのです。そしてその質問は非常に重要でした。なぜなら、何かに答えてもらいたいたびにLLMに長時間考えさせるのは、本当に高価だからです。

重要なのは、2024年と2025年に考える時間を大幅に増やすことができたのは、基本的にゼロから始まっていたからです。しかし、モデルにゼロ分の考える時間から1分の考える時間へと増やすことは手頃でしたが、少しでもより良い答えを出すためにモデルに10分や100分考えさせるだけの十分なコンピュータチップが世界には実際にはありません。少なくとも通常の状況ではそうです。そしてこの事実により、考える時間を増やすことによる利益は、2024年から2025年、そして2026年と2027年へと続いていける傾向ではなく、一回限りのものになってしまうのです。

そして実際、推論モデルの性能向上の3分の2以上は、モデルにより多くの考える時間を与えることから来ていたようです。残念ながら、これは私たちが再び引き出せる技ではありません。少なくとも、実際により多くのより高速なコンピュータチップを製造しに行くまでは。それは起こりますが、以前に考える時間をスケールアップできた速度とは比べ物にならないほど遅いのです。この認識により、アナリストたちは今後のAI能力の向上がより遅くなると予想するようになりました。

番組の過去のゲストであるToby Ordが、私が知る限り、この件についての最良の公開分析を行っています。企業内で数字の多くが機密扱いなので、少し難しいのですが、彼は見つけられるものから物事を解明し、番組ノートにそれらの記事のいくつかへのリンクを掲載します。

また、METRという組織から出された、AIがますます長いソフトウェアエンジニアリングタスクをすべて正常に完了できることを示す非常に影響力のあるグラフを覚えているかもしれません。さて、これは絶対に真実ですが、その大きな部分は、これらのタスクを完了しようとするために、以前よりもはるかに多くの考える時間がモデルに与えられることによって駆動されています。そのため、完了できるタスクの長さの指数関数的な増加は、それに見合った指数関数的なコストの増加を伴っており、場合によっては、これらのAIエージェントを1時間実行するコストは、実際に人間のソフトウェアエンジニアを雇うコストとほぼ同じくらい、実際には数百ドルかかるかもしれません。

そしてその価格では、考える時間をさらに10倍にスケールアップして、数千ドルや数万ドルにすることは、経済的に合理的ではありません。少なくとも当面はそうです。ですから、これは2026年と2027年の進歩が、2025年に見たのと同じペースで必ずしも来ないだろうと考える理由なのです。

強化学習のコスト効率の問題

以前のように考える時間をスケールアップできなくなったように見えましたが、代わりに推論訓練をスケールアップできるかもしれません。これは、質問があるたびに支払わなければならないコストというよりは、固定費に近いものです。

残念ながら、それも2025年初頭に人々が期待していたほどうまく機能していないことが判明しました。AIモデルの訓練の詳細は商業的に非常に機密性が高いため、正確に特定することは難しいのです。だから彼らは文字通り、あなたが持ちたいと思うかもしれない数字を公開しません。しかしToby Ordは、この種の強化学習の計算効率は、「次の単語を予測する」時代や事前訓練時代と比べて、文字通り100万分の1程度かもしれないと推定しています。想像できるように、これは非常に大きなペナルティです。

この方法の問題は、強化学習がAIに本当に難しいコーディングや数学や哲学の問題を解決する試みをたくさんたくさん生成させることで機能することです。そして、正しい答えを得ることができたときはいつでも、私たちは「素晴らしい、その通り。その時やっていたことをもっとやりなさい」と言います。

これは明らかに機能します。モデルはこれらの領域ではるかに優れたものになりました。しかし、比較的控えめな量の教育や学習を絞り出すには、多くの計算が必要なのです。

その理由は、本やインターネットの投稿やGitHubなどから収集された蓄積された人間の知識でモデルを訓練するのとは異なり、ここではAI自身が学習しようとしているコンテンツを作成しなければならないからです。これには、最終的にどこにもつながらない問題を解決しようとする膨大な数のゴミのような、失敗した試みを作ることが含まれます。そして、これらの各試みの最後に、AIが得るのは「正しい答えを得た」または「間違った答えを得た」だけです。しかし、多くの場合、彼らは何百ページにもわたって推論しています。推論のどの部分が間違った方向に進んだ部分だったのでしょうか。または、正しい答えにつながる突破口を開いたセクションはどの部分だったのでしょうか。そのようなことについての指導は得られません。

誰かがこのすべてを、AIが小さなストローを通して知性を吸い込もうとしていると印象的に表現しました。

結論は、この種の確認可能な領域での強化学習をゼロから今の状態にすることで、能力の大きな向上を得ましたが、強化学習をさらに1000倍スケールアップして、同様に大きな性能の飛躍を得るための、世界中のコンピュータチップが単に存在しないということです。

振り返りと今後の展望

要約しましょう。はい、考える時間をスケーリングすることで大きな性能向上を得ました。そして、数学やコーディングなどでの強化学習をスケーリングすることから多くの価値を得ました。しかし、2025年を通じてこれらの他の事実が明らかになるにつれて、人々は2026年の進歩が2025年までと同じくらい速いままであるとは信じなくなり、それが悲観主義の波につながりました。

私は人々の意見がなぜ変わったのかを説明しようとしてきましたが、正直に言うと、その推論の筋道が正しいと本当に確信しているわけではありません。そしてそれは、AI企業が常にパフォーマンスを向上させるために1つのことをスケールアップし、それが収穫逓減に達するまで続け、その後スケールアップする別の何かを見つけるからです。

彼らは有名なことに、次の単語を予測するためにモデルの訓練に投入される計算を大規模にスケールアップし、それは素晴らしく機能しました。しかし、10倍、100倍、1000倍とスケールアップするにつれて、収穫逓減に達し始めました。

その後、より大きな焦点は、実際にあなたのために物事を行う有用なアシスタントのようにモデルを動作させるために、人間のフィードバックからの強化学習をスケールアップすることになりました。そしてそれは素晴らしく機能しました。大きな違いをもたらしましたが、それもまた収穫逓減に達し始めました。

そのため、彼らは自然に、私が説明してきたように、推論時間スケーリングと推論のための強化学習に計算を投入することに移行しました。個々のものは、10倍、100倍、1000倍、10000倍とスケールアップするにつれて、リターンは常に先細りになります。しかし、常に移行する別の何かがある限り、全体像のトレンドは、これまで見てきたような着実な改善のままであり続けるでしょう。

彼らの研究チームが、コンピュータチップをより賢く、より有用で、より能力の高いAIモデルに効率的に変換する他の方法を熱心に考え出そうとしていることは確かです。それが彼らの研究の全体的な仕事です。彼らは4回目または5回目に再び成功するでしょうか。それとも、今のところトリックを使い果たし、数年待つ必要があるかもしれませんか。それは、企業の内外のすべての人が、多かれ少なかれ繰り返し推測することを余儀なくされている根本的な未知数です。成功するか失敗するまで。

技術的更新以外の懸念事項

以上がいくつかの技術的更新、新しい技術的結果でした。しかし、人々が常に抱いていた多くの懸念が、2025年後半にさらに顕著になりました。私にとって目立ついくつかを挙げましょう。

第一に、その期間にわたって、AIモデルがデモで何ができるように見えるかと、実際にほとんどの職場や私たちの周りの世界や私たちの個人的な生活をどれだけ覆しているかとの間に、ますます大きなギャップがありました。この奇妙な状況は、ポッドキャスターのDwarkesh Patelによって次のように要約されました。「モデルは短期タイムラインの人々が予測する速度でより印象的になり続けているが、長期タイムラインの人々が予測する速度でより有用になっている。」

このギャップの拡大により、アナリストや人々は、画面上で話しているときに本当に印象的に見えるものが、実際の状況でどれだけの違いをもたらし、生産性を向上させることができるかについて、基本的に自分自身の判断を信頼し始めました。

実際のアプリケーションへの転移の失敗の1つの理由は、2番目のポイントかもしれません。AIは明らかに人間と同じ方法で学習しません。私たちの弱点が何であれ、人間は基本的にわずか数サンプルで本当にすぐに物事が上手になります。また、時間の経過とともに新しい知識と新しいスキルを構築し、蓄積します。AIがそれをしないので、新しい人間の雇用とは異なり、仕事で何が機能し、何が機能しないかを理解する最初の数ヶ月ではるかに能力が高くなるのではなく、本当にすぐにプラトーに達してしまいます。

一部の人々は、このいわゆる「継続学習」を解明することが、AIからはるかに多くの有用性を引き出す鍵だと考えています。しかし注目すべきことに、2025年にはそれについての目に見える進歩はあまり見られませんでした。ですから、一部の人々にとって、それもまた弱気の指標でした。

AI研究開発の自動化

最後に、特にAI研究開発の自動化について話しましょう。それは、この会話で特に大きく立ちはだかっています。なぜなら、それを完全に自動化できれば、再帰的自己改善ループを開始できるかもしれないからです。AIがより良いAIを設計し、それらがより良いAIを設計し続け、かなり早く人間は背景に消えていき、徐々にAI開発にほとんど関与しなくなります。

私の意見では、そしてほとんどの人々の意見だと思いますが、完全に自動化されたAI研究開発を実現できれば、本当に大きな出来事になるでしょう。しかし、人々が悲観主義に傾くにつれて、これらのタスクタイムライン研究でAIがソフトウェアエンジニアリングでより優れたものになっても、完全に自動化されたAI研究開発に特にすぐにつながらない理由についての議論がいくつか再浮上し、はるかに多くの議論を呼びました。

第一に、AI企業は主にソフトウェアエンジニアで構成されているわけではありません。他にもたくさんのことが起こっています。特に私たちが考えているケースでは、人工知能について考え、実験することの他の側面は、ソフトウェアエンジニアリングではありません。ですから、私たちがこれらのベンチマークでテストしているもの、つまりソフトウェアエンジニアリングが効果的に無料で無制限で即座にできるようになったとしても、AI研究開発のプロセス全体はかなり早く他の場所でボトルネックになり、ごくわずかにしか高速化されなかったかもしれないと言えます。

第二に、AIを改善するにつれて、さらなる改善を見つけることがますます難しくなります。なぜなら、すべての同様のもののように、私たちは低く垂れ下がった果実を摘み取ったからです。そしてそれは、潜在的に、過去にあったのと同じ進歩の速度を維持するために、実際には多くのAI支援とツールが必要だということを意味します。ですから、今AI企業で、そのコードのほぼすべてがAIによって書かれていることを観察すると、90%、95%ですが、おそらくそれがやっていることのすべては、最初に聞いたときにあなたが素朴に期待するような速くなることではなく、以前にあったのと同じ研究速度を維持することを可能にしているだけかもしれません。

この最後のポイントはかなり重要で、パンチを効かせることができます。AI 2027シナリオの背後にいる人々は、1年前の最初のモデリングラウンドでこの要因を見逃し、最近の更新でそれを考慮に入れることで、彼らのタイムラインを1年から2年押し出しました。あれらの人々にとって、物事がどれほど迅速に進むと予想しているかを考えると、それは実際にはかなり大きな調整です。

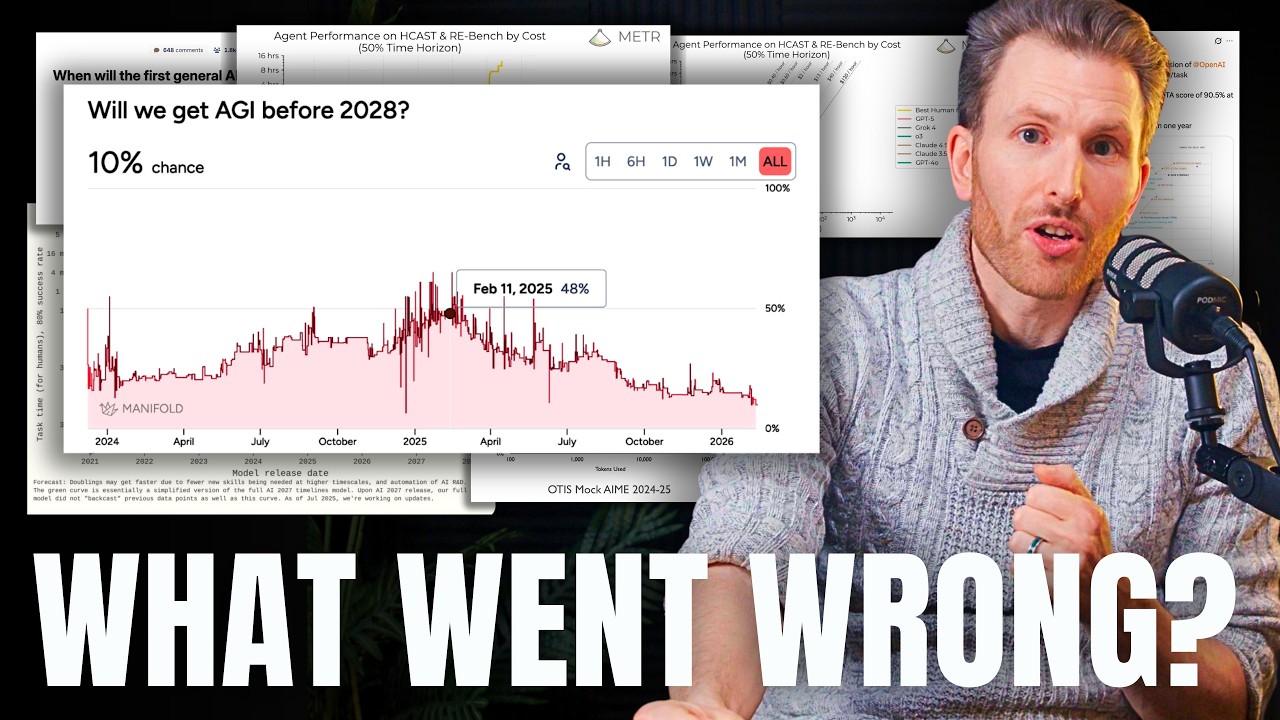

予測市場の変化と重要な時間枠

では、これまで話してきたこれらすべての更新の結果は何だったのでしょうか。2025年の初めに、予測市場Metaculusの予測者たちは、強力なAGIの到来を2031年7月と予測していました。つまり、彼らは中期タイムラインの人々だったと思います。その予測は2033年11月に移動しました。これは1年の間に起こった2年半の延長であり、AI業界のムードをかなり反映していると思います。壊滅的ではなく、莫大な遅延ではありませんが、人々は確実に、2025年の初めに考えていたよりも数年長くかかると考え始めました。

すでに聞いたことがないなら、記憶にしまっておく価値のあることが1つあります。それは、2028年から2032年の期間が、AGIまたは再帰的自己改善AIを開発するための非常に重要な、成否を分ける期間になる可能性があるということです。

その理由は、その時点まで、AI業界は、以前は人工知能に関係のないことに向かっていたり、取り組んでいたりしたコンピュータチップや電力や技術的なものを吸い上げることによって、投入されるインプットを大幅に拡大することができるからです。しかし、これらのインプットの現在の成長率が続けば、2032年までに、AIはすでにすべてのコンピュータチップと電力と技術スタッフの大きな部分を占めるようになり、世界の他の部分から吸収する余裕はそれほど残っていないでしょう。

そしてその日までに、資金調達でさえもかなり厄介になる可能性があります。なぜなら、次のスケールアップは、訓練に1兆ドル、または10兆ドルかかる単一のAIモデルになるかもしれないからです。AIがその時点までに本当に人々を圧倒し、大規模に人間の労働を置き換えることを投資家に納得させていない場合、それがうまくいくかどうかわからないのに投じるには多額のお金です。

これは、たとえ2032年までに起こらなかったとしても、最終的にAGIを開発しないということを意味するわけではありません。ほぼ確実に開発するだろうと思います。おそらく少し遅い粉砕作業になるだけでしょう。そしてそれは、とりわけより多くの計算能力へのアクセスを得ること、コンピュータチップを製造するより多くの工場を建設すること、より多くのチップを製造すること、そしてそれらのチップのそれぞれをより効率的にすることによって推進される粉砕作業になるでしょう。そしてそれは通常のことの枠組みでは急速な進歩ですが、これまでこれらすべての異なる種類のインプットを拡大することができたほど速くはありません。

別の物語:AI進歩停滞説への反論

私は、テクノロジー業界の人々が2025年初頭にAGIタイムラインを大幅に前倒しし、その後年の後半に再び大幅に押し戻した理由を理解しようとしてきました。

しかし、より広い社会では、私が議論してきたこととほとんど相互作用しないように感じるAIについての全く別の物語を見つけることができます。これは特にメディアや学術タイプの間で循環していると思う物語です。そしてそれが語る話は、GPT-5はAIの進歩がほぼ停止したことを示す大失敗であり、いずれにせよ、AIは人々をより生産的にせず、基本的に役に立たないというものです。その上、それは人々が支払う意思があるか、今支払っているよりも多くのコストがかかり、おそらくAI企業はビジネスモデルが非常に悪いため、いつでも破産の危機に瀕しているかもしれません。

これは明らかに完全に見当違いだと思う視点であり、私がそう考える5つの理由を挙げます。

第一に、Epoch Capabilities Indexです。Epochは素晴らしいシンクタンクで、AI能力、インプットなどについて多くのデータを収集しており、このトピックに興味があるなら絶対にチェックすべきです。彼らは、個々の結果を恣意的に選ぶのではなく、測定できる限り遡って、できるだけ多くの異なるAIモデルをできるだけ多くの異なる能力ベンチマークで見ようとしています。そして彼らは、どちらかと言えば、AI進歩が近年加速していることを発見しています。彼らは、任意の時点で利用可能な最良のAIモデルの性能が、2024年4月以降、以前よりも2倍速く増加したと報告しています。

より長期的なグラフを見ると、おそらく単なる線形増加だと言えるかもしれません。2022年と2023年にはそれほど多くのデータポイントがなかったので、少し言いにくいです。そして、進歩の速度に本当に倍増があった場合、おそらくその多くは、以前に話した推論時間スケーリングによるものでしたが、これはおそらく同じペースで維持できないものです。しかし、これは基本的にAI進歩が減速したという考えを、完全に停止したというのは言うまでもなく、本当に除外していると思います。インデックスはGPT-5および他の最近のモデルを、その最近のより速いトレンドのちょうど真ん中に位置づけています。

ですから私の解釈は、センチメントのすべてのノイズの多い揺れの背後で、人々が突然楽観的になったり、ひどく悲観的になったりする中で、AIは月に行くこともなく、壁にぶつかることもなかったということです。代わりに、何年も前から毎月少しずつ、しかし容赦なく、より有用になってきただけなのです。

私の2番目の議論は、これらのモデルを使用している私の経験から来ています。時々、AIは役に立たない、人々はそれを望んでいないと言う人々を聞きますが、私は彼らが一体何を吸っているのか聞きたくなります。私は今、副操縦士や思考パートナーとして、効果的に1日何時間もAIを使用しています。それにより、物事をより早く理解し、より速く学び、理解していないことに正確に指を置いて、その答えを得ることができます。また、単調な作業をはるかに速く完了させ、より興味深いことに移れるようにしてくれます。

また、非常に多くの人々が発見したように、健康問題、財務計画の質問、社会的状況、頭の中で熟考していることについてのアドバイスを得るのに最適な場所です。最近、私が長い間抱えていた鼻づまりの問題を診断するのに役立ちました。おそらく何が問題なのかを理解し、それをほとんど取り除くために何をすべきかを理解しました。

確かに、通常、これらのことについての最良の人間の専門家ほど良いまたは信頼できるわけではありません。しかし、ほとんどの場合、私たちのほとんどは、最良の医師や財務アドバイザーやセラピストやその他の人々に、ほぼ無料で、好きなだけ話をしてもらうことはできません。

これは2024年末からの大きな変化だと思います。当時、私はこれらのモデルを実用的に活用する方法を見つけるのに苦労していました。紙の上では印象的に見えたにもかかわらず。

ですから、時々、人々の印象が単に時代遅れになっているのではないかと思います。そして、彼らがAIが好きではないと決め、その時点以降試すのをやめ、今実際の最先端のモデルにお金を払う意思がない場合、それは彼らがAIが実際に何ができるかに遅れずについていくことを妨げるかもしれません。これがこの種の態度に対して私が与えることができる最も寛大な説明だと思います。

コストパフォーマンスの改善

第三に、これは本当に重要なのですが、以前私は、どこにでも存在する最先端の推論とエージェント能力の計算と財務コストの増大を強調しました。そして、最も最先端のAIエージェントは、人間のソフトウェアエンジニア以上の運用コストがかかるかもしれないと指摘しました。しかし、最先端に近い能力は、しばしばはるかにはるかに安価です。例えば、Gemini 3 Flashは、ほとんどのタスクでGemini 3 Proの数パーセントポイント以内の性能を発揮し、実行コストはわずか4分の1です。また、質問にはるかに速く答えるので、多くの人々はその理由だけでそれを好みます。

そして、テールの外に出るほど、これらのコスト削減はより極端になる可能性があります。昨年、番組を定期的に聴いている人々は知っていますが、私がToby Ordと議論したのは、2024年後半にOpenAIが非常に難しい推論ベンチマークであるARC-AGI-1を、テストの質問ごとに完全に4,500ドルの計算費用を費やして合格したことです。モデルは、これらの質問に答えようとして、ブリタニカ百科事典の長さのノートを書きに行くのです。あなたや私が実際には非常に簡単に答えられる質問です。

さて、1年後、OpenAIは11ドルで同じ性能を達成し、400倍の減少を遂げました。ですから、基本的に、最先端には非常に急なコストパフォーマンス曲線がありますが、私たちのほとんどは絶対的な最先端を必要としません。そして、たとえ必要だとしても、その最先端のコストは信じられないほど急速に下がっています。

第四に、2025年の初めに、比較的強気な短期タイムラインのAI関係者の一団が、AIがどのように進むかについて行った予測を見ている、最近出た魅力的な研究があります。AIが異なる知能指標でどれだけうまくやるかという質問については、少なくとも平均では、彼らは基本的に正しかったのです。時には過大評価し、時には過小評価しましたが、平均では基本的に的中していました。

彼らが物事を大きく間違えた1つの場所は、OpenAI、Anthropic、xAIが顧客に製品を販売してどれだけの収益を上げるかという質問でした。これらの予測者は、AI能力については確かに強気ですが、それが2.5倍に上がって年間換算収益率が160億ドルになると予測しました。しかし実際には、ほぼ5倍に上がって300億ドルになりました。そして、それはすでにかなり重要な業界でのことです。この種の成長を見て、これが多くの人々が本当に欲しがり、かなり頻繁に使用し、冷たく、固いお金を払う意思があるある製品であるという考えから逃れるのは難しいです。

私の5番目のポイント、これが最後です。最終的にたどり着きますが、AI企業が供給するコストよりも低い価格でAIモデルへのアクセスを販売して、顧客を引き込み、夢中にさせているという印象を持っているかもしれません。Uberが昔やったように。しかし、それはそうではありません。企業は明らかに、サインアップする各追加の有料ユーザーでお金を稼いでいます。

さて、固定費の本質的な問題もあります。それらの顧客から十分な利益を上げて、販売およびマーケティングチーム、研究開発チーム(スタッフは非常に高価になる可能性があります)の固定費を支払う必要があります。そしてもちろん、そもそもモデルを訓練するための計算コスト、これは彼らの最大のコストの1つです。しかし、彼らは新しい顧客ごとに利益を上げており、収益は年間5倍に成長しています。それは私には収益性への合理的な軌道に乗っているように聞こえます。そして、それは、いつか人間の労働を完全に置き換えるか、超知能機械神を構築する可能性を脇に置いてさえのことです。それが起これば、確実にゲームを変えるだろうと思います。

全体的な見通しと結論

ですから、これはすべて消化すべきことがたくさんあります。私は昨年私たちが学んだことの概要を提供しようとしてきましたが、それは全体的に私たちをどこに残しているのでしょうか。

個人的には、来年完全に自動化されたAI研究開発を手に入れたら、かなり驚くでしょう。2028年はまあ、想像できますが、いくつかの驚くべき突破口や、今見ているものを超える加速が必要になるでしょう。2029年、2030年はもっともらしく感じ始めます。少なくとも、現在のトレンドが続き、重大な新しい障害にぶつからなければ、除外することはできません。しかし、はるかに長くゆっくりとしたテイクオフになる可能性も非常に現実的です。

しかし、これをより広い文脈に置きましょう。番組の過去のゲストであるHelen Tonerは、昨年「高度なAIへの『長期』タイムラインはとんでもなく短くなった」というタイトルの記事を書きました。彼女は、Gary MarcusやYann LeCunのような長年のAGI懐疑論者が、以前は人間の労働者を複製できるAIは数十年先だと思っていたか、そもそも来るかどうかわからないと思っていたのに、今ではおそらく10年先だと考えていることを指摘しました。そしてそれは、主要AI企業内の穏健派や、例えばToby Ordのような中期タイムラインのAI安全性関係者にもかなり典型的です。

しかし、10年後には、人間ができるすべての知的作業ができる機械というこの革命的な技術を手に入れ、それがコンピュータがするように毎年より賢く、より速く、より安くなり続けるというアイデアは、もしそうであれば、依然として衝撃的で信じられないほど重大です。2年は明らかに、それがもたらす社会的、政治的、経済的、軍事的、認識論的な激変に対して世界を準備するには、どこか近くでも十分な時間ではありません。しかし10年は。10年も快適ではありません。

そして、その陽気なメモで、次回またお話しします。

コメント