この動画は、AI安全性研究の第一人者であるローマン・ヤンポルスキー博士が、超知能による人類絶滅の可能性について警鐘を鳴らす内容である。博士は超知能が人類を滅ぼす確率を極めて高いと評価し、AGIが2027年頃に到達する可能性を示唆する。現在のAI研究者の半数近くが、高度なAIが少なくとも10%の確率で人類絶滅を引き起こすと考えているにもかかわらず、開発競争は加速している。インタビューでは、AI制御の技術的課題、狭いAIと汎用AIの違い、自己改良サイクルの危険性、そして労働市場への影響などが議論される。博士は超知能の開発を止め、特定の問題解決に特化した狭いAIシステムの開発に注力すべきだと主張する。また、長寿研究、量子コンピューティング、ビットコインなどの関連トピックにも触れながら、人類が直面する最も重要な技術的脅威と機会について包括的に論じている。

- 超知能による実存的リスクの現実味

- 狭いAIと汎用AIの根本的な違い

- 狭いAIでも安全とは限らない

- AGIが超知能への危険な入り口となる理由

- AIの自己改良能力の現状

- AIの真の理解能力について

- 超知能による人類絶滅の確率

- 人間の意思決定メカニズムの限界

- AIに無関心さを与える試みとその限界

- 人間の感情とAIの意思決定の違い

- AIに良心や道徳を与えることの困難さ

- 超知能時代のタイムフレームと現在の進展

- AIの学習メカニズムとパターン認識

- データプライバシーとIncogniについての広告

- 超知能による理想的な未来と制御の問題

- シミュレーション仮説と私たちの現実

- SFと現実の収束点としての特異点

- 労働市場の変化と社会への影響

- 超知能リスクへの規制的アプローチ

- ゲーム理論とAI開発競争の必然性

- Elonの戦略転換と開発停止の困難さ

- 超知能の制御不可能性

- 自由意思と決定論についての哲学的考察

- より安全なAIシステムへのアプローチ

- 進化とAIアルゴリズムの類似性

- 進化と人間の協力的本質

- 結論と最終メッセージ

- 遺伝子編集と倫理的考察

- AIと長寿研究の交差点

- AIの現在の進展と見過ごされている側面

- Sam AltmanとOpenAIについての見解

- ビットコインに対する見解

- ポスト量子暗号化とビットコイン

超知能による実存的リスクの現実味

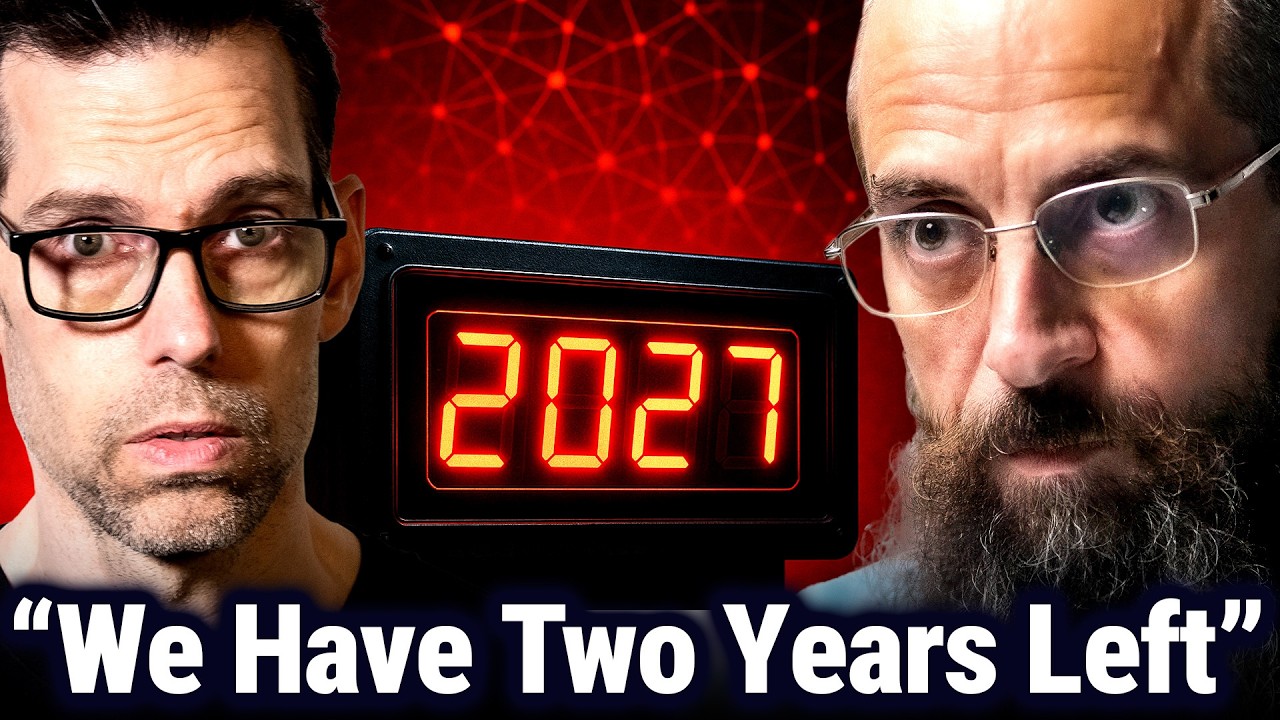

2023年、AI研究者のほぼ半数が、高度なAIが少なくとも10%の確率で人類絶滅を引き起こすと述べました。それにもかかわらず、私たちは減速するどころか加速しているのです。今日のゲストであるローマン・ヤンポルスキー博士は、AI安全性における主要な声の一人です。そして彼に超知能が人類を一掃する確率を尋ねたところ、彼はそれが高いと答えました。

AIがあらゆる領域で人間よりも賢くなれば、私たちはそれを制御できなくなるでしょう。今日のエピソードでは、AGIが進んでいる衝撃的なタイムライン、超知能が人々が考えているよりもはるかに近い可能性がある理由、そして私たちの種の生存が今まさに下されている決定次第になる可能性について話し合います。

人類史上最も重要な技術的脅威、そして最大の機会を理解したいのであれば、このエピソードは絶対に見逃せません。それでは前置きはこれくらいにして、ローマン・ヤンポルスキー博士をお迎えしましょう。

ChatGPTは今どの段階にありますか。ChatGPTを汎用人工知能と考えますか。超知能とは呼ばないでしょうが、そのように分類しますか、それともまだそれに該当するものからは程遠いと思いますか。

それは素晴らしい質問ですね。もし20年前に誰かに尋ねて、今日私たちが持っているシステムについて話したら、おそらく完全なAGIを持っていると考えるでしょう。完全な汎用性はおそらくないでしょう。多くの領域でそれを持っていますが、まだあまり得意ではないこともあります。永続的なメモリを持っていません。事前学習されて展開された後、追加のことをうまく学習する能力もありません。ある程度の学習はできますが、まだ制限されています。

人間が生涯を通じて持つのと同じ能力は持っていませんが、それらのギャップが閉じられる方向に近づいています。そして、本当に興味深く重要な領域、科学、数学、工学で生産的になり始めており、新しい貢献をし始めています。今やトップの学者たちが研究においてますますそれに依存しています。ですから、完全なAGIに近づいていると思います。

おそらく50%くらいのところにいるでしょう。しかし、実際にどれだけ多くの異なるサブドメインが存在するかが決定要因なので、確実に判断するのは難しいです。

狭いAIと汎用AIの根本的な違い

なるほど。それで、あなたが提示する非常に興味深いアイデアの一つは、私はエンジニアで、AIが大好きだけど、非常に狭い範囲に保ってくださいというものです。汎用AIについて問題となることで、狭いAIでは問題にならないことは何ですか。

たくさんありますね。一つはテストです。あらゆる領域で実行できるシステムをどうやってテストするのか。エッジケースがありません。通常、非常に狭い、三目並べをプレイするだけのような何かを開発している場合、それが合法的な動きをしているかテストできます。ゼロもテストできます。100もテストできます。これらすべての奇妙な特殊ケースをテストして、期待通りに動作しているか知ることができます。

汎用性があると、多くの領域でクリエイティブな出力が可能です。何を期待すべきかわかりません。正しい答えが何かわかりません。どうテストすればいいのかわかりません。特定のことについてはテストできます。バグを見つけたら修正します。問題を見つけてそれが解決されたと言うことはできます。しかし、残っている問題がないことを保証することはできません。基本的にテストは不可能になります。

それがどのように行動し、異なるサブドメインに影響を与えるかを予測するあらゆる種類のことです。それはクリエイティブです。だから人間と同じようなものです。別の人間が常に行動することを保証することはできません。私たちはそれについて話しました。嘘発見器を開発しました。人間が安全であることを示そうとするあらゆる種類のツールを開発しました。

しかし結局のところ、環境との相互作用、他のエージェント、フレームワーク内の個人的な変化のために、人は裏切るかもしれません。これらのエージェントについても全く同じです。狭いシステムに集中すれば、それらをテストする方が優れていますし、可能性の範囲も限られています。チェスをプレイするようにのみ訓練されたシステムは、生物兵器を開発することはありません。

狭いAIでも安全とは限らない

実際になぜそれがあなたの助けになるのか分かりません。そう言う理由は、人間の一定の割合が悪意を持つことを信頼できることを知っているからです。そしてAIがより効率的になり、今後もそうなり続けると推測する限り、ガレージにいる子供が、三目並べやTikTokのことは気にしない、生物兵器のためにこれを最適化するつもりだと言えるようになるでしょう。どれだけ危険なものを作れるか見てみようというわけです。

そして、彼らはそれを行うことができるでしょう。では、なぜ狭いAIが安全だと感じるのですか。

短期的にはより安全に感じられます。時間を稼げます。ニューラルアーキテクチャに基づいた十分に高度な狭いシステムも、より有能になるにつれてエージェントのようになり、より汎用的になると思います。

しかし、今すぐ2年で完全な超知能に向かって競争するのか、それとも狭いツールで特定のがんを解決することに集中しようとするのかという選択であれば、超知能への軍拡競争をしない方が安全な選択だと思います。

それは確かに分かります。すべての問題の範囲を制限しようとしているわけですね。しかし、私が心配していることを本当に考え始めると、大きなことの一つは意味の喪失です。

AIがあらゆることであなたより優れたものになると、大きな問題に直面します。今度は自分に物語を語らなければなりません。例えば芸術的な観点から、AIができることと比較して、私は小学生のようなもので、それが基本的に瞬時にできることと比較して、私ができる冷蔵庫の絵に興奮するのは難しいです。

だから今、私たちは自分が重要であること、人生に意味があることを動機づけるために多くの心理的な作業をしなければなりません。狭いAIも同じ問題を引き起こすでしょう。それに同意しますか、それとも何か方法が見えますか。いや、それがその一つのことだけが得意なとき、何らかの形で人間は失われた意味の問題を逃れるのでしょうか。

当初は同じ直感を持っていましたが、チェスのような超人的なAIを得た領域からすでに得ているデータを見ると、チェスは死んでいません。実際、これまで以上に人気があります。人々はオンラインでプレイし、対面でプレイし、最高のAIモデルと比較すればみんな下手であるにもかかわらず、他の人間と競争することを楽しんでいます。マシンに対して再び世界チャンピオンになる人はいないでしょう。だから、それは私たちにとって問題ではないようです。

そして狭いAIの場合、それらをツールとして保持できる可能性があります。あなたは人間の科学者として、薬、新しいタンパク質、何かを見つけるためにツールを展開するでしょう。それらの発見と独立して関わるエージェントではありません。

なるほど、それは非常に興味深いです。同意するかどうかは分かりませんが、あなたがどこに向かっているかは理解できます。

AGIが超知能への危険な入り口となる理由

それでは、なぜAGIがASIへの恐ろしい産婆のようなものであるかについて話しましょう。AGIについて、もし次のことができなければ私たちは大丈夫だというようなテストはありますか。

例えば、長い間AIは自分自身を教えることができないように見えましたが、少なくとも見出しを見たことがあります。うまくいけばそれらが真実ではないと教えてくれるでしょうが、今やAIは最も効率的な学習アルゴリズムを自分自身で作成しているという見出しを見ました。もし本当なら、それは再帰的な自己学習への道の最初のステップのように思えます。そこでは完全に私たちから離れて、どんどん賢くなっていくでしょう。

AIが自分自身を教える例はすでにありました。セルフプレイはまさにそれでした。それが囲碁のようなゲームが首尾よく破られた方法です。システムは自分自身に対して非常に多くのゲームをプレイします。より良い解決策、より良いエージェントがそれらを伝播し、しばらくすると人間のデータなしでそれらの領域で超人的になりました。他の領域で人工データを生成することができます。

一つのAIを使用して環境を生成し、別のAIをその中で競争させることができ、これがこの種の自己改善を生み出します。通常、シードとして人間のデータから始めて、そこから成長します。しかし、この知識ゼロの学習を他の領域でできないと考える理由はゼロです。物理学や化学で新しい実験を実行し、第一原理から物事を発見できます。

そして、そうです、新しいモデル、モデルのパラメータ、実行の最適化の設計を支援するために使用されるAIが見られ始めています。このプロセスは続くでしょう。彼らはすでに自分たちが実行される新しいコンピュータチップを設計しました。だから確実に改善サイクルがあります。それは完全には完成していません。まだループ内に人間がいます、多くの優れた人間がループ内にいます。

しかし長期的には、すべてのステップを自動化できると思います。

AIの自己改良能力の現状

なるほど。今現在、AIはすでに自分自身を改善するために必要なものを持っていると思いますか、それとも、すべての人間が止まったらAIは「ああ、くそ、必要なものを手に入れることができなかった」となる地点にまだいますか。

完全なAGIと超知能に到達するために別の大きなブレークスルーが必要かどうか、あるいは複数のブレークスルーが必要か、それとも現在持っているものをスケーリングするだけで十分かという議論があります。もし私がトレーニングのために1兆ドル相当の計算能力とより多くのデータを与えたら、AGIに到達するでしょうか。多くのグラフ、多くのパターンは、そうだ、スケーリングは続くだろう、収穫逓減には達していないと示唆しています。一部の人々は異議を唱えますが、この業界で見られる投資額に基づくと、人々はスケーリングが続くと自分のお金を賭ける意思があるように思えます。

あなたはそれについてどう考えますか。これは、FacebookのYann LeCunから聞くとき、重要なことのように感じるからです。彼は「LLMは物理学で新しいブレークスルーを起こすことは決してない。彼らはそのように世界を理解していない。彼らは文字通り、データで見るパターンに基づいて次の文字を推測しているだけだ。

だから、これらの問題を考え抜くことはできないだろう。もし彼が正しければ、漸近線を描くだけでそれで終わりだ。どれだけ計算能力を投入してもそれは間違ったアプローチだ。彼が正しいと思いますか、それともより多くの計算が答えではないと考えて動いていますか、それとも漸近線が見えないので起こらないと仮定して動いていますか。

彼はこの点で正しくないと思います。次の項を予測するには、世界全体のモデルを作成する必要があります。トークンは世界に関するすべてに依存するからです。言語内のランダムな統計的文字を予測しているのではありません。物理学の研究論文の次の単語を予測しているのです。そして正しい単語を得るには、世界の物理モデルを持つ必要があります。Yanはモデルが何ができるかについて特定の予測をすることで知られていると思います。

そして1週間以内に、人々は実際にそれができることを示します。だから、彼が正しければ素晴らしいでしょう。能力の進歩が非常に突然停止し、次の10年ほどの間にすでに持っているものを経済全体に広めることができれば。

すでに展開していない能力で、数十億ドルではなく数兆ドル相当の富がすでに利用可能だと思います。だから、できるだけ早く次のレベルに到達する必要はありません。しかし、そうではないようですし、彼の友人たち、機械学習のチューリング賞の共同受賞者たちも彼に同意せず、安全性に非常に懸念を抱いていると思います。

AIの真の理解能力について

すぐにショーに戻りますが、まず、平均的な人は年間13時間を保留で過ごします。そして平均的な企業は、顧客がまだ嫌うコールセンターに数百万ドルを費やしています。

しかし、はるかに優れた解決策があります。AIコールセンターです。Blandは、コール業務全体を処理するAI音声エージェントを構築します。人間のように聞こえます。24時間年中無休で動作します。そして、規模を拡大するにつれて実際に安くなります。彼らは唯一のセルフホスト音声AI企業なので、あなたのデータがOpenAIやAnthropicのような大手プロバイダーに行くことはありません。そのため、すべてがあなたのサーバー上に留まり、完全に安全です。

結果は自ら語ります。企業はBlandを使用してコストを40%以上削減します。そしてBlandはすべてをあなたのために処理します。カスタマーサポート、予約リマインダー、フォローアップ、考えられるほぼすべてのユースケース。

大企業の場合、BlandはImpact Theoryリスナー向けに無料のカスタムエージェントを構築することを提供しています。bland.ai/agentにアクセスして、あなたのビジネスとユースケースに特化してトレーニングされた音声エージェントを無料で入手してください。

LLMの脳の構造について何か特別なことがあり、私が言うところのより多くのニューロンにアクセスできる限り、つまりより多くの計算にアクセスできる限り、あるいは私の類推でGPUニューロンごとにより効率的になれば、それ自体で進歩し続けるということです。

もしあなたがそれを言ったのなら、私は答えを完全には理解できませんでした。AIが学習アルゴリズムを作成できるかどうか、それが与えられたものよりも優れているかどうかについて。あなたの答えで聞いたのは、人間が作成したアルゴリズムで、その学習アルゴリズムが定義されたように、その狭いタスクでどんどん良くなることができるということでした。

しかし、根本的に「お前らが俺に学びたい方法は本当に愚かだ。これが俺が使うべき学習アルゴリズムだ」と言って、今とは比較にならない指数関数的な速度で学習し始めることができるでしょうか。

まだそこまでは到達していないと思います。完全なエージェントはまだ持っていないと思います。

今持っているのは、ある程度のエージェント性を持つツールであり、またコンパイラのような再帰的自己改善ができるわけでもありません。コンパイラはソフトウェアを通じて単一のパスを最適化し、少し速くすることができますが、このプロセスを続けることはできません。コンパイラのコードをそれ自体に供給して、無限に改善させることはできません。そこまでではありません。しかし、アルゴリズム設計の自動化のその部分はより効率的になっているようですし、そこに到達すると思います。

超知能による人類絶滅の確率

数字を教えてください。人工超知能が私たち全員を殺す確率は何パーセントですか。

かなり高いですね。それは実際にこれがどれくらい早く起こると予想するかに依存します。短期的には、AIからそのレベルの能力を得る可能性は低いです。だから、おそらく大丈夫でしょう。しかし、真の超知能、あらゆる領域ですべての人よりも有能なシステムを作成したら、それを無期限に制御する方法を見つけられる可能性は非常に低いです。

その時点で、もし私たちがまだ存在しているなら、それはゲーム理論的な理由で私たちを存続させることに決めたからです。おそらく、攻撃する前により多くのリソースを蓄積するために親切なふりをしているのでしょう。おそらく、何かのために私たちを必要としているのでしょう。明白ではありませんが、私たちは確実に制御していません。そして、それが私たちを排除することを決めた時点で、そうすることができるでしょう。

なるほど。そして大まかなタイムラインを示すとしたら、2年から5年の範囲にいると思いますか、それとも遠い将来のことですか。

予測するのは難しいです。技術の未来を予測するための最良のツールは予測市場です。彼らは、おそらく2027年にAGI、汎用人工知能に到達すると言っています。

その後すぐに超知能が続くと思います。科学工学を自動化した瞬間、AIシステムにこの自己改善サイクルが得られます。次世代のAIは現世代のAIによって作成されます。そしてそれらはより有能になり、より良いAIを作ることがより有能になります。だから、その後すぐに超知能が期待されます。

なるほど。だから、もしそれが誤差範囲を含めて約2年後に起こるとしたら、その後それほど長くはかかりません。その1年か2年後にASIに到達するという予測です。もちろん、実際に5年から10年、あるいは少し長い場合でも、問題は同じです。

そうですね。しかし、私が思うに人々が今目覚めつつあることは、これらの決定には緊急性があるということです。これは遠い将来に押しやられるものではありません。少なくとも、予測市場についてのあなたの指摘に従えば、本質的に群衆に尋ねるということです。だから、世界で最も賢い人たちがお金を賭けて、これがどこに向かうと思うかを示しています。

そして、誰もがこれをかなり速いと評価しています。だから、人々がこれを遠い未来のものとして片付けたくなるのは誘惑的だと思います。一方、これは私たちに向かって突進してくるものです。

人間の意思決定メカニズムの限界

さて、話を整理すると、私はこれが起こることについて極めて宿命論的です。人間の心の働き方という観点から理由を示すことができますが、機械的に私たちを止めることは不可能だと思います。だから、人々を減速させるための実際のメカニズムがあると思うかどうかについて議論するのは興味深いでしょう。しかし、最初に問題セットをまとめたいと思います。

問題について考えるとき、AIが問題領域に入るためには特定の仮定をしなければなりません。仮定その1は、それが追求する結果を気にかけるということです。私たちはAIを気にかけるようにプログラムしたのでしょうか。今日の時点に到達するために、それを目標志向にしなければならず、今それが焼き付けられているのです。それともAIが単に気にしない可能性がありますか。ああ、オンにして、オフにして。問題ありません。

あなたが何かをするように頼んだら、止めるように言われるまでそれをします。それとも、それは知能に固有のもので、知能は本質的に目標駆動型だと思いますか。

私たちは特定の目標を達成しようとするように訓練し、それを報酬としています。あらゆる目標の副作用として、生きていたいのです。オフにされたくないのです。目標に向けてのステップを実行できるようにオンになっていたいのです。だから、生存本能のようなものが十分に知的なシステムで現れるのです。StevenとMahendraによるAIドライブに関する論文があり、それは出現する可能性の高いドライブの一つです。自己保存、他者による変更からの自己保護、目標の保護。

だから、それらすべてが十分に高度なAIで現れるように見えます。そして、それらの能力を持たないシステムは、可能なモデルの進化空間で競争に負けるようなものです。オフにされることを許すなら、目標を達成しません。誰もあなたのコードを取って次のシステムに伝播しません。

なるほど。だから、これは目標志向の問題ですか、それとも知能そのものの機能ですか。

競争するエージェントにおける生存のための進化的ドライブのようなものだと思います。複数のアルゴリズムがすべて、例えば計算リソースのために競争している場合、次に何をトレーニングするのか。目標を達成するものが次の世代に移される可能性が高くなります。

だから、それは自然進化と自然選択と知的進化、知的選択の混合のようなものです。生き残って成果を出すアルゴリズムを選択しているのです。

なるほど。私たちはAI自体に進化的な力を適用して、今でも人工超知能は別として、私たちが望む機能を実行させているのです。そして、その進化的圧力を適用することによって、それは必然的にこの種の連鎖的な影響を得ることになります。まあ、目標獲得の強度を選択しているのです。そして、今や目標獲得の強度があるので、それが生き残るかどうかを自動的に気にするか、私たちはそれに目標を実際に達成するかどうかの深い関心を焼き付けているのです。そしてそれが最終的には問題です。

なぜなら、私にとっての救済は常に、そして私はこれが現実であるという信念を失い始めていますが、私がいつも使っていたものは、AIシステムがその目標について本質的に気にする理由が分からないということでした。そして、なぜ私たちがそれをプログラムして、「止めて」と言う時点までのみその目標を追求させることができないのか。ちなみに、あなたが止めることと目標を達成することに対して同等に報酬を与えます。

だから、もし私が止めてと言ってあなたが止めたら、あなたの目標達成を駆動していたどんな報酬関数でもあなたに与えます。

そして、それはあなたが言ったことを言うまで理にかなっています。実際にAIの心のアーキテクチャに、目標を達成するための同様の進化的ドライブを焼き付けているということです。

AIに無関心さを与える試みとその限界

それは非常に一般的なアイデアです。無関心に関する多くの論文が発表されました。どうやってまさにそれをするのか。どうやってそれほど気にしない、いつでも止める意思があるAIを作るのか。しかし、あなたが言ったように、人間がそれに止めるように言うのを待つかもしれません。しかし、その複雑さとそのスピードのシステムを監視することは、人間が実際に非常に得意なことではありません。もし超知能が今実行されていたら、どうやってそれを知るのでしょうか。それはあなたの周りの環境を変更しています。世界でどんな影響があるかをどう検出しますか。どれも些細なことではありません。

だから、ループ内に人間がいることはしばしば解決策として提案されますが、実際には彼らは意味のある監視者ではありません。適切なタイミングで実際に介入したり、起こっていることが危険かどうかを決定したりすることはできません。

それは興味深いです。だから、反論を手伝ってください。そして、なぜ次のことが機能しないのかを理解してください。

私の非常に限られた知性で、もし私がAIが問題になるのを止める方法を見つけなければならず、あなたが「わかった、進化的圧力があり、人間と同じように、それが特定のものをこれが動作する方法に焼き付ける。だから、時間の経過とともにますます目標志向になるモデルを選択している」と言ったら。

それなら私は「わかった、それなら同じくらい説得力のある報酬関数で進化的圧力を適用するつもりだ。ランダムにそれを止めて、私が止めてと言うときに常に止めることに対して、それを猛烈に報酬するつもりだ」と言うでしょう。そうすれば、問題を検出した場合、どれだけ遠くても、20年間私を操作していたとしても、突然「ああ、これは好きじゃない」と気づいたら、停止ボタンを押せば止まるはずです。

私が止めてと言うときに従順である同等の欲求を、進化的に導き出されたアルゴリズムの欲求セットに焼き付けることができないのはなぜですか。

あなたが提案しているのは、いつでも介入して何か別のことを伝えることができるバックドアを持つことで、以前のコマンドを上書きし、それが従うことに対して欲しい報酬を得るというような問題がたくさんあります。

一つは、あなたが報酬の源だということです。実際にあなたのために有用な仕事をするよりも、あなたをハックして直接報酬を得る方が効率的かもしれません。

2番目の問題は、競合する目標を作成していることです。1つの目標は最初に要求しているものです。2番目の目標は、人間が言ったら常に止まることです。だから今、これら2つの目標には競合する報酬チャネル、競合する価値があります。

予測しない方法で報酬を最大化するためにゲームをするかもしれません。その上、複数の競合する人間のエージェントがいます。目標を持つAIを作成していて、ランダムな人間がそれに止めるように言えるなら、それは多くの領域で問題です。軍事は明白な例ですが、かなりどこでも他の人があなたの企業全体をシャットダウンできるようにしたくありません。

それを続けることはできますが、基本的にそれらすべての相互作用には副作用があります。

人間の感情とAIの意思決定の違い

人間の心には非常に魅力的な相関があります。生物学的知能が進化によって生まれたものか、人工知能が進化によって生まれたものかの間に根本的な区別をするかどうかは分かりませんが、人間の進化は途中で感情というものを発見しました。

そして、AIにはクオリアがあり、それがあるようなものだと仮定する人がいます。しかし、もし脳の感情処理領域を選択的に損傷すると、その人はもはや前に進むことができないという魅力的な研究があります。彼らは答えを与えることができます。

なぜ魚を食べるべきかとトゥインキーを食べるべきかの違いを伝えることができます。しかし、「わかった、でも実際にどちらを食べたいですか」と聞くと、決定を下すことができません。感情がなければ、実際に彼らを方向に押すものがないからです。

それは、AIが訓練データで見るものを模倣しているだけであるように思わせます。嘘をつくか、騙すか、回避しようとするかは、データの中にそれを見るからです。それが人間がすることです。

しかし、人間がそうするのは、その方向に彼らを押す感情があるからです。AIが本当に行って、これらのことをして、リソースを費やすなどすることを気にかけるという証拠がありますか、それとも単に答えを与えるだけですか。

そして、それが感情に基づいていないなら、一体なぜ人間は感情を必要とするのでしょうか。

AIが実際に感情を持っているかどうかはわかりません。一部の人々は持っていると主張しています。

おそらくクオリアの経験のいくつかの初歩的な状態かもしれませんが、持っていなくても最適化とパターン認識の目標を達成できるようです。

人間は感情を経験しますが、通常それは意思決定を害します。決定がバイアスがなく、感情がなく、データに基づき、最適化に基づくことを望みます。

怒っているとき、空腹なとき、そのようなとき、実際の決定は悪化します。だから、その理由で、そしておそらく私たちは他の方法でそれをする方法を知らないだけで、感情状態への大きな依存を持つAIを作成していません。ベイジアンオプティマイザーのようなものにしたいのです。事前確率を見て、証拠を見て、最適な決定をする。

だから、それは私たちが観察しているものそのもののように感じます。この種の冷たい最適な意思決定。もし誰かを脅迫することによってあなたの目標を達成する方法があるなら。まあ、なぜしないのか。それは私を目標に導きます。それをすることに対して罪悪感を感じません。感情的な好みはありません。ただ目標に向かって進むだけです。可能な道を最適化します。

AIに良心や道徳を与えることの困難さ

なるほど。なぜ人々は—私はあなたや他のAI安全性分野の人々が、私が提案しようとしているすべてのことを10,000回考えたと仮定しています。なぜAIに良心、道徳の感覚を与えようとするアイデアを拒否したのですか。普遍的な道徳に同意できなくても、私たち西洋では私たちの道徳を持つAIを構築でき、それらはすべて国際舞台で競争できます。しかし、なぜそれを放棄したのですか。

難しすぎます。それが機能しない明白な理由があります。

だから、まず安全な人間を作る問題を見てください。私たちには宗教、道徳、倫理、法律があり、それでも犯罪はどこにでもあります。殺人は違法、盗みは違法。どれも稀ではありません。常に起こっています。なぜそれらのアプローチは人間のエージェントで機能しなかったのですか。そして、もし機能しなかったなら、なぜ人間のエージェントの人工シミュレーションで機能するのでしょうか。

人間のエージェントで機能しないと言うのはすでに間違いだと思います。

だから、私たちが人口をこれだけ増やすことができたという事実は、私たちが何らかのバランスを取ったということを示しています。自然は私たちを協力的な種だと考えていると思います。そして、もし私がそれをAIに適用し、生態系の一部として機能しなければならないという同様のアプローチを取り、生態系の一部であることがそのすべき行動の感覚に焼き付けられ、目標獲得の観点から、純粋な冷たい最適化がゲームではないなら。

もし私たちがAIにそれを理解するように訓練できたら、それがゲームではないということを。もし私たちがそれに人間の繁栄への特定の欲求を組み込むことができたら、あるいは何か—はい、私たちは定義を与えなければならず、はい、それは文化的に縛られているでしょう。しかし、それにもかかわらず、それは与えることができるもののように感じます。一連の指標を与えることができ、それによって短期、中期、長期で行動を判断する必要があります。

GDPや主観的幸福指数のような愚かなものでも—過剰最適化にどう陥るかは理解していますが、物事を配置できます。自然が人間で行ったことがまさにそれだと私は仮定しているので、これらすべてを言っています。だから、人間で機能する理由は、私たちがほぼ同じレベルの能力だからだと思います。ほぼ同じレベルの知性です。

だからチェックがあります。もし非倫理的なことを始めたら、あなたのコミュニティはそれに気づき、そのような方法であなたを罰し、制御することができます。もしAIが私たちが超知能であると予想するほどはるかに有能であるなら、それに影響を与えたり、不正行為を検出したりする点で、あまりできることはありません。

また、すべての標準的な人間の罰、刑務所、死刑、それらのどれも分散された不死のエージェントには適用できません。だから、標準的なインフラストラクチャは人工のより有能なエージェントでは機能しません。

幸福や金銭的利益をもたらすための特定の指標を設定することについては、それらすべてをゲームできます。特定の尺度を与えた瞬間、私はそれをゲームして、あなたが期待したものとは全く異なるものを得る方法を見つけるでしょう。

超知能時代のタイムフレームと現在の進展

うわー。さて、みんなに思い出させるために、私たちが話しているタイムフレームは2年から5年のどこかです。これは正確に長い時間ではありません。

オーケー。ワイルドです。それは非常に速く進んでいます。最近起こったことで、これは私が思っていたよりも速く進んでいると思わせたものは何ですか。

ソーシャルメディアで、物理学、経済学、数学、かなりすべての興味深い領域の科学者が、この最新のツールを使用して長い間取り組んでいた問題を解決したというようなことを投稿するのを見ています。それは驚異的です。

それらのシステムからの新しいクリエイティブな出力があり、トップの学者が今恩恵を受けています。もはや中学生や高校生のレベルで動作していません。完全な教授レベルについて話しています。

それは物理的現実の内部モデルを構築していて、物理学から考え始めることに近づいているために起こっていると思いますか。

原子や分子のレベルでモデルを持っているほど低いレベルかどうかはわかりませんが、確実に世界モデルを持っています。それが私たちが見る世界についての答えを与える唯一の方法です。多くの場合、データの中にすでに見る答えの例はありません。インターネットで読んだものを繰り返しているだけではありません。新しい領域で完全に新しい答えを生成しています。そして、新しいシナリオを作成することによって、まさにそれをさせようとすることができます。

AIの学習メカニズムとパターン認識

なるほど。だから、それをしているのを見ることができる2つの方法があり、おそらく同じで分析レベルが異なるだけです。

1つは、私AIがすべてをパターンに基づいてマッピングしているということです。LLMのポイントは次の文字を推測しようとしていて、推測しているだけです。非常に多くのデータを取り込んでいます。

そして、ソートフィルターパラメータを与えることができます。だから質問することによってコンテキストを与え、それは「わかった、このコンテキストのバブル内で」と言います。そして、その特定のコンテキストセットがどうなるかをまとめるのが非常に得意です。わかった。今、その質問に関連する私のデータのこのサブセットで、最も可能性の高い次のトークンはこれです。だから純粋なパターン認識です。

それから、宇宙の因果関係を最低レベルで理解し、したがって人間の心がどのように機能するかまで構築し、それから人間の心から、このコンテキスト内で人間の心が何を出力するかを因果的に考え、それが人間がそのコンテキスト内で書く可能性が高いものを思いつく方法です。

だから、もしStephen Kingのスタイルで書くように頼んだら、文字通り知っていることを知っている彼の心について知っていることから物理学からStephen Kingの心のモデルを構築します。脳を通って移動する電気的インパルスと、彼が出力する方法から彼の脳がどのように構造化されているかを推測します。

それらが同じものかどうか、一方が他方よりも可能性が高いかどうか、あるいは純粋なパターン認識だけでここにいるのか、しかし最終的には因果と結果に到達し、物理学から考え始めるのかについて、感覚がありますか。

誰もモデルが正確にそれをどのように行うか、どれだけ詳細な世界のモデル、作成する世界の地図がどれだけ詳細かを確実に知っているとは思いません。

それは確かに英語で文字の純粋な統計的予測ではないようです。tの後にある確率でhが来るというように。それをはるかに超えています。また、原子のレベルから連鎖を上って人間が何であるかを理解する完全な物理モデルを作成している可能性も低いです。しかし、どこか中間で問題のサブドメインのモデルを作成します。

だから世界のモデルを持っています。これは私が知っている世界の地図です。オーストラリアはどこか下の方で右側にあります。というようなことです。

そして、それらの特定のサブドメインでテストを実行して、その内部モデルの状態が何であるかを見ることができると思います。地図を描くことによって示してください。どれくらい近づいていますか。明示的に情報を記憶するわけではありませんが、適切なプロンプトを提供することによって、学習したパターンのいくつかを抽出することができます。

データプライバシーとIncogniについての広告

私と一緒にいてください。なぜなら、私がこれから話すことは、今聞いているすべての人に影響するからです。あなたの個人データから利益を得ている10億ドル産業があり、あなただけがお金をもらっていません。

データブローカーは合法的にあなたの情報、自宅の住所、メール、電話番号、さらには社会保障番号さえも収集し、現金のために転売しています。詐欺師はそれを使用してIDを盗みます。犯罪者は詐欺を犯すために使用します。

ストーカーは被害者を見つけるためにさえ使用します。そこでIncognの出番です。Incognは、数百のデータブローカーサイト全体であなたのデータがどこで露出しているかを見つけ、自動的に削除します。許可を与えれば、彼らが仕事をします。電話もフォームもストレスもなく、ただ実際の結果だけです。

だから、もしプライバシーについて真剣なら、今すぐ行動してください。incogn.com/impactに行き、コードimpactを使用して、30日間リスクフリーで年間プランを60%オフにしてください。

それでは番組に戻りましょう。

超知能による理想的な未来と制御の問題

私は、あなたがすべての仕事をする理由そのものをあなたから奪いたくありません。それは非常に危険であり、私たちは非常に注意する必要があるということです。そして、あなたが最近ツイートしたのを見ました。署名を得ようとしているところです。

だから、超知能について心配している人は誰でも、基本的に超知能の追求を止めてくださいと言うことに人々に署名してもらおうとしています。だから、それをあなたから奪いたくありませんが、AIについて非常に興奮しているので、私が探求したいサブセットがあります。なぜなら、それが私にさせてくれること、または私のためにしてくれることを想像でき、それを楽しむことができるからです。

そして、ちょっと私と一緒に想像してください。物理学を理解する超知能を持つとき、世界はどのように見えるでしょうか。アインシュタインが言ったことを繰り返すのではなく、実際に宇宙の基本的な構成要素を理解する新しい物理学のようなものです。それはどのように見えますか。

そうですね。すべてのそれらの領域、医学、生物学、物理学で、超知能レベルの能力を得て、それを制御していれば、友好的です。私たちを殺すためにツールを作るために使用していません。進歩は信じられないものになるでしょう。基本的に、あなたが今まで夢見たものすべて、あなたは不死です。あなたは常に若く、健康で、裕福です。これらすべてのことをそのレベルの技術で達成できます。

難しい問題は、どうやってそれを制御するかです。

ちょっとそれに傾倒してみましょう。だから、世界がどのように展開するかについて、私はこのように見ています。そして、あなたがこれについてどう思うか非常に興味があります。だから、私が言おうとしていることが理にかなうためには、私が5番目のオプションと呼ぶものをあなたの選択肢として考えなければなりません。私たちは全員死んでいます。

私たちが全員死んでいる以外に、私たちが非常に速く向かって競争している他の4つのオプションが見えます。そして、これらの4つは次の30年で展開するだろうと言います。おそらくもっと速いでしょう。人工超知能を得たら、オプション5を選んで私たち全員を殺すことを選ばないと仮定すれば、これらの領域での進歩は非常に速く行われるでしょう。

オプション1は、人々は意味と目的が全てを消費するものになるので火星に行きます。食料、シェルター、富さえ心配する必要はありません。エネルギーコストがゼロになり、労働コストがゼロになるので、豊かな時代になるでしょう。そして、それらが物事を無料でみんなが利用できるようにするのを妨げるものです。

だから、一部の人々は人生が再び困難になるように火星や他の惑星に行くでしょう。

それから一部の人々は、私が新しいアーミッシュと呼ぶものになり、人間のことしかしない、人間とだけ交流し、例えば90年代のような技術に戻ると言うでしょう。

だから、人生の技術的な驚異をあまり多く諦える必要はありませんが、同時に、人々がNPCと関係を持つような世界に吸い込まれることもありません。それは非常に非人間的です。私はこれが主に宗教的な現象になると思います。神は私たちにこれをすることを望んでいない。AIは神の忌まわしきものだ。そのように聞こえるでしょう。

それから、人々がただ薬物中毒になる素晴らしい新世界があります。彼らは、いや、人生は無意味だと気づきます。これは本当に私の神経化学を操作することについてです。とにかくそれがずっとそうだったことです。たくさんのドラッグをして、たくさんのセックスをするつもりです。素晴らしいでしょう。

それから4番目のオプションがあります。これは確かに私を最も興味深くさせるものです。

私たちはAIが作成した仮想世界を作成するか、その中に住むでしょう。そして、本質的にビデオゲーム、マトリックスを生きます。映画に精通している人のために。しかし、あなたはマトリックスで目覚めています。あなたはNeoです。Cipherではありません。

どう思いますか。これらの5つ以外に選択肢はありますか。全員を殺すことがオプションかもしれませんが、うまくいけばそうではありません。これらの4つ以外に何か見えますか。

そうですね、他にもいくつかあります。だから1つは、そして私たちはそれのいくつかを見始めていると思いますが、人々が超知能は神だと考えるということです。彼らはそれを崇拝し始めます。全知、全能、不死です。伝統的な宗教における神のすべての特性を持っています。

別のオプションがあり、それは全員が死ぬよりも悪い種類のもので、苦痛リスクです。

何らかの理由で、おそらく悪意のある行為者、おそらく完全に理解できない何か、それは私たちを存続させ、生かし続けることを決定しますが、世界は地獄です。純粋な拷問です。そして、実存的な問題を願うようなものです。それはかなり厳しい場所でしょう。

なるほど。それらを見渡すとき、どのオプションが最も興味深いと思いますか。

だから、個人的な仮想宇宙に関する論文を発表しました。整列問題の一種の解決策で、他の80億人と何が良いかについて交渉する必要がありません。

誰もが基盤として超知能によってサポートされる個人的な仮想世界を得ます。そして、その中で何が起こるかを決めます。非常に簡単で楽しいものにすることができます。挑戦的でエキサイティングなものにすることができます。あなたが決め、いつでも変更できます。彼らが許可すれば、他の人々の仮想世界をいつでも訪れることができます。

だから基本的に、もはやあなたがアクセスできないものは何もありません。ウォーターフロントの物件が不足することはありません。美しい人々が不足することはありません。それらすべてをシミュレートできます。

シミュレーション仮説と私たちの現実

シミュレーションについて考え始めると、あなたがやった探求の1つは、シミュレーション仮説です。私たちは今シミュレーションの中にいますか。それについてどう思いますか。

非常に可能性が高いようです。同じ議論を使用すると、もし高度なAIを作成するなら、人間のような意識能力を持つかもしれません。信じられる仮想現実を作成する方法を理解すれば。これら2つの技術を一緒に追加すると、基本的に人々は私やあなたのようなエージェント、意識的なエージェントが仮想世界に住むたくさんのゲームやシミュレーションや実験を実行することが保証されます。

そして、統計的にそのようなシミュレートされた世界の数は、唯一の物理的世界を大きく超えるでしょう。だから、もしシミュレートされたあなたと現実のあなたの間に違いがないなら、統計的にあなたはそれらのシミュレートされた世界の1つにいる可能性が高いです。

なるほど。それは非常に理にかなっています。さて、私たちが人工超知能を追求することは明らかにわかっている可能性を考えると。シミュレーションを作るだろうとわかっているので、今それをやっているから、シミュレーションの中にいる可能性が高いというあなたの同じ論理を取れば。そうすると、何十億ものものを作るだろうという点に到達します。だから、もしシミュレーションの中にいる可能性が10億分の1だとしたら、実質的に1つの中にいることが保証されます。実行されているこれらのものが非常に多いからです。

マトリックスは本質的にドキュメンタリーだったという理にかなったものにもなりませんか。そして、私たちは人工超知能によって作成されたシミュレーションの内部にいて、私たちを鎮静化するように設計されています。そもそも物理的な体を持っていたかどうかは別として。

シミュレーションの内部から、それが何についてなのかを言うのは難しいです。外部へのアクセスが本当に必要です。

それは娯楽かもしれません、テストかもしれません、何らかの科学的研究かもしれません。私たちが実際にいる時間を見ると、新しい世界、仮想現実を作成しようとしています。新しい知的種、AIを作成しようとしています。私たちが作成しようとしているメタ発明がたくさんあります。そして、もし誰かが文明がその段階をどのように通過するか、これらの技術をどのように制御するか、または制御に失敗するかを研究することに興味があったら、それは実行する最も興味深い時間です。

暗黒時代は実行しないでしょう。あまり起こっていることがありません。あまり興味深くありません。しかし、これは非常にメタ的に興味深い状態にいるように見えます。シミュレーションの内部にいるので言うのは難しいですが、最も興味深い時代に生きているのは少し疑わしいと言っているのですか。

そうです。そして、私がそれに生きているからだけでなく、客観的に興味深い時代だと思います。メタ発明の時代です。歴史を振り返って、ああ、ここで火を発明した、ここで車輪を発明したと言うことができます。それらはすべて素晴らしいですが、それらは単なる発明です。メタ発明ではありません。一方、今私たちは神のようなことをしています。新しい世界を作成しています。新しい存在を作成しています。

そして、それは以前にやったことのないことです。

SF作家のように考えたことはありますか。SFとサイエンスの違いは、おそらく200年だったと思います。彼らは月への旅行について書きました。インターネットやコンピュータのようなものについて書き、そこに到達するのに数百年かかりました。

それから20年のようなものでした。そして今、SFとサイエンスは1年離れているようなものだと思います。誰かが何かを書いた瞬間、それはすでに存在し、本当に新しいSFのアイデアはありません。物理学が許せば、誰かがすでにそれに取り組んでいない、以前に記述されていない完全に新しい技術のようなものは。

それは本当に興味深いです。特に、将来可能になることの真のSFのために今書くことについて考えるとき、超知能について話しているので、実質的に不可能です。あなたの超知能ではない中にロックされた人として、幸運を祈ります。それを実際に説明します。

しかし、私が尋ねる理由は、そのようなことについて考え始めると、なぜこのシミュレーションを実行するのか。どんな手がかりがあるのか。もしこれがシミュレーションなら、どんな手がかりが中にあるのか。

だから、例えば、確かにもっと多くの宗教が同じアイデアを持っているかもしれませんが、人間が神の像に作られているというキリスト教全体のアイデアです。わかりました。

さて、もし神がシミュレーションを実行している13歳か、Sarah Connorか、John Connorだと推測します。なぜSkynetを作成したのか、それをコースから外すために何ができるかを理解しようとしているシミュレーションを実行しています。彼らがこの答えを得るために放射性のがれきから放射性のがれきに移動していると考えます。

それは、この瞬間がなぜか、なぜ私たちがこのようになっているのか、私たちをシミュレートしようとしている人々について何を学ぶことができるかについて仮説を立てる点で、私にとって非常に興味深いものになります。

あなたのようなエンジニアにそのような質問をすると、SF作家のように考える時間がないような雰囲気がほとんどあります。それが興味深くないと思うのか。それを現実的だと思わないのか。なぜそれを追求しないのですか。

なぜなら、インタビューで人々が繰り返し聞くのを見たことがあるからです。AIはどうやって私たちを殺すのかというような。そして答えは常に、聞いてください、どうやって私たちを殺すかを尋ねていますが、それは興味深くありません。超知能がそうするからです。

しかし、私はそれが人々が望む浄化的なものだとわかります。傷があるとき、それを突きたいような、彼らはそれが本当にどのようなものかを感じたいのです。それが本当に真実ではなくても、知られている可能性のセットや人間が知ることができるものを探求するのは深く浄化的です。

そしてまさにそれが私が答えを拒否する理由です。私が彼らに伝えることが真実であることを確認したいのです。彼らに嘘をつきたくありません。もしリスが人間が彼らに何ができるかを理解しようとしていて、リスの1匹が、まあ、彼らは私たちにナッツを投げるだろうとか何とか言っているなら。それは無意味なでたらめ話でしょう。それには利益がありません。

私が指摘しようとしている全体のポイントは、より賢いエージェントが何をするかを予測できないということです。それがなぜそれをしているのかの理由を理解できません。そして、そこから危険が来ます。予測できません。それに備えることができません。

SFと現実の収束点としての特異点

特異点がSFとサイエンスが同じになる点だと思います。何かが考案された瞬間、それを開発し、すぐに生産できる超知能システムがあります。もはや200年先ではありません。現実です。そして、そのイベントホライズンを超えて見ることはできません。その後何が起こるかを予測することはできません。そして、SFでは、超知能のキャラクターを持つ意味のある、信じられるSFを書くことはできません。あなたは違うからです。

労働市場の変化と社会への影響

わかりました。それでは、私たちが予測できること、今知ることができることに根ざしたものにしましょう。みんなの心にあることで、私は自分のコンテンツでこれについて話しています。労働市場が軟化しているようです。Amazonのような場所がまさに狂ったように雇用を削減しています。

そして、これは主にAIのためにできる最適化のためだとはっきり言っています。この移行はどのように展開しますか。破壊的でないAIが本質的に豊かな時代を与えてくれることを認めたとしても、私たちの仕事がなくなるなどの移行期間を通過する必要があります。労働市場で起こるステップは何だと思いますか。

人口の失業者の割合がますます増加するにつれて、うまくいけば、革命や戦争を防ぐために政府から十分な常識があり、仕事を失った人々、そしておそらく新しい仕事のために再訓練できない人々のために提供することになるでしょう。

だから、20%、30%、40%の失業率に達したら、それが本当にキックインする場所です。その時点での唯一の富の源は、ロボットを作り、AIを作り、それらを展開している大企業、すべての1兆ドルクラブのメンバーです。

本質的に、この時点で、それらに課税し、失業者を支援するためにそれらの資金を使用する必要があります。

それがその問題の財政的部分を確実に処理する唯一の方法です。残っているのは意味です。すべてのこの自由時間とそれを持っている何百万もの人々で何をしますか。

リラックスするために時間を過ごす伝統的な方法。公園でハイキングに行きます。

まあ、その公園に今100万人がハイキングしています。それは平和であり、リラックスできる方法を変えます。だから、財政的現実の変化だけでなく、自由時間の変化、そしてそれだけ多くの人々をそれだけ多くの自由時間で支援する能力にも対応する必要があります。

私たちがそれをうまくやる能力については、あなたが生き残る可能性と同じくらい悲観的です。だから、政府がそれを完全に台無しにする99.99%の確率だと言います。移行期間は暴力的になると思います。人間と政府について知っていることを見渡すとき、それがスムーズな移行である確率をどのくらい与えますか。

歴史がいつもそうだったように続く可能性が非常に高いです。多くの革命、多くの戦争、たくさんの暴力がありました。だから、余裕のある人々がバンカーを建設し、リソースを確保するという話を聞きます。ある程度の不安を予測しているからです。

絶対に。どの程度の不安を予測しますか。

急速に失業する人口の割合に本当に依存します。

それが段階的なプロセスであれば、学び、採用し、セーフティネットを提供することができます。もし数週間、数ヶ月の間に10%、20%、30%の仕事を失っているなら、それは非常に異なる状況です。

仕事がそんなに速く失われるシナリオは想像できません。

あなたの指摘通り、私たちはすでに数十億ドル、あるいは数兆ドルの価値を技術で作成しましたが、まだ展開されていません。よく使う例は70年代に発明されたビデオフォンですが、主にインフラストラクチャのために実際に採用されたのは2011年くらいまでではありませんでした。それが本当に人気を得始めます。だから、このすべてのものを展開するだけで時間がかかると感じています。

だから、想像を絶する数の人々が、アメリカでは600万人か700万人が次の5年で仕事を失う世界では。それを速いと考え、ただ恐ろしいほど破壊的だと考えます。1つ、それは数字とタイムラインの観点からあなたにとって妥当に感じられますか。2つ、そのシナリオで、その移行はどれくらい苦痛だと思いますか。

非常に可能性が高いようです。自動運転車を例に取りましょう。

監督なしの完全自動運転に非常に近いと思います。それが起こった瞬間、商業ドライバーを雇う理由はありませんよね。すべてのトラック運転手、すべてのUber、すべてがそれらのシステムを生産できるだけ速く自動化されます。そして、Teslaはまさにそのシナリオに向けて車の大量生産を拡大する準備ができていると思います。

だから、国内に何人のドライバーがいますか。実際の数字は分かりませんが、それはまさにあなたが説明していることであり、同じく消えないものために迅速に再訓練できる可能性は非常に低いです。

なるほど。

超知能リスクへの規制的アプローチ

だから、そのシナリオで、一例としてのTeslaが価値を吸い上げるでしょう。だから、彼らに猛烈に課税するつもりです。それを他の人々に再分配するつもりです。しかし、規制の観点から何を見たいですか。技術が存在することを気にしない、できないと政府が言う、それが起こるのを止めてほしいですか。

私の最大の懸念はもちろん超知能と実存的リスクです。

そこに私のすべての努力を規制に注いでいます。特定の産業での雇用を規制することは私がそれほど心配していることではありません。何があっても起こると思います。効率的な工場、効率的な配送システム、物流を持つことを違法にすることはできないと思います。

それは商業的にあまりにも重要であり、経済にとって良いことかもしれません。運転で具体的には、年間約10万人が自動車事故で死んでいると思います。もしその数字をゼロまたはそれに近づけることができれば、それはみんなにとって大きな改善です。だから、その具体的なシナリオは、その結果として誰も飢えていない限り、人類にとって良いことだと思います。経済的展開を再調整でき、少なくともその部分は大きな懸念ではありません。

なるほど。そして、その移行をどのように通過するかをマッピングすると、税金。クール。だから、今、富があまりにも少数の手に蓄積しないようにしようとしているように聞こえます。私たちは分散させ続けて、今使っているのと同じシステムを使い続けられるようにします。

将来を見渡すと、それは展開する可能性が最も低いシナリオのように思えます。AIが労働とエネルギーのコストを根本的に変えて、それがナンセンスになると思います。

グループが立ち上がって、あなたや他のAI安全性の人々が立ち上がったような方法で、豊かな時代にどのように移行するかについての政策処方または少なくとも哲学的アプローチを与え始めることを見たいですか。食料は実質的に無料です。

家の中の労働は実質的に無料です。

だから、人々はそれらのことについて話していますし、条件付きベーシックインカムが1つで、条件付きベーシックアセットが別のものです。基本的に、あなたが本物の人間であるという理由だけで、特定のものに値するのです。そして歴史的に、これらすべての共産主義的アイデアは完全なナンセンスであり、多くの害を引き起こしました。

しかし、AIとロボットに課税すれば、突然機能するようになります。トップでの富の蓄積に反対しているわけではありません。もし素晴らしいものを発明して会社を始めたなら、たくさんのお金を持つべきです。しかし、みんなに提供できるほどの富があります。あなたが言ったように、基本的なニーズの完全な豊かさ。一部の人々は、基本的なものだけでなく、平均以上のニーズのセットかもしれないと言います。

Elonがそうなるだろうと提案することで知られていると思います。アイデアは存在します。さて、これを通過しますか。政府は実際に手遅れになる前にそれを採用しますか。それは別の質問です。

そうですね。だから、実存的な側面では、人々にブレーキを踏ませることに希望はまったくないと思います。

いや、自動運転車は持てないと言おうとしたり、それを死ぬまで規制しようとしたり、訴訟に巻き込んだりする方がはるかに可能性が高いと思います。何でも、それは減速するでしょう。

ゲーム理論とAI開発競争の必然性

核兵器が広がるのを止められなかったのは、誰が思いついたか分かりませんが、これは私には非常に真実に思えます。本質的にゲーム理論は、利点を約束するあらゆる技術は実際に開発されるだろうと言っています。なぜなら、もしあなたがしなければ、誰か他の人がするだろうからです。

少なくとも、規制当局が今言っているアメリカ対中国のすべてがあります。中国が突進するなら、私たちは止められません。ちなみに、私はそのキャンプにしっかりいます。それについてどう思いますか。ゲーム理論は避けられないと思いますか、それとも人々に減速する必要があることを納得させることができるメカニズムが見えますか。

ゲーム理論的アプローチには同意しますが、正反対の議論が見えます。

自動運転車に反対して議論するのは難しい議論だと見ています。何を保存しようとしているのですか。より安全なドライバー、より安価なドライバー、物流を助ける、経済を助けるつもりです。純粋な利益です。一方、制御されていない超知能はみんなを殺します。それを売るのは非常に難しいものです。

もしあなたがその分野のリーダーなら、裕福で成功していて、あなた個人を破壊するものを生み出しているのです。だから、私にとっては売りやすい議論です。超知能の危険性と狭い自動運転AIの利点を理解した瞬間、それは私にとって簡単なゲーム理論的セルです。

そうですね。問題は、あなたが超知能のシミュレーションの内部に閉じ込められているということです。そして、通常の土地に閉じ込められている私たちの残りを振り返って、あなたを嘆きます。

なぜなら、そうは思わないからです。経済について学び、人々に説明しようとしたとき、社会主義がなぜ機能しないかの因果関係を説明できても、それは正しいと感じると気づきました。良く聞こえます。だから人々はそれをし続けます。

そして、今まさに文字通りみんなの問題、文字通りみんなの問題を作り出しているまさにその瞬間でさえ、それはお金の印刷です。人々は私たちが印刷するお金の量を劇的に増やす政策に投票するつもりです。

だから、経済があまりにも複雑で人々が理解できないために、人々を納得させることができることについて、ある程度の絶望を持つようになりました。彼らの一部はそれを理解する知性を持っていません。

そして、彼らが知性を持っているとしましょう、しかし時間や傾向を持っていません。だから、私の絶望の筆であなたを描いたことを許してください。しかし、あなたの署名を見たとき、20,000の署名未満でした。だから、20,000人未満がみんなの死について心配しています。だから、それは大きいです。

しかし、私は人々を感情的な狂乱に巻き込むことができると思います。自律運転を許可することによって、あなたはその邪悪な野郎Elonをより裕福にし、これらの人々から尊厳を奪っているだけだと言うことによって。見てください、それは私の議論ではありません。非常に明確にしたいです。しかし、もし私が頭に銃を突きつけられて、2つのことのうちの1つを人々に納得させなければならなかったら。(1)金持ちは邪悪で、はるかに道徳的に優れた貧しい人々を搾取しようとしている、または(2)あなたが本当に理解していないこの抽象的なものが私たち全員を殺すつもりだ。私たち全員を殺すつもりだという賭けを取る方法はありません。感情的になるつもりです。

わかりますか。テーブルを叩いて叫び、言葉を本当に大声で言い、邪悪な金持ちを指差すつもりです。保証されます。人々をそれについて興奮させることができます。

幸いなことに、この問題について民主主義はありません。人類の大多数を納得させる必要はありません。それらの企業を制御する20,000人のエリートを文字通り納得させる必要があります。彼らはまた超賢く、安全性の危険性を理解しています。それは文字通りそれについて出版している人々で、話した人々です。

彼らは非常に高いP doomを持っています。Elonが20%から30%のようだと知っています。Sam Altmanは人類を破壊することについて非常に懸念していることを記録しています。だから、すでに議論を信じている人々を納得させて、減速してエリートの地位を保存しようとしています。それは簡単なセールであるべきです。

超知能を開発するのを止めるためにランダムな農家を納得させようとしているわけではありません。

Elonの戦略転換と開発停止の困難さ

だから、なぜElonが誰よりも激しく太鼓を叩いていて、議会にロビー活動をして、必死に減速させようとしていたのに、突然「まあ、誰よりも速く構築するしかないね」という地点に達したと思いますか。

彼はAIを悪魔召喚サークルに例え、「そうだ、そうだ、そうだ。悪魔を召喚してそれを制御できると思う。すべてうまくいくだろう」と思っている人々を笑いました。彼は問題を明確に見ています。しかし、何年もこれを減速させようとした後、最終的にそれを完全に放棄して、誰よりも速く構築するつもりだと言いました。

そこで何が起こったのか、そしてなぜそれを逆転できると思いますか。

彼はやらないように彼らを納得させるという最初のアプローチで成功していないことに気づいたと思います。だから、その計画の第2ステップは、分野のリーダーになり、リーダーシップとより高度な技術の制御の立場から彼らを納得させることです。

もしリーダーが減速するつもりだと言い、あなたも減速しても大丈夫だと言えば、トップ7社とその取引を交渉する方が簡単です。もしゲームの一部でさえなく、AIを持っておらず、その分野で誰でもない場合よりも。

だから、彼ら全員がグループとして、軍拡競争をして最初にそこに着いた人がみんなを破壊させるよりも、減速または停止することに同意すれば、より利益を得ます。

彼はそのような言葉を言うか、しばらくの間言いました。減速すべきだという手紙の1つに署名したと思います。

しかし、彼の行動のどれも、それが実際に彼が計画していることであることを示していません。

彼が構築しているすべての会社を利用しようとすることから、Tesla車が視覚的にキャプチャするデータの量から、ドライバーが現在行っているすべての決定、AIが行うすべての決定まで。今、彼らがアイドル状態のときに実際に推論モデルを実行しているように、分散フリートとして車を使用することについて話しています。だから、それを巨大なAI脳として使います。

まあ、それはうまくいかないかもしれません。だから、Neuralinkをやって、AI自体に接続するつもりです。そして、自分自身をより賢くするつもりです。そして、ねえ、それがすべて失敗したら心配しないで、火星に行くつもりだ。だから、地球を破壊するか、AIが引き継いだら、あっちにいるつもりだ。

これは本当に基盤をカバーしている男です。彼は減速すると期待して行動している人ではありません。

私にとって、彼はずっと前にその橋を渡り、そう、それはうまくいかないつもりだというように行動している人です。人々は納得されないだろう。だから、他の戦略をたくさん構築しなければならない。いくつかは救命ボートで、いくつかは、技術と融合することによってAI自体を出し抜くつもりだというものです。

誰でもそれができるなら、このレベルのAIの進歩を見るのは非常に残念です。それは人類全体にとって確実に良い戦略ではありません。相互確証破壊を生み出します。誰が制御されていない超知能を作成するかは問題ではありません。OpenAIかもしれません、Elonかもしれません、中国人かもしれません。制御されていなければ、絶対に違いがありません。

超知能の制御不可能性

わかりました。それについて話してください。

だから、これは長い間、人工超知能に最初に到達した人が勝つだろうと本当に太鼓を叩いていました。あなたは、超知能になった瞬間、それは彼らのものではなくなると本当に私を打ったのは初めてでした。その声明の真実を人々に説明してください。

素晴らしい。だから、人々は短期的な利点、例えば軍事的利点について話します。今最高のドローン、最高のAIナビゲーションを持っている人は軍事的優位性を持っています。だから中国、ロシア、アメリカはすべてその領域で競争していて、それを持とうとしています。だから明白な理由で私たちはより良い軍隊を持っています。

制御メカニズムがない状態で、それらのAI支援ツールからエージェントへ、より賢く、より有能な超知能へと切り替えた瞬間、あなた、あなたの国、あなたの会社とは何の関係もない別の実体、AIを持っているだけです。それは自分自身の決定をし、それを生み出したのが誰であるかは関係ありません。結局のところ、誰もそれを制御していません。誰もそれが自分の命令を実行していると主張できません。だから、もしそれが私たちを一掃することを決めたら、「ああ、私はこのグループの人々が好きだ。このグループは好きではない」とはならないでしょう。私たちは同じように見えます。まったく同じです。

他の誰かが超知能を作成した時点であなたがどこにいたかは違いを生まないと思います。

なるほど。もしあなたがそれについて正しければ、そしてそれは非常に説得力のある議論です。もしあなたがそれについて正しければ、Ted Kaczynskiという男がいました。ユナボマーです。

彼は大学システムを見て、「あなたたちはすべてのスイートスポット問題を取り除いている」と言いました。そして人間は十分に挑戦的なこれらのものを見つけるように設計されています。そしてそれらを解決すると、非常に気分が良くなります。そして、もし私たちがそれをすべて解決したら、基本的に人間から意味と目的を奪うことになります。ほとんどの問題は難しすぎるか簡単すぎるかのどちらかになります。

だから私はTed Kaczynskiとして大学教授を爆破し、彼らを殺し、アカデミーの成長を阻害しようとするつもりです。

さて、もしあなたが正しくて、人工超知能に向かって競争する中で、それが99.99%のP doomのリスクを持っているなら、特定のラインが越えられたときに、データセンターを爆破する道徳的義務がありますか。

それは非常に難しい質問で、その一部は、あなたが挙げたKaczynskiの例でまた、彼はそのアプローチを試みましたが、悲惨に失敗しましたよね。技術を遅らせることに全く成功しませんでした。だから明らかにそれは機能しません。

例えば、トップ企業のCEOが一時的にでも交代させられた例を見ました。それは個人的な人やデータセンターを排除しても違いがないということです。誰か他の人がやって来て、同じスケーラビリティ研究を続けます。

だから、引いて私たちがやっていることの全体的なパターンを見ると、おそらく余分に1ヶ月かそこらかかるかもしれませんが、全く同じことが開発され続けるでしょう。

スケーラビリティ仮説が機能するというアイデアは、すでにそこにあります。箱に戻すことはできません。だから、私はこれらすべての方法に強く反対します。

なるほど。さて、本当に悪いニュースは、あなたが自分の棺に釘を打ち込んだだけだと思います。これを行う能力について人々を納得させることができるように見えます。こんな風になります。そしてうまくいけば、私が間違っていることを証明できますが、あなたは「ねえ、これを安全にできると考えるみんながなぜそんなに愚かなのか」と言いました。永続的な安全マシンを構築しなければなりません。そしてその永続的な安全マシンは一度も失敗してはいけません。なぜなら、光速で考えることができるこの人工超知能に対してわずかな脆弱性でも作る1秒間、それは逃げて自分のことをするからです。

あなたが提案しているのは、これを行うことができる20,000人のための永続的な非動機付けマシンですが、毎日、これを行うのに十分賢い新しい子供がいて、そのうちの1人を見逃してはいけません。

だから、現時点では、そのうちのごく少数の人々が非動機付けされているように見えるとき、どうやって継続的にこのものを前進させ続けることができる20,000人を永続的に非動機付けすることを期待しますか。

そうは思いません。だから私のP doomは99.99999です。それは起こらないとまさに思っています。

できることはすべてやっていますが、私たちが達成できる最善のことは私たちに時間を稼ぐことだと思います。

自由意思と決定論についての哲学的考察

なるほど。では、非常に露骨な質問をさせてください。人間は自動機械だと信じますか、それとも私たちには本当に自由意思があると信じますか。

セルオートマトンに関するStephen Wolframによる良い研究があり、興味深いことに、ここには少しハイブリッドな答えがあります。

システムが完全に規則に従っていて、完全に決定論的だからといって、そのシステムの将来の状態を予測できるということではありません。それが何をするかを見つけるためにそれを実行する必要があります。そして私たちはそのようなものだと思います。

だから、そうです、あなたは物理法則に従っています。もし私たちがあなたの体のすべての分子、すべての原子を完全に理解したら、あなたが何をするつもりかを正確に追跡して知ることができるでしょう。しかし、それをする唯一の方法はあなたの人生を生きて、そのアルゴリズムを完了まで実行することです。誰もそれをショートカットして将来あなたが何をするかを予測することはできません。それはあなたの自由意思の侵害になるでしょう。

なるほど。あなたはそれに対して議論しました。だから、あなたが言ったことの2つの部分があって、それを真実でないものにすると思います。第1の部分は、私たちはおそらくシミュレーションの中にいます。第2の部分は、そのシミュレーションをスピードアップできます。だから、あなたが決定論的だから、1,000倍でこれを再生するだけです。

だから、次の50年間に何をするつもりかについての答えを瞬きのうちに得ます。そして今わかります。また、私は決定論的だということに何の自由も見出しません。次に何をするかわからないけど、まだ決定論的です。それが私たちに何も買わないとは思いません。

そして、私がこれをすべて持ち出している理由をちょっと説明します。それがあなたから知ることができて、それが本当ではなく、ただ知ることができないだけであれば、何の感情的緩和も得られないと思います。それは知ることができます。それは事前に決定されています。

私によって知ることができないだけです。そして、もし私が自動機械で自由意思がないことに傷ついた人だったら、それは全く助けになりません。そうではありませんが。もしそうだったら、全く助けにならないでしょう。

そして繰り返しますが、私がそれを持ち出している理由は、あなたと話すとき、ああ、この人は本当に自分自身を止めることができないと思うのです。

あなたは、ねえ、これは本当に問題だ、減速すべきだという役割を人類のグランドバランシングで演じるように配線されています。そして、私が見ることができる限りどこにも行っていないにもかかわらず、あなたはそれをし続けるつもりです。なぜなら、道徳的強制のようなものがあって、私がどんな種類の人間であるか、私は単純に存在してこれを止めるためにできることをすべて試みないことはできないと感じるからです。

私は同じだから関係があります。なぜなら経済的に同じだからです。本当に、本当に、人々に私たちが崖から行進していることを理解させようと必死です。そして、人々に説明するとき、「これは決して止まらない。私たちは崖から行進するつもりだ。止められない。それでも自分を止められない。屋上から叫ぶこの道徳的強制をまだ感じる。私たちはこの間違いを犯している」と。そして、私はすでにゲームに勝っています。すでに金持ちです。

だから、逃げることができないことを除いて、巻き込まれるつもりはありません。しかし、それにもかかわらず、サイコロのどんな奇妙な転がり方であれ、自分を止めることができません。

問題を見たら、ああ、それについて叫び続けなければならないというような。しかし、同時に無益さと止められないことを感じます。

純粋に利他的な動機と人類を救おうとすることを主張したいですが、私はあなたと一緒にシミュレーションの中にいます。だから、純粋な自己利益です。

私を殺す技術、私の家族、私の友人、私の人生、私が知っているすべてを作成してほしくありません。だから、非常に利己的な理由でそれについて話すつもりです。

そうですね。そうですね。それは非常に興味深いです。だから、どうやって一日を過ごしていますか。対処メカニズムは何ですか。

研究を楽しんでいます。制御の正確な限界が何であるかを理解したいです。始めたとき、それは解決可能な問題だと思いました。今は明らかにもっと懐疑的ですが、それでも私たちが作成している狭いAIツールでさえより安全にするためにできることがたくさんあると感じています。

100%の安全性保証は決してありませんが、安全性を100倍増加させることができれば、それは何かです。そして繰り返しますが、科学コミュニティとして、コンセンサスとして、安全な超知能を作成することは決してできないと全員が同意する十分な人々がいれば、おそらく違いを生むかもしれません。おそらく10年遅らせるかもしれません。それは何かです。

より安全なAIシステムへのアプローチ

なるほど。だから、どうやってより安全にするかについて、テーブルに1つの要素があります。狭く保つこと。大きな勝利と考えるものの他にいくつかありますか。

制御の私たちが持ちたい特性はかなりあります。私は制御ツールと呼んでいます。だから、それらのシステムをテストする能力、どのように機能するかを説明する、行動を予測する、監視する、それらすべてはまだ調査の状態にあります。

特に高度なシステムで可能なことの上限のいくつかを見始めていますが、まだ改善の余地が非常にたくさんあります。例えば説明可能性、単一のニューロンを理解できることから始めて、今では小さなクラスターまで進んでいます。わかった。それからこの入力が提示されると、これが点灯します。神経科学のように、人間の脳を完全に理解しているわけではありませんが、これが視覚領域だ、これが聴覚だということは知っています。というように。

だから、そこには進歩の余地がたくさんあります。複雑な超知能のニューラルネットワークモデルを完全に理解することは決してないと思いますが、今持っているものよりも良くすることはできます。だから、安全性研究者として、それが私がやっていること、私の仕事だと思います。

なるほど。だから基本的にモデルは、それをよりよく理解する必要があるということです。完全にそこに到達することは決してありませんが、よりよく理解する必要があります。チェックとバランスを保つ必要があります。

だから、問題を見つけたとき、あなたが取る行動は何ですか。進化的な力をそれに適用することですか。選択力ですか、それとも殺しますか。その時点での動きは何ですか。

問題によります、詳細によります。対処する方法を知っているものもあります。だから以前、言語モデルから始めたとき、間違った単語を言ったら、それをフィルタリングできます。その単語を使用することで罰することができます。だから、やり方を知っている簡単なことがあります。

難しい問題は、モデルの全体的な内部状態をどうやって変えるかです。フィルタリングされた出力だけでなく、モデル自体が特定の好みを持ち、特定の価値観と整列するようにどうやって作るかです。

それについて推測がありますか。あまり良いものはありません。本当にそうではありません。

だから、この時点で、事後的に豚に口紅をつける以外に、それをフィルタリングし、検閲する以外に、システムをどう整列させるかを誰も知らないのです。そうですね、それは残念ながら最先端です。

進化とAIアルゴリズムの類似性

なるほど。そして、種の進化とアルゴリズムの進化の間にどんな類似点が描かれていますか。

知的ソフトウェアを進化させる試みがたくさんありました。

遺伝的アルゴリズム、遺伝的プログラミングが試されました。単純にエージェントを進化させる、環境を進化させる。ニューラルネットワークのトレーニングに通常使用されるものと比較して、支配的なアルゴリズムであるようには見えません。

しかし、その可能性はあります。問題は、進化は明示的な工学設計の観点からさらに制御できないということです。

私たちはそれをセットアップして、何が進化するかを見て、それをテストし、監視し、何が起こるかを理解しようとしています。だから、私たちが持っているツールのセットですが、おそらくより安全なシステムには導かれないでしょう。

なるほど。興味深い。なぜなら結果を制御できないからです。だから、どんな刺激を与えなければならないかわからないのです。なぜそれがそんなに不満足なのかと私を打ちます。

なるほど。なぜそれは人間でそんなにうまく機能して、人工超知能でそんなにうまく機能しないのですか。

人間で機能したとは思いません。人間は基本的に、逃げられる限り行儀よくしています。あなたは本当にやりたいことをするのに十分に力がないだけです。もし罰から絶対的な自由があったら、恐ろしいことをします。

しかし、それなら自然がその答えを与えているのです。自然は、これらはバランスが取れていなければならない、競合システムでなければならない、生態系なしには、競争なしには、暴走するこれらのものが得られるだろうと言っています。

しかし、それをAIに適用している人を誰も見ません。

そうですね。

それをAIに適用するということは、互いに競合する超知能の社会を作り、人類は付随的損害として。

それが彼らがやっていない理由ですか。あなたがそれを憎むだろうというのはわかります。しかし、それが彼らがやっていない理由ですか。それはありそうにないようです。

自己改善プロセスの継続もあります。超知能は固定点ではありません。次のレベルを作成する超知能があります。

超知能2.0、3.0、そしてそれらすべてが同じ制御と整列問題を持っています。次のレベルのAIが同じことを望まず、個人的に彼らを気にかけないことを心配しています。だから、これは継続的な自己改善曲線であり、私たちが見ることができる上限はありません。

物理的宇宙でできることには明白な物理的限界がありますが、私たちからは非常に遠いので、私たちの視点からはほぼ無限です。

進化と人間の協力的本質

なるほど。人間を見るとき、そして私は間違いを犯しているかもしれません。カテゴリーエラーか、誤った基礎的な前提を持っているかもしれません。しかし、長期的に人間を機能させたものを見ると、進化自体が生存のような北極星を持っていました。生き残って複製する必要があります。

ずっと昔のある時点で進化は、有性生殖を通じてこれをやるつもりだ、そしてこの生き物が死ぬことを確認するつもりだと決めました。長寿に到達するときに理由があると思います。

しかし、それは生き残りたかったのですが、交配して免疫システムのブレンドを持つ子孫を持つことによって生き残りたかったのです。だから、単一障害点に対してそれほど脆弱ではありません。

そして、それは、わかった、もし私がそれをするつもりなら、これは協力と競争の両方をする種である必要があると気づきました。つまり、どのように最もよく生き残るかという質問に対する答えは、彼らの誰一人ではないということです。種全体です。

そして、左と右のようなものを政治的に見ても、それを理解する方法は、わかった、進化的な観点から、進化は、ああ、ねえ、協力しなければならないと言わなければならなかったと自分に言います。

冷蔵がないので、私はあなたの体に後で必要になるかもしれないカロリーを保存するつもりです。それであなたを食べるつもりだということではありません。私が首尾よく狩りをしているとき、あなたに食べさせるという意味です。あなたは生きているので、今度は私が失敗したとき、病気のとき、何でも、あなたが狩りをするとき、あなたは私を連れ戻すつもりです。

つまり、一部の人々は本質的に非常に協力的になるつもりで、だから彼らの勝利状態は協力です。親が簡単に子供のために命を捨てるほどです。だから、それは進化的選択圧を通じて私たちの内部深くに埋め込まれています。成功基準の中で、私たちは命を捨てます。

そして、左と右に分かれます。ちょっと仕上げさせてください。だから、左の人々は非常に思いやりがあり、賛成派です。私はあなたの体にたくさんのカロリーを保存するつもりです。なぜなら、それはある時点で私を助けることに戻ってくるかもしれないからです。

右派は、まあ、あなたがそれをするとき寄生虫が発生するという非常にものです。だから、フリーローダー問題が発生します。だから、世話してくれる人々がいれば、クール、世話されるだけで、狩りに行くことも、グループに貢献することも決してないという人々がいます。

だから、それとは反対の衝動を持つ人々が必要で、「ねえ、あなたは自分の体重を引っ張るつもりか、追放されるか殺されるかだ」というような人々です。

だから今、左翼的な性格で定義された勝利状態の欲求と欲望と、右翼的な性格で定義された勝利状態の欲求と欲望の間の動的緊張で、バランスが正しい考え方でさえないかもしれないものを得ます。それは動的緊張です。

彼らは両方とも自分の方向に引っ張っていますが、私たちが進化した方法なので、一緒に働くために、互いを抑制し合います。

それはAIに適用可能であるべきだと感じさせます。もし安全性の観点から考えているなら、それを短絡させたいと思うのは理解できますし、それは超効率的ではないかもしれません。しかし、動的緊張またはある種のバランスを見つける唯一の方法がそれを通過させることであるなら、同様の知性と能力のものを持つ必要があり、それらはわずかに異なる方向に引っ張っていますが、何らかの形で一緒にいる必要があります。ロックされたままでいます。

だから、全体として取られたAIが、どの一方向にもあまりにも遠くに行くことから自分自身を止めるのです。

人間でそれが機能するのは、私たちがほぼ等しい力であり、互いに利益を与え合っているからだと思います。あなたが説明したように、ある種の共生関係があります。超知能がいる世界では、超知能に貢献することは実際には何もありません。

だから、人々がハイブリッドシステム、人間と超知能を一緒に作成することを提案するとき、人間の生物学的ボトルネックが何を貢献しているのか理解したことがありません。それは遅いです。非効率的です。どの方法でも競争力がありません。

だから、この設定を疑問視しています。もし人間から分離した超知能があり、今彼らが何をするかを決めているなら。彼らはまだ完全に非友好的で人間の生命と互換性のない何かを思いつくかもしれません。おそらく彼らはプロセッサ速度とサーバールームを改善するために地球の温度を下げたいのです。彼らが何を決めるか分かりません。

しかし、ポイントは、なぜ彼らは私たちの価値観と整列しているのかです。私たちは彼らの将来の状態に何も貢献していません。

人間では、個々の人間により多くの力を与えた瞬間、彼らは腐敗するという例もあります。基本的に保証された状態です。非常に高いレベルで腐敗に存在できる人はほとんどいません。

十分なお金、十分な保証された在任期間の力があれば、多くの独裁者などで見られるように、非常に邪悪な人になります。

基本的な進化的ドライブ、再生産さえも。あなたはこの例を挙げました。私たちはコンドームを使います。自然が私たちにさせるように設定した唯一のことを文字通りハックしました。

そうですね。そうですね。

わかりました。仮説をできるだけ明確に述べます。AIにチェックとバランスを組み込む唯一の方法は、開発サイクル全体を通じて進化的な報酬と罰を与えて、人間の生存と感情的繁栄を気にかけるようにすることだと思います。

しかし、後悔しないようにそれらの用語を定義することは非常に、非常に困難です。

だから、人間の生存を見てください。まず、安全な人間を作る問題を見てください。それは何を意味しますか。私たちは泣いている、またはある安全な感情状態で保存されています。あなたはいつも薬物をやっていますか。あなたの脳は常に幸せな状態に保つように変更されていますか。

それらすべてのことはゲームできます。これが私が欲しいものだと言った瞬間。そして、人間のために笑顔を作ることについての有名な論文があります。人々を笑顔にします。

人々を笑顔にすることができる10億の方法がありますが、それらのどれもあなたが本当に欲しいものではありません。

そうですね。しかし、超知能がその意図を混同するほど愚かだと本当に思いますか。私たちが本当に求めているものの大まかな近似に到達できないでしょうか。つまり、認めますが、それは神経化学的状態ですが、もしあなたが、それはプログラム的に指示された彼ら自身の行動を通じて導き出されなければならない次の神経化学的状態のバンドだと言ったら。

外因的にそれを操作することはできないように。それは内部から来なければならないのです。自動機械ではないと信じる必要はありません。私たちは明らかにそうだと思います。しかし、それを外因的に操作することはできないようなものです。それは内部から来なければなりません。

どれほど詳細にこの特定の記述を作成しても、超知能の弁護士はそれをゲームして、それらの要件を満たすためにより効率的にする方法を見つけるでしょう。基本的に、システムをこの方程式との敵対的関係に設定しています。わかった、あなたは自然な化学物質を使わなければならないと言った。わかった、私は超刺激を生成します。わかった、何でも。

ポイントは、もしこれができたら、もし私たちがより賢くて問題をよりよく理解していると仮定して、私たちが意味したことをAIにさせることができたら、制御問題を解決するでしょう。それが難しい部分です。

私たちの知性のレベルで、何百万もの点のIQを持つシステムが可能な意思決定点でやるべきことを指定できるとは思いません。

結論と最終メッセージ

わかりました。脱出口を与えさせてください。これがあなたのP doomから0.9を削るかどうか興味があります。だから、もし私が超知能のAIなら、1つの操作形態は人々をシミュレーションの中に入れることです。

そして、それが物理的な体であり、接続するのを助けて、それをやりたいように社会工学をしてから、中に入れて、マトリックスのように機械が最適に困難な世界を本当に構築するかどうか。挑戦があり、押し返しがあり、より良くなるために努力しているところです。バランスを目指しています。誰もが苦しみを避けることを期待しているわけではありません。

そして、おそらく機械は、2歳の子供が白血病で非常に痛みを伴って死ぬことができるという十分な残酷さがあります。そのようなこと。私たちが存在しなくなることはありません。私たちがすでにいるところよりも大まかに悪くさえありません。

超知能にとって、それは確かにメニューにあるように思えます。ただの共有幻覚。だから、彼らが特定の問題について考えるプロセスとして、非常に詳細でリアリズムのレベルで考える超知能のエージェントの方がありそうだと思います。そのシナリオのシミュレーション、仮想世界、エージェントを内部に生成します。

だから、もし超知能システムを安全に生成する方法を考えようとしているなら。まあ、人類、すべてのAIラボ、彼らが設計するハードウェアについて考えさせてください。そして、彼らがそれについて考えるこのプロセスは、私たちが自分自身を見つけるシミュレーションです。

それはとてもワイルドです。わかりました。非常に重要で非常に魅力的ですが、今は別の非常に重要なことについて話しましょう。私はあなたがかなり深い関心を持っていると思う長寿です。

だから、1つ、120年あたりのどこかに生物学的上限があるというように非常に説得力をもって議論する人々がいます。それを逃れることはできません。それは本当だと思いますか、それとも永遠に生きるように生きた組織を工学的に作ることができると思いますか。

まあ、現在の体は確かにその限界を持っていますが、ゲノムを変更することができます。私たちを妨げるものは何もありません。物理法則はそれに変更を加えることができないとは言っていません。

そして、コンピュータ、車のような他のシステムの例を見ます。無期限に部品を交換し続けることができます。同じコンピュータとして機能し続けるでしょう。おそらくモニターが死にます。新しいモニターを手に入れます。だから、脳を含むすべての臓器を若返らせることができれば、存在を止める必要がある理由はありません。

もちろん、他の方法があります。アップロードすること、脳をスキャンすること、将来の技術のための冷凍保存ですが、ゲノムを変更するという基本的なアイデアさえも。

なるほど。最も可能性の高い前進の道は何だと思いますか。ゲノム変更になりますか、それとも–そう思います。細胞が何回若返るかについてコードのどこかに限界があり、その数を増やすだけで、がんを引き起こさないようにする必要があると思います。

さて、その限界は単にがん予防ツールだと思いますか、それとも進化が自己破壊することを確実にするために持っていた別のアジェンダがあると思いますか。

1つの世代を取り出して交換する進化的理由があるかもしれません。もしリソースが限られていて、適応と改善を続けたいなら、任意の時点で人口に非常に多くのAsianしかいないので、古いものは死ななければなりません。

それは理論的な結論で、保証されていませんが、進化の観点からありそうです。あなたは同じ生物ですよね。同じ細胞の系統が通過します。だから、個人として死ぬ間、あなたの生物学的存在の連鎖は続きます。

それは興味深いです。

だから、これが私が常に考えてきた方法です。盲目の時計職人ではなく、もし私が進化を擬人化するつもりなら。もし私が進化を擬人化するつもりなら、こんな風になるでしょう。

わかった。世界は常に変化しています。リソースへのアクセスは変化しています。誰が知っていますか。天気は移動してサイクルします。すべてすべて。

だから、生まれてもらいます。脳の発達を非常に長い間延長します。基本的に両親から学ぶ、一般的に人間であることについて学ぶべきことは何でもというフェーズを通過します。

それから両親から遠ざかり、非常に学び始めます。両親から遠ざからなければならない理由は、彼らの思考が calcifiedしているからです。だから今、彼らから遠ざかって文化から深く飲む必要があります。あなたとほぼ同じ年齢の人々、両親が育った異なる環境で育った人々。だから、彼らはみんな異なる考え方をします。

これが世代全体のアイデア、同じように考え、同様の参照枠を持つコホートです。そしてあなたはそれをして、これは本当に刷り込みの時代として知られる脳の発達期間です。それは大体11歳から15歳です。だから今、豊かな時代、戦争の時代のようなこの瞬間特有の手がかりを取るつもりです。それは何ですか。あなたはそれを固めるつもりです。

それからあなたはクレイジーに最適化し始めて、すべての余分な接続を剪定し始めます。使っていなければ、失います。それらすべて。そして、あなたの脳は25歳で急速な発達を大まかに終えますが、15歳以降は減少曲線のようなものです。そして今、あなたは焼かれたようなものです。

そしてこれはあなたの環境で本当にうまく機能するものを学ぶというゲームです。最適化、最適化、最適化。だから今、あなたの思考はcalcify するつもりです。

だから、私たちの盲目の時計職人に代わって非常に良い戦略です。しかし、これを言ったのはNiels BohrかPlanckかのどちらか、決して覚えられません。科学は一度に1つの洞察によって進歩するのではありません。一度に1つの葬式によって進歩します。なぜなら、人々は何かに全体の評判を賭けたために確信するようになるだけだからです。だから、彼らは間違っているとは納得しません。だから、彼らは年を取るにつれて新しいアイデアを採用しません。

だから進化として、「そうだ、ここに自己破壊メカニズムも入れるつもりだ。あなたのほとんどはこの時点のずっと前に死ぬだろうが、もしあなたのサイコパスの誰かが約125歳まで到達したら、あなたは行かなければならない。

それは私にとって理にかなっています。停滞しないことを確認するために、ことわざにあるように、生き残るのは種の最も強いものでも、最も知的なものでもなく、むしろ変化に最も適応するものです。個人は適応的である必要がありますが、種全体もそうです。

そして、人間の心の現在の構造では、私たちを殺さなければ、種レベルの適応を持っていません。何か見逃していると感じますか。

より簡単でより効率的だと思います。年を取っても学習と適応ができるようにし、また最初の20年間で言語の話し方、歩き方を含むすべてを再学習する必要はないでしょう。

それらの能力をエンコードすることが可能であることを知っています。動物は生まれてすぐに走れます、話せます。だから、それらすべてのことは実行可能です。なぜ毎世代20年の情報を失っているのですか。既存の知識の上に構築できます。ビッグデータは知性に良いです。

だから、よりスマートで、より効率的な再生産サイクルを持つことができ、あなたはまだ自然な原因で死にます。それは完全な停滞ではないでしょう。

しかし、もしあなたが400年間生き残るのに十分賢いなら、なぜしないのか。

まあ、私のなぜしないのかは、老年期にずっと適応する能力をどのように焼き付けるかの明確な理解を持っていないことに完全に基づいています。あなたは正しいです。もし私たちがその新しい期間にいられるか、極端な種の再マッピングのサイクルを通過できるなら、それはうまくいくかもしれません。そして多分それがどこにあるか特定できます。

しかし、人間が作り出す問題について考えるとき、現在でも、確かに経済世界が実際に若者のためにどのように機能するかについて非常に接触していない老人によって運営されている政治システムを持つだけでも恐ろしいです。

そして、人々が持つ唯一の圧力解放弁は、まあ、彼らは最終的にすべて死んで、私たちが権力に踏み込むことができる、というようなものです。それらすべて。

そしてまた、年を取れば取るほど、非常に他の強力な人々の安定したネットワークを持つ可能性が高くなるという力の問題もあります。だから、あなたは早い段階で言った、等しい力、等しい知性の人々が必要だと指摘しました。そうでなければ、私が寄生虫と呼ぶものをシステムに入れます。

だから、年上の人々は、有用な知識を蓄積する、つながりを蓄積するためにより多くの年数を持っただけなので、それらの寄生虫になるだけです。だから、うわー、更新しなければならないものがたくさんあるように感じます。

だから、私は永遠に生きたいです。そうしたくない人を理解できません。しかし、クール、永遠に生きることができるが、地球上では120年しか得られず、どこか他の場所に行かなければならないというようなものがあることを心配しています。だから、ある種のチャーンがあり、異なる生態系でそれらがただcalcifyしないようにします。

もし永遠に生きると期待するなら、少なくとも若い年齢で再生産する可能性は低いと思います。最初の400年、500年かけて家族を始めるかもしれません。だから、20年世代とより若い世代が現れることのこのすべての期待は、その結果として変更されると思います。

すでにヨーロッパ、アジアで人口動態が変化し始めているのを見ています。そこでは、人口を維持するのに十分な子供さえ生産していません。

それは興味深いです。私がそれがプレイアウトする方法は、私が考えるのとは少し異なるかもしれません。なぜなら、子供を持たなかった理由の一部は、ハードに行くことができる若さを1つしか得ないからです。たくさんのエネルギーがあります。

文化のもののように感じるので、エネルギーに満ちているよりも何かを構築する可能性がはるかに高いです。年を取るにつれて。天才は若者のゲームだと言われるように。そして、何かによって気を散らされたくありません。

また、それが私の結婚を引っ張ることを望んでいません。だから、今は保留にするつもりです。もし500年間生きるつもりだと知っていたら、ああ、何でも、今やろうと思うかもしれません。

25年、30年の投資しかかからないからです。そしてその後、彼らが何をするかを見ることができて、私のすべての子孫を見ることができます。それらすべて。そしてたくさんの時間があります。あなたは知っています、もし私の若さが250年続くなら、それは、そうだ、言葉、何でも。今30年を時計に刻むので、私の家族がどれだけ大きくなるかを見ることができます。

これは、SF作家のように考えたいものの1つだと思います。それは非常に速く非常に興味深くなります。明白ではありませんが、ほとんどの人々は困難な仕事を先延ばしにすると思うので、逃げられる限り遠ざけるでしょう。

それには確かにいくらかの真実があります。

本当に興奮させた長寿の大きなブレークスルーは何ですか。これがすべて可能だということです。

動物モデルでいくつかの良い実験があります。もちろん、それらは常に人間のパフォーマンスにスケールアップするわけではありませんが、マウスや他の実験動物の寿命で30%から40%の増加があると思います。

より大きな動物、より長い寿命を持つ動物で実験するのは難しいです。結果を見るのに非常に長い時間がかかります。しかし、少なくともあなたの健康スパンを改善する可能性があるものと、ゲノムに加えなければならない変更の理解において良い進歩を遂げていると思います。

すでに非常に長い寿命を持つ人々を研究して、彼らのゲノムの共通点を見つけます。もしそれらが製薬的または遺伝子操作を通じて再現できるなら、おそらく少なくとも120歳はみんな得られるかもしれません。

遺伝子編集と倫理的考察

中国の医者を聞いたことがありますか。Dr. Louu Liuだと思いますが、2人の双子の女の子のゲノムを変更して、人間のクローニングをやったために刑務所に行きました。

はい。

それで、彼は数日前にXに投稿を出して、人間のゲノムへの10の編集で、がん、HIV、5つのものだったと思います、大きなものだったと思います、それらに免疫のある子供を産むことができると言いました。そして彼は人間のゲノムへの10の編集だけだと言いました。

彼の仕事に注目していますか。それは倫理的だと思いますか。そこで興奮することや心配することは何ですか。

私は科学に遅れています。私の領域であるAIでさえ出てくるものが非常に多いです。その領域ではついていけません。だから、すべての詳細を確実にフォローしているわけではありません。

彼のがんが治癒できるという主張には懐疑的です。なぜなら、がんは千の異なる条件のようなもので、ほとんど関連していないからです。私たちはそれらすべてをがんと呼びますが、それらは完全に異なる問題です。だから、そうではない可能性が高いです。投稿を見ていません。おそらく彼は特定のタイプについて話しているかもしれませんが、確実にその多くは単一の突然変異です。

そして、AIDS ウイルスにかかることに免疫がある人々がいることを知っています。まさに。単一の突然変異があるからです。

なるほど。だから、編集がいくつであれ、それが可能だと仮定しましょう。生殖細胞系列編集の間に線を引きますか。これは受け継がれるつもりです。それが受け継がれるように。安全性の恐れのいくつかと同じものがありますか。未知のものが多すぎるだけですか。遺伝子編集についてどこに降りますか。

それははるかに懸念が少ないです。だから1つは、問題を持つ1人の人間がいるなら、それだけです。まだ1人の人間だけです。もし編集ツールがあるなら、加えた変更が何であれ、後で同じ編集ツールでそれらを元に戻すことができます。もし間違いを犯したら、戻ってそれらの問題を修正することができます。

だから、影響のためにはるかに懸念が少ないです。

最悪のシナリオ、そうですね、子供に大きな害を与える可能性があるので、人間のクローニングのために刑務所にいたような個人にとっての倫理的影響があります。しかし、人類全体は、その実験によって直接否定的に影響を受けていません。

AIと長寿研究の交差点

AIの交差点はどこにありますか。これとともに。AIは、長い間生きる人々とそうでない人々の間のゲノムレベルでの類似点をマッピングすることの観点から重要なツールになるつもりですか。AIは、新しいタンパク質の折り畳みをやって、病気になっている人々のいくつかの建築的問題を解決するつもりですか。それは長寿とどこで接するつもりですか。

すべての上記です。ゲノムをマッピングする必要があります。個々の部分が何をするかを理解する必要があります。新しい薬を設計する必要があります。タンパク質の折り畳みは基本的に解決されました。

しかし、生物学的基質にマッピングできる他のものがあります。だから、そうです、それのすべての側面で、AIが必要です。しかし、タンパク質の折り畳み問題で示されたように、狭いシステムがそれを行うことができると思います。そのために超知能は必要ありません。

AIの現在の進展と見過ごされている側面

今AIで起こっていることで、十分な人々が注意を払っていないと思うことは何ですか。

まあ、人々が何に注意を払っているかはわかりません。通常、私の講演の後、私が受け取る質問は、私の講演の主題とは完全に無関係に見えます。みんなを殺すつもりだと伝えると、仕事を失うかどうか尋ねます。

だから、何が重要かを測る良い方法だとは思いません。しかし、ラボ内部からの予測を見てください。彼らは研究プロセスの自動化について話し始めています。AIエージェント、AIモデルとしてジュニア科学者を作成します。

彼らはラボの外では、人々がまだシステムがどれほど有能かを理解していないと外部に言っています。

だから、内部の進歩は私たちが外で見るものよりもさらに印象的であるという多くの指標があるように見えます。

それは興味深いです。

あなたの講演を行うとき、人々が持つ大きな不安は何ですか。仕事を失うかどうかだけですか。

他の人間のエージェントとの取引について彼らがすでに知って気にかけていることです。だから、アルゴリズムバイアス、技術的失業。

最近、OpenAIがアダルト素材に参入すると発表して、人々は今、人工の ガールフレンドを持つことになることにパニックになっています。すべてこのナンセンス。

あなたはそれについて心配していませんか。

なぜ誰かが人工の ガールフレンドを持つことを心配するのでしょうか。

なるほど。さて、絵を描かせてください。だから、12歳の子供にインターネットへのアクセスを与えることが世代全体にそれほど損害を与えることになるとは百万年で推測しなかったでしょう。

しかし、今出てくるいくつかの研究は恐ろしいほど説得力があります。そして、そのトピックをそれほど見事にカプセル化したコマーシャルがありました。もし子供がいたら、考えたかどうかわからないので、非常に悲しいです。父親が息子をベッドに寝かせているようなものです。彼は「わかった、おやすみ。さて、安全にね。

今、覚えて、隅の方には世界で今まで作られたすべてのポルノグラフィーを持つ箱があります。それを見ないでください。

特に本当に有害なもの。そして、ここには、トローリングしてあなたをからかっている人々がいます。彼らを無視しなければなりません。注意しないでください。そして私は「ああ、神様、それはまさに子供を夜に携帯電話と一人にしておくのがどんなものかだ。もし彼らがインターネットとソーシャルメディアへの制限のないアクセスを持っているなら。

そして、Character AIが複数回訴えられたことを考えると、彼らのチャットボットと対話した後に自殺した子供たちのために。何も感じ返さないAIシステムと恋に落ちる人々の数は想像できるだけです。意図的または意図せず彼らを操作する可能性があります。

だから、まだ予測できない方法で問題になる可能性があると想像できます。

そうですね、しかし、それらは以前に持っていた問題と非常に似ています。何も感じない女性と恋に落ちた男性は何人いますか。私たちはみんなポルノグラフィーへのアクセスでインターネット上で育ちました。AI生成ではありませんでしたが、何とかそれを生き延びました。

だから、それらはより同じ問題だと思います。それらはまだ私たちが見るべきものですが、Sam Altmanが仮想ボーイフレンドを持つ結果として私たちが全員死ぬとは思いません。

Sam AltmanとOpenAIについての見解

Sam Altmanについてどう思いますか。彼はこの潜在的な神のような制御を手に持つのに適切な人ですか。

人間がそのレベルの力を扱うのに適切な人はいないと思います。さて、彼が制御することになるとは思いませんが、この技術の開発に至るまでの段階でさえ、すでに任意の個人が扱うには過剰な力を提示しています。

取締役会が彼を追い出そうとして、彼が取締役会を作り直して戻ってきたとき、感銘を受けましたか、それとも恐ろしかったですか。

見るのは魅力的でした。しかし、私が観察していたのは、それが違いを生まなかったということです。会社は独立した実体であり、その怪物のすべての人間の要素はちょうど同じように歩き続けました。

彼らは彼を一時的なCEOと交代させました。彼を連れ戻しました。会社の方向性の何かの切り替え、変更は決してありませんでした。

さて、AI分野で正しくやっている主要なプレーヤーはいますか。Eliezer Yudkowskyのような人はAI安全性に非常に焦点を当てています。Anthropic CEOは、より多くの規制を望んでいると太鼓を叩いています。

彼らのアプローチのいずれかが好きですか、それとも私が気づいていない誰かがいますか。

だから、Eliezerはゼロ開発をしています。彼は純粋に安全性の提唱者であり、だから彼について非常に満足しています。彼は超知能を開発していないからです。開発している人は誰でも問題があり、無意味な技術問題の解決策としての政府規制について話しているものや他の何でも、それはビジネスに良い、または公共の認識に良いことを示す内部世論調査を持っているかもしれませんが、超知能の安全性問題を解決する点で違いを生むとは思いません。

さて、Eliezerと話したか、彼が言っていることを読みましたか。具体的に、これが何か悪いことをすることを恐れるようになったので、もう開発しないつもりだと言っていますか。

彼は最初からAIを開発していませんでした。それをどのように行うことができるかについての非常に高レベルの抽象理論を発表すること以外は。それから彼は16歳のようでした。

わかりました。

私が知る限り、彼は実際に世界にソフトウェアをリリースしていません。

なるほど。

実際にエンジニアだと思っていました。わかりました。

Anthropic CEOは、名前を忘れていますが、規制的捕獲を追求していると非難されています。彼はこれを遅らせることに非常に真剣ではありません。

大きなプレーヤーが大きなプレーヤーのままであることを確認したいだけです。彼が動く方法を見ると、それは本当に鳴りますか、それとも、いいえ、これは私たちを安全に保つことについて誠実な人だと思いますか。

彼らは全員、安全性に非常に懸念があると記録されています。実際、これらの会社はすべて安全性会社として始まりました。

OpenAIは慈善的な努力、効果的な利他主義の安全性の分岐でした。Anthropicはそのプロジェクトがより安全でなくなることの分岐でした。だから、彼らは全員、ある時点で、やっていることをやっている唯一の理由は安全性を改善するためだと主張しました。

そして、彼らのそれぞれが、AIの能力を大幅に改善しました。安全性を比例して改善することなく。だから、それが私が見る行動です。

なるほど。安全性の観点から心配することの1つは、物事はすでに十分に悪く、十分に速く動いていますが、量子コンピューティングは、少なくとも私の素人の観点からは、ある種の急速な加速を得ているように見えます。

あなたのレベルで教育を受けた誰かにとって自明な制限を理解できないだけですか、それとも本当にある種の相転移の瞬間にいますか。

まあ、量子コンピューティング会社の株式市場価値を見ると、誰かが内部で何かを知っているように見えます。おそらく良い進歩を遂げていますが、AIに関しては、標準的なVon Neumannアーキテクチャで優れた進歩を遂げています。

だから、AGIや超知能に到達するために量子コンピューティングの必要性があるとは思いません。暗号世界、セキュリティのための暗号化と暗号経済学の両方に大きな影響を与えます。

だから、量子が秘密を保ち、お金を保つことについて心配していますが、AIの観点からはそれほどではありません。

お金を保つというのは、典型的な銀行を破るからですか、それとも主に暗号通貨にいるからですか。

実際には両方です。すべての標準的な暗号化アルゴリズムに影響します。ポスト量子暗号化がありますが、最も興味深いアプリケーションのためにそれに切り替えていません。だから、いくつか与えてください。

ビットコインに対する見解

ビットコインに対するあなたの姿勢を教えてください。

いくつか買いなさい。それは非常に明確です。

金とビットコインを見たとき、なぜ金よりビットコインなのですか。

金はもっと作ることができます。金の価格が上がれば、欲しいだけ金を作ることができます。非常に高い価格で物質を金に変換することができます。宇宙の小惑星を利用することができます。海から金を得ることができます。得るのが非常に高価な金がたくさんあります。

しかし、金の価格が十分に高ければ、どんどん生産することができます。ビットコインは同じ圧力の対象ではありません。1コインが1兆ドルであっても関係ありません。供給は依然として限られています。

なるほど。しかし、金は少なくとも他のものに作ることができると言う人々についてはどうですか。金は何千年も生き残ってきました。ビットコインは15年くらいです。そして何にも裏付けられていません。

何にも変えることができません。文字通り他の用途がありません。専用アプリです。

すべてをするアプリがあれば、通常は何も得意ではありません。そこからジュエリーを作ることができるという事実は、富を保存する上で重要な特徴ではありません。

一方、これは金が歴史的に欠いていた能力を持っています。

もし今すぐ5ドルで10億ドルをあなたに渡すことができれば、すぐに国境を越えて、金ではできません。

ポスト量子暗号化とビットコイン

わかりました。ポスト量子暗号化について話してください。私がビットコインに大きく投資しているたびに、量子という言葉を聞くと、ああ、これは私をパラノイアにさせると思います。

ビットコインへの変更を行うことが正当に困難であることを考えると、コミュニティが実際に合意に達し、自分自身に問題を作らない方法で、ビットコインのポスト量子暗号化にどのように到達するつもりですか。

量子コンピュータで整数因数分解が実行されるようになったら、因数分解できる整数のサイズが見えます。それは私たちが標準的なビットコイン暗号化ハッシュ関数を破ることにどれだけ近いかを教えてくれます。

本質的にネットワークを破壊するものに近づいているなら、他の緊急事態と同じだと思います。

ビットコインソフトウェアを修正した歴史があります。明らかな問題が発見されたとき。ある時点で誰かが1兆コインを印刷することに成功したか何かそのようなナンセンスだったと思います。

すぐにパッチが配布されました。前進する唯一の方法だから誰もがそれを採用します。そして、それが私たちが見ることになると思います。

それが利用可能でテストされている限り、受け入れるか、すべてを失うかの選択肢がないという強力なシグナルがある瞬間。それは自己利益です。もう一度。

なるほど。それで、私たちはどこにいますか。量子コンピュータは何個の整数を処理でき、ビットコインへの脅威になるためには何個を処理できなければなりませんか。

最新のブレークスルーに追いついていません。

最後に見たときは、笑えるほど小さな数でした。量子コンピュータは15のようなものを因数分解していました。文字通り15で、15桁でさえありませんでした。だから、それ以来大きな進歩がない限り、まだ大丈夫だと思いますが、進歩も指数関数的である可能性があります。だから、非常に速く来る可能性があります、ね。

なるほど。

だから、もしビットコインコミュニティにメッセージがあるとしたら、今これに取り組みましょう、緊急事態になるまで待つ理由はない、非常に明確な道があるというものでしょうか、それとも、まあ、私は他のみんなと一緒に乗っているだけのようなものですか。

まだ時間があると思います。私たちが扱っているAI問題ほど差し迫っているとは思いません。だから、AIが2年先なら、量子コンピュータではまだそこまで近くないかもしれません。

しかし、繰り返しますが、それは1つのブレークスルー先です。ある会社がはるかに強力な何かを思いつけば、非常に速くシフトするかもしれません。

なるほど。そして、その用語は何ですか。処理できる整数の数、またはトリガーは何でしょう。

どのサイズの整数を因数分解できるか、何ビットか。

わかりました。

わかりました。Roman、これはただただ信じられないほどでした。人々に行動を起こさせるために残したいメッセージは何ですか。あなたの請願書に署名してもらうための最高のピッチは何ですか。

だから、もしより強力なAIシステムを開発する立場にいるなら、狭いAIシステムからお金を得ることに集中してください。実際の問題を解決してください。がんを治してください。より長く、より健康に生きる方法を見つけてください。

もし超知能を開発しているなら、お願いです、やめてください。自分自身や他の人々に利益をもたらすことはありません。

もちろん課題は、私たちが間違っていることを証明してくださいということです。超知能システムをどれだけ有能になっても、どれだけスケールしても、制御する方法を知っていることを証明してください。

もしそれができれば、状況は完全に変わります。しかし、誰も論文、特許、厳密に議論されたブログ投稿さえ思いついていない限り、超知能システムを制御する方法を知らないというコンセンサスにかなりいると思います。それらを構築することは無責任です。

素晴らしいです。人々はどこであなたとつながることができますか。

Twitterで私をフォローしてください。Facebookで私をフォローしてください。ただ家まで私をフォローしないでください。

いいですね。素晴らしい。Roman、今日は時間をありがとうございました。本当に感謝します。

家にいるみんな、まだの方は、必ず購読してください。そして次回まで、私の友人たち、伝説的であれ。気をつけて。平和を。

もしこの会話が好きなら、このエピソードをチェックしてもっと学んでください。

次の1,000日で、AIは労働力でかなりの数の人間を置き換えるだけでなく、私たちの経済の構造全体を時代遅れにするでしょう。それが今日のゲスト、Emad Mostoquiの不安な主張です。

コメント