AIアライメント・安全性

AIアライメント・安全性 なぜ法律、条約、規制ではAIから人類を救えないのか ビッグタバコの戦略家が明かす真実

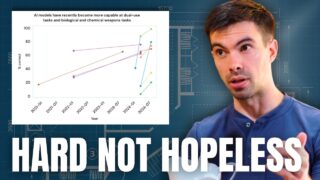

本動画は、かつてビッグタバコの規制対策を指揮したピーター・スパーバーが、AI安全コミュニティに向けて衝撃的な警告を発する内容である。スパーバーは、新しい法律や条約、規制によってAIから人類を守るという従来のアプローチが根本的に誤りであると断...

AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性  AIアライメント・安全性

AIアライメント・安全性