34,518 文字

シンギュラリティ、それはなぜAIの歴史がまだ私たちに教訓を与えるのか。サイクというプロジェクトがあります。これは私たち文明が持つすべての知識を、この種の論理構造に保存しようとしました。私が求めているのは道徳的なAIではなく、道徳的な人間だと思います。かつては哲学的な問いだったものが、今や実験科学になりました。コンピュータが発明されたのは、数学史における皮肉の一つです。あなたが言うところの黄金時代、1956年から1974年について教えてください。AIのこの最初のブームについて。

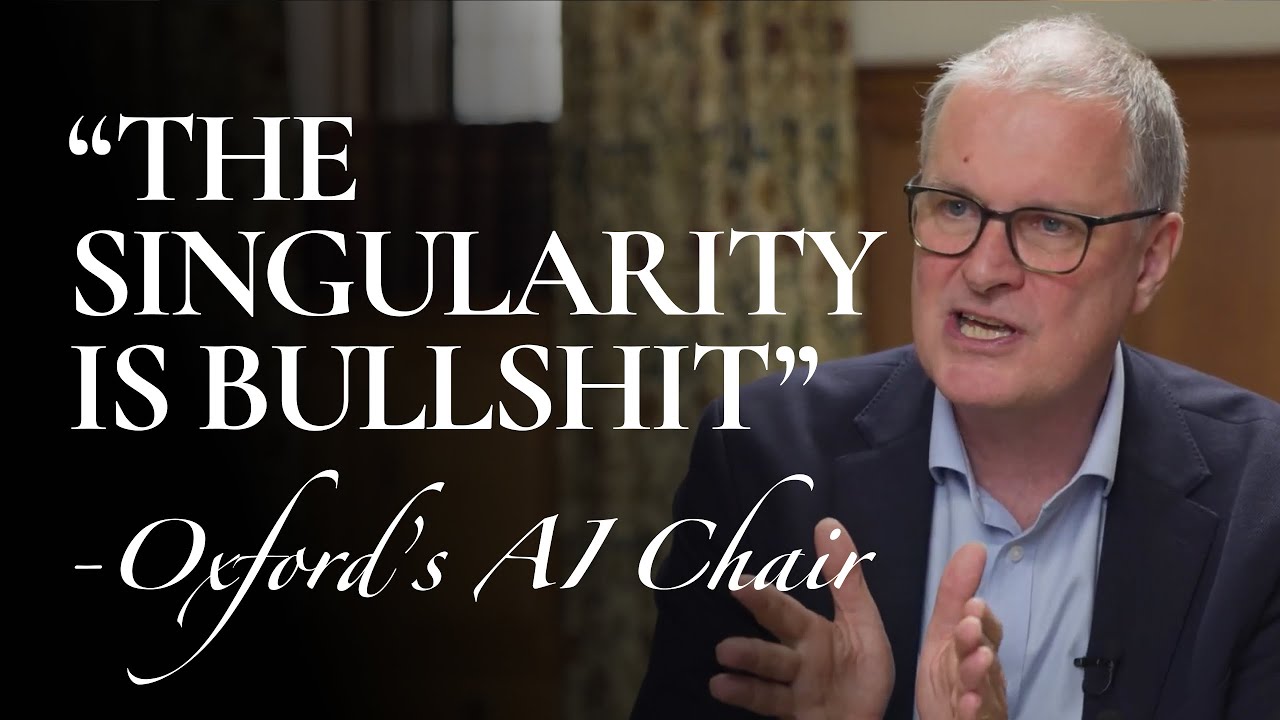

実際、AIは全く良い評判を持っていませんでした。AIは一種のホメオパシー医学のように見なされていました。ニューラルネットワークは死んだ分野と見なされていました。おお、これは本当に最先端にいるんですね。これは大きな研究課題です。オックスフォード大学のマイケル・ウールドリッジは、ベテランのAI研究者であり、エージェントベースAIの先駆者です。このインタビューでは、ウールドリッジはチューリングから現代のLLMまで、AIの100年の歴史全体を解説します。

技術の歴史を研究する理由を考えるかもしれません。技術というものは最先端のテクニックに関するものであり、最新の開発に関するものであるべきではないでしょうか。古いものや時代遅れのものを再訪する意味は何でしょうか。この歴史を研究すべき重要な理由が少なくとも2つあります。

まず、技術の未来をよりよく予測するのに役立ちます。ウールドリッジはAIのこの反復がシンギュラリティにつながるという点で非常に懐疑的です。というのも、彼は似たようなAIブームのサイクルを多く経験してきたからです。ブレークスルーがあるたびに、宗教的な熱狂者によって終末論的な予測が推し進められ、それによって不合理な期待が設定され、最終的には分野を後退させることになります。このブームと不況の歴史を研究することで、誇大宣伝を見抜き、技術が実際にどこに向かっているのかを理解するのに役立ちます。

歴史を研究する2つ目の、さらに価値のある理由は、今日のイノベーションにインスピレーションを与える可能性のある見過ごされた技術が含まれているからです。15歳からコーディングを始め、大学でCSを学び、そしてテクノロジー企業を設立した私にとっても、ウールドリッジは私が聞いたこともないAIの完全なパラダイムを明らかにしました。ウールドリッジの主張によれば、AIで選ばれなかったこれらの道、いわゆる失敗は間違っていたのではなく、単に時期尚早だったのだと言います。そのため、この100年の歴史は、現在のインスピレーションのために振り返るべきアイデアの宝庫なのです。

私の名前はジョン・ジャン・Bです。私はコスモス研究所のフェローであり、哲学とAIの交差点を研究しています。もし転写を通じてこのエピソードを追いたい場合は、リンクが説明にあります。

それでは、マイケル・ウールドリッジをご紹介します。これはあなたの本の挑発的な章のタイトルですが、「意識を持つ機械への道:シンギュラリティとは」。なぜそのようなタイトルなのでしょうか?

それは外にあるある種の物語があるからです。それは非常に人気のある、非常に説得力のある物語です。それは、ある時点で機械が人間と同じくらい知的になり、その後、知的能力を用いて自分自身をさらに賢くすることができるというものです。その物語によれば、すべてが私たちのコントロールを超えてしまい、もちろんこれはかなり多くのSF映画、特に「ターミネーター」のストーリーです。私はそれらの映画を誰よりも愛していますが、それは非常に説得力がないと思います。そして私はさまざまな理由でその物語にイライラするようになりました。その理由の一つは、AIがどこに向かっているか、そしてAIに関連するリスクは何かという真剣な議論でその物語が出てくるたびに、それは部屋の中のすべての酸素を吸い込んでしまうのです。私の同僚が言うフレーズでは、それは会話を支配し、私たちが実際に話し合うべきことから注意をそらしてしまいます。

実際、これから生まれた学問がありますが、それは存在論的リスクと呼ばれています。これはターミネーターの状況を心配し、これらの超知的エージェントを人間の利益により良く合わせるためにどうすればよいかを考えるようなものです。もし単なる物語だけでなく、実際の資金調達や最も賢い人々が何に時間を費やしているかを見れば、企業だけでなく政策グループにおいても、X-risk(存在論的リスク)が市場全体の中で支配的なシェアを持っています。

なぜこの物語がそのような大きな支持を得ているのだと思いますか?

確率は低いが、非常に非常に高いリスクという議論だと思います。つまり、ほとんどの人々はこれが非常に説得力があるとは思っていないが、もしそれが起きたら、それは最悪のことになるでしょう。非常に非常に高いリスクなので、その確率にリスクを掛け合わせると、考え始めるべきものになるという議論です。

しかし、大規模言語モデルの成功が明らかになり、ChatGPTがリリースされ、去年みんなが非常に興奮したとき、この種の議論はやや感情的なレベルに達し、少し浮ついたものになりました。私の感覚では、議論は少し落ち着き、より実際の状況とリスクに焦点を当てるようになっています。

それはかなり寛大な解釈だと思います。心理学的には、それは合理的な計算、確率は小さいが大きなコストがかかるというものです。私は宗教的な歴史を研究していますが、存在論的リスク関係者と話すとき、その心理学はキリスト教の終末論を思わせます。キリスト教の歴史全体を通じて、「今がその時だ」と言う人々がいます。最近では、おそらく千年紀を迎えた1999年ごろに起こりました。それは世界全体を方向付けるために、全体的で終末論的なものを掴もうとする心理的な衝動です。

私が強調したいのは、これらの人々が終末論的な物語に引かれる理由は、ほぼ宗教的な現象だということです。これは、世界が終わっていないとか、気候が変化していないとか、存在論的リスクがないということではありません。しかし、人々がこの物語に引かれるのは、ほぼ宗教的な現象のようなものだということです。

そう思います。それは何か原始的で人間の本性のようなものに訴えかけています。最も基本的なレベルでは、それは「あなたが何かを創造し、子供を持ち、それがあなたに反抗する」というアイデアです。それは親にとって究極の悪夢です。あなたは何かを生み出し、育て、何かを創造するというものです。

あるいは、オリジナルのSFテキスト「フランケンシュタイン」に戻ると、それはまさにフランケンシュタインのストーリーです。あなたは科学を使って生命を作り出し、何かに命を与え、何かを創造し、それからそれはあなたに反抗し、あなたはそのものをコントロールできなくなります。それは非常に共感を呼ぶアイデアであり、人々が簡単に取り付くことができるものだと思います。

私たちはここでの心理学を批判することは簡単ですが、一旦スーパーインテリジェンスや少なくとも人間レベルの機械知能を持った場合、それらが自分自身を再帰的に改善できるという議論に、人々が過剰な重要性を与えると、何が問題だと思いますか?

イライラする部分は、その議論のスカイネット部分です。「ターミネーター」のような、突然これが私たちがコントロールできない方法でコントロールを失うというものです。非常に短い期間で。これらのものがどのように機能するか、そしてAIを維持するためにどれだけ多くのパッチが必要かを見ると、それはあまり説得力がありません。

より具体的には、存在論的リスクが発生する可能性について基本的に2つの議論があります。最初は有名なペーパークリップの議論です。あなたは非常に知的な機械を作り、できるだけ多くのペーパークリップを作るように依頼します。そして、それはあなたの指示に従いますが、あなたが予想しなかった方法で、例えば人類全体を奴隷化してペーパークリップの生産に向けるなど、すべてをペーパークリップに変えるまでです。それがペーパークリップの議論です。

この議論には、AIがそのような方法で誤動作する可能性があるという意味で強みがありますが、それが私たちを傷つけるためには、私たちを傷つける権限を与えなければなりません。鍵を渡し、コントロールを与える必要があります。そして、防護柵はありません。そして、それが非常に説得力がないのはその理由です。それは私たちが行うには愚かなことでしょう。つまり、AIに核兵器を渡すというのは。

AIが存在論的脅威になる可能性についての2番目の議論は、私たちが非常に非常に知的な機械を作り、それらが私たちのものと一致していない独自の目標を開発するというものです。これははるかに漠然としています。それがどのように起こるかわかりません。そのため、少し対処するのが難しいですが、現時点では本当にその近くにはありません。そして、現在持っている非常に強力なAIでも、そこからどこに行くのかロードマップは見えません。

あなたの理解によれば、最初のケースは、AIが私たちの目標を実行しているが、人間が暗黙の価値観や前提を取り入れていないような場合であり、2番目は独自の目標を開発した場合です。そしてここでは、LLMがどれほど強力でも、エージェンシーの兆候がないため、さらに遠い話に思えます。それは根本的に必要なことです。

私と友人たちは実際、半分冗談で「存在論的リスク・リスク」という言葉を考え出しました。これは、存在論的リスクに過度に焦点を当て、現在のAIによって実際に直面する可能性のあるその他のリスクから離れている社会に対するリスクです。もし魔法の杖を振って、AIの物語をX-リスクから離すことができるなら、現在、どのような実際の問題や会話を持つべきでしょうか?

私たちは、基本的に10年、最大でも20年以内に、私たちが読む、ソーシャルメディアやインターネット上で見るものがすべて、AIによって生成され、何が本物で何が本物でないかわからない世界に向かっています。その世界では、社会が単に共通の信念の核がなくなるため、断片化するなど、多くのリスクがあります。

私たちは特定の問題に執着し、ソーシャルメディアやインターネットはAIがあなたが気にする問題を拾い上げるようにプログラムされており、それらのリスクを強調する物語を供給するため、その特定の問題の周りに私たちを駆り立てます。

私が特に懸念していたのは、米国や英国の選挙に向かう中で、AIによって生成された偽ニュースでソーシャルメディアが溢れることでした。結果として、少なくとも私が恐れていたほどの規模では見られませんでしたが、それでもリスクとして目を離すべきではないと思います。それは非常に現実的なリスクです。

独裁的な国家がメディアをコントロールし、単にAIを使って無限の偽ニュースの物語を生成したり、ポピュリスト政治家が同じことをするなど、私たちは偽ニュースに溺れ、もはや何が本物で何が本物でないかを判断する方法がわからず、結果として何も信頼できなくなるリスクがあります。

これらすべての問題を考慮して、あなたの本からの引用を読みます:「AIの開発をコントロールするための法律、おそらく核力と同じように国際条約さえ必要でしょうか?私はAIの使用を規制するための一般的な法律を導入するという考えはかなり説得力がないと思います。それは数学の使用を規制するための法律を導入しようとするようなものです。」これらのリスクを軽減するための政府や政策の役割はどうあるべきだと思いますか?

私が懸念しているのは、ニューラルネットワーク法のような素朴な試みです。「汝はニューラルネットワークを使ってはならない」というようなものです。それは説得力がないと思います。なぜなら、ニューラルネットワークは本質的には少しの数学だからです。実際には非常に複雑な数学ではありません。たくさんありますが、非常に複雑なものではありません。

そのため、それを規制する場合、どこに線を引くのでしょうか?基本的な統計学、あなたが日常的に行うようなことはAIでしょうか?ニューラルネットワークはかなりの線形代数です。線形代数を禁止しますか?

プログラムを書く時に、ニューラルネットワークを指して「これらを使うべきではない」と言って技術を規制しようとするのは、核兵器や核分裂装置を指すのとは違う意味で問題があります。核分裂装置を簡単に識別できると思います。それについてあまり議論はないと思います。あるいは化学兵器の使用など、武器での塩素ガスの使用を禁止するなど、これらのことは比較的簡単で堅牢に識別可能です。AIはそうではなく、それが実際にAIであるかどうかは非常にグレーな領域です。

私の好みは、技術の使用に焦点を当てることです。本で取り上げているのは監視技術です。もし誰かが私に監視技術を使用しているなら、それがニューラルネットワークであるか、論理プログラムであるか、キャビンに座っている人が見ているかは気にしません。私が気にするのは、誰かが私に監視技術を使用しているということです。そして、それが禁止されるべき場所です。

規制を見る際、一般的なニューラルネットワーク法を目指すのではなく、特定のセクター法、健康、防衛とセキュリティ、金融、教育など、それぞれの異なる分野でAIが提起する問題は何かを考え、その周りで法律を作ることを好みます。

これをX-リスクへの批判にも結びつけることができると思います。なぜなら、これらのニューラルネット法と呼ぶようなものの背後にある衝動や直感の多くは、「ああ、正しいコントロールを設定しなければ、それはコントロールを失い、スカイネットになるだろう」という予防的なものだからです。しかし、あなたが言っているのは、それが何ができるか、何ができないかについての期待をより穏健にすべきだということであり、それによって害も含めて、特定のユースケースで、他のテクノロジーや物理的な産業やインフラと同じように規制することができます。

そうあるべきだと思います。ここまでは、将来を見据えた視点について話してきました。インタビューの残りの部分では、あなたの本に深く潜り、AIの歴史的な見方について話したいと思います。しかし、まず、技術分野の多くの人が持つだろう質問から始めましょう。なぜAIの歴史を気にすべきなのでしょうか?

AIの歴史はまだ私たちに教えるべき教訓があるからです。そしてそれが教えてくれる大きな教訓の一つは、AIで見ているものに過度に興奮し、過大解釈することが非常に簡単だということです。そして人々は過去に複数回それをしてきました。

現在のAIの波については、本当に実質があると思います。私たちはブレークスルーの瞬間にいると思いますが、AIの道の終わりにいるとか、Transformerが魔法の成分だとは確信していません。数年前、人々は深層学習だけがAIの魔法の成分だと言っていましたが、今はTransformerアーキテクチャなどです。これらのどちらも魔法の成分だとは思いません。まだ知らない成分があると思います。

そして、真剣なAI研究者でさえAIの歴史から学ぶことがあるという点はさらに強調できます。それは単に「興奮を落ち着かせる」というネガティブなことではありません。比喩を使わせてください。哲学では、パラダイムシフトを通じて、多くの良い道徳的直感が失われるという考えがあります。

私たちはこのキリスト教的世界観から多くのことを得ますが、ローマ世界や異教的世界から離れると、忘れられてしまった、救出すべきものがあります。私の初期の訓練はSTEMでした。STEMは通常、歴史的なものを研究しません。通常は最新の物理理論だけを研究します。しかし、トーマス・クーンが最大の提唱者であるSTEMイノベーションの見方として、これらはパラダイムシフトであり、以前のパラダイムで失われた重要なものがあります。

そして、今日これを見ることになると思います。そして、真剣な技術的研究者にさえ、AIの歴史について与えるポジティブなピッチは、私たちの現在のパラダイムで見過ごされている、人工知能についてのプログラミングの方法や考え方があり、それが次のフロンティアへ進むのに必要かもしれないということです。

そうだと思います。クーンの言葉を使えば、私たちはパラダイムシフトの瞬間にいます。ChatGPT以前とChatGPT以後です。これは10年以上前から沸き立っていました。深層学習の到来は2005年頃に明らかになりました。

ここで重要な歴史的ポイントです。2005年、深層学習の到来。2012年、GPUがニューラルネットワークのトレーニングに使用できることが認識され、突然、GPUを使用することでトレーニングで10倍のパフォーマンスを得ることができました。そのため、できることを増やすことができ、事態は本当に過熱しました。

2017年にはTransformerアーキテクチャがあり、2020年にはGPT-3がありました。これらはその種の瞬間です。しかし、私たちは今、パラダイムシフトの中にいます。コンピューティングにおいて、世界は今、正確で最適なアルゴリズムをコーディングし、この問題を解決するための正しいアルゴリズムは何かと考える時代から、データを与えて機械学習に投げ入れ、機械学習に解決させる時代へとシフトしていると本当に信じています。

どのようにしているのかを正確に気にしますか?必ずしもそうではありません。単に答えを与えてくれるだけです。しかし、多くの場合、それが与えてくれる答えは、正確さと最適性の保証を犠牲にしても、信じられないほど有用なものであることが判明します。それは非常に強力なツールになります。だから、パラダイムシフトはデータ駆動の世界に向かっています。

2016年から2020年にコンピュータサイエンスの学位を取得し、AIの歴史について尋ねられたら、あなたが教えてくれたことしか答えられませんでした。しかし、あなたの本を読むと、それは少なくともさらに半世紀以上続きます。また、MLを上回る明示的なプログラミング、あなたが「象徴的AI」と呼ぶものについて、完全に見落とされた次元があります。それはMLよりも主要なパラダイムでしたが、今では私たちがAIと言えばMLを考え、そこには技術的研究者のリーダーたちにとっても救い出せるような直感があるかもしれません。

しかし、アラン・チューリングから始めましょう。彼がチューリングマシンで、コンピュータサイエンスという分野だけでなく、AIの基礎をどのように築いたのか教えてください。

アラン・チューリングは、今や歴史上最も有名な数学者の一人ですが、チューリングのストーリーには人々がまだ理解していない多くの部分があります。誰もがチューリングを知っているのは、ブレチリー・パークで行った暗号解読の仕事であり、それは連合国の勝利に非常に重要な役割を果たしました。それはハリウッド映画にもなりましたが、映画は面白いですが、正確さという点ではひどいものです。

しかし、1930年代に戻ると、彼はケンブリッジで博士課程をしており、当時の大きな数学的問題の一つであるエンツァイドゥングス問題(決定問題)に取り組んでいました。大まかに言って、決定問題が問うのは、数学を自動化できるか、数学をすべての人間の洞察を取り除き、ただ手順に従うだけのものに還元できるかということです。それは20世紀初頭の定義的な問題の一つでした。

信じられないほどの先見性をもって、チューリングはエンツァイドゥングス問題に取り組む任務を自らに課し、非常に迅速に解決しました。しかし、それを解決するために、彼は一種の数学的機械、指示に従う機械を発明しました。最初は単なる数学的抽象でしたが、第二次世界大戦中の暗号解読機でのらの作業は、彼と他の多くの人々にこのチューリングマシンを実際に構築できることを認識させました。

チューリングマシンは基本的に、いくつかの実用的な調整を加えると、現代のデジタルコンピュータです。それはすべてのコンピュータ、つまり指示に従う機械です。したがって、数学の歴史における最大の皮肉の一つは、コンピュータが副産物として発明されたことです。彼は物事をできる機械を発明しようとしていたのではなく、エンツァイドゥングス問題を解決しようとしていました。そのためにコンピュータを発明する必要がありましたが、そうしました。

戦後、彼は最初のコンピュータに取り組みます。それらの初期の、信じられないほど原始的なコンピュータは、世界全体で数台しかありませんでしたが、これらは信じられないほどの知的偉業をなし遂げることができました。膨大な量の数学を非常に速く、非常に正確に行うことができ、人間よりもはるかに速く、はるかに正確でした。そして人々は、これらの機械は知的なのではないかと考え始めました。それがAIという考えを空気中に置きました。

その時期について驚くべきことは、1950年代初めには、おそらく世界全体でコンピュータは2、3台しかなく、今日の基準で見れば信じられないほど原始的でしたが、その10年の終わりには、計画の基本や問題解決、チェスやチェッカーの適切なゲームをプレイできる機械を持つまでになりました。何もないところから、それらのことができる機械まで、10年でわずかな進歩を遂げたのです。

知的巨人がいて、彼らの二次的な考えさえも全体の分野を生み出すことがあります。例えば、ニュートンの微積分法です。チューリングマシンについて、非技術的な視聴者のために強調したいのは、それが行うことができるのは非常に基本的なことだということです。それは文字通り、明確な指示です。もしAならB、ポインタをEからZに移動するなど、非常に基本的な手順です。そして、私が非技術的な視聴者のために再度強調したいのは、これが現在のコンピュータの基盤であるということです。根本的に新しいパラダイムを設計したわけではありません。

しかし、それが魅力的なのは、再度、これらの決定論的で単純で明示的な手順から、ChatGPTのような創発的な振る舞いを得ることができることです。これが哲学者として私を興奮させるのは、大学の学部時代に、私はカント学者と議論していました。彼は「決定論的なシステムは、あなたや私ができるような常識的な推論を生み出すことはできない」と言いました。私はML授業を受けていましたが、私たちが行うような常識的な自然言語操作を生み出すために、明示的に決定論的なシステムだけを使用する方法を学んでいたことを非常に鮮明に覚えています。これは、あなたが言ったように、哲学が実験科学になっている一例に過ぎません。

その通りです。AIの問いを枠組みする一つの方法は、知性がそれらの信じられないほど単純な指示、コンピュータが従う明示的な指示に還元できるかどうかです。もしプログラミングをしたことがない場合、その単純な指示がどれほど愚かに単純かを想像するのは難しいです。これはコンピュータプログラマーが高給を得る理由です。そのレベルで考え、機械がどのように動作するかを理解するには特別な考え方が必要です。

はい、そして大規模言語モデルの最先端のAIで見るこれらの非常に目を見張るような能力が、最終的にそれらの非常に単純な指示に還元されるのは驚くべきことですが、彼らがしていることを行うには、それらの単純な指示がとてつもなく多くあります。

現代の2つの分水嶺的瞬間と今日の私たちの瞬間を比較せずにはいられません。コペルニクス革命では、「人間は宇宙で特別ではない」とされ、ダーウィン革命では、「人間は動物界で特別ではない」とされました。私たちの最後の砦、私たちが所有している最後の神聖な能力である知性がバイナリビットに還元されたように感じます。

まだ完全にそこまでは行っていないと思います。人間の本質的な性質、人間の根本的な要素の一つは、私たちが経験を持っていることだと思います。我々は世界を経験します。誰も本当に意識が何であるかを理解していませんが、大まかに言って、人々は、個人的な視点から物事を経験する能力、そしてあなたの個人的な視点がプライベートでユニークであるという点に同意しています。私はあなたが経験していることを想像できますが、それは本当にプライベートでユニークなものです。

機械からそのようなものを得られる段階にいますか?いいえ、確実にそうではありません。そして、それをどのように行うのか、あるいはそれが行う価値のあることなのかは、私にはとても不透明です。

これはチューリングについて有名なもう一つのこと、チューリングテストについて話すための完璧な導入です。彼がこのテストを考案した理由と、それがAIの発展にどのような影響を与えたかについて教えてください。

1950年代になると、最初のデジタルコンピュータ、今日認識される構造に従って動作する最初のコンピュータがあり、それらはチューリングのチューリングマシンのビジョンから生まれ、人々はこのような機械を実際に構築できることに気づきました。

1950年代初めには最初のデジタルコンピュータがあり、これはAIという用語がまだ与えられていなかったとしても、AIについての一種の公開討論を始めました。

チューリングは、コンピュータは創造性や感情などのXを決してできないと独断的に主張する人々にいらだちを感じました。また、決定的に機械は人間と同じように何かを理解することはできないと。そこで彼はチューリングテストを発明しました。

非常に有名なチューリングテストはその単純さで美しいものです。それは識別不可能性のテストです。大まかに言うと、あなたは人間の審判がテレタイプを通じて何かと対話します。彼はそう説明しましたが、コンピュータ画面を想像してください。あなたは何か、質問でも何でも入力し、その画面を通じて応答を得ます。その応答を生成している相手が人間かコンピュータプログラムかはわかりません。

チューリングテストでは、もしあなたが違いを確実に見分けることができなければ、つまりこの機械が効果的に人間として通用するなら、それについて議論するのをやめなさいと言っています。機械が行っていることと人間が行うことの間に、合理的なテストによって区別できないので、議論する意味はありません。

チューリングテストには哲学的に2つの解釈があります。一つの方法は形而上学を現象学に還元することであり、これは「何かを理解しているのか、本当に考えているのか」という形而上学的な問いは、「出力を区別できるか」という現象学的・経験的な問いに完全に折りたたむことができると言うことです。

あるいは、それは認識論的なポイントを提起しているのかもしれません。つまり、形而上学的な問いは実際には重要ではなく、経験的な問いに焦点を当てるべきだと言っているのかもしれません。どの解釈だと思いますか?

どの解釈かは明確ではありませんが、私は前者だと思います。彼はおそらくこの点を越えた後は議論する意味がないと考えていたのではないでしょうか。

その前提に同意しますか?確かに同意しませんよね?これが私に思い出させるのは、実際、行動主義者、心理学学派です。行動主義者は、最も寛大な解釈でも、人間についてのすべてが、外部環境との行動や相互作用を通じて知られると考えています。

最も寛大でない解釈では、彼らは文字通り、心は存在しない、意識は実際には存在しないと言っているようなパッセージがあります。それが妥当であるためには、どういう意味なのかさえわかりません。しかし、これはチューリングがここで犯している誤りのように思えます。

しかし、これが私たちに説明しているのは、チューリングテスト、美しいものではありますが、人間の知性のためのテストとしてはそれほど興味深いものではないということです。チューリングは議論にイライラしていて、「それが区別がつかないことを行っているだけならば、なぜその時点で議論しているのか」と言ったのだと思います。純粋に実用的な意味では、それが人間が理解しているのと同じ方法で本当に理解しているかどうかは、その時点では関係ありません。

強いAIと弱いAIの区別があります。強いAIのアイデアは、私たちが目指しているもの、または持っているものは、人間や動物と同じ方法で本当に理解し経験する機械だということです。弱いバージョンのAIは、それらは本当に理解していないが、それらのことをシミュレートすることができると言います。

私は強いAIにあまり興味がありません。ただ、同僚との会話で数杯のグラスの後には興味があるかもしれませんが、強いAIに本当に興味を持っているAI研究者はあまり知りません。AIの目標はもっと実用的です。

ちなみに、実用的な目的としては、ここ数年でチューリングテストをパスしたと思います。しかし、それが説明するのは、知性の本当のテストとしてのチューリングテストの限られた価値だと思います。

私にとって、コンピューティングマシンの意識が持つ、または持たない唯一の本当の懸念は、それらを道徳的エージェントとして扱うべきかどうかです。機械が苦しんでいると思う場合、それを消したくないと思っているなら、それに何らかの重みを与えなければならないかもしれませんが、それが強いか弱いかに興味を持つ唯一の可能性のある理由のようです。

はい、人々の中には単にそれが興味深いことだと思う人もいます。AIを道徳的エージェントとするアイデアは心配です。AIに一種の倫理的・道徳的推論を装備しようとする一連の研究があります。人々がそれをしたい理由はわかります。つまり、私たちが望むような選択をする機械を持つためです。

私が心配しているのは、それによって人々が自分の道徳的・倫理的責任を放棄しようとすることです。「私のせいではなかった、機械のせいだった」と。しかし、人間に責任を問うことができるように、その行動に責任を持つように機械に要求することはできません。

特に軍事分野で非常に懸念しているのは、「私ではなかった、AIが標的を選び、そのミサイルを発射した、それは全く私たちの責任ではなかった」と聞くことです。だから、私が望むのは道徳的AIではなく、道徳的な人間だと思います。AIを構築し展開する人々が責任と倫理的考慮があるべき場所であり、彼らが展開する機械の行動に責任を持つべき人々です。

それがチューリングであり、それは人工知能だけでなく、コンピュータサイエンス全体の分野の始まりです。実装の実際の歴史に移りたいと思います。あなたの本からの引用から始めましょう:「歴史的にAIはこの問題に対して主に2つのアプローチのいずれかを採用してきました。大まかに言えば、最初の可能性は心をモデル化しようとすることを含み、もう一つの可能性は脳をモデル化することです。」

心をモデル化することは、私たちが象徴的AIとして話してきたことです。つまり、何をすべきかの明示的な指示を与え、私たちが頭の中で理性的に、意識的に行うプロセスをモデル化することです。脳をモデル化することはマシンラーニング、ニューラルネットワークであり、実際に何が起こっているかについてそれほど洞察がなくても、脳の物理的構造をモデル化することです。

まず象徴的AIについて話しましょう。最初に心をモデル化することについて話しましょう。あなたが説明する黄金時代、1956年から1974年についてAIの最初のブームについて教えてください。

1950年代の終わりまでに、知性の萌芽を示すことができる機械がありました。計画を立てることができ、数学を行うことができました。率直に言って、それは一般的な人々の典型的なレベルを超えるものでした。ここオックスフォードでゴールドバッハの予想とは何かを教えてくれる人を見つけるチャンスは限られているでしょう。

数学ができ、問題を解決し、ゲームをプレイできる機械があり、非常に速く一般的な知能のようなものに向かって進歩するだろうという本当の興奮がありました。それが黄金時代と呼ばれる理由です。何もないところから、それらのことができる機械まで進歩しました。

AIの博士課程の学生のモードオペランディは、人間に知性を必要とするタスクを考え、それを行う機械を構築することでした。そして、それらのことの原始的なバージョンを行うことは、それほど難しくないことがわかりました。

しかし、それによって、進歩は迅速になるだろうという大きな楽観主義がありました。人々は数十年以内に、AIの終わりに達し、完全な一般的な知能AIを持つようになると考えていました。AIハイプは新しい現象ではないのです。

1970年代初期までに、進歩が停滞していることが明らかになりました。進歩が停滞した理由はたくさんあります。その一つは、人々が実際の問題ではなく、問題の人工的なバージョンを見ていたことです。つまり、彼らはロボティクスの問題のような実世界の問題を見て、その問題の単純化されたシミュレーションをコンピュータで作成しました。彼らはその単純なシミュレーションバージョンで解決することができましたが、そのシミュレーションされたバージョンは実世界の問題にあった問題に対処しませんでした。

古典的にロボティクスでは、倉庫内のロボットのシミュレーションを行い、画面を見ると、パッケージを運んでいるシミュレーションされたロボットが見えました。それは非常に説得力があるように見えました。「素晴らしい、実世界でシステムを見せてください」という感じでした。しかし、実世界の倉庫でパッケージを運ぶロボットは、シミュレーションされたバージョンとはまったく異なります。それらのシミュレーションされたバージョンはマイクロワールドと呼ばれ、再び、博士課程の学生の標準的なモードオペランディは、特定の問題のためのマイクロワールドを考案し、そのマイクロワールドで解決できるプログラムを構築することを示すことでした。しかし実際には、実世界の実際の問題について困難なことをすべて抽象化してしまっており、研究資金提供者は「これを実際の倉庫で見せてください」と言うでしょうが、彼らはできませんでした。

黄金時代のこの期間の一般的な哲学と戦略を、「分割して征服する」と表現しました。これは、私たちの心的能力と考えるものを分割し、それを満たすために異なるバリエーションの検索アルゴリズムを構築しようとすることです。一例として、円柱を積み重ねて正しい形にするハノイの塔があります。また、旅行セールスマン問題もあります。都市のリストが与えられ、最適なアルゴリズムを見つけようとするものです。これらは人々が取り組んでいた問題のタイプです。

これらの問題全体に人々がぶつかっていた共通の制限がありました。それはNP完全性に関連していました。非技術的な視聴者に、これが大体何を意味するのか説明してもらえますか?

初期のAIへの多くのアプローチには、検索と呼ばれるものが含まれていました。検索とは、特定の問題が与えられた場合に、すべての可能な候補解を調べることを意味します。旅行セールスマン問題では、特定の地図が与えられ、セールスマンはその地図上の多くの都市を訪問し、ベースに戻る必要があります。セールスマンは一定の燃料予算でそれを行うことができるか、それが旅行セールスマン問題です。

それに対するアプローチの一つは、すべての可能な候補解を検討することです。問題は、その場合の候補解の数が天文学的に増加することです。例えば、70の都市がある場合、可能な候補解の数は宇宙の原子の数よりも多くなります。それらの候補解をすべて網羅的に検討することができるコンピュータを持つことは決してないでしょう。

初期の日々では、何らかの方法でこの問題を修正できると仮定されていました。それは組み合わせ爆発と呼ばれていますが、何らかの技術を見つけてそれを行うことができると思われていました。1970年代初めまでに、計算複杂性と呼ばれる理論が現れていました。これは特定のタスクの本質的な複雜性を理解することに関するものです。

旅行セールスマン問題に関しては、それはNP完全と呼ばれる計算問題のクラスに属します。大まかに言えば、それを行うための効率的な方法がないという意味です。一つを見つけるためにすべての候補解を見ることよりも効率的な方法はありません。これは実際には、その種の問題で解決しようとすると、大きな障壁があることを意味します。

しかし、実際にはAIのあらゆる場所で見た問題の多くがNP完全であることが分かり始めました。コンピュータビジョンの問題はNP完全であり、推論や問題解決の無数の問題もNP完全、あるいはそれ以上に難しいものでした。複雜性クラスと呼ばれる複雜性の大きな階層があり、NP完全問題よりも難しい問題や、さらにそれよりも難しい問題などがあります。

私たちが見るところでは、AIでこれらの問題に遭遇していました。そして壁にぶつかりました。その壁は組み合わせ爆発の障壁でした。これらすべての問題は同じ特徴を持っています。原則として、正しいもの、機能するものを見つけるために、すべての候補解を調べることで解決できますが、実際にはそれを行うことは不可能です。

1970年代半ばまでに、誇大宣伝だけでなく、AIフィールドが直面していた一連の技術的問題により、AIはその最初の、しかし確かに唯一ではない冬に入りました。これは資金が枯渇し、関心が薄れ、AIフィールドの人々が時には詐欺師として描かれ、公衆はAIの主張に非常に疑惑を持つようになったことを意味します。

あなた自身、これらの冬、ブームとバストのサイクルを多く経験してきました。実際にAIに真剣な人々が集まるので、冬の方が良いのでしょうか?

私がAIを研究してきた大部分の時間は、比較的静かな存在でした。その良いところは、自分のことに取り組み、同じ分野で働いている人は少なく、研究者としては実際にそれはかなり爽快なことでした。研究者として自分だけの大きなスペースを持つことは、実際に非常に爽快なことです。その領域を探索することができます。

フィールドが人気になると、大量の人々がそれに殺到することがわかりました。その良いところは、大量の非常に才能豊かな人々がいることですが、研究者としては、もはや自分の問題を見ている唯一の人ではないことに気づきます。あなたは正確に同じ問題に取り組んでいる非常に有能な人々に囲まれており、AIの研究を行うことの性格がかなり変わりました。

あなたはケーキの唯一の人ではなく、同じ場所で一緒に削っている多くの人々がいます。しかし、科学においてAIは実際には良い評判を全く持っていなかった20年前に戻ることを覚えておく必要があります。AIはホメオパシー医学のように見なされ、ニューラルネットワークは行き詰まりと見なされていました。同僚が「なぜAIに取り組んでいるのか?これはあなたのキャリアに良くないでしょう」と言うのを覚えています。これがどれだけ変わったかは驚くべきことです。

80年代に私たちは最初のAI冬から抜け出し、AIの新しい波、新しいパラダイムはエキスパートシステムと呼ばれていました。この第二波のAIの哲学が黄金時代とどのように異なっていたのか教えてください。

第二波AIの大きなアイデアは、知性は主に知識の問題であるということです。そのため、あなたのために何かを行うマシンを構築したい場合、フランス語から英語に翻訳したり、チェスをプレイしたりなど、鍵となる問題は、人間がそのタスクを行うときに使用する知識を把握し、その知識をマシンに与えることです。それが大きなアイデアでした。知識、知識が知性への鍵です。AIは主に機械に正しい知識を与える問題です。

ルールベースのシステムと呼ばれる技術が登場し、それにより特定の問題に関する知識を機械に与えることが可能になりました。古典的な例はMYCINシステムであり、これは人間の血液病を診断する専門家でした。MYCINの開発方法は、開発者が人間の専門家、血液病の専門家である医師と話し、「血液病の原因を診断するためにどのようにアプローチするか」と尋ねました。彼らは「最初にすることは誰かの体温を測定し、体温がこの範囲を超えている場合、このテストを行います」などと言いました。

人間がその問題をどのように解決するかについての知識は、ルールと呼ばれる離散的なチャンクの形でコード化されました。「人間の体温がこれ以上で、特定の血液検査が陰性の場合、彼らはラッサ熱を0.7の確率で持っている」というようなルールです。これらすべてのルールがコード化され、機械に与えられ、その後機械と対話します。機械は「患者は体温がありますか?このテストを行いましたか?このテストの結果は何ですか?」などの質問をし、最終的には「あなたの患者はラッサ熱を持っていると思います」などと教えてくれます。

しかし、新しいシステムが開発されただけでなく、私自身がCSの学生として、以前には聞いたことのなかったプログラミングの新しいパラダイムについて非常に驚きました。現在、学校で教えられるタイプは2つあります。宣言型は、機械に何を望むかを指定するものです。SQL、多くのデータベース言語などです。「2024年からの緑のりんごをすべて表示して」などです。そして命令型言語があります。これはJava、C++などであり、これはマシンに「もしこれならこれをしなさい」と伝えるものです。ビデオゲームなどはこれで作られています。

あなたの本で学んだばかりの別のパラダイムは、論理パラダイムと呼ばれるものです。引用させてください:「デビッド・ウォレンによって1974年に書かれたWARPLAN計画システムは、ブロックスワールドを含む計画問題を解決することができました。これはシミュレーションされた工場の検索問題で、黄金時代で説明したものですが、それはプロログコードわずか100行を必要としました。同じシステムをPythonのような言語で書くと、おそらく数千行のコードと数ヶ月の労力が必要でしょう。」

論理プログラミングの誘惑は、基本的な真理を与えれば、論理的演繹が優雅にすべてを解決できるということです。

それは多くのAI研究者を魅了した美しいアイデアです。論理プログラミングのアイデアは、象徴的AIと知識ベースのAIをさらに一歩進めて、機械に知識を与えたい場合、その知識を論理の形で表現することだと言います。

これらの世界の論理的な記述を与え、これは基本的にアリストテレスですね?「ソクラテスが人間であり、すべての人間は死すべきものなら、ソクラテスは死すべきものである」、これはアリストテレスの論理101です。

その通りです。しかし、血液病の診断や計画問題の解決など、特定の問題に関するすべての知識を与え、それを論理的な形で表現し、組み込まれた論理的推論者が詳細を解決してくれます。彼らは論理的推論を行います。

そこでのアイデアは、論理ベースのAIでは、知性は主に演繹、論理的推論の問題であると考えられていました。それは美しく優雅なアイデアで、あなたが言うWARPLANプログラムは15行のコードで、それは信じられないほど短いプログラムです。

問題は、それが最初にそれほど効率的ではないことです。多くの問題では望み薄弱なことがわかりました。また、例えばロボティクスをやりたい場合、プロログはロボティクスに必要な言語ではないことがわかりました。それは完全に不適切です。

しかし、ChatGPTが晒されてきたすべての知識を手動で論理的表現の形で表現し、それを与えるのは想像できないでしょう。それは機能しません。

それでもMYCINというプロジェクトがあり、これは特定の医師と病院に非常に限定されていました。そのアイデアは再び、世界について知られているすべての第一原理、主要な事実を論理的演繹に投入するというものでした。「ソクラテスが人間なら、ソクラテスは死すべきものである」という具合に。

サイク(Cyc)という別のプロジェクトがあり、これは私たちが文明として持っているすべての知識をこの種の論理構造に保存しようとしました。

サイクプロジェクトはAIの歴史の中で少し混合した位置を占めています。このビジョンはダグ・レナートのビジョンでした。彼は70年代初めの彼の仕事で人々を本当に魅了した非常に素晴らしい研究者でした。そして彼は、AIの本当に大きな問題、人間と同様に完全に能力を持つ機械を構築する問題は単に知識の問題であると確信するようになりました。彼は「これには近道はない、ただ機械にこのすべての知識を与えなければならない」と言いました。

彼はいくつかの資金提供者を説得して彼の仕事をサポートさせ、ある時点では倉庫がいっぱいの人々が、これらのルールの形式ですべての人間の知識をコード化することに忙しくしていました。「もしこれとこれとこれならこれ」という具合に、最終的にこれが人間と同様に能力を持つだろうというアイデアでした。

レナートは彼のプロジェクトについて非常に楽観的でした。90年代初めにこれを読んだとき、彼は「数年以内に、サイクは賢くなり、自分自身のルールを書くことができるようになり、私たちはそれをする必要がなくなります。ただ教科書を与えるだけです」と言いました。

サイクの物語の幸せな部分は、検索エンジンで使用される知識グラフや、多くの検索の裏側で使用されているものは、これらの非常に大きな知識ベースと呼ばれるものに知的歴史をたどることができます。

しかし、サイクは当時、単に途方もなく野心的であることとして嘲笑されていました。それは想定されていたスケールでは何も提供せず、いくつかのアプリケーションを見つけましたが、比較的ニッチなアプリケーションであり、レナートが望んでいたスケールでは何も提供しませんでした。それで、それはしばしば嘲笑され、象徴的AIについて何がすべて間違っていたかを要約した一つのプロジェクトとして取り上げられていました。

あなたの本から私が思う最も面白い引用を紹介します:「AIの歴史におけるサイクの主な役割は、非常に公的に予測された大きな予測に応えることができなかったAIハイプの極端な例です。サイクの創設者ダグ・レナットのAIにおける役割はコンピューティングの民話の一部として神話化されており、ミクロレナットという冗談があります。これは何かがどれほど偽物であるかを測定する科学的単位です。なぜミクロレナットなのか?それは全体のレナットほど偽物であるものは何もないからです。」

これは、あなたがAIの歴史を研究する重要性について言おうとしていたことだと思います。適切な視点を得るために。新しいパラダイムごとに、「検索を使用してすべてを解決するのに非常に近い」という黄金時代、エキスパートシステムでは「サイクは基本的に再帰的に自分自身のルールを書くことができるだろう」など。

しかし、戻ってみると、印刷機のような技術でも、人々はすぐに百科事典を書きたがりました。世界中のすべての知識を捉えるという、この衝動が今日のAIに見られます。

レナートとサイクに戻ると、その引用は少し残酷だと思います。ジョークは少し残酷な引用ですが、真実は、当時で非現実的だった、そして実現されなかったただ誇張された主張がなければ、AIの歴史においてずっと幸せな場所を持っていただろうということです。もう少し測定された目標を持っていれば、大規模な知識ベースの開発の演習としてはるかに良く評価されていたでしょう。Googleの検索などの背後にある知識グラフのDNAには、サイクの少しがあったと言っています。それは何の役にも立たなかったわけではありませんが、「それは自分自身のルールを読み書きし始める」などの過度に誇張された主張がありました。

しかし、大規模言語モデルの訓練方法には驚くべき類似点があると思います。つまり、私たちはそれらを手に入れることができるすべてのデジタルデータにさらすだけです。違いは、サイクの場合、人間がそのすべてを解釈して、コンピュータ言語でルールを書き込んでいたことです。大規模言語モデルでは、そのようなことは一切行われません。それはただモデルに提示され、ある意味で(ここでは大きく手を振っていますが)それはその中に秩序を見出します。そして、それがどのようにしているのか、私たちは実際には本当に理解していません。

黄金時代の検索、80年代後半のエキスパートシステムについて話しました。これらのエキスパートシステムの過度の誇張に対する反応として、ロドニー・ブルックスは「行動AI」と呼ばれる新しいパラダイムを始めました。そのいくつかの哲学は、彼が設立したiRobot社の背後にあります。このパラダイムにおける哲学について教えてください。

ブルックスは、AIが1950年代から30年間にわたって取り組んできた基本原則に疑問を呈しました。これらの原則とは、知性は象徴的推論のプロセスを通じて解決できること、問題を解決するために必要な知識を機械に与えることが知性の主要な要素であるということでした。

ブルックスは「それが人間に知性がどのように機能するかとは思わない」と言い、代わりの理論、この種の行動理論を提案しました。大まかに言えば、彼が言ったのは、私たちは相反する行動の集まりであり、そのいくつかは進化のプロセスを通じて遺伝的にハードワイヤされ、いくつかは生涯を通じて学習しますが、私たちはただこれらの行動の集まりであり、何らかの形で人間の知性はこれらの行動の相互作用から生じるということです。

そこで彼は「これらの行動を層ごとに構築していこう」と言いました。また、彼は非体現化システムにおいて知性が表現されるという考えにも非常に不満を持っていました。彼は「それは本当の知性ではない。人間の知性は世界の中のものであり、私たちは世界で物事を行う」と言いました。彼は世界と対処できないAIのどのバージョンも深く批判していました。彼はロボット工学者で、物事を行うロボット工学を構築したいと考えていました。

彼はこれを行うためのアーキテクチャ、フレームワークを構築しました。最も基本的な行動、想像できる最も基本的な行動から始め、ロボット工学ではロボット工学のコースの初日に学ぶ最も基本的な行動は有名に障害物回避です。ロボットが物にぶつかるのは高価であり、訴訟などのリスクがあるからです。

最初の層は障害物回避から始め、ごみを拾い集めるためにこの部屋を回るロボットを想像してください。行動における次のレベルは探索かもしれません。部屋を探索してごみを見つけようとすることです。行動の次のレベルは、ごみを見たら拾うことかもしれません。徐々に層を重ね、それらの行動がどのように相互作用するか、何が何に優先するかを考える必要があります。

例えば障害物回避は通常、すべてに優先します。破壊か生存かの問題であれば、常に生存を選びたいものです。本当に素晴らしいことは、彼は実世界でかなり印象的なタスクを実行できるロボットを構築することができたということです。

それは知性に向かっての方法として、象徴的AIで人々が遭遇したものと精神的には似ていない問題にぶつかりました。組み合わせ爆発的に、比較的少数の行動の後、それらの行動を組織し、それらの行動がどのように相互作用するかを考えることが非常に難しくなります。そのため、ある時点で限界に達しました。90年代半ばまでには。

しかしブルックスは成功したロボットシステムを構築することができました。有名なルンバロボットは彼のアイデアのバージョンを使用して構築されています。そして、これが彼が話しているアイデアのすべての最良の例だと思います。

掃除ロボットは基本的にあなたの家を回ります。それらは体現化され、ロボットであり、単なるソフトウェアではありませんが、重要なことは、ロボットの背後にあるプログラミングを見ると、それはトップダウンの検索や全体のスペースを通過するようなものではなく、障害物があれば一定の角度でランダムに回転し、スペースをマッピングするようなものです。それは非常に反応的です。

哲学的には、最初の2つのパラダイム、黄金時代とエキスパートシステムとの有用な対比は、それらがある種のトップダウン、体系的なものであるということです。「一つの検索があり、すべての組み合わせの可能性を検索する」とか「すべての人間の知識を一つのものに符号化する」というようなものです。そして行動的なものはその反対です。それはもし特定の状況に遭遇したらこれをしなさいというような、非常に反応的なものです。ほとんどルックアップテーブルのようなものです。

当時、人々は行動心理学の理論との類似点を指摘しました。スキナーは犬などの実験と訓練をすべて行い、刺激と報酬と罰を与えることで行いました。そして、行動心理学は一般的な理論として当時かなり信用を失っていました。人間の行動の一般的な理論として大部分で信用を失っていました。そして人々はそれらの批判を指摘し、それらの批判をブルックスの行動AIに向けました。

しかし、AIとは何か、そして私たちの基本的な指導原則は何かに本当に戻って考えようとした比較的少ないと試みの一つだったと思います。象徴的AIがあり、行動AIがあり、機械学習と深層学習の新しいAIがあり、それはある種のデータ駆動型AIです。

象徴的な世界において、話したい最後のパラダイムは90年代初頭のエージェントベースAIです。私の理解では、これはエキスパートシステムと黄金時代の直感を、目標指向であり、機械がプロアクティブであるべきだという組み合わせを試みたものです。これに行動AIの反応に加えて、エージェンシーが社会的な性質を持つという第三のアイデアも組み合わせています。このエージェントベースについてもう少し教えてください。

私たちは私のホームグラウンドにいます。これは基本的に私の全キャリアを通じて取り組んできたことです。これを考える一つの方法は、コンピュータソフトウェアとの関係を変えることです。マイクロソフトワードでは、すべてが起こるのはあなたがそれを起こさせるからです。メニューから何かを選択したり、アイコンをクリックしたりします。しかし、その相互作用に唯一のエージェントがいて、それはあなたです。あなたはただ機械に非常に詳細な低レベルの指示を与えているだけです。ある程度プログラミングしているのと同じようなものです。

80年代の終わりから90年代の初めにかけて登場し、私が取り組んだアイデアは、ソフトウェアがあなたの代わりに行動するエージェントになり、あなたが設定したタスクであなたと協力し、一緒に働くように、ソフトウェアとの関係を変えることでした。それは単なる指示の受け手ではなく、あなたと、そして潜在的に他のエージェントと一緒に働いている積極的な参加者になります。

別の言い方をすれば、エージェントの夢の表れとして最も明らかに見られるのは、Siri、Alexa、Cortanaです。それらは文字通り、そのアイデアの直接の子孫です。実際、Siriは90年代に同じコミュニティで働いていた知人のエージェントに関する研究から生まれました。

Siriのアイデアは、それが単に何をすべきかを言われるのではなく、問題に取り組むために私たちと積極的に協力するというものです。しかし、それは他のSiriとの相互作用を含むかもしれません。もしあなたとの会議をアレンジしたいとき、なぜあなたに電話するのでしょうか?なぜ私のSiriがあなたに電話するのでしょうか?私のSiriが直接あなたのSiriと話せばいいのではないでしょうか?それがマルチエージェントシステムと呼ばれるものであり、それが過去35年間の私の仕事のほとんどを駆動してきたものです。

エージェントパラダイムについて私が魅力的だと思ったのは、それがほとんど不可知論的であり、象徴的に心をモデル化することと脳をモデル化することを横断しているということです。それがどのようにプロアクティブであるか、反応的であるか、あるいは他のエージェントとどのように相互作用するかは、あなたが考えている質問の種類から抽象化されています。

マルチエージェントシステムは、基礎モデルの現在のパラダイムに何を提供していますか?

おお、我々は本当に最先端にいます。これは大きな研究課題です。大規模言語モデルがあり、それらは一種の完全な一般的な知性ではありませんが、それでも非常に能力があります。それらを私たちのエージェントにどのように実際に展開するのか?それらは自然言語の部分、会話の部分だけを扱うのか、あるいは問題解決や同様のことを行うためにそれらを活用できるのか?

すでに「大規模言語モデルは問題を解決できるか」というアイデアについて話しましたが、私は現時点ではそれができる程度についてやや懐疑的です。しかし、この技術を最も良い方法で活用する方法は、まさに現在の研究の最先端です。それは人々が今まさに考えていることです。

エージェントパラダイム、特にこのマルチエージェントパラダイムに何があなたを引き付けたのですか?

1980年代の学部生として、私はAIに魅了されていましたが、コンピュータネットワークにも魅了されるようになりました。当時、コンピュータネットワークは一般的ではなかったことを覚えておく必要があります。インターネットの前身であるARPANET(米国の高等研究計画局によって開発された、本質的に軍事研究資金提供機関)は、英国ではわずかなノードが接続された非常に不完全な国際ネットワークを持っていました。

しかし、私はJanet(Joint Academic Network)と呼ばれる英国のその拡張に取り組む機会を得ました。そして私は啓示の瞬間を持ちました。その時点で、これが未来になるだろう、ネットワークは単にどこにでもあるだろう、誰もがコンピュータネットワークを使うようになるだろうと気づきました。あなたが電話やそれに似たものを通じてネットワークに接続し、これがどこにでもあるようになるだろうということは明らかでした。

そこで、頭の中にこれら2つのアイデアがありました。AIに本当に興味があり、ネットワークが未来になることを知っていました。これは明らかです。これが未来になるでしょう。これらを一緒に置いて、AIのネットワーク、互いに話すAIについて考えてください。それが私が興味を持った方法です。文字通り、それが私が興味を持った方法です。2つのAIシステムが通信できる場合、どうなるのか?彼らはどのように通信するのか?言語は何か?彼らが使用するプロトコルのルールは何か?それが私の興味を起こしたものです。

ちなみに、ネットワークが未来になることに気づいた後、ワールドワイドウェブやAmazonなどを完全に予想することができませんでした。人生の中で、変革的な仕事をするために逃した機会を見ています。ネットワークが未来になることは完全に理解しましたが、それでもその未来がどのようなものになるかを正確に理解していませんでした。

あなたは私たちがマルチエージェントに直接行くことを期待していたようです。私にはAIが私の代わりに交渉しているようなものです。一方、私たちはまずこのマルチ、ほぼ象徴的なフェーズを経ました。Amazonとは何か、Googleとは何か、それは大きな高度な検索アルゴリズム以外の何ものでもありません。しかし、今、私たちは私が自分の代わりに行動するための自分自身のAIエージェントを持つという意味で、マルチエージェントの世界に向かっているとお思いですか?それによって、この初期のインターネットの多くが時代遅れになりますか?

一方または他方で必然的だと思います。計算の歴史が教えることをすべて考えると、これは確かにそうであるべきです。AIの未来が単に一つの大きな孤立したシステムではなく、互いに相互作用する複数のAIシステムであることを、計算の歴史から学ぶすべての教訓が示しています。なぜなら、それが計算の歴史がどのように進んできたかだからです。だから私は絶対にそれを信じています。問題は、それがどのように見えるかを正確に知らないということです。それが私が今解明しようとしていることです。それが私の現在の研究が解明しようとしていることです。

マルチエージェントシステムが現在展開されている別の方法があります。複数のLLMが互いに話すのではなく、一つのLLM内で仕事をどのように分割するかです。大まかな直感は、おそらく実際に3つの隠れたLLMをトレーニングする方が良いということです。一つは数学が得意、一つは直感が得意、一つは創造性や言語が得意で、そして異なるLLMに異なるタスクを与える仕事処理ユニットがあります。それもまた一種のマルチエージェント作業です。

その通りです。そして、それらはまさにそのような建築的な質問です。LLMはどのように適合するのか、そのアーキテクチャはどのようなものか、これもまた最先端にあり、現在これらの質問を見ている人々がいます。そしてすべてのことを組織する正しい方法を解明しようとしています。

フィールドの中で現在最大の質問は何ですか?

AIコミュニティの非常に多くの人々が取り組んでいるのは、大規模言語モデルの能力を把握し、これらのモデルが確実に何ができるか、何ができないか、そして実際に持っている能力と実際には持っていない能力を正確にマッピングしようとすることです。

これが本当に難しいと判明した理由の一つは、それらが本質的に世界中のすべてのデジタルコンテンツにさらされているため、彼らが本当に根本的に見たことがないと確信できるものを思いつくのが難しいということです。しかし、これは科学の本当にエキサイティングな領域の一つです。私が思うに、現在の科学の最も重要な領域の一つです。そして、それはこのこと、AIが以前はなかった方法で実験科学になったことに戻ります。これはその一部です。これらの能力をマッピングしようとすることです。

また、これらのモデルが率直に少し奇妙な振る舞いをするのでこれは非常にイライラします。ある日、何らかの原則やルールがあると思い、次の日、あなたにとっては無害に思えるような方法でプロンプトを少し変えただけで、全く異なる答えが得られます。「そこで何が起こったのか?どのように、なぜそれが変わったのか?」という感じですが、それをマッピングすることは今本当に非常に魅力的です。

会話の最後の部分に移りたいと思います。私たちは時間のほとんどを象徴的なAI側の歴史について話すことに費やしました。なぜなら、それはほとんど忘れられた歴史だと感じているからです。AIと言えば、MLを考え、象徴的で明示的なプログラミング側は考えないからです。

この歴史を視聴者のためにたどり、まとめたいと思います。私にとって魅力的だったのは、AIの人々はAIとMLを関連付けることはなかったということで、あなたの本からわかるように、機械学習は40年代に別の分野として成長しました。この考えは、電気ニューロンを持つ脳構造を計算で再現できるかというものです。そして、大きなマイルストーンは1980年代のコネクショニズムで、これは逆伝播、基本的にこれらのネットワークをトレーニングするためにより多くの層を追加する方法を見つけました。2000年代にはディープラーニング、さらに多くのレイヤーとスケール、そして最終的に2020年代のTransformerと基礎モデルへと進みました。

この全歴史が今、モーが完全に一周するのを見るのが非常に詩的だと思います。機能しなかったのは、合理的に明示的にコンピュータに何をすべきかを伝えようとすることでした。今機能しているのは、人間の脳の生物学的構造を模倣することです。

ニューラルネットワークの運命の変化は実に驚くべきことです。25年前は本当に一種のホメオパシー医療のように見なされ、ある意味では非常に真剣に受け取られていませんでした。部分的には、大規模なニューラルネットワークを構築するために必要なスケールによるものでした。25年前には、2000億または5000億のパラメータを持つニューラルネットワークを処理できるコンピュータを持つことは信じられないことでした。しかし、それは今利用できるコンピュータの力によって可能になりました。そしてこれらのシステムが信じられないほど能力を持つことがわかりました。だから本当に驚くべき物語です。

本の中である時点で、「もし科学が無知から真実への秩序ある進歩についてだと思うなら、それは絶対にそうではない。それは混乱し、誤った回転、ほとんど一種のイデオロギー的な十字軍」と言っています。それは本当にイデオロギーであり、宗教的なものです。これはエクスリスクの人々の終末論的な心理に完全に戻ります。

この新世代の基礎モデルについて話したいと思います。あなたの本からの引用から始めます:「大規模言語モデル(GPT-3が最もよく知られているかもしれない)は、現在の基礎モデルの最も顕著な例です。基礎モデルは特定のタスクで印象的な能力を示していますが、本質的に非体現化されているため、人工知能の道の終わりではありません。」

過去3年間で、ディープラーニングから現在のメが持つものへのジャンプは、Transformerアーキテクチャとスケールを増加させ、多くのデータを使用することです。アーキテクチャはすでにTransformerで解決され、AGIに行くために必要なのはより多くのスケールだけだと考える人もいます。その議論の何が間違っていると思いますか?

まず、最初に言わせてください。過去数年間に見てきたことは、Transformerアーキテクチャに関するものです。これは2017年にGoogleのラボによってリリースされたと思います。それらはトークン予測のためのアーキテクチャであり、大規模言語モデルを可能にするために開発されました。プロンプトを与え、次に何が来るべきかを予測できるようにするためです。「ウィンストン・チャーチルの生涯と業績」や「私たちがいるクライストチャーチ・カレッジの歴史」などです。

それらはTransformerアーキテクチャと、想像を絶するほどの計算力と本当に驚くべき量のデータを投げる意欲を組み合わせると、非常に驚くべきものになることがわかりました。正直に言って、どれほど良かったかに驚かなかったと言うAI研究者は少し誤解を招いていると思います。それらは本当に驚くべきものです。それらは私を驚かせました。それらがどれだけ良いか期待していませんでした。

しかし、1分だけ考えてみてください。私たちが持っているのは、量子力学、クライストチャーチ・カレッジの歴史、リバプールフットボールクラブ、第一次世界大戦の起源、2008年の金融危機に至った経済的状況、またはアーノルド・ベネットのレシピなど、あなたが考えることができる何でもについて会話できる大規模言語モデルです。あなたはこれらについて尋ねることができます。そして私たちはそれを見て「わあ、これはAIだ、これは知性だ」と思います。

しかし、あなたの家に入り、夕食のテーブルを片付け、食器洗い機に入れることができるロボットはありません。なぜそのような奇妙な二分法があるのでしょうか?それは、現時点ではAIの手に負えない人間の活動の大きな範囲があるからです。そしてそれらの活動は実世界での活動です。ロボットAIを行うことは非常に非常に難しいです。

大規模言語モデルは顕著な方法で成功し、それらは本当に印象的な成果ですが、それらは大量のデータが利用可能であり、ある意味で、彼らが行うことの結果があまり重要ではないタスクで成功します。ChatGPTを通じて悪いオムレツのレシピを得ると、悪いオムレツができますが、それは世界の終わりではありません。人間と一緒に実世界を占めるロボットを構築し、それが間違った場合、それは混乱を引き起こし、本当の害を引き起こす可能性があります。

実世界で物事を行うことを受け入れないAIのアイデアは、AIのかなり貧弱なバージョンだと思います。

それがあなりの批判で面白いと思うのは、あなたは「非体現化された」という言葉を使っています。それがある種の直感です。そして、他にも取り上げたいことがあります。ChatGPTとの会話をして、あなたが2週間休暇に行き、途中で中断したとしても、それはあなたがどこに行ったのか考えたり、「ウールドリッジはどこに行ったのだろう」と思ったり、退屈したりしません。それは何もしていません。それは単にループで一時停止しているコンピュータプログラムに過ぎません。

人間の知性、動物の知性は基本的にそれとは異なります。私たちは世界に存在し、世界を認識しています。それが体現化が意味することです。それは単に体を持つことではなく、私たちが住んでいる世界と密接に結合していることです。

あなたが最近行ったチューリング講演では、人間の能力を大きく2つに分けています。一つは体現化された能力で、これは自分の周囲を感じる能力です。ここではAI、つまりロボット工学が自然言語処理、画像処理、画像生成などの分野よりもはるかに遅れていることに同意します。

しかし、チューリング講演で本当に驚いたのは、一連の知的能力もリストアップしていたことで、そこでさえも現在の基礎モデルが我々をそこに導いてくれるとは思っていないようでした。自然言語処理、想起、常識的推論は解決済みまたは解決可能と言いましたが、次のような体現化されていない知的能力がLLMの範囲内にすらないとしたことに非常に驚きました:論理的推論、抽象的推論、計画、算術。GPT-4ではまだその立場を維持していますか?なぜなら、それは算術を行うことができるようです。

それは本当に算術を行うことができるのか、それとも算術のように見えることを行っているのか?大きな疑問は、大規模言語モデルが行っていることは、それらのことを行っているのか、それともすでにトレーニングデータで見たものの変形に過ぎないのかということです。

算術は今や解決された問題かもしれませんが、これらのものが、トレーニングデータですでに見た何かの変形ではない問題を実際に解決できるかどうかを調べている大量の研究があります。そして、問題を本当に元から解いているのか、それともパターン認識を行っているだけなのかという問いは、現在大きな疑問の一つです。現時点では評決はまだ出ていません。そして現時点での証拠の重みは、それらは問題解決をしているのではなく、より多くパターン認識に似た何かを行っているということです。

例を挙げて説明させてください。AIでは、問題解決と計画に長い間関心を持ってきました。計画とは、ここに達成したい目標があり、ここから始まり、利用可能な選択肢、世界を変えるアクションがあるというプロセスです。どのようにそれらのアクションを組織して、現在の状態から目標へ変換するかということです。

これは半世紀以上にわたって人々が研究してきた非常に基本的なAI能力です。大規模言語モデルは計画を立てることができるのでしょうか?第一印象では、人々はそれができるように見えたため非常に興奮しました。旅行計画のようなものを尋ねることができます。

しかし、より詳しく調べると、次のようなことをするとどうなるでしょうか?あなたの計画で使用されているすべての用語を難読化するとします。それが慣れている言葉を使わず、同じ問題を表現しますが、トレーニングデータに現れないと分かっている用語を使います。それでも問題を解決できるでしょうか?

強調しますが、それは同じ問題です。ただし見たことのない言葉を使っています。現時点での答えはノーです。それはできません。だから私たちは元々問題を解決することができますが、それはできません。

それが旅行計画を見ているとき、それは数千の旅行計画ガイドや旅行アジェンダなどを見ており、それを助けるためにパターンマッチングを行っていることを示唆しています。しかし、実際に最初から旅行を計画するために、それらのさまざまなアクションをどのように組織するかを計画していますか?

現時点では、論理的推論や問題解決をその種の方法で深いレベルで行うことができるという証拠の重みはノーです。それが役立たないという意味ではありません。それを使って旅行を計画するのに役立てることはできますが、実際にそれらのことを最初からやっているかどうかについては、現時点での証拠の重みはノーです。

あなたの直感は、これらの能力がないだけでなく、それはアーキテクチャの問題であり、ここからデータの量を桁違いに増やしても論理的推論を期待することはできないということですか?なぜなら、基本的にLLMがやっていることは次の単語の予測だけだからですか?

そうですね、それが私が指摘している深い問題ですか?Transformerは次の単語の予測のために設計されました。驚くべきことは、十分なデータとコンピューティングパワーを投入する意欲があれば、それがどれほど有用で印象的であることが判明したということです。

しかし、Transformerアーキテクチャが例えばロボットAIの鍵であると信じる理由は見当たりません。それはそのために設計されたものではありません。だからそれが論理的推論や論理的推論の鍵であるべき理由も分かりません。繰り返しますが、それはそのために設計されたものではありません。

しかし、それが役立たないという意味ではなく、私はこのテクノロジーを使用するときに誰かと同様に魅了されます。そして毎日、人々が本当に注目すべきことを示してくれるとき、驚きを感じます。

私は言わなければなりませんが、これは本当に思いますが、AIの歴史における分水嶺の瞬間です。なぜなら、AIの多くの質問が純粋に哲学的な質問であった時期から移行したからです。それらは文字通り数年前まで哲学者のためだけに留保されていました。そして突然、それは実験科学になりました。

「大規模言語モデルは意識を持っているか?」という問いがあります。それでは袖をまくりあげて実験をしてみましょう。ちなみに、彼らは持っていません。しかしこれらは今、実践的なハンズオン的な質問です。そのような質問を適用できる世界に何もないところから、これが実際の実践的なハンズオン実験科学になるまで、わずか数年で移行したことは驚くべきことです。

ここで悪魔の代弁者をしたいと思います。哲学者として、AIを研究することは非常に謙虚な経験でした。なぜなら、それは人間における理性がどれほど少ししか機能していないかを明らかにするかもしれないからです。

ここでの課題は、これらのアーキテクチャは人間の心のイミテーション、そして人間の心がニューラルネットワークを通じてどのように接続されているかに基づいて構築されているということです。そして直感としては、ニューラルネットワークが論理的推論のために設計されていなくても、人間の脳の構造を模倣したことで、それは創発的な現象かもしれないということです。

おそらく人間が行っていることは第一原理からの思考ではなく、おそらくパターンマッチングなのかもしれません。おそらくそこにはすべてパターンマッチングがあるのかもしれません。私はこれを本当に信じてはいませんが、おそらく私たちは会話をしているときに単に次の単語の予測を行っており、人間が行っていることについて再考する必要があるのかもしれません。実際に私たちが行っていることについての過大な期待を持っているという本当に真剣な思考の学派があります。

人間はTransformerアーキテクチャではないと思います。それが私たちが行っていることだとは思いません。はるかに多くのことが起こっていると思います。私たちは地球に住み、他の人間と相互作用するために進化した動物です。そして人間の本質の基本を理解するためには、これら2つのことを理解する必要があると思います。

Transformerアーキテクチャはそれではありません。長い道のりでもありません。しかし、あなたが創発性について言及したポイントは全く有効だと思います。私たちは人間における知性がどのように生まれるかを理解していません。どのようにして私たちの頭の中のすべてのどろどろしたもの、それらすべての電気化学的プロセスなどがあなたや私を生み出すのか、私たちはそれを深いレベルで全く理解していません。

それが現在のこの時期がとても刺激的な理由です。袖をまくりあげてそれが実際にこれをどのように行っているのかを調べましょう。しかし、これらのシステムを全く軽視したくありませんが、それらはハックである意味があります。それらはまとめられたエンジニアリングのハックです。それらは心の深いモデルや人間の知性に関する深い哲学的理論、または人間の知性に関する深い認知科学理論に従っているわけではありません。それらは技術的なハックです。

人工ニューラルネットワークは人間や動物の脳で見られる構造によって触発されましたが、それを忠実に再現しようとする試みではありません。実際にそれを行おうとする試みがありました。非常に大きなヨーロッパが資金提供したプロジェクトがあり、実際の脳を再現しようとしましたが、ニューラルネットワークはそれを行っているわけではありません。

脳の特定の構造を模倣することでどれだけ成功したかを考えると、つまりニューロンがコンピューティングでどのようにリンクされているかを考えると、バイオミミクリーにもっと目を向け、脳をもっと研究して、複製できる他の構造があるかどうかを見るべきでしょうか?それが前進の道であり、私たちを導いてくれるアーキテクチャを見つける方法でしょうか?

それは一つの方法だと思いますし、確かにいくつかの洞察を得られるでしょう。脳がどのように組織されているかについての非常に不完全な理解があります。脳は単に一つの大きな均質なニューラルネットワークではありません。たとえそれが巨大なニューラルネットワークを含んでいたとしても、それはいくつかの機能的構造を持っています。そして脳の機能的構造については、30年前よりも今の方がはるかに多くのことを理解していますが、それでも非常に不完全な理解です。

だからそれは進む一つの方法ですが、再度強調します。私たちは、数十億年の進化のプロセスを経て地球に住むために現れた類人猿です。大体、海面レベルの地上レベルに、そして地球の物理学について学び、地球の物理学のダイナミクス内で操作できるようになるために、また他の類人猿と相互作用できるようになるためにです。

これらが人間の知性の2つの主要な大きな要素です。私たちの世界について学ぶこと、そして他の類人猿、人間について学ぶことです。AIが持った成功を考えるとき、私たちはそれを忘れるべきではありません。私たちは単に大きなニューラルネットワーク、大きな均質なニューラルネットワークではありません。それよりもはるかに多くのことが起こっています。

AIのどの技術が機能し、どれが機能しなかったかについては、何か憂鬱なものがあると思います。あなたの本からの素敵な引用を紹介します。これはあなたの声で話している部分です:「2000年7月、ボストンでの会議で、新しいAIの若き星の一人によるプレゼンテーションを見ていました。」これはMLが勢いを増し始めた頃だと思います。「私はAIの黄金時代からAIにいた、マッカーシーとミンスキーの同時代人であるベテランのAI専門家の隣に座っていました。彼は軽蔑的でした。『今日のAIはこれなのか』と彼は尋ねました。『魔法はどこに行ったのか』」。

あなたが言っていることですが、「彼の言っていることは理解できました。AIでのキャリアは今や哲学や認知科学や論理ではなく、確率、統計、経済学のバックグラウンドを要求していました。」これはあなたが言っていた詩的でないように思えることだと思います。サイクやアリストテレスの論理学で、それが機能すると思ったが、実際には私たちの脳よりも理解できないブラックボックスであるニューラルネットアーキテクチャに多くの平凡な数学が必要でした。

あなたはニューラルネットを異なる動作をさせるためにより賢いアーキテクチャが必要だと思っていますが、実際にはスケールを増やすことが動作の出力を根本的に変えることがわかりました。それは非常に落胆させる教訓です。

AIの進歩の主要な源が科学的発展だと思うでしょうが、実際にはより多くのコンピュート、より多くのデータだけです。リッチ・サットンというある人による「苦い教訓」と呼ばれる記事があります。リッチは非常に有名な機械学習研究者で、彼は「真実は、我々はAIでいくつかのコアアイデアによって進歩を主にしてきたが、実際には我々が見てきた進歩の大きな一歩は、10倍のコンピュート、10倍のデータを投入する意欲があった時だ」と言っています。それは冷静にさせる教訓ですが、AIにはまだ魔法があります。

今、私たちがChatGPTのような機械を持っていて、会話をし、想像できるあらゆることに会話を向けることができるという事実は、5年前と比べて単に驚くべきことです。私は今PhD学生であり、このような奇妙な新しいAIの風景を探索し、これらのシステムを支配する基本的な法則は何か、原則は何かを解明し、このテクノロジーの裏にある科学を明らかにする機会があることを願っています。そこにはまだいくつかの魔法があります。ただ、それを見つけるために少し頑張る必要があるだけです。

最も先進的な数学が必要であったり、この素晴らしいアーキテクチャを発明したり、人間の脳を数十年間非常に綿密に研究したりする必要があった方がよかったかもしれません。しかし、あなたの言葉「冷静にさせる」が気に入っています。それは「憂鬱」や「失望」と言い換える別の方法だからです。

この一つの観察で締めくくります。現在、ストア派に関する講義を準備していますが、ストア派は有名に人間が非常に合理的な生き物であると考え、無意識のうちに何かを欲するとき、それが良いものであるという暗黙の命題を立てているという考えです。ほとんどの人間の行動の背後には、明示的または暗黙の真偽の命題があります。

反対の極端にいるのはおそらくフロイドでしょう。彼は私たちの無意識は私たちには知られておらず、おそらく大いに知ることができないと考えています。そして、私たちが自分でも理解していないブラックボックスであるニューラルネットがサイクのような明示的なものよりもはるかに多くの成功を収めたという事実は、おそらく私たち自身の知性がどのように機能するかについても冷静な教訓を教えてくれます。

そして私にとって、哲学的な視点から来ると、これがすべてのこの中で最も興奮することの一つであり、かつては哲学的な質問だったものが今や実験科学になっているということです。

ありがとうございました、教授、魅力的なインタビューをありがとうございました。

視聴いただきありがとうございます。この会話が気に入っていただけたなら、ニック・ボストロムの新著「ディープ・ユートピア」に関する私の議論も楽しめると思います。それはAIが私たちをすべての領域で超えた後、人間に何が残されているかを想像しようとしています。

これらのインタビューは、哲学と人工知能を研究する非営利団体であるコスモス研究所のフェローとして制作しているAIシリーズの一部です。ウェブサイト、ボストラムとのインタビュー、そして今日取り上げたすべてへのリンクは以下の説明にあります。ありがとうございました。

コメント