中国のZhipu AIが発表したGLM-5は、オープンウェイトモデルとして驚異的な性能を示している。744億パラメータ(40億アクティブ)の大規模モデルでありながら、Claude Opus 4.5やCodex 5.2といった最高峰のクローズドウェイトモデルに匹敵する性能を発揮し、特にコーディングタスクや長時間実行タスクにおいて優れた結果を残している。価格はOpusの5分の1から6分の1程度と極めてコストパフォーマンスが高く、ハルシネーション率も30%台と業界最低水準を記録した。1時間にわたるコードベース移行作業を成功させるなど、これまでのオープンウェイトモデルでは不可能だった複雑な実務タスクをこなせる実力を持つ。画像入力には非対応という制約はあるものの、多くのホスティングプラットフォームで無料または低価格で利用可能であり、オープンウェイトモデルの新たな到達点を示す存在となっている。

GLM-5の衝撃的な登場

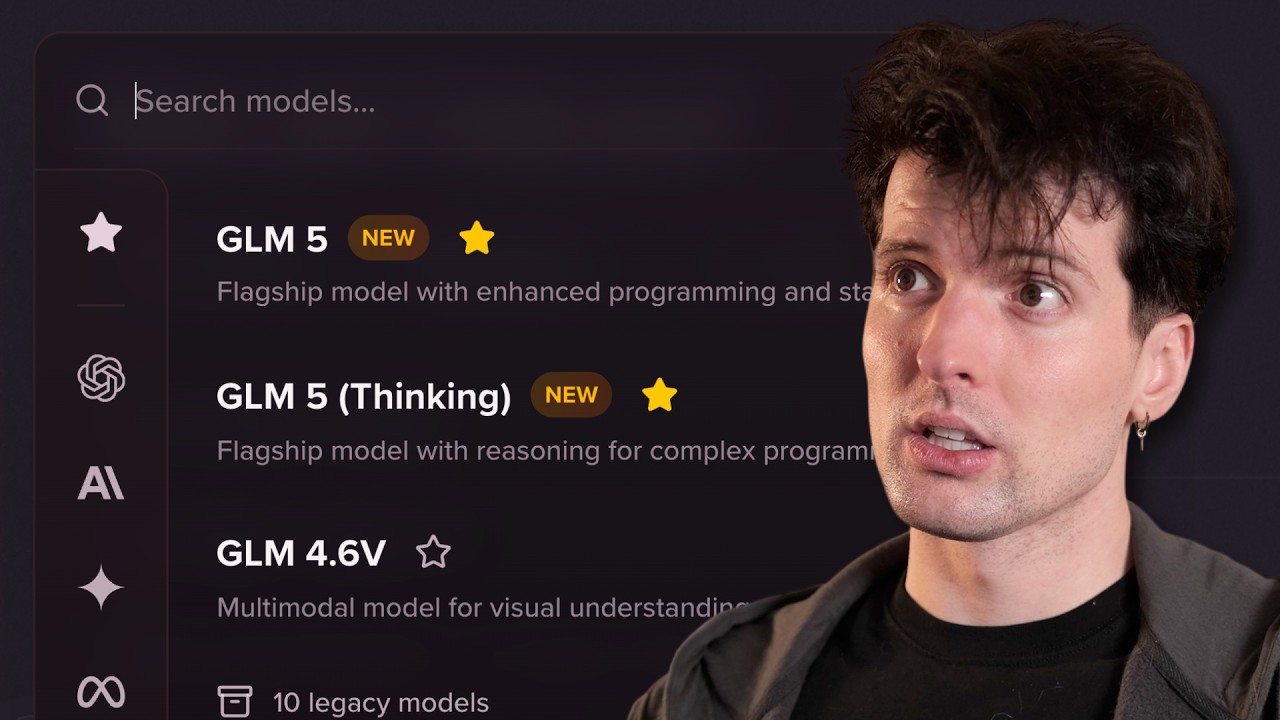

さあ、カウンターの準備をしてください。また新しいモデルが登場しましたよ。GLM-5が私を圧倒しています。みなさんがいつも最初に聞きたがる質問に先回りしてお答えすると、Opus 4.6より優れているのか、Codex 5.3より優れているのかという点では、答えはノーです。これは中国のはるかに小規模な研究所が開発したオープンウェイトモデルなんです。

とはいえ、私がこれまで見てきた中で群を抜いて最高のオープンウェイトモデルであることは間違いありません。特にコーディング関連の作業において優れています。Kimmy K 2.5も素晴らしいモデルでした。オープンウェイトモデルとして、ファイルをダウンロードして自分で実行できるものがこれほど優れているというのは驚異的なことです。しかしGLM-5はそこから意味のある改善を遂げています。

Claude Sonnet 4とCodex、Opus 4.5といったモデルと互角に渡り合っています。もちろん、Opus 4.6のような最新のモデルはまだわずかに優位性を保っていますが、少なくとも私の経験では、Gemini 3 Proよりもはるかに良い体験ができています。

とはいえ、このモデルを限界まで試してみたいと思っています。OpenAIがCodexのために出したものと似たデスクトップアプリも彼らはリリースしています。これは非常に興味深いことです。ただし、これは彼らのホスティングでのみ動作します。彼らの製品ですからね。つまり、それにサインアップする必要があるわけですよね。

このモデルに正直な評価を与えるつもりです。特にこの早い段階で、まだすべてのプラットフォームで利用可能になっていない時期ですからね。最大プランに加入しなければなりません。月額80ドルは、メインで使わないサブスクリプションとしてはちょっと高いですが、これを最大限にテストしたいんです。

私がZhipuから報酬をもらっていないことの証拠が必要なら、ここにありますよ。私が彼らにお金を払ったんです。今日の動画で私にお金を払ってくれている唯一の人たちは、今日のスポンサーです。

DNSimpleの紹介

ソフトウェア開発で難しいことはたくさんありますが、特に難しくて私たちが常にネタにしているものが一つあります。DNSです。DNSで小さなミスを一つ犯しただけで、とんでもない問題に遭遇したことが何度あったか数え切れません。もしそれがシンプルだったらと思います。

ああ、DNSimpleですね。信頼性の高いDNSホスティングとドメイン名サービスです。本当の話をしましょう。このスポンサーには注目してほしいんです。普通のスポンサーとは違うんですよ。

このチャンネルで私が話している企業のほとんどは、VC支援を受けて数十億ドルの収益を目指し、チームが猛烈に成長している企業です。一方、DNSimpleからこのTシャツを受け取ったとき、箱には手書きの宛先と差出人の住所が書かれていました。創業者たちが自宅から自分で発送したんです。

DNSimpleは、エンジニアがエンジニアのために作った製品です。その核心においてそうなんです。ドメインの再販業者として法外なマージンを稼ごうとしているわけでも、ドメインをあなたの目の前から買い取ろうとする怪しい会社でもありません。彼らはただDNSをより簡単にしたいだけなんです。

問題が発生して彼らに連絡すると、対応してくれるのは開発者です。開発者としてDNSがどれだけ良くなり得るか知りたいなら、これ以上探す必要はありません。

アカウント内のすべてのドメインをリストアップしたいですか。そのためのRuby APIがこちらです。新しい連絡先で新しいドメインを登録したいですか。そのためのTypeScript APIがこちらです。Let’s Encrypt SSL証明書を設定する必要がありますか。実行すべきコード行がこちらです。

DNSで少しでも複雑なことをしたい場合、例えばユーザーがアプリをバイブコーディングしたときにサブドメインを作成したり、ユーザーが自分の製品内でドメインを購入できるようにしたりする場合、それらすべてを統合するのは地獄のような作業です。10人以上のチームを持つ企業を知っていますが、彼らは本当はDNSimpleを使うべきなんです。時間を無駄にするのはやめて、sidyv.link/dnsimpleでドメインを正しく処理しましょう。

GLM-5の実践テスト

さあ、準備が整いました。Zcodeアプリについて深く掘り下げていくつもりですが、今日のストリーム準備をしながら裏で作業を進めてきました。実際の仕事を実行していて、この古いコードベースの移行作業も含まれています。これは実際に1時間かけて無料で実行されました。

このUIは見覚えがあるかもしれませんね。OpenCodeのような感じですが、上部を見ると、これはKilocodeです。Kiloはスポンサーなので、そこには若干のバイアスがあることをお知らせしておきます。彼らは最近OpenCodeをフォークして独自のCLIを作りました。Kiloのサブスクリプションで使えるので、なかなか便利です。

彼らはこの新しいモデルを一貫してサポートした最初のプロバイダーでもありました。しかもGLM-5をサポートしているだけでなく、無料で提供しているんです。Modalのような他のいくつかのプロバイダーも同じことをしているようです。彼らはAPIエンドポイントを持っていて、この新しいモデルをホスティングしており、今のところ無料で使えます。

将来的にも無料のままでいるかというと、おそらくそうはならないでしょう。Open Routerで見ている現在の価格設定は、出力が100万トークンあたり約3ドル、入力が100万トークンあたり1ドルです。これはSonnetの3分の1から4分の1の価格で、Opusの5分の1から6分の1の価格に相当します。その性能を考えると、本当に良いコストパフォーマンスです。

ただし、これらのモデルが出たばかりなので、稼働時間はそれほど良くありません。多くのプラットフォームで7秒以上のレイテンシが発生しています。でもこれらはすべて短期間で解決されるでしょう。新しいモデルが出るときはいつもそうなんです。

今私たちが本当に気にすべきなのはパフォーマンスです。スピードではなく、能力です。そして、これが1時間以上かかるジョブを問題なく実行できた最初のオープンウェイトモデルであるという事実は、私を完全に驚かせました。

実行中ずっと見ていましたが、多くの賢い処理をしていました。このプロジェクトに最初に投げかけたのはPingでした。Pingをご存じない方のために説明すると、Twitchを辞めた直後にライブコラボレーションを簡単にするために作ったものです。Linus Tech TipsからElgato、Xboxチームまで、みんなが使っています。

ライブストリーミングのコラボレーションを簡単にするために作られました。今でもこの製品を誇りに思っていますが、クリエイターツールはあまりお金を生まないことが判明したため、私たちのメインフォーカスにはなっていません。そのため、私たちが構築している他のすべてのものに注力してきました。

その結果、このコードベースは古くなってしまいました。もう少し寛大に言えば、ですが。正直に言うと、もう作業するのが楽しいコードベースではなくなっています。その大きな理由は、当時はTRPCの非常に古いバージョンのような、その後大きく変わったものに早期から賭けていたからです。

このコードベースを最新のツールに移行することは、モデルに投げかけるお気に入りのチャレンジの一つです。実際にはできないことなんですが、近づけば近づくほど、私にとって興味深くなります。

Codex 5.3についての動画で述べたように、これはこの作業で意味のある進歩を遂げることができた最初のモデルでした。パッチのパッケージング周りで新しいことをして、それを機能させ、全体を通してブロックを解除しました。5.3のパフォーマンスには本当に感銘を受けましたが、今GLMで実行してみたところ、非常にうまくいっているようです。

この移行の最終段階はまだ完了していません。今のところどう動いているか見てみたいと思います。

トラブルシューティングと機能テスト

Firefoxのサポートはあまり良くありません。これはメディア製品で、FirefoxのAVレイヤーがひどいからです。これは私がよく遭遇する一般的なエラーです。この作業に使ってきたすべてのツールで、この特定のバグが発生しています。

実はこれがGLM-5に対する最初の問題点です。貼り付けて、修正して、送信します。少し混乱しているようですね。あるいはサーバーがラグっているのかもしれません。ビジョン機能がないんです。コードモデルなのに、なぜビジョンが必要なのかと思われるかもしれませんが、馬鹿げているとは思いません。

私は常に画像を貼り付けています。コードを書いているときに私が行う主なことの一つなんです。正直に言って、私のプロンプトの20%から50%には画像が含まれていると思います。だから、それがないのは残念です。Kimmy K 2.5について気に入っていた点の一つは、ついにそれを修正したことでした。

エラーが出ています。修正してくださいと指示します。このジョブを実行させている間に、実行した他のタスクを見てみましょう。なんてこった。このモデルはとにかく動き続けてくれます。これは本当に素晴らしいことです。オープンウェイトモデルでこれだけ長時間動作できるのは嬉しいですね。

ああ、これは初めて画像を貼り付けようとしたときです。ジョブは動いていると言っていますが、画像は見えません。そう、ちょっと面倒ですが、動いています。このジョブをバックグラウンドで実行させている間に、彼らがこのモデルについて何と言っているか、そして私たちの仲間たちがこれをどうレビューしているか、少し読んでみましょう。まずは彼らのブログ投稿から始めましょう。

バイブコーディングからエージェント型エンジニアリングへというタイトルは少しクリックベイト的だと感じますが、なぜそう言っているのかは理解できます。これは私のこれまでの経験から、オープンウェイトモデルができることにおいて意味のあるジャンプのように感じられます。見栄えの良いデモをワンショットで作るところから、もう少し有用で、はるかに長時間動作し、より難しいことができるものへと進化しています。

私がGLM-5にやらせてきたような移行作業ができるオープンウェイトモデルを見たことがありません。その作業が最終的にうまくいくかどうか、待ちきれません。

モデルの技術仕様

複雑なシステムエンジニアリングと長時間のエージェントタスクをターゲットにしたGLM-5をローンチしています。ええ、そうですね。スケーリングは依然として、AGIの知性効率を向上させる最も重要な方法の一つです。

GLM 4.5と比較して、GLM-5は355億パラメータ(32億アクティブ)から744億パラメータ(40億アクティブ)にスケールアップしています。これが何を意味するか分からない方のために説明すると、これはモデル内部のマッピングで、何が何を指し、どれだけ強くそうするかということです。

パラメータは基本的にトークンとベクトルのようなもので、既にあるテキストに基づいて何が起こるべきかをマッピングします。参考までに、Kimmy K 2.5は1兆パラメータのモデルです。744億は近いですが、これはこのモデルが巨大になるということを意味します。1.5テラバイトです。

対して4.7は700ギガバイトでした。ただし、FP8バージョンやフラッシュバージョンもあります。古いモデルの軽量版で、この4.7 FP8バージョンはわずか360ギガバイトです。そして4.7フラッシュはたったの62ギガバイトです。

でも、このモデルをローカルハードウェアで実行することはできません。オープンウェイトが自分のコンピュータで実行できることを意味すると思っている人が多いですが、テラバイトのモデルを自分のハードウェアで実行することはできません。これは自宅でアクセスできるものではありません。

これはModalなどのホスティングプラットフォームにとってより有用です。これらのオープンウェイトモデルをホストして私たちが使えるように提供したり、CerebrusやGrokのような場所がモデルの独自バージョンを作って大幅に高速化できる可能性があります。

今ここにいて気づいた良い点は、これが適切なMITライセンスとしてライセンスされているということです。私が見る限り、通常の除外事項はありません。私たちを使っていることを明記しなければならないとか、一定数のユーザーがいる場合は私たちに支払わなければならないといった奇妙なことはありません。

つまり、パラメータが多いということは、モデルが大きいということです。例えば、GPT OSS 120Bモデルは約80から90ギガバイトです。私のラップトップでローカルに実行できますが、120億パラメータです。だから、パラメータが少なければ知性も少なくなります。

一般的に言って、パラメータ化が多ければ多いほど、価値が高まり、モデル内のデータが多くなり、表示できる知性が高くなります。一般的にはですよ。明らかに時間の経過とともに、特定のサイズに詰め込める知性の量は変化しますが、今のところ、大きなモデルは確実にもっと多くの能力の可能性を意味します。

しかし、この40億アクティブという部分、これはMixture of Expertsです。これが意味するのは、特定のリクエストにおいて、740億パラメータすべてを通過する代わりに、あなたがやっていることに最も関連性が高い40億の部分、それが代わりに通過されるということです。

Mixture of Expertsモデルはかなり前から顕著になっています。今では誰もがこれを行っているようです。なぜなら、必ずしも通過する必要のない、さまざまな言語、さまざまな科学、これらすべてのさまざまなことについての異なる知識を持つ超知的なモデルを持つことができるからです。

英語で応答しているときに、モデル内のすべての中国語データを通過する必要はありません。Hello Worldアプリを書いているときに、すべての理論物理学を通過する必要はありません。それが基本的にMixture of Expertsの仕組みです。

40億アクティブはかなりクールですが、繰り返しになりますが、このモデルのサイズは多くの人にとってアクセス不可能にするでしょう。また、彼らの事前トレーニングは28.5兆トークンという驚異的な規模です。

GLM-5はDeepSeekのスパースアテンションも統合しており、長いコンテキスト能力を維持しながら、デプロイメントコストを大幅に削減しています。DeepSeekの研究は多くのことを推し進めており、ここでそれを明記しているのは素晴らしいことです。確実にパフォーマンスに役立つでしょう。

強化学習の改善

彼らは強化学習にも大きな改善を加えています。これはモデルを作った後にチューニングする方法です。強化学習は、事前トレーニングされたモデルの能力と卓越性の間のギャップを埋めることを目的としています。

しかし、LMSのために大規模に展開することは、RLトレーニングの効率性のために困難です。これに対処するため、私たちはSlimeという新しい非同期RLインフラを開発しました。これはトレーニングのスループットと効率を大幅に改善し、より細かい粒度での事後トレーニングの反復を可能にします。

ええ、それは本当に素晴らしいです。まだ調べていませんが、それは今日の目的ではありません。彼らは一度に多くのRLを実行する方法を見つけたようです。やや直線的ではなく。それは本当に素晴らしいことかもしれません。どのように機能するか見るのが楽しみです。

でも、私がもっと見たいのはこれらのベンチマークです。Humanity’s Last Examでは、ツールなしではGoogleのモデル以外のほぼすべてを打ち負かしましたが、ツールありでは勝利しました。

ここで本当に興味深いのは、このベンチマークにおけるツールなしからツールありへのギャップを見ることができることです。ツールがあれば、研究をしたり、コードを書いたりできますが、ただテキストを吐き出すだけではありません。

ここで気づくのは、Zhipuのモデルはツールを使うと40から50%良くなるということです。Anthropicのモデルは20から30%良くなりますが、何らかの理由でGoogleとOpenAIのモデルはそれほど良くなっていないようです。私はそれについて疑念を持っています。特にGoogleのモデルは、ツールをうまく使いません。

次にSWE-bench Verifiedがありますが、これではOpusとCodexと互角でした。これは4.5と5.2だと思います。ええ、そうです。彼らは4.6がドロップする前にこれらを作りました。これはよくあることです。

そして5.3はまだAPIにないので、ベンチマークを取るのが本当に難しいんです。だから、これが今できる最善です。でも正直なところ、Opus 4.5と5.2の両方とも、日常的な作業には十分以上のものです。5.3は素晴らしい改善です。今は私のデイリードライバーとして使っています。

5.2は依然として驚異的なモデルです。Opus 4.5はおそらくOpus 4.6よりも優れています。SWE-benchで互角になるのは大きなことです。SWE-bench Verifiedでは、Anthropicと互角であるだけでなく、Codex 5.2を打ち負かし、Gemini 3 Proを粉砕しました。

そしてTerminal Benchでは、GeminiとCodexの両方を打ち負かし、再びAnthropicと互角です。Vending Benchは、自動販売機を運営してどれだけお金を稼げるかというベンチマークです。ここでも非常に良い成績を収めました。

TAU Benchでもとても良い成績でした。これはツール呼び出しのベンチマークです。MCP Atlasでは、5.2とほぼ同等になりました。そしてBrowse Compというブラウザ使用のベンチマークでは、私の知る限り史上最高のスコアを獲得しました。これは本当に驚くべきことです。

長時間タスクのベンチマーク

ZI Benchv2 4.7対5対Opus 4.5があります。これは長時間実行タスクをテストするために彼らが作ったベンチマークです。それが彼らにとっての真の焦点のようで、オープンウェイトモデルから見るのは非常にクールです。

ビルド成功率は以前のモデルから大幅に向上しています。エンドツーエンドの正確性も意味のある向上を見せています。バックエンドについても改善されています。

しかし、ここで右側を見ると、かなり大きなギャップがあることがわかります。フロントエンドタスクは98%の確率で完了できます。トップティアモデル全体でエンドツーエンドの正確性は75%の確率ですが、バックエンドは26から27%まで下がります。

これらのモデルでバックエンド作業を改善する機会はまだたくさんあります。最近多くのバックエンド作業をしてきたので、これは自信を持って言えますが、フロントエンドは今や圧倒的です。

そして再び、長距離タスクでは、Anthropicモデルよりも優れたパフォーマンスを発揮しているようです。マルチステップチェーンタスクでは若干劣っていますが、それでもはるかに良い成績です。

正直に言うと、これらのチャートの一つを見ていて面白いのは、ほぼすべての太字の値が、私たちがここで見るために来たものの右側にあることです。最高のクローズドウェイトモデルに対しては何も勝っていません。

Claude Opus 4.5はこれよりも優れているでしょう。しかし、これが5分の1の価格かそれ以下で、オープンソースであることを考えると、これは非常に魅力的なモデルです。実行中だったジョブをチェックしてみましょう。

いいですね。5分以内にかなり早く修正しました。今ページを読み込めるか見てみましょう。スクリーンショットを撮るには最高で、コピペするには悲惨なエラーの一つです。

どうやら彼らの他のアプリは画像を扱えるようです。だから、実際のプロジェクトでZcodeを素早く試してみましょう。Cloud CodeでGLMを使うつもりでしょうか。GLM-5すらないんですか。このアプリにはそれがあると思っていました。彼らの製品なのに。

GM-5テスト。うまくいったようです。新しいタスクをやってみましょう。ここでスクリーンショットが撮れるか見てみます。修正してください。

Cloud Codeと表示されているのに、Cloud Code経由でGLM-5を使っているのは少しおかしいですね。少なくとも私が知る限りでは、そういう仕組みだと思います。遅さを感じますね。繰り返しになりますが、スピードはほぼ確実に改善されるでしょう。

大手ラボからのクローズドウェイトモデルで、リリース時に遅い場合、それは遅いままになります。だからGPT-5がローンチ時に遅ければ、それはおそらく変わらないでしょう。Opus 4.6がローンチ時に遅ければ、ネタバレですが、遅かったです、それはおそらく変わらないでしょう。

オープンウェイトモデルが最初遅い場合、ホストが最適化する方法を見つけ、容量が良くなるにつれて改善する可能性が非常に高いです。これらすべて、これらのラボは全体的な容量も少ないです。

非常に興味深いですね。画像を分析しましたが、自分で画像を見ることができないため、ツールを使ってそれを行いました。マルチモーダルではありません。物を見る能力はありません。ただ物事を行う能力があるだけです。

bunコマンドを実行できません。サンドボックス化されているんですか。なぜできなかったんでしょう。起動していないんでしょうか。ああ、彼らがここで間違ったことを知っています。知りすぎているかもしれません。なぜなら、最近自分で似たようなアプリを構築しているかもしれないからです。

これはうまくいかないと思います。だから今のところKiloを使い続けることにします。こういうアプリを作っているのは素晴らしいことですが、明らかにメインフォーカスではないですね。

画面にZhipuのブランディングよりもCloud Codeが表示されているという事実からわかるように、Zhipuのモデルを使っているにもかかわらずです。少なくとも、これは機能しているようです。何が壊れたんでしょう。

ああ、だめです。rm -rf node_modules bun install rundevをやってみます。よし、大丈夫そうです。何をコンパイルしているのかわかりません。こんなに時間がかかるなんて。でもサインインはできます。ちょっと待ってください。

いいですね。今のところうまくいっているようです。実際にカメラを起動したときにどうなるか見てみます。やあ、オタクたち。少し裏側を見せています。マイク、参加します。

よし、参加した途端にエラーが出ました。公平に言うと、Agoraクライアントは私が今まで扱った中で最も呪われたソフトウェアの一つです。だから壊れていても驚きません。自信を持って悪だと言える企業はほとんどありませんが、彼らとはそれほど悪い経験をしてきました。それが壊れたことに驚きはありません。

実際に出荷したいと思っているこの構築作業では、Convexに移行して、Agoraのような壊れたものの多くを廃止できるようにします。テストしています。いいですね。そしてリフレッシュしても、メッセージはまだそこにありますか。あります。

外部のクイック埋め込みリンクをやると、私は表示されますか。表示されます。素晴らしい。すべて期待通りに機能しています。これは非常に印象的です。

このモデルが1時間動作し、TRPCを除くコアの依存関係のほとんどを更新し、成功し、今動作しているという事実は驚異的です。今年の初めでさえ、クローズドウェイトモデルはこれを行うことができませんでした。オープンウェイトモデルがこの年の初めにこれを行っているという事実は、本当に印象的です。

明らかに、サイモン・ウィリソンも自分の投稿を作りました。LMSで構築しているプロフェッショナルなソフトウェアエンジニアを何と呼ぶべきかについて、Zhipuが立場を取っているのを見るのは興味深いです。

エージェント型エンジニアリングが最近他の場所でも現れているのを見てきました。特にアンドレイ・カルパシーとアディオ・アモデイからです。それは公平です。バイブコーディングという用語には非常に多くの否定的な連想があり、これははるかに深いため、業界はこの用語から離れようとしているようです。

ああ、どうやらDaxがチャットにいるようです。なぜKilo CLIを使っているのかって。だって君たちまだGLM-5を持っていなかったからだよ。心配しないで、Dax。最初にそれがOpenCodeのフォークであることを指摘したよ。みんな知ってるし、これに使っていることも。

GMは良いですか。ああ、それを見逃しました。Dax、えっと、驚異的だよ。超長時間実行が本当に可能なんだ。1時間近く動いたジョブを実行したばかりだよ。古いping.ggコードベースを移行する大規模な移行だった。

これを適切に動作させることに近づいた唯一の他のモデルは5.3 Codexで、それはできた。ええ。59分30秒。ほぼ1時間ぴったりで動作した。だから君たちは絶対にできるだけ早くサポートを追加したいはずだよ。

現在の変更をコミットして、フェーズ4を実装できますか。良いGitエチケットも持っています。それは必ずしも期待していたことではありませんが、見るのは素晴らしいことです。この間に一度、私のためにコミットしてこの新しいブランチを作るように指示しました。そして、それらすべてを非常にうまくやっているようです。

これは、OpusとCodexやトップティアモデルから得られるあの有能さを最も感じたものです。メジャーラボ以外でこれを感じたのはこれが最も強いです。何かを感じています。

そして、ええ、Kiloの無料ティアで1時間のリファクタリングをやりました。かなり驚きです。そして、他の多くの場所もこれを無料または本当に安く提供することを期待しています。なぜなら、十分なGPUがあって、それを行うことができれば、ホストするのがそれほど難しいことではないからです。

最高クラスに近い知性を探していて、これらの200ドルプランの予算がない人たちにとって、これは本当に魅力的です。これは大きなタスクです。パッケージ更新計画から始めましょう。

正直なところ、君たちが追跡し始めるべき新しいインデックスは、ベストニューモデルインデックスだけではなく、実際にモデルを使ってコーディングしたりコードを表示したりしている時間が動画のどれくらいを占めているかです。他のものを読むのではなくね。

コードベースの詳細に費やしている時間が多ければ多いほど、おそらくより良いモデルです。これらすべてのサイトのダッシュボードはひどいですね。Zhipuのサイトでランダムにサインアウトされる回数は少しイライラします。

そして今、OpenCode本体のセットアップができました。見てください。ここでのコーディングプランを通じてGLM-5を使えます。別のプロジェクトでこれを試してみましょう。速く感じるかどうか見るために。

このアプリを近々リリースする予定です。ローンチ前に対処すべき目立つことはありますか。これをShoeに投げてみます。どうなるか見てみましょう。これでUIテストをすばやくやるべきです。

Vite、Tailwind、React、TypeScriptで初期化してください。ホームページの5つのバリエーションを作ってください。フロントエンドデザインスキルを使って、見栄えを良くしてください。

これは正当な監査を行いました。2分しか実行されませんでしたが、多くの良いものを見つけました。実際にアプリを適切にスキャンし、重要なものすべてを見つけ、良い提案をしました。これは良いモデルです。他にどう表現すればいいかわかりません。

UIでどうなるか見るのが楽しみです。多くのオープンウェイトモデルが苦戦するところですからね。Kimmy 2.5はそこで良い仕事をしましたが、どれだけ良いかは今後次第です。効率のためにすべてを並行して書きます。そうだね!

待っている間に、Artificial Analysisが何と言っていたか見てみましょう。GLM-5はZhipuの4.5以来の最初の新しいアーキテクチャです。他のすべてのモデルは元のアーキテクチャの一部でした。

5は744億まで完全にスケールアップしました。先ほど述べたように、これはDeepSeek V3やKimmy K2のFP8ではなく、BF16浮動小数点精度です。それがこのモデルがこれほど巨大である理由の大きな部分です。

Artificial Analysisの評価

GLM-5はインテリジェンス指数で50のスコアを獲得し、4.7の42から上昇して、新しいオープンウェイトのリーダーになりました。8ポイントのジャンプは、エージェントパフォーマンスと知識およびハルシネーションにわたる改善によって推進されています。

ハルシネーション部分は特に本当に素晴らしいです。これまでに見た中で最もハルシネーションが少ないモデルのようです。Googleがすでにオープンウェイトモデルに粉砕されているという事実はかなり驚きです。

Gemini 3は悪く、すでにかなり無関係でした。今や完全に終わりました。GLM-5はハルシネーションベンチでより頻繁に棄権します。これにより、嘘をついて間違っていることに対するマイナスポイントを回避しています。

そして、それが彼らがこれまでに見た中で最も低いスコアをハルシネーションベンチマークで獲得した理由です。そのハルシネーション率は30%台です。Gemini 3 Proの88%と比べてください。

ええ、わからないと言う方がはるかに意欲的です。他のモデルはただ嘘をついて間違えます。20万トークンのコンテキスト、マルチモーダリティはテキスト入力と出力のみです。Kimmy K 2.5は画像入力をサポートする主要なオープンウェイトモデルのままです。

そうです。そしてKimmy K 2.5もそれが本当に得意です。正直なところ、画像部分にKimmy K 2.5を使う汎用画像認識ツールのようなものに価値を見出すことができます。そして、他のすべてにこのモデルを使うことができます。

オープンウェイトモデルのどれも、単独で使う唯一のモデルとして十分に優れているとは思いませんが、それらの間である程度のオーケストレーションは非常にうまく機能する可能性があります。

多くの人が以前、GLMをワークホースモデルとして使用し、Minimax のようなものでコマンドとコントロールをさせていたことを知っています。Kimmy 2.5が物事を少し変えました。そしてGLM-5はさらにそうするでしょう。

コスト対インテリジェンスでの位置づけは本当に堅実です。巨大なので、Kimmyよりも少し高価ですが、そのパフォーマンスは意味のある改善です。コストは下がるかもしれませんが、確かなことはわかりませんが、そのパフォーマンスは意味のある改善です。

このグリーンの範囲にはまだ達していませんが、そこから遠くもありません。そして、他のモデルがはるかに高価に感じられます。この下のバーは対数スケールであることを覚えておいてください。だから50%遠いものは2倍悪いわけではありません。時には20倍になることもあります。残酷です。

また、ベンチマークを実行するために使用するトークンも以前より少なくなっています。パフォーマンスははるかに良くなっているのに。これは素晴らしいことです。なぜならGLM 4.7はこれらの推論ベンチマークでは確実にトークンを多く消費していたからです。

そして、それはこのリリースでほぼ対処されたようです。実際のコストを見ると、主要モデルよりもはるかに低いことがわかります。GLM-5はこのベンチマークを実行するのに500ドルかかりましたが、Opus 4.6は1500ドルかかりました。3倍安いです。

5.2ハイは2300ドルでした。そしてOpus 4.6の適応的推論では、必要なだけ推論できるモードで2500ドル、Codex X-ハイで3200ドルでした。だから、知性としては劣るものの、意味のあるほど十分に近い知性に対して3倍から6倍安いのです。

デザインがどうなったか見てみましょう。オープンウェイトモデルからこれほど良いデザインが得られるという事実は、かなりすごいことです。何。明らかにKimmy K 2.5は良い仕事ができますが、これは本当に良いスタート地点です。他のものをチェックしてみましょう。

ああ、それらすべてがこのフォントクリッピングをやっています。これは多くのモデルが失敗するのを見てきました。きれいですが、問題があります。3番目。ここで彼らが目指している方向は気に入っていますが、この側面が適切に完成していません。

繰り返しになりますが、彼らが目指している方向は気に入っていますが、背景などにいくつか問題があります。でもこれは合理的な出発点でしょう。より高価なモデルにお金を使いたくない場合、これで問題ありません。

明らかに、これの残念な点の一つは、問題がある場合、気に入らないものをスクリーンショットして「これを修正して」と言えないことです。画像を見る能力がないからです。でも、これらは合理的な出発点です。

これらのどれも、フロントエンドデザインスキルを使ったOpus 4.6から期待するほど良くはありませんが、正直なところ、GPTモデルから得られるものよりは良いです。

そして、ハルシネーション率のことにはまだ圧倒されています。それを見るのは本当に素晴らしいことです。そして、ホスティングの最適化でコストを少し下げることができれば、すぐにこの範囲に入り、合理的な価格で群を抜いて最も賢いモデルになるでしょう。

このモデルの右側にあるほとんどすべてのものは、それほど賢くありません。適応モードのOpus 4.6とエクストラハイのCodex以外は、ほとんど他のすべてがより愚かです。コスト指数では半分の位置にあるのに、パフォーマンスではトップ近くにあるというのは、かなり驚きです。

知性が商品化されることを疑ったことがある人は、うまくいけば、Kimmy K 2.5とGLM-5の最近のリリースが反対方向に揺さぶっているでしょう。これらのラボがフロンティアに追いつくスピードは驚異的です。

特に、同時にGoogleやxAIのようなラボが追いついていないことを考えるとです。Grok 4は今どこにいるのでしょうか。ああ、ここまで下がって41と39それぞれです。

Grokのファンボーイは決して理解できませんが、特に今、彼らの研究者全員が去り、状況は少し怖いです。彼らは粉砕されています。ここのメイン2つのラボと中国の本当に才能のある一握りのラボによって、みんなが粉砕されています。

年末までに、Anthropic、OpenAI、Zhipu、DeepSeek、Minimax、またはMoonshot以外の誰かは本当にいないと思います。今重要なのはこれらのラボだけのような気がします。将来的には変わる可能性がありますが、彼らほど速く動いている人はいません。

未来は私たちがここで見ているものと非常に似ているように見えると思います。数字は大きくなるかもしれませんが、順序は比較的似たままになると思います。でも、今トップ4のモデルの一つがオープンウェイトであることは本当に素晴らしいことです。

ワクワクしています。ところで、TRPCのことでやっていた移行作業はまだ実行中です。ただ動き続けることができます。そして、ここで行ってきたこの移行作業すべて、適切なAPIレートで課金されていたら、約10ドルかかっていたでしょう。

この移行を行うためにエンジニアに数千ドル支払うところでした。そして、これはバックグラウンドで粉々にしてくれます。最高クラスのクローズドウェイトモデルでは100ドル以上かかっていたでしょう。それは驚異的です。

このモデルを多くのことに使うつもりだと思います。素晴らしい出荷をしてくれたZhipuに祝福を。ここでのエンジニアリングと長時間実行タスク作業へのフォーカスが大好きです。他のすべてをはるかに先行しています。

多くの会話をするのは好きにならないと思います。そして画像のマルチモーダルサポートの欠如は少し厳しいですが、それ以外は、もうほとんど到達したような気がします。オープンウェイトの世界がどれだけ速く動いているかを見るのは驚異的で、このリリースにこれ以上ないほど満足しています。

本当に本当に興奮しています。Codex 5.3というデイリードライバーをまだ置き換えるつもりはありませんが、驚くほど近いので、お金を節約しようとしている人や、自分でホストできるモデルを実行しようとしている人には、簡単にこれをお勧めできます。

ただ、みなさんがどう感じているか気になります。私と同じくらいこのリリースに興奮していますか。それとも新しいリリースにうんざりしていますか。どう感じているか教えてください。それでは次回まで、ピース、オタクたち。

コメント