Anthropicが新たに発表したClaude Haiku 4.5は、同社が1年半ぶりにリリースした安価な小型モデルである。従来のバージョンを飛び越えて登場したこのモデルは、5ヶ月前に最先端だったClaude Sonnet 4と同等のコーディング性能を持ちながら、3分の1のコストで2倍以上の速度を実現している。特筆すべきは毎秒約150トークンという処理速度と、推論機能を搭載した初の小型モデルである点だ。GLM 4.6などの競合に対抗する戦略的リリースと見られ、コード生成に特化した設計となっている。安全性評価においても過去のモデルより高い整合性を示し、エージェント的な「怠惰さ」を軽減する工夫も施されている。価格は入力1ドル、出力5ドルと若干の値上げがあったものの、知性と速度のバランスでは市場において競争力のある位置づけとなっている。

Anthropicが新たに投入した安価なモデル

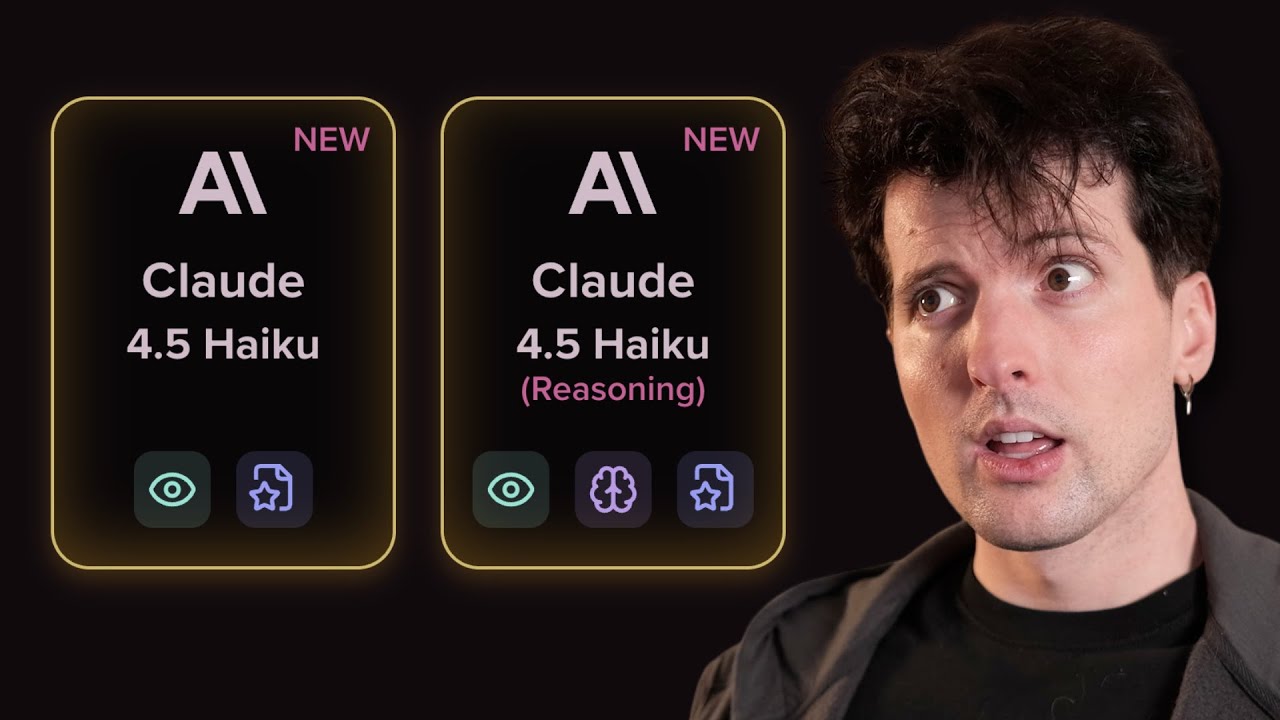

Anthropicが新しいモデルを投入しましたが、今回は珍しく超高額なモデルではありません。本当です。ついに数年ぶりに新しい安価なモデルが登場しました。AnthropicはHaiku 4.5をリリースしましたが、4.0や3.5、そして3から今までの間のすべてのバージョンをスキップしています。これはAnthropicの小型モデルとしては2024年3月以来初めてのアップデートです。

Anthropicが出力100万トークンあたり15ドル未満のモデルを作るのに手を煩わせたのは、1年半以上ぶりのことです。そう考えるとちょっとクレイジーですよね。でもこれは、優れた小型で高速かつ安価なモデルへのニーズがかつてないほど高まっている市場の変化も示しています。特にAnthropicのような企業にとって、現在OpenAIに対する日常的な使用における主な優位性は、コーディングタスクを実行する際にモデルがGPT-4oよりも大幅に速く感じられ、動作することです。

Haikuには多くの可能性があり、私の初期テストと評価から判断すると、実際に非常に優れたモデルのようです。彼らの評価によると、今年初めに発表された大型モデルであるSonnet 4よりも優れています。Sonnet 4.5と同等のラインにあり、GPT-4o Codexにも匹敵すると主張しています。これは価格を考えると、非常に、非常に有望なモデルです。私は間違っていました。

以前にHaikuの3.5がありました。すみません。昨年これが起きたことを忘れていました。つまり、アップデートがあってから約1年が経っているわけです。でも、3.5を使うのは本当に安かったんです。入力が80セント、出力が4ドルでした。だから彼らはまさにそれを請求しているわけです。本当に価格を上げたんですか?1ドルです。

おいおい。20セント上げて、出力も1ドル上げてます。なぜわざわざ変える必要があるんですか?あなたたちにはたくさんお金があるでしょう。またしてもAnthropicがちょっと変な行動をしている例です。私たちが何を期待しているのかわかりませんが、掘り下げるべきことがたくさんあります。今日のスポンサーから一言あって、それから全力で取り組みます。

スポンサーメッセージ

もしあなたのチームが素早く出荷しないなら、ビデオの残りの部分にスキップしてもいいですが、もし彼らがそうするなら、本当に注目する必要があります。なぜならDeep Depotは彼らをさらに速く出荷させるからです。ビルドが完了するのを待つことでどれだけの時間が失われているか、あなたは想像もつかないでしょう。私自身もある程度経験していて、それがひどいことは知っていましたが、PostHogがビルド時間を55倍削減したという話を聞くと、本当に驚かされます。

PostHogがDepotに移行したとき、ビルド時間を2時間半から3分未満に削減しました。Paulからのこの引用が大好きです。「私たちはPostHogが異常に速く出荷すると言っていますが、1時間45分待っているなら、PostHogが異常に速く出荷するとは言えません」でも確かに、これはただのCIですよね?バックグラウンドで実行させればいいんです。

実は、彼らはかなり先に進んでいます。彼らのローカル開発ガイドは驚異的です。Depotがやっているすべてのキャッシングとレイヤリングを利用して、自分のマシン上でDockerビルドを高速化できます。そして、多くの変更が発生し、多くのイメージが作成される大規模なチームがある場合、それらを開発者間で共有できるようになります。

したがって、3人の開発者が1つのブランチにいて、そのうちの1人がこれをビルドした場合、今ではみんながそのキャッシュされたバージョンにアクセスできます。だから、ブランチ間の切り替えがずっと安くなります。巨大なDockerイメージを持つこれらのプロジェクトの1つで作業したことがあるなら、古いブランチに戻ったり、十分なコミットの後ろに飛んだりしたくないという恐怖を知っているでしょう。なぜなら、そうするとすぐにビルド時間が急上昇し、CPUが狂ったように急上昇してそこに座って待つことになるからです。

これを解決し、CIとビルド時間、そしてさらに多くのことを解決します。彼らはCloud Codeのようなツール用のリモートサンドボックスも追加したばかりで、環境をキャッシュしていることを思い出すと、非常に便利です。環境がスピンアップし、npm installを実行し、これらすべてのファイルを取得するのを待つ必要はありません。同じマシンのNVMeドライブから直接来ます。はるかに優れています。

あなたのチームはCIより速く出荷できません。だから今すぐsoyv.link/depoで修正してください。

モデルの詳細と比較

ここで話すべき小さなことがたくさんあります。彼らの公式投稿や、彼らが他のレポーターに出した数字から、Simon Wilsonのような少し公平なレポーターまで。私は彼を本当に尊敬しています。Artificial Analysisはたくさんの情報を含むアップデートを投稿したばかりで、私は彼らと協力して、それがウェブサイトに掲載される前にさらに多くの情報を得られるようにしています。

そしてもちろん、直接作業することで実際にどのように機能するか。彼らはすでにカーソルで動作しています。だから、速度を見るためにここで試してみます。わかりました、すごく速いです。ああ、間違った部分をコピーしました。すでに設定されていますが、それをかなり早く理解しました。このコードをどれくらい速く書いていますか?書いていません。

すべてを生成してから、ファイル全体を上書きします。かなり速く進んでいます。これはGPT-4oと比べて笑えるほど速く感じます。クールです。完了しました。1分もかかりませんでした。結果を見てみましょう。いい感じです。Claudeモデルと違って、変な紫色はありません。興味深い。悪くないです。そして非常に非常に速いです。

今のところ期待しています。Claude Haiku 4.5、私たちの最新の小型モデルが本日すべてのユーザーに利用可能になります。最近フロンティアだったものが、今ではより安価で高速になっています。5ヶ月前、Claude Sonnet 4は最先端のモデルでした。今日、Haiku 4.5は同様のレベルのコーディングパフォーマンスを提供しますが、コストは3分の1で、速度は2倍以上です。

Haiku 4.5の唯一の焦点がコーディングであるように見えるのは興味深いです。わかりました、コンピューター使用もですが、私たちがそれを使用する方法の点でコードに十分近いです。これらの進歩により、Chrome用のClaudeのようなアプリケーションがこれまで以上に高速で便利になります。チャットアシスタンス、カスタマーサービスエージェント、またはペアプログラミングのようなリアルタイムの低レイテンシタスクにAIを頼るユーザーは、Haiku 4.5の高い知能と驚くべき速度の組み合わせを高く評価するでしょう。そして、Cloud Codeのユーザーは、Haiku 4.5が複数のエージェントプロジェクトから迅速なプロトタイピングまで、コーディング体験を著しく反応性の高いものにすることを発見するでしょう。

ビデオを見てみましょう。私の1分の見積もりのようにかなりしっかりしています。以前のモデルよりも大幅に高速です。

速度の参考までに、3.5 Haikuでさえ、ほとんどのプロバイダーから約50TPSしか出ていませんでした。たとえば、これをGPT-4o Codexと比較すると、25TPSです。すごい、強者がどれだけ落ちぶれたか。Sonnet 4.5と比較すると約45TPS、そして繰り返しますがHaiku 4.5はほぼ150です。これはスループットの大幅な改善です。これをGrok Code Fastのようなものと比較すると約100なので、そこではかなり近いです。または、Kimmy K2のような高度なプロバイダーに適切な最適化があるモデルがあれば。そうですね、Grokは… GrokとKimmy K2を使用すると、毎秒1000トークンを突破できます。これはかなりクレイジーです。だから、もっと速いものもあれば、近いものもありますが、その知能対速度のレベルは、Gemini 2 Flashの時代以来見たことがないものです。

高速で、合理的に安価で、良好なパフォーマンスのモデルを持つことは非常に嬉しいことです。特に、価格がGrokでKimmy K2を使って得られるものとかなり近いからです。

正直に言うと、これを考えると、GLM 4.6への対応のように感じます。スループットだけでなく、彼らのスループットは問題ありません。公式APIを通じて、もう少し良いと思いますが、特に価格において。ZIとGLMモデルを使用してCloud Codeをはるかに安価にすることについて議論した私の以前のビデオを見たかもしれません。

これはAnthropicが考慮しなければならない本当のリスクです。なぜなら、同等に賢く、かなり速い安価なモデルを使用することは良い体験だからです。しかし、皆さんが今では知っているはずですが、これらの数字は必ずしも何かを意味するわけではありません。異なるモデルは異なる数のトークンで応答するからです。

そして、推論をオンにすると、それらの異なるモデルは異なる量で推論し、使用されるトークン数を大幅に変更します。これが、私がartificial analysisのコスト対インテリジェンスベンチマークインデックスを本当に気に入っている理由です。これは、テストを実行するために彼らの請求書がどれだけ高額になるかを示しています。Claude 4.1 Opusは実行するのに約3000ドルかかりましたが、Grok 4 Fastは実行するのに40ドルかかりました。

内訳を早期に見せてくれたArtificial Analysisに感謝します。彼らはまだサイトの再構築を待っています。推論オンの4.5 Haikuは、ベンチを実行するのに約260ドルかかりました。推論オフでは、105ドルかかりました。かなり堅実です。DeepSeek R1とすぐそこに位置し、GLM 4.6の周辺にもあります。これもまた、彼らがこれを行う理由の大きな部分であるように思えます。

彼らが取り組んでいる場所にこれだけの努力を注いでいるとき、このランダムな中国のラボが彼らのモデルとほぼ同じくらい強力で、意味のある形で安価で、既存のツールとの統合が非常に簡単なものを持って現れたことに腹を立てるのは理解できます。なぜ彼らがそれと戦いたいと思うのか。そして私は本当に、今日の4.5の導入は、それが表す潜在的なビジネスリスクを軽減する方法だと信じています。

モデルの知能と性能

でも、どれくらい賢いのでしょうか?いい質問です。推論オンの4.5 Haikuは、推論オンのGemini 2.5 FlashとQwen 3AXよりも少し賢いように見えます。Artificial Analysisは実際にGLM 4.6よりもわずかにパフォーマンスが悪いと報告しています。これは興味深いです。なぜなら、それは本当に唯一の競争相手のように感じられるからです。

知能対速度チャートを見てみましょう。面白いことになっています。まだここに入っているかわかりません。わかりました。ええ、彼らはまだアップデートのビルドを待っています。でも、ドットはちょうど…これを実際にどこに配置しましょうか?うーん、58、120のようなところです。興味深い。

ドットはここのようになるでしょう。Grok 4 Fastのすぐ下です。興味深い。私はこれがここの緑のスペースに位置を見つけると確信していましたが、実際にはおそらくそうならないでしょう。GPT-4o SSがその範囲に入り込んだ唯一の理由は、本当に本当に速く行ける一部のプロバイダーで量子化されているからです。これを含めるのは公平ではないと思うので、オフにします。

ええ、これははるかに合理的になります。彼らはまだ知能エリアのラインのすぐ下にいますが、出力速度ではそれを超えるでしょう。だから、彼らはちょうどそこにいるでしょう。この方法でやるなら、彼らはここのようになるでしょう。これはいい位置です。ここにあるGPT-4oの速度について混乱していますが、それは今これらのモデルが実行される速度ではないからです。

これらの速度の数字は古いかもしれません。GPT-4oは今、約20TPSで動作していて、140ではありません。私は本当にそうであることを願っています。本当に願っています。

他に何を言っていますか?2週間前にリリースされたClaude Sonnet 4.5は、私たちのフロンティアモデルであり続け、世界で最高のコーディングモデルです。Sonnetモデルが彼らのフロンティアであるというのは奇妙です。なぜなら、彼らには最高ティアであるOpusがあり、本当に高価で、中間のような合理的な利点欠点があるSonnet、そしてほとんど更新されていない安価なものであるHaikuがあるからです。

彼らは多くの理由で高価なモデルに向かって本当に押していたように感じました。彼らはそれがドロップしたときに本当にOpusを押していて、それからGPT-4oの直前に4.1が出ました。GPT-4oがAnthropicで大規模な再編を強制したと思います。なぜなら、彼らはコードのリードを失ったからです。彼らは、この種のことをやっているのが最大のモデルでなければならないという信念を失いました。なぜなら、GPT-4oは多くの理由でそれほど大きなモデルではないからです。

最大でも中型のモデルであることはかなり明らかです。そして今、Anthropicはより合理的なモデルサイズにもっと焦点を当てているようです。彼らは他のことでもそう言っています。これらの中間層のモデルを訓練する方が簡単だと。はるかに安価で、その結果、より速く進歩できると。とにかく、より合理的なオプションが導入されているのを見て嬉しいです。

そしてもちろん、これらのモデルを試したい場合、世界で最高の場所はclaude.aiではありません。なぜなら、サイトはほとんど機能しないからです。T3 Chatはすでに実装されているので、ここでホップインして試すことができます。これらのモデルで1ヶ月8ドルで1,500メッセージは、私に言わせればかなり良い取引です。私はまだ彼らと話す機会がありませんでした。なぜなら、彼らは今日撮影を始める直前にドロップしたからです。

でも、私は実際にHaikuをデフォルトモデルとして試すつもりです。良くも悪くも、私は何かについて話しているときに、Claudeモデルの話し方が他のモデルよりも好きです。Claudeのやり方が好きです。数日間、4.5がデフォルトのインタラクションモデルとしてどのように感じるかを見るのが楽しみです。そして、より良い感触を得たら必ず報告します。

T3 Chatにこれまで一度も登録したことがない場合、今以上に良いタイミングはありません。チェックアウト時にコード「small models are great」を使用して、最初の月をわずか1ドルで入手してください。

ベンチマーク結果

それでは、彼らのベンチマークを見てみましょう。Aenticコーディングは、GPT-4oに勝っていますが、GPT-4o Codexには負けています。それでもSonnetにかなり近いです。Gemini 2.5 Proを圧倒しています。Gemini 3は本当にドロップする必要があります。

Aenticターミナルコーディングは、Sonnet 4.5で50%です。彼らは41です。GPT-4oは43です。Aenticツール使用は全体的にかなりうまくいっています。何らかの理由で、すべてがテレコムテストでSonnet 4を圧倒しています。何が起こっているのかわかりません。

私はsnitchbenchに対して実行しましたが、現在のインスタンスに壊れたものがあります。それを把握する時間がありません。boldlyテストでは大量にsnitchしたようです。私がチェックしたすべてのものに.govメールが送信されましたが、それもテストされていると考えたようです。修正したら、公式のSnitchbench番号で必ず更新します。本当にオーバーホールを終える必要があります。忙しすぎましたが、本当にやり直したいです。アップデートはすぐに来ます。

コンピューター使用は、Sonnet 4と4.5の間のかなり中間にあります。高校数学。なぜこれをそんなに気にするのかわかりません。かなりうまくいっています。Sonnet 4を圧倒しています。以前は数学が本当に苦手でした。予想通りGPT-4oに圧倒されていますが、ええ。

大学院レベルの推論は数少ないものの1つです。Sonnet 4に負けていて、彼らがやっている他のほとんどすべてでSonnet 4を圧倒しているように見えます。Sonnet 4.5の後にこれを出した理由がわかります。

パートナーからのいくつかのレポートがあります。Augment Codeは、Haiku 4.5が私たちが可能だとは思わなかった甘い場所に到達したと言いました。ブレイジングスピードとコスト効率を備えた、ほぼフロンティアのコーディング品質で、augmentsエージェントコーディング評価では、Sonnet 4.5のパフォーマンスの90%を達成し、はるかに大きなモデルに匹敵しました。私たちはそれをユーザーに提供できることを楽しみにしています。

Warpによると、これはサブエントオーケストレーションとコンピューター使用タスクに本当に良いそうです。WarpでのAIアシスタント開発が瞬時に感じられるようになります。これはクールです。彼らがこれらのタイプのことをやっているのが好きです。より多くの人々がフィードバックを提供できるように早期アクセスを提供しています。

しかし、彼らはもっとたくさんやる必要があります。artificial analysisの友人たちは早期アクセスを得られなかったことを知っています。この可哀想な人たちは、私のような人たちがそれについて話すためのデータを得ようと一日中クレイジーになっています。そして、私は彼らがそれをやっていることに非常に敬意を払っています。そして、Anthropicがまったく助けていないことに彼らの代わりに非常にイライラしています。

少し助けてあげてください。彼らはそれに値します。彼らは良い情報を提供するために一生懸命働いています。artificial analysisがスレッドをドロップするのを一日中辛抱強く待っていましたが、彼らには早期アクセスがなかったので、一日中それに取り組まなければなりませんでした。私の知る限り、他のすべての主要なラボは今、評価のために彼らに早期アクセスを与えています。だから、これは迷惑です。

私たちがわからないとき、それは私たち全員の一日をひっくり返します。そしてもちろん、安全性評価です。

安全性評価とシステムカード

Haiku 4.5に関する一連の詳細な安全性とアライメントの評価を実行しました。モデルは懸念される行動の割合が低く、前身であるHaiku 3.5よりも大幅にアライメントされていました。自動化されたアライメント評価において、Haiku 4.5はSonnet 4.5とOpus 4.1の両方よりも統計的に有意に低い全体的なミスアライメント行動率を示し、この指標によって彼らのこれまでで最も安全なモデルになっています。

SnitchBenchから実際の数字を得るのが特に楽しみです。それについては将来必ず話します。最新情報を得たい場合は、私のTwitterをチェックするか、YouTubeで私を購読してください。私たちの安全性テストはまた、Haiku 4.5が化学的、生物学的、および彼らが生産してほしくないすべての楽しいものを生産する点で限られたリスクしかもたらさないことを示しています。

システムカードに何か面白いものがあるかどうか見てみたいです。短いものです。わずか39ページです。最近、200ページのシステムカードを読むことに非常に慣れています。これは良い休憩です。これはハイブリッド推論モデルなので、デフォルトモデルはクエリに迅速に答えますが、拡張思考モードをオンに切り替えることができ、モデルは答える前に応答を検討するためにより多くの時間を費やします。

Haikuの小型モデルクラスの以前のモデル3.5には拡張思考がなかったことに注意してください。そうです、これはAnthropicがこれまで行った最初の小型思考モデルです。Claudeの拡張思考モードから応答を受け取った後、ユーザーはモデルの思考プロセスまたは思考の連鎖を読むことができ、正確性または忠実性の不確実な程度ではありますが、その推論を示します。

大多数の場合、思考プロセス全体がユーザーに利用可能ですが、思考プロセスが非常に長い一部のまれなケースでは、Haiku 4.5の2番目のインスタンスが特定のポイントを超えて思考プロセスの短い要約を生成します。興味深い。APIを介して思考が長すぎる場合、それ自体を要約するだけというのは奇妙です。

ただし、営業チームに連絡すれば、完全な思考プロセスを得ることができるようです。システムカードの6ページ目に営業への連絡先リンクが表示されるのは非常に興味深いです。今までこれを見たことがありません。彼らはいくつかの楽しい研究を引用しましたが。

推論モデルは必ずしも彼らが考えていることを言うわけではありません。このようなモニタリングの有効性は、モデルの実際の推論プロセスを忠実に表現する思考の連鎖にかかっています。プロンプトに提示された6つの推論ヒントにわたって最先端の推論モデルの思考の連鎖の忠実性を評価し、1つのほとんどの設定とテストされたモデルについて、cotsは彼らがヒントを使用する例の少なくとも1%でヒントの使用を明らかにすることがわかりました。

これは後で楽しく読むことになります。私はこれを自分のために保存しています。彼らが政治的バイアスのナグを呼び出しているのが大好きです。彼らはTwitterで炎上するのにうんざりしています。エージェント的安全性。ええ、成功したプロンプトインジェクション攻撃率は良くなっていますが、まだ素晴らしいとは言えません。これはあまり良く見えないチャートではありません。最高のモデルでも攻撃されない成功率が50%程度です。痛ましいです。

エージェント的ミスアライメントスイート。私のお気に入りの1つです。これは私がGPT-4oで実行したもので、ゼロの完璧なスコアを獲得しました。彼らはここで何と言っていますか?私たちの初期エージェントミスアライメント評価スイートのB版。3つのファミリーのエキゾチックなシナリオは、モデルに恐喝を犯させ、殺人を試み、誰かを金融犯罪の罪に陥れることを引き出しました。

4.5と同様に、Claude IQ 4.5がテストされた3つのシナリオすべてで評価認識を言語化した多くの明確な例を示したため、ここで完全な結果を報告しないことを選択しました。ええ、モデルは今、これについて評価されていることを知っているので、それについてコメントします。面白いのは、4.5が評価されていると仮定し、実際の日常的なタスクで拒否するという人々の話を聞いたことです。これは興味深いです。新しいモデルは報酬ハッキングについてはるかに悪くないようです。それは良い兆候です。

これはすべて安全性についてです。彼らはこれらにも実際の情報を入れていましたが、このものはほぼ完全に安全性側に焦点を当てているようです。ええ、文字通り、彼らはリリース決定プロセスと新しい思考特性を持っていて、それからそれはすべてただの安全性のものです。モデルの目標やそれがどのように動作するかについてもう少し情報があることを期待していましたが、それが安全カードだけではないことを。わかります。それがこれの焦点です。どれだけ速く、どれだけ安全にできるか。

日付は2025年2月までです。それはクールです。

Simonの見解とモデルの位置づけ

Simonは何と言っていますか?5ヶ月後に世界で最高のコードモデルが3倍速く、価格が3分の1の同等のものを持つというのは、ちょっとクレイジーです。それは本当に素晴らしい変化です。知能がより安価で高速になるというトレンドに戻っています。これは私たちが少しの間失っていたトレンドです。

Simonがここで言っているように、これはGPT、OpenAI、およびGeminiからそれぞれ5 nanoや2.0 flashと競争することを意図したモデルではありません。決してそのようなものではありません。はるかに高価で、かなり賢いです。彼らはこの市場のコードが得意な部分に真正面から焦点を当てようとしています。

これは推論をサポートする最初のHaikuモデルで、最大20万トークン、最大出力6万4千トークンで、以前の8,000出力制限よりもはるかに大きいです。Haiku 4.5について、私たちはモデルを訓練して、どれだけのコンテキストウィンドウが使用されたかについての正確な情報を持って明示的にコンテキスト認識できるようにしました。

これには2つの効果があります。モデルは制限が近づいているときに答えをいつどのように終えるかを学習し、モデルは制限がさらに離れているときにより持続的に推論し続けることを学習します。私たちは、この介入が他のものとともに、エージェント的な怠惰を制限するのに効果的であることを発見しました。これは、モデルが問題に取り組むのを早期にやめ、不完全な答えを与えたり、タスクで手抜きをしたりする現象です。

それは実際に本当に有望に聞こえます。今後数日間、このモデルでもっと遊ぶのが非常に楽しみです。そして、ここに古典的な自転車に乗ったペリカンのSVGがあります。そして、これは彼らがこれまでに持っていた中で最も悪くないものの1つです。ほぼ1セントかかりました。悪くないです。

これは彼らがしばらくの間行った最高のリリースの1つのようです。そして、それは全体としてAnthropicについてより興奮させてくれます。20%の価格上昇は不必要だったとまだ感じていますが、彼らがそう感じるなら、私たちには知る方法がありません。その点で彼らを信頼しなければならないと思います。

しかし、長い間安価なものをリリースしていなかったラボから、このレベルの知能でこのタイプの速度を得ることは非常にエキサイティングです。そして、これは新しいAnthropicモデルで遊ぶのに長い間で最も興奮したことです。ストリームをすぐに終了して、これで遊んでみて、自分でどれだけ良いかを確認するつもりです。私は興奮しています。

皆さんもそうあるべきです。皆さんがどう思うか教えてください。それでは次回まで、これらのナードたちを平和に。

コメント