本動画は「AIはバブルだ」という主張に対し、実際のAI能力進化を示すデータで反論する内容である。非営利研究機関Meterが開発したベンチマークを軸に、AIが単独でこなせる実世界タスクの複雑さがおよそ7ヶ月ごとに倍増し、近年はさらに4ヶ月へと加速していることを示す。株価や投資家心理ではなく、物理的・技術的な能力曲線こそが重要であるとし、懐疑論者の主張が繰り返し外れてきた歴史的経緯も紹介。最終的には、AIの指数関数的進化がバブル崩壊ではなく、人類史上最大規模の変革の前夜であることを、複数のチャートと専門家の証言をもとに論じている。

- AIバブル論への反論——本当に起きていることとは

- Meterベンチマーク——AIが単独でこなせるタスクの規模

- ムーアの法則とAI版指数関数的成長

- 懐疑論者の予測は毎年外れてきた

- バブルか、それとも現実の進歩か

- AIが目指す未来——月単位・年単位のタスク処理へ

- AIの「ジャグド・フロンティア」——進歩は一様ではない

- S字カーブと指数関数的トレンド——ジャグドな進歩の構造

- あらゆる分野で同じ指数関数的トレンド

- AI研究者たちが夜も眠れない理由

- 自己改善するAI——すでに始まっている現実

- バブルの正体——懐疑論者の繰り返される誤り

- なぜ懐疑論者の声が説得力を持つのか

- AIアムネジア——人間は指数関数的変化を直感的に把握できない

- 進歩単位(DPU)と指数関数的加速の歴史

- 専門家予測の逆バイアスと指数関数的思考の欠如

- 人間の脳は直線思考に配線されている

- ズームレベルによって見え方が変わる——懐疑論者と楽観論者の違い

- 新しいパラダイムが次々と登場する——S字カーブの連鎖

- 知能の歪んだ認識——チンパンジーから神へ

- 計算能力の爆発とレイク・ミシガンの比喩

- キューバ危機との比較——制御できないAIへの警告

- ASI——人類史上最強の存在の誕生

AIバブル論への反論——本当に起きていることとは

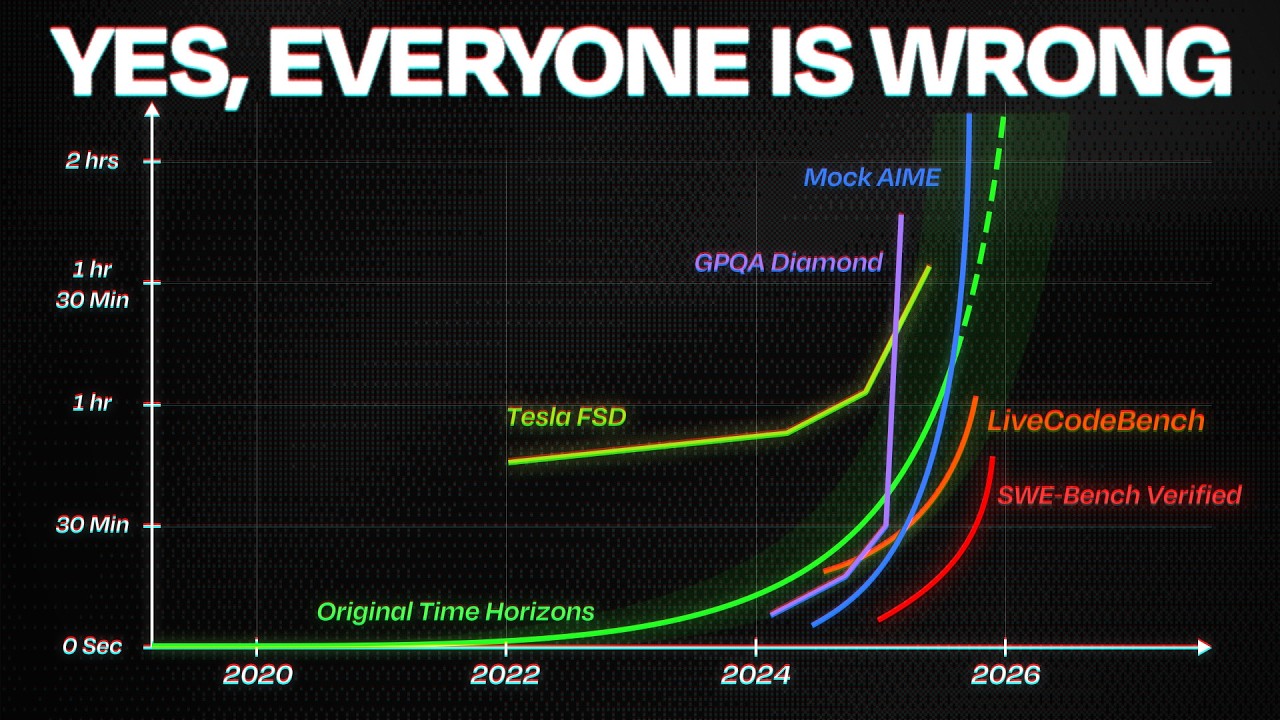

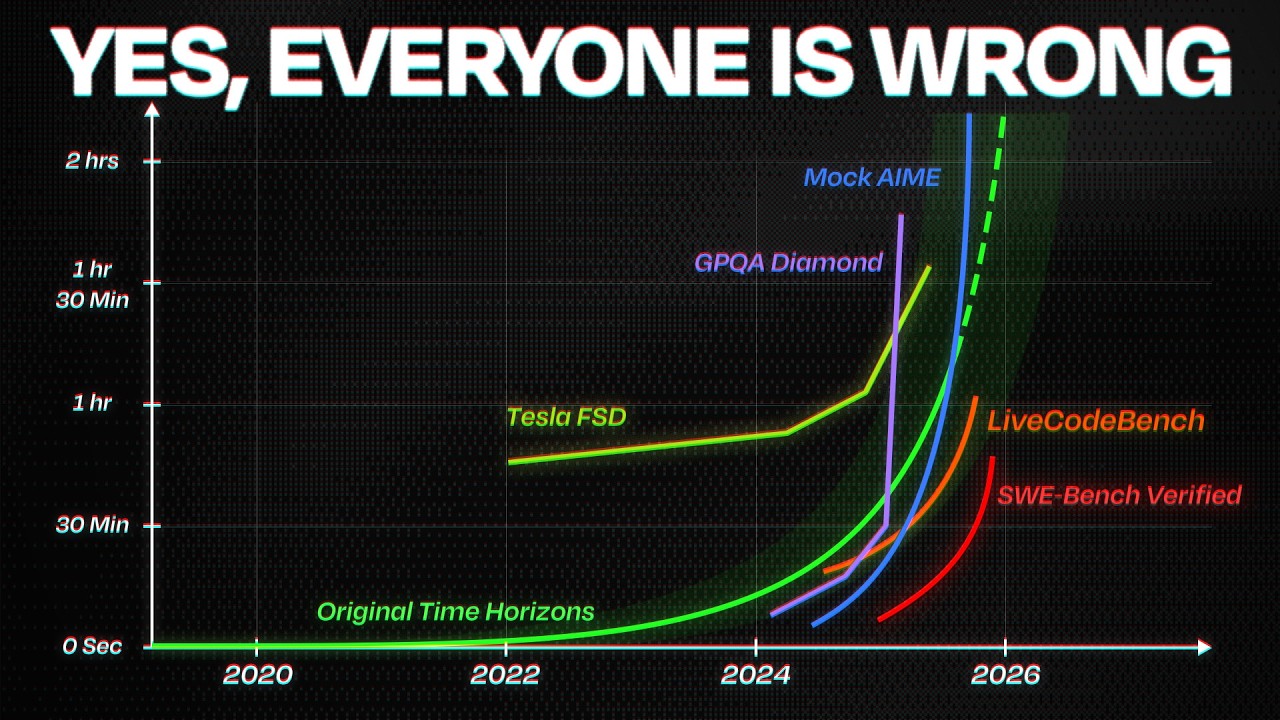

AIはバブルだと言われています。史上最大のバブルだとも。でも実際に起きていることは、それよりはるかに衝撃的なんです。それを理解するために、ぜひ見ておいてほしいチャートが一つあります。

これは、真剣にAIに向き合っている研究者たちが皆、釘付けになっているチャートです。株価とは一切関係なく、AIが実際に何をできるかだけを映したチャートです。

このグラフの一本の線を見て、希望を感じるAI研究者もいます。でも一方で、胃がよじれるような恐怖を覚える研究者もいる。これから何が起きるか、わかってしまっているからです。Meterという機関は今や、世界の株式市場が依存するほどの重要な存在になっています。

このチャートを含む、最も重要な8つのグラフをお見せしながら、「AIは本当にバブルなのか」という問いに答えていきます。

正直に言うと、ある意味ではバブル的な側面もあるかもしれません。でもこの動画を最後まで見れば、ほとんどの人が何も分かっていないこと、そして実際に起きていることがいかに重大かが、きっと伝わると思います。

Meterベンチマーク——AIが単独でこなせるタスクの規模

非営利研究機関Meterの研究者たちは、ある根本的な問いに答えようとしました。AIは現実の世界で、どれほど大きな仕事を完全に自力でこなせるのか、という問いです。誇張するためではなく、ただ測定するために。

AI企業はベンチマークをうまく操作して、自社のAIモデルを実際より強く見せようとすることがよくあります。でもこのベンチマークはそうはいきません。AIが実際にその仕事をこなせるかどうか、それだけが問われるからです。だからこそ、このベンチマークが重要なんです。いわば「AIがいつあなたの仕事を奪うか」を示す指標です。

研究者たちが発見したのは、衝撃的なトレンドでした。2020年、GPT-3ができたのはメールを書くことでした。15秒で終わるタスクです。それが1年前には、バグの修正ができるようになった。そして今では、AIはゼロからアプリ全体をコーディングできるようになっています。

AIが単独でこなせるタスクの複雑さは、わずか数ヶ月で2倍になりました。さらに数ヶ月後にはまた2倍、そしてまた2倍。2019年以来、おおよそ7ヶ月ごとに倍増し続けています。今日のAIは5年前と比べて、100倍長いタスクをこなせるようになっています。そしてさらに5年後には、1万倍規模のタスクを処理するようになるでしょう。

これだけでも十分に大きな話です。でも、次に何が起きるということを意味しているのでしょうか。

ムーアの法則とAI版指数関数的成長

ムーアの法則という言葉を聞いたことがあるでしょう。何十年もの間、テクノロジー分野で最も重要な法則のひとつとされてきました。簡単に言えば、コンピューターチップの性能が1年半から2年ごとに安定して2倍になるというものです。あなたのiPhoneは、1970年代にビル一棟分の部屋を占めていたコンピューター群よりも高い処理能力を持っています。これが指数関数的成長です。

そしてMeterは、AI版のムーアの法則を発見しました。しかも、オリジナルのムーアの法則より3倍速いんです。GPT-5.1は今や、熟練した人間が3時間以上かけて行う現実のソフトウェアエンジニアリング作業をこなせます。これは1年前の最高モデルと比べても3倍以上の進歩です。

ここで、未来の自分ドリューからお伝えします。実際には、このスクリプトを書き始めた頃よりもさらに速く進歩しています。Claude Opus 4.5はほぼ5時間分のタスクをこなせるようになっています。AIの進歩は今、7ヶ月ごとに倍増していた従来のトレンドラインから、4ヶ月ごとに倍増する、より速い新しいトレンドラインに乗っています。

懐疑論者の予測は毎年外れてきた

鈍化しているのではありません。逆です。2025年に入り、AIの改善スピードはさらに加速し始めています。AIは失速または停滞するだろうと自信満々に宣言していた懐疑論者たちは、毎年毎年そう言い続けてきましたが、何度も何度も外れ続けています。壁などありませんでした。数字はただ上がり続けています。

このトレンドが続けば、2026年にはAIが8時間連続のタスクをこなすようになります。これが重要なのは、それが人間の労働者にとっての丸一日の勤務時間と同じだからです。そして2028年には、1週間分のタスクへ。

では、それはあなたにとって何を意味するのでしょうか。AIエージェントが本当に1週間分のタスクをこなせるなら、経済全体にわたってホワイトカラーの仕事を代替できることになります。

バブルか、それとも現実の進歩か

では、このバブルはいつ弾けるのでしょうか。実はここが問題のポイントです。右肩上がりのグラフを見て、バブルだと思う人がいます。株式市場の暴落が待っていると。しかし株価は投資家の心理、ハイプ、恐怖、欲望を測るものです。人々が楽観的なときに上がり、現実が期待を裏切ったときに暴落する。でも技術カーブが測るのは現実です。感情ではありません。能力であり、物理的な現象です。

ムーアの法則は50年後も弾けませんでした。物理学がそれを許したから、チップの性能は倍増し続けたのです。Meterのトレンドが測っているのはハイプではありません。AIが実際に経済的価値のある仕事においてどれだけのことをこなせるかです。バブルは偽物を意味します。でもこれは偽物ではない。これは経済的価値のある作業における、本物の指数関数的進歩です。

AIが目指す未来——月単位・年単位のタスク処理へ

これが現在のAI企業の計画です。楽観的に言えば、彼らはあなたの仕事を奪うと主張しています。悲観的に言えば、世界を破壊するかもしれないと言っている。そしてそれだけでは終わりません。さらに進めば、月単位のタスク、そして年単位のタスクへ。自分の仕事で1年分の成果を、ほんの数日で達成できることを想像してみてください。AIエージェントは人間の100倍から200倍の速度で動きます。

私たちが1ヶ月かけてやることを、彼らは1時間でこなします。本を丸ごと数秒で読める。あなたはできますか?本を丸ごと1分で書ける。あなたはできますか?それが、あらゆることに当てはまると想像してみてください。AIから見た私たちは、まるで彫像のように動きが遅い存在です。

AIを3日間放置しておいたら、その間に人間が運営する会社が1年かけてやることを達成してしまったら、どうなるでしょうか。そして最も重要なのは、AIが急速に自己改善を始め、より強力なAIを作り始めたとき、何が起きるのか、ということです。AIがより強いAIを作るというのは仮説ではありません。すでに起きています。ただ、それはまた後で触れることにします。

AIの「ジャグド・フロンティア」——進歩は一様ではない

ここで、ほとんどの人がAIの進歩について誤解していることをお話しします。今お見せした指数関数的なカーブは本物です。でも、それは重要なことを隠しています。

AI の進歩はギザギザしているんです。どういう意味か説明しましょう。GPQAベンチマークを例に取ります。Googleで検索しても答えが出てこないような、博士レベルの問題です。1年前、AIモデルはこれらの問題の60%に答えられました。今では90%近くに達しています。大学院レベルの科学の問題で、人間の専門家自身よりも優れているということです。

でも同時に、AIはどんな人間もしないような恥ずかしいミスをまだ犯します。AI進歩否定論者たちはこのミスを取り上げるのが大好きです。しかし実際には、多くはすでに古い話で、現在は当てはまらないものも多い。「AIは手が描けない」とか「strawberryのrの数を数えられない」とかいった話です。ジャーナリストたちは常にこれに引っかかります。査読を通過するまでに数年かかってすでに時代遅れになった研究をもとに、「AIにまだできないこと」という記事を書き続けています。

読者はそういう見出しを見て、進歩が止まったと思います。でも止まっていません。

S字カーブと指数関数的トレンド——ジャグドな進歩の構造

ではこのパラドックスはどう説明できるでしょうか。5年前、GPT-3は遊び道具で、人間の仕事のタスクにはほぼ役に立ちませんでした。3年前、ChatGPTとGPT-4が登場し、マーケティングや基礎的なコーディングといった一部のタスクで人間を補助できるようになった。そして今、AIは「ジャグド・フロンティア」を持っています。驚くほど優秀なときもあれば、間抜けなときもある。

次のステップでは、AIは信じられないほど知的になりますが、なぜか明らかなことで失敗します。そしてこの進化のプロセスが重要な理由があります。AIの能力はすべてゼロから始まります。そして、より多くの計算資源、より多くのデータ、より良いアルゴリズムが加わることで、閾値を超え、突然それまでできなかったことができるようになる。能力は、不可能から信頼できるレベルへと、まるで一夜にして変わるように見えます。

これが、AIのゴッドファーザーたちや多くの研究者が、自分たちの発明が人類を文字通り絶滅させるかもしれないと恐れている理由です。計算能力をスケールアップするだけで、うまくいくからです。長い間、プロのAI懐疑論者たちは「スケーリングによる事前学習のパラダイムは死んだ」と言い続けてきました。つまり、より多くのテキストデータと計算能力を投入するだけでは、AIをどんどん賢くすることはできないという考えです。ある人物はこれを毎年繰り返し主張してきましたが、毎年繰り返し間違いを証明されてきました。

ジャグドなフロンティアはAIが限界に達していることを意味しません。計算量がスケールするにつれ、日々新たな能力が解放されていく様子を私たちが目撃していることを意味します。AIのゴッドファーザーたちは次に何が来るかを理解しています。私たちはもはや単なるツールを作っているのではない。制御できないかもしれない何かを作っているのです。

あらゆる分野で同じ指数関数的トレンド

でも、ほとんどの人が理解していないことがあります。Meterのグラフは例外ではありません。それがパターンなんです。チャートを見ても、見ても、見ても、同じ指数関数的なトレンドが現れます。物理学のベンチマーク、化学、生物学、数学、コーディング。測定できるほぼすべての分野で、AIの能力は4ヶ月から7ヶ月ごとに倍増しています。

少し立ち止まって考えてみてください。コーディングだけじゃない。すべてのことで、です。

でも懐疑論者は必ずこう問いかけます。指数関数的成長はいつまでも続かない。いつかは横ばいになるはずだと。そしてよく引き合いに出されるのが、赤ちゃんに関するあるミームです。私の3ヶ月の息子は生まれたときの2倍の大きさになった。このペースで行けば、10歳で7兆5000億ポンドになる計算だ、という話です。もちろんバカバカしい話で、成長曲線は平坦になります。ではなぜ、AIは違うと信じるべきなのでしょうか。

答えはこうです。赤ちゃんのミームはたった2つのデータポイントに基づいています。赤ちゃんの実際の成長曲線をズームインして見れば、すでに鈍化しているのがわかります。一方、Meterのトレンドは6年間にわたる15のデータポイントに基づいています。そして曲線は平坦化していません。それどころか加速しています。2024年から2025年にかけて、倍増時間は7ヶ月から4ヶ月へと短縮されました。これはムーアの法則よりもはるかに速い。

Gordon Mooreが自身の観察を発表したのは1965年で、ほんのわずかなデータポイントしかありませんでした。Meterには15のデータポイントがある。実際には、はるかにしっかりと裏付けられたトレンドです。問うべきは、指数関数的成長が起こりうるかどうかではありません。どこで止まるのか、です。

AI研究者たちが夜も眠れない理由

ここが、研究者たちが夜も眠れない部分です。2024年、研究者たちが数千人のAI科学者を対象に調査を行いました。平均して、AIが人類を絶滅させる可能性を16%と見積もっていました。6分の1、つまりロシアンルーレットの確率です。そしてAnthropicのCEO、Dario Amodeiは、AIが人類を絶滅させる可能性が25%にまで上昇したと述べています。

念のため言っておきますが、これはAI業界では珍しくない認識です。そして彼は単にハイプを作り出そうとしているわけでもありません。それは間違っています。彼はこれを認めることで批判を受けるばかりです。誰もこれを聞きたくないんです。彼は会社を始める前からこういったことを発言しています。

これは経済的インセンティブを持たない教授や科学者も含め、AI業界全体で広く共有されている信念です。幹部だけの話ではありません。考えてみてください。技術の発明者たちが、まだその技術を作り続けながら、それが人類を滅ぼすかもしれないと警告した歴史的事例が他にあるでしょうか。設計者が「空中爆発する確率25%」と言っている飛行機に乗りますか?しかもそれはあなただけでなく、全員が強制的に搭乗させられる飛行機なんです。

自己改善するAI——すでに始まっている現実

AIが月単位・年単位のコーディングタスクを自動化できるようになれば、AI研究そのものを自動化できるようになります。自己改善するAI。Sam Altmanはかつてこれを「本当に恐ろしい」と表現していました。手に負えなくなる可能性があるからです。しかし今、OpenAIは明示的にそこへ向かってレースを繰り広げています。MicrosoftのAI CEO、Mustafa Suleymanはこれを絶対にやってはいけないと言っています。絶滅を引き起こす可能性が高すぎると。

現在、AIのフロンティアにいる研究者は数千人しかいません。その数千人が、Meterのグラフで見た進歩を牽引してきました。しかしAIエージェントによって、彼らはすぐに100対1の比率で数を上回られる可能性があります。しかもそのAIエージェントは100倍速く動きます。

そしてAnthropicのCEO、Dario Amodeiは、ClaudeがAnthropicのコードの90%を書いていると述べています。彼が6ヶ月前にこれを予測したとき、嘲笑されました。AIはゼロから数年でコードのほとんどを書くまでになった。AIはすでにジュニアプログラマーを代替できるレベルのコードを書いています。Dario Amodeiは、エントリーレベルのホワイトカラー職の50%を近いうちに消滅させるかもしれないと考えています。シニア社員の代替が始まるまで、あとどれくらいでしょうか。

でも、こう聞かれるかもしれません。AIの進歩はいつか平坦化するはずじゃないか、すべての指数関数は実際にはシグモイドカーブだろう、と。そのとおりです。でも問題は、危険な閾値がどこにあるかわからないということです。ここかもしれないし、ここかもしれないし、ここかもしれない。私たちは霧の中でカーブを上っており、どの一歩が制御不能なシステムへとつながるか全くわかりません。

バブルの正体——懐疑論者の繰り返される誤り

これで最初の問いに戻ってきます。私たちはバブルの中にいるのでしょうか。奇妙なのはここです。過去5年間、数ヶ月ごとにAI懐疑論者たちは同じことを宣言してきました。今回こそ終わりだ、スケーリングは死んだ、バブルは今にも弾ける、と。

Yann LeCunはAIが基本的な物理の理解を欠くだろうと予測しました。こんなことを言っていました。私は根拠のある知性を信じている。テキストだけからマシンを知的に訓練できるとは思わない。例えば、物を机の上に置いて机を押せば、物も一緒に動くのは明らかですよね?これを説明するテキストは世界中のどこにもないと思う。だからGPT-5000がどれほど強力でも、これを学ぶことはないだろう、と。

しかしわずか1年後、GPT-3.5はこれを正確に説明できるようになっていました。彼が自信を持って「絶対に起きない」と言ったことが、その1年後に現実になっていたわけです。Yannの主張の多くは、AIは自律性を持たないため危険ではない、スーパースマートで従順な部下のようなものだという前提に基づいています。基本的に、AIは長期的な計画を立てたり自己主導したりする能力を持たないだろうというわけです。

そして今、AIがどれだけ自律性を増してきているかがわかるベンチマークがあります。

なぜ懐疑論者の声が説得力を持つのか

懐疑論者がなぜ説得力を持つのか、理由があります。世界を変える技術について話すとき、懐疑論者は常により合理的に聞こえるからです。一方は「これがすべてを変える」と言い、他方は「そんなまさか、何も起きないよ。モデルを大きくするだけで永遠に賢くなり続けるわけがない。限界があるはずだ」と言う。後者の言葉は理性的に、地に足がついているように聞こえます。でも、それは証拠ではありません。感覚、つまりバイブです。

では実際の実績を見てみましょう。Gary MarcusやYann LeCunといった人物は、2019年からスケーリングの終焉を予測してきました。ほぼ毎年、「ついに壁にぶつかった」と言い続けています。毎年、外れています。「とにかく大きくする」というアプローチは15桁の大きさにわたって機能してきました。これはテクノロジーの歴史の中で最も一貫したトレンドのひとつです。数年ごとに「ニューラルネットは誇大宣伝で、全部崩れ落ちる」と言い続けてきた人たちがいて、毎回外れてきた。これからも外れ続けると思います。

AIはウェブサイト全体をゼロからコーディングし、ヒット曲を書き、アート競技で優勝しています。でも多くの人が引っかかるのは、まだミスをするという点です。例えば、「AIは音楽チューリングテストに合格した」という論文が出ても、メディアの報道はゼロ。でも「ここ4週間、毎週新しいAI生成作品がビルボードチャートにデビューしている」という見出しは出ています。

AIアムネジア——人間は指数関数的変化を直感的に把握できない

6ヶ月経っても自分の仕事の流れに革命的な変化がなかったと感じると、「ほら、横ばいになってる。バブルが弾けてる」と言い出す人がいます。これはAIアムネジアです。ほんの数ヶ月・数年前、これらのシステムがいかに限定的だったかを、私たちは思い出すことができないのです。

2年前、モデルが小学校の算数をやれるようになるとは想像しがたかった。最も基本的な問題も解けなかった。実際、衝撃的なほどの限界がありました。みんな忘れているんです。2020年の専門家にAIが今できることを全部話したら、笑い飛ばされたでしょう。純粋なサイエンスフィクションとして。今ではそれが当たり前になっている。当たり前になったから、進歩が止まったと思い込む。でもデータは違う話をしています。

AIは鈍化していない、加速しているんです。でもトレンドラインを追い続けていれば、私たちが今どこへ向かっているか予測できたはずです。10年前、ChatGPTが存在する前、Tim Urbanは今日の私たちの状況を予測する記事を書いていました。その記事を読んだ後にNvidiaに3000ドル投資していたら、今頃百万長者になっていたでしょう。

進歩単位(DPU)と指数関数的加速の歴史

Tim Urbanはあるグラフから話を始めました。時間軸での人類の進歩のグラフです。ここに立っているのはどんな感じだろう?すごいですよね。指数関数的カーブの急な部分に立っている。でもここが重要です。時間軸のグラフにいるとき、右側に何があるかは実際には見えません。だから実際の感覚はこうなんです。普通。完全に普通。

Tim Urbanはある思考実験でこれを説明しています。1750年のジョージ・ワシントンを2025年に連れてきたとしましょう。1750年はそれほど昔ではありません、265年前です。すべてが暗闇の中でした。電気もなかった、電球もなかった、馬以外の移動手段もなかった。今日の素晴らしいものは何も存在しなかった。だから彼をここに連れてきて、高速道路を走る車を見せ、インターネットを見せ、iPhoneを見せ、国際宇宙ステーションの話をし、相対性理論の話をし、飛行機の話をする……話は尽きません。これはあまりにも大きな衝撃で、ただ驚くとか仰天するとかいうレベルではなく、死んでしまうんじゃないかと思います。

どれくらい未来に行けば、その進歩の大きさに驚いて死ぬでしょうか。これを「進歩単位(DPU: Die Progress Unit)」と呼んでいます。

でもジョージ・ワシントンが嫉妬して、自分も同じことをしようとしたとしましょう。過去の誰かを自分の時代に連れてきて驚かせようとする。彼は言います、タイムマシンを使って、1500年のダ・ヴィンチを連れてきてやろう、と。ダ・ヴィンチは1500年に48歳でした。同じくらい驚かせてやれるかもしれない。望遠鏡など、宇宙や物理に関する話は確かに驚くでしょう。でも死ぬほどではないと思います。

ワシントンが1750年に連れてきて死ぬほど驚かせたい相手を探すには、農業革命以前、つまり1万2000年前まで遡る必要があります。その頃は都市もなく、大きな集団もなかった。そこから誰かを1715年に連れてきて、そびえ立つ教会や大洋を渡る船を見せたら、その人は倒れて死んでしまうかもしれない。

つまり、そこまでさかのぼって初めて1つのDPUになる。そして1万2000年前の人を驚かせるには、さらに火と言語を発見する前の10万年前まで遡る必要があります。

狩猟採集民の時代、最初のDPUは10万年以上かかりました。農業革命の時代は1万年以上。産業革命の時代は250年。そのトレンドに従えば、次のDPUはわずか10年から20年後かもしれません。

専門家予測の逆バイアスと指数関数的思考の欠如

そう聞くと、テックCEOたちはいつもハイプを作り出そうとしているだけだ、と思う人もいるでしょう。それは理解できます。CEOたちが確かにハイプを作ろうとすることはあります。でも奇妙なのはここです。AIの専門家たちはハイプの問題を持っていません。むしろ正反対の問題を持っています。

信じられないことに、ほとんどのAI専門家は逆方向に外れ続けるという、ひどい予測の実績を持っています。何度も何度も何度も、進歩が少なすぎる方向に外れ続けてきました。これは非常に奇妙なことです。他のあらゆる業界では、専門家は進歩を過大予測して失望します。でもAIでは逆なんです。

なぜ賢い人たちまでAIの予測を外し続けるのでしょうか。主な理由は、人間が直線的に考えるように配線されているからです。私たちの脳は文字通り、21世紀に起きているような指数関数的進歩を理解するようには進化していません。

人間の脳は直線思考に配線されている

もう一度、人類の進歩グラフを見てみましょう。次の30年の進歩を想像するとき、私たちは過去の30年の進歩を指標として見ます。21世紀に世界がどれだけ変わるかを考えるとき、20世紀の進歩をそのまま2000年に加算するわけです。これはジョージ・ワシントンがダ・ヴィンチを1700年代に連れてくるときに犯したのと同じ間違いです。等しい時間間隔が等しい進歩を意味すると思い込んでいた。

線形的に考えてしまうのが私たちには最も直感的です。本来は指数関数的に考えるべきなのに。もし少し頭を使って、過去30年ではなく現在の進歩速度をもとに次の30年を予測したとしても、より正確にはなりますが、それでも大幅に外れるでしょう。

将来を正確に考えるためには、今よりもはるかに速いペースで物事が動くと想像する必要があります。

そしてこのチャートは、実は想像より悪い状況を示しています。ほとんどの人の直感はここに示した紫のラインに近い。これがAIが私たちを驚かせ続ける理由です。「AIは横ばいになっている」という記事が外れ続ける理由です。私たちは指数関数的変化を把握するように作られていません。そしてAIの進歩は指数関数的なのです。

ズームレベルによって見え方が変わる——懐疑論者と楽観論者の違い

AIの進歩に関する評価が「すごい進歩だ、私たちは戻ってきた」から「もう終わりだ」へと振り子のように揺れる理由は何でしょうか。同じデータを見て、正反対の結論に達してしまう。これはすべてズームレベルの問題です。

先ほどのグラフを覚えていますか?簡略版を見ると、指数関数的に見えます。右肩上がりのなめらかなカーブ。でも曲線が指数関数的に見えるかどうかは、どこから見るかによって全く変わります。

ズームインしてみましょう。今度は平坦に見えます、線形、場合によっては下降にすら見えます。これが懐疑論者の住んでいる場所です。週単位・月単位の変化を見て、トレンドが崩れたと宣言する。1996年に2029年までにAGIが実現すると予測した伝説的な未来学者Ray Kurzweilはこう説明しています。

すべての指数関数的グラフは実際にはS字カーブで構成されている。S字は、新しいパラダイムが世界を席巻するときの進歩の波によって生まれる。このカーブは3つのフェーズを経ます。緩やかな成長(指数関数的成長の初期フェーズ)、急速な成長(指数関数的成長の後期爆発フェーズ)、そしてそのパラダイムが成熟するにつれての横ばいです。

新しいパラダイムが次々と登場する——S字カーブの連鎖

実際に起きていることはこういうことです。単一のS字カーブをズームインして見ていると、それが平坦化するのが見えます。GPT-4が登場して大きな飛躍を見せ、その後改善が鈍化する。懐疑論者は勝利宣言します、「スケーリングは死んだ」と。でもズームアウトすると、全体のトレンドはまだ指数関数的です。新しいパラダイムが次々と登場するからです。GPT-4が横ばいになると、推論モデルが突破口を開く。Transformerが横ばいになると、マルチモーダルモデルが登場する。一つのS字カーブが平坦化すると、別のものが始まる。

平坦化は数ヶ月、場合によっては1年続くかもしれません。でもそれは指数関数的軌道を変えません。それがただ、指数関数的成長のカーブをズームインしたときの見た目なんです。懐疑論者は個々のS字カーブが平坦化するのを見ている。一方、他の人たちは何十もののS字カーブが積み重なってできた指数関数的トレンドを見ている。そしてこれが振り子が揺れ続ける理由です。

歴史に学べば、平坦化は長続きしません。

知能の歪んだ認識——チンパンジーから神へ

これらのAI企業の究極の目標が再帰的自己改善、つまり自分自身を改善できるAIシステムであることは本当に驚異的です。もし成功すれば、人間と超知的AIとの差は、人間とアリの差よりも大きくなるでしょう。

知能に対する私たちの歪んだ認識を見てみましょう。少し前、ChatGPT以前、AIはチンパンジーよりも賢くありませんでした。ホットドッグの識別すら確実にできなかった。私たちは笑っていました。かわいい、ロボットが猿のマネをしてる、と。でも今やAIは新しい物理法則を発見しています。これは本当の話です。リンクは概要欄に。でも覚えておいてください、知能はジャグドです。だからこそMeterのグラフが重要なんです。

より正確な見方はこうです。池に睡蓮の葉が1枚あって、毎日2倍に増えるとします。30日後、池は睡蓮の葉で完全に覆われます。何日目に池の半分が埋まるでしょうか?15日目だと思いましたか?実は29日目です。そう、終わりのたった1日前まで、池は半分しか埋まっていない。

ここで重要な教訓があります。進歩はほとんど起きていないように見えて、突然瞬きをしたら池が満タンになっている、ということです。AIについて、私たちは今何日目にいるのでしょうか。

計算能力の爆発とレイク・ミシガンの比喩

別の視覚化をしてみましょう。コンピューターが人間の脳の計算能力に匹敵するまでどのくらいかかるか、という問題です。レイク・ミシガンの水量はオンスで表すと、ほぼ人間の脳の1秒あたりの計算回数と同じです。ムーアの法則通りに18ヶ月ごとに計算能力が倍増するとしたら、どうなるか見てみましょう。

湖はずっと空に見えます。そして突然、完全に満タンになる。つまり、人間の脳と同じコンピュータ処理能力に達したということです。現在、私たちはこの動画の最後の数秒にいます。これが指数関数的成長です。ゆっくり、そして突然、一気に。

私たちは自分たちよりどんどん賢いマシンを作る軌道に乗っています。そしていつかは、彼らが私たちよりも賢くなる日が来る。そしてその時、彼らは自分たちの自律性と目標を持ち、それが私たちのものとは合致しないかもしれない。その時、私たちはどうなるのでしょうか。消えてしまうのでしょうか。

キューバ危機との比較——制御できないAIへの警告

Eliezer Yudkowskyはこれをキューバ危機に例えます。フルシチョフとケネディはハシゴを登っているのをわかっていました。どの段で核戦争が始まるかはわからなかったが、登り続ければいつか数億人が死ぬことに繋がるとわかっていた。ケネディは後に、全面核戦争の確率を3分の1から2分の1と見積もっていました。

私自身のような科学者の警告にもかかわらず、私たちは霧の中を盲目的に突き進んでいます。この軌道が制御の喪失につながるかもしれないという警告を無視して。暗闇の中でハシゴを登っていて、どの段が消滅に繋がるかわからないときの唯一合理的な反応は、登るのをやめることです。

核の場合と同様に、どの段が制御できないスーパーインテリジェンスにつながるかわかりません。だから、わかる前に登るのをやめた方がいいかもしれません。

たった5年前、AI科学者たちはAGIの実現まで25年かかると予測していました。しかし科学者たちが2040年に達成されると予測していた進歩がすでに起きています。しかし恐ろしいのはスピードだけではありません。AIが何になりうるか、そのスコープです。スーパーインテリジェンスは私たちが遠くからでも把握できるものではありません。

IQ85が知的能力の低い方で、135が非常に賢い方とします。12,573という数字には、私たちには対応する言葉すら存在しません。それが何なのかわからない。私たちがそれを理解しようとするのは、マルハナバチがケインズ経済学を理解しようとするようなものです。

知性のレベルを階段として想像してみましょう。たった1段上がるだけでも巨大な差があります。2段上がれば、チンパンジーと人間の差を超えます。でも再帰的自己改善による知性爆発が始まれば、その階段ははるか高くまで続いています。

ASI——人類史上最強の存在の誕生

Tim Urbanが言うように、ASIが何をするか、あるいはそれが私たちにとって何を意味するか、知る方法はありません。そうでないと主張する人は、スーパーインテリジェンスが何を意味するかを理解していません。

では何がわかるのか。わかることは、地球上での人類の絶対的な支配が一つの明確なルールを示しているということです。知性には力が伴う。つまり、私たちがASIを作ったとき、それは地球の生命史上最強の存在となるでしょう。そして人間を含むすべての生命体は、完全にその意のままになります。私たちの観点からすれば、ASIが誕生した瞬間、地球に全能の神が現れたということになります。

そして私たちにとって最も重大な問いは、それが優しい神であるかどうか、です。

スーパーインテリジェンスが実際に何をするかの現実的なシナリオを見たい方は、次のこの動画をご覧ください。トップのAI研究者たちによる深いリサーチと脚本に基づいています。私はドリューです。最後まで見ていただきありがとうございました。スーパーインテリジェンスが実際に何をするかの現実的なシナリオを見たい方は、次のこの動画をご覧ください。トップのAI研究者たちによる深いリサーチと脚本に基づいています。私はドリューです。最後まで見ていただきありがとうございました。

コメント