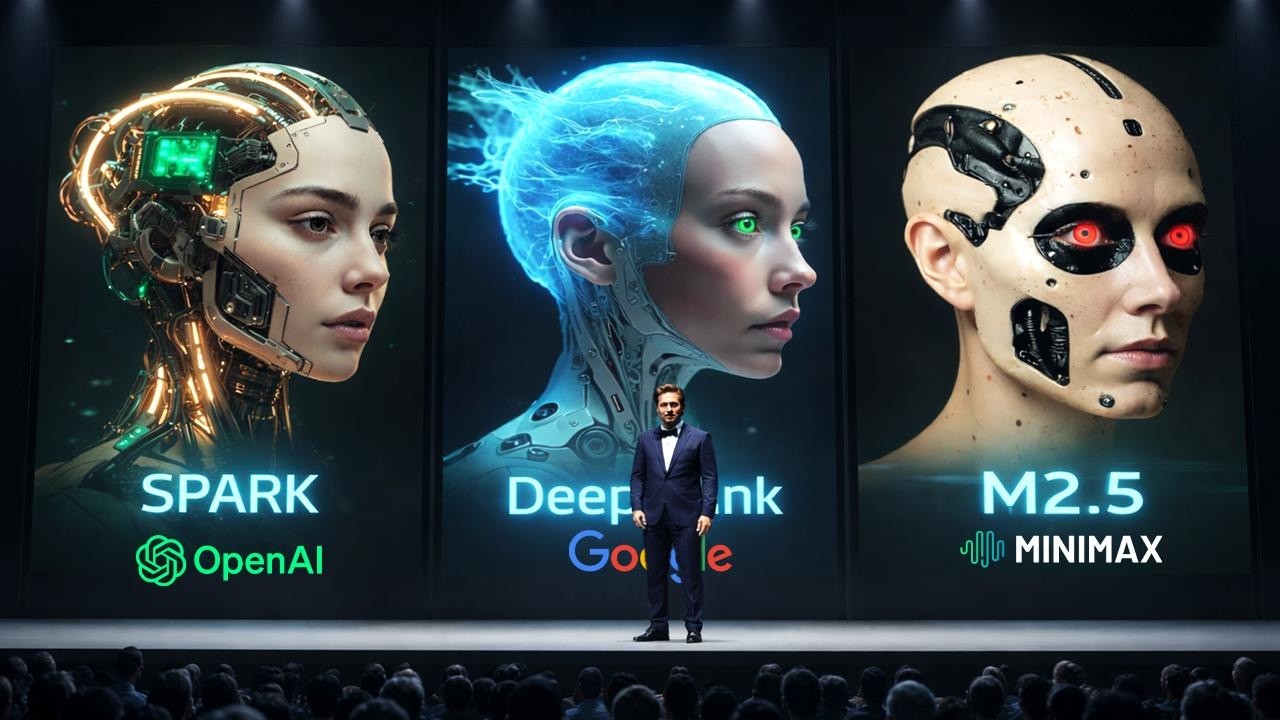

OpenAIのGPT-5.3 Codex Spark、GoogleのGemini 3 DeepThink、MiniMaxのM2.5という3つの強力なAIモデルが同時に発表された。Sparkはリアルタイムコーディングに特化し、Cerebrasのウェハスケールエンジン3上で高速推論を実現する。DeepThinkは科学・研究・エンジニアリング向けの深い推論能力を提供し、テスト時計算によって信頼性を高めている。M2.5は低コストで常時稼働可能なエージェント機能を売りにし、強化学習によって実世界タスクに最適化されている。これら3つのアプローチは、ソフトウェア開発の未来における速度・深度・経済性という異なる価値軸を示しており、AI支援開発の本格的な転換点を迎えたことを示唆している。

3つの強力なAIモデルが同時に登場

OpenAIはCerebrasのハードウェア上で動作するGPT-5.3 Codex Sparkをリアルタイムコーディング向けに発表しました。GoogleはGemini 3 DeepThinkに本格的な推論能力とスケッチから3D作成機能を追加しました。そしてMiniMaxは、一日中稼働できるほど安価なエージェント性能を持つM2.5を発表しました。

高速コーディング、深い思考、そして常時稼働のAIエージェント、これらすべてが一度に登場したのです。これはソフトウェアの構築方法における本当の転換点のように感じられます。では、詳しく見ていきましょう。

OpenAI Codex Sparkのリアルタイム推論

まずはOpenAIから始めましょう。Codexは2つの非常に異なる種類の作業に向かって進化してきました。1つは長期ミッションで、エージェントが計画を立て、ツールを実行し、複数ファイルにわたるタスクをこなし、しばらく作業を続けられるものです。

もう1つは密接なリアルタイムループで、コードを書き、ロジックを調整し、インターフェースを磨いている間、アシスタントがあなたのペースについてきてほしいという場合です。Codex Sparkはこの2番目のモードのために作られました。

OpenAIはこれをGPT-5.3 Codexの小型版で、高速推論のためにチューニングされたものと説明しています。つまり、ほぼ瞬時に感じられるということです。普通の言葉で言えば、このモデルはフロー状態を維持できるほど素早く応答するように設計されているということです。

関数を投げれば編集してくれます。リファクタリングを頼めばロジックを再構築してくれます。UIコンポーネントを調整すればクリーンなパッチを提供してくれます。ポイントは勢いです。

そして最も重要なのは、その勢いをどのように動かしているかです。SparkはCerebrasのWafer Scale Engine 3、つまりWSE3上で動作します。GPUがほとんどのAI推論が動作する標準的なエンジンだとすれば、Cerebrasは直線スピードのために作られた特殊なドラッグレースカーのようなものです。

WSE3はウェハスケールチップで、従来の小型チップアプローチではなく、巨大なシリコン片を中心に構築されており、4兆個のトランジスタが詰め込まれています。

OpenAIはSparkを、100億ドル以上の価値がある複数年契約として発表されたCerebrasとのパートナーシップにおける最初のマイルストーンと呼んでいます。これはカジュアルなサイドクエストではありません。これは異なる体験のために異なるハードウェアが存在する混合コンピュート未来への真剣な賭けです。

GPUは幅広い使用の基盤として残ります。なぜなら、多くの人に大量のトークンを提供する最もコスト効率の良い方法だからです。Cerebrasは、インタラクションを即座に感じさせることを目標とする、レイテンシ優先の階層になります。

速度はモデルだけではない

そして、ほとんどの人が思っている以上に重要な詳細があります。速度は決してモデルだけではありません。時々速く感じたり遅く感じたりするAIツールを使ったことがあれば、その多くはモデルの周辺のすべてから来ています。

ネットワークオーバーヘッド、セッション設定時間、最初のトークンまでの時間、ストリーミング動作、これらすべてが摩擦を加えます。OpenAIは、Sparkがリクエスト-レスポンスパイプライン全体を引き締めることを強いたと述べています。

彼らは、クライアントからサーバーへ、そして戻る際のレスポンスの動きを合理化し、推論スタックの一部を書き直し、最初のトークンがより早く表示されるようにセッション初期化を改善し、イテレーション中にインタラクションが応答性を保つように永続的なWebSocket接続を使用したと述べています。

最終結果は、より速い頭脳だけでなく、より密接なループのように感じられるはずです。

能力面では、Sparkは最大で最強ではなく、小型で高速であることを意図しています。128kのコンテキストウィンドウを搭載し、現時点ではテキストのみです。リサーチプレビュー期間中は独自のレート制限があり、使用量は標準のレート制限にカウントされません。これは基本的に、遊んでストレステストして、人々がリアルタイムコーディングをどう使うか教えてくださいという意味です。

Chat GPT Proユーザー向けにCodexアプリ内、さらにCLIとVS Code拡張機能で展開されています。これは完璧です。なぜなら、開発者が実際に作業する3つの主要な場所をカバーしているからです。

OpenAIはまた、ベンチマークコンテキストでトレードオフを裏付けています。Terminal Bench 2.0では、Sparkは58.4%で、フルGPT-5.3 Codexは77.3%、GPT-5.1 Codex Miniは46.1%です。

このギャップがポイントです。Sparkは速度と応答性を得るために、いくらかの生の力を犠牲にしています。そして、素早い編集と迅速な反復を行っているとき、そのトレードオフはしばしば勝利のように感じられます。なぜなら、モデルに大規模なエンジニアリングマラソンを解決するよう求めているのではなく、数十の小さなステップを素早く進むのを助けてくれるよう求めているからです。

したがって、Codex Sparkの本当の物語はこうです。OpenAIは、レイテンシが知性とほぼ同じくらい重要なリアルタイムコーディングの道を切り開いています。そして、それを専用ハードウェアとパイプライン最適化と組み合わせて、ループを機敏に感じさせています。

Higsfieldによる統合型AI動画制作プラットフォーム

さて、その同じ勢いがAI動画の実際の作り方を再形成しています。Higsfieldが本日の動画をスポンサーしており、彼らは最も急成長しているクリエイター向けAI制作プラットフォームの1つを構築しました。単なるプロンプトボックスではなく、本物のスタジオワークフローのように感じられるように設計されています。

Higsfieldに着陸すると、すべてが動画が実際にどのように作られるかを中心に構造化されています。アイデアから始め、ショットを形作り、1つの接続されたパイプライン内で生成し洗練させます。スクリプト、ビジュアル、編集のために異なるAIツール間を行き来する代わりに、プロジェクト全体がコンセプトからエクスポートまで1つの場所に留まります。

そのクリエイター優先のセットアップが、プラットフォームを本当に際立たせているものです。特に、単なる素早いテストクリップ以上のものを制作しようとしている場合はそうです。彼らはすでに最新かつ最強のAI動画モデルの多くをホストしており、最新の追加はKling 3.0です。これは今最も印象的な動画モデルの1つです。

Higsfieldのワークフロー内では、スクリプト、参照、オーディオディレクションがすべて1つの構造生成プロセスに流れ込むため、シーンが自然に流れ、カメラの動きが意味をなし、キャラクターやオブジェクトがショットからショットへ一貫性を保ちます。

実際には、プロジェクトを開き、短いスクリプトやアイデアを入れ、シーンをマッピングし、動画を生成し、タイミングやビジュアルを調整し、ソーシャル広告やストーリーテリングに対応したものをエクスポートします。AI映画制作に真剣に取り組んでいるなら、確実にチェックする価値があります。リンクは説明欄にあります。

Google Gemini 3 DeepThinkの深い推論能力

さて、動画に戻りましょう。Googleにスライドすると、Gemini 3 DeepThinkは基本的に別の極端です。GoogleはDeepThinkを専門的な推論モードと呼び、このアップグレードは科学、研究、エンジニアリングにおける実用的な使用を中心に組み立てられています。

つまり、雰囲気は「より良くチャットする」ではなく「現代の課題を解決する」です。彼らは科学者や研究者と協力することについて語り、重要なアイデアは、データが不完全に見え、制約があいまいに感じられ、解決への道に多くの不確実性がある問題を扱うことです。

これはまさに、通常のモデルが漂流したり、過度に自信を持ったり、詳細を見失ったりする種類の作業です。そしてGoogleがスコアボードを持って登場します。

DeepThinkは、ツールなしでHumanity’s Last Examで48.4%、Arc Prize Foundationによって検証されたARC AGI 2で84.6%、Code Forcesで3,455 ELO、そして国際数学オリンピック2025で金メダルレベルのパフォーマンスでハイライトされています。

これらは4つの異なる聴衆を狙った4つの異なるアピールです。HLEで幅広いフロンティア推論の人々、ARC AGI2で一般化ファン、Code Forcesでハードコアコーディングの人々、そしてIMOで数学純粋主義者です。

ベンチマーク数字は抽象的に感じられることがあります。では、具体的な翻訳をしましょう。Code Forces ELOは競技プログラミングのシグナルです。高いELOは、強力なアルゴリズム思考、制約の下で正しい解決策を構築すること、トリッキーなエッジケースを処理すること、そしてエリートプログラマーに近い方法でランタイムを最適化することを意味します。

ARC AGI 2は異なる味わいで、例から規則を学び、新しいパズルに適用するようなものです。人々が気にするのは、単なるパターン再生ではなく、適応可能な推論を示唆しているからです。

Googleはまた、テスト時計算に傾倒しています。これは基本的に推論中にモデルにより多くの思考予算を与え、答える前に内部でステップを検証し、悪い経路を剪定できるようにするものです。これは大きな意味があります。なぜなら、モデルが強くなるにつれて、信頼性が本当の製品機能になるからです。

特にドメインが科学、エンジニアリング、または小さなミスが高くつくものである場合、自信に満ちた間違った答えを減らしたいのです。

そして、これを主流の頭脳にクリックさせるデモがあります。スケッチから3Dプリンティングです。主張は、何かを描けば、DeepThinkが描画を分析し、形状をモデル化し、ファイルを生成し、それをプリントできるというものです。

これは推論と実世界の出力の間のクリーンな橋渡しです。そして、Googleが「実用的なアプリケーション」というフレーズを使用している理由も示しています。単にパズルを解くだけではありません。あいまいな人間の入力を受け取り、コードを通じて具体的な成果物に変えるのです。

可用性の面では、このアップグレードされたDeepThinkは、Google AI Ultraサブスクライバー向けのGeminiアプリに表示され、エンタープライズ向けの早期アクセスパスを持つGemini APIを通じても提供されます。したがって、パワーユーザーと本格的なワークフローを対象とした、プレミアムで高機能な推論モードとして位置づけられています。

MiniMax M2.5の破壊的な経済性

さて、MiniMaxは正直なところ最も破壊的な第3の角度、つまり経済性を持って登場します。M2.5の物語は、Sparkのように速くも、DeepThinkのように深くもありません。それは、エージェントを常時実行する余裕ができたときに実用的になるというものです。

MiniMaxはM2.5を、数十万の実世界環境にわたって強化学習で大量にトレーニングされたモデルとして紹介し、コーディング、エージェント的ツール使用、検索、オフィス作業、その他の高価値タスクに長けていると宣伝しています。

彼らはSWE bench verifiedで80.2%、multiSWE benchで51.3%、コンテキスト管理を伴うbrowse compで76.3%を引用しています。そして彼らは速度も押し出しています。SWE bench verifiedはM2.1より37%速く完了し、エンドツーエンドのランタイムはClaude Opus 4.6とほぼ同じ範囲です。

しかし、彼らが最も強く押し出しているのはコストです。彼らは基本的に、コストを心配することは消えるべきだと言っています。見出しは、100トークン/秒で約1ドルで1時間連続してモデルを実行できるというものです。そして50トークン/秒では、約30セントに下がります。

これはエージェントビルダー向けに構築された価格設定の物語です。なぜなら、エージェントはリトライ、探索、ツール呼び出し、そして「もう一度、より良く」ループを必要とするからです。そして、これらのループは、実行ごとに高価に感じられると、すぐに苦痛になります。

MiniMaxはまた、M2.5とM2.5 Lightningという2つのバージョンをリリースしています。同じ能力、異なる速度で、両方ともキャッシングをサポートしています。Lightningは100トークン/秒のスループットで、公表されたトークン価格は入力100万トークンあたり0.3ドル、出力100万トークンあたり2.4ドルですが、遅い方はその半分のコストです。

平易な言葉で言えば、彼らは安価で、速く、常時稼働の領域を支配しようとしています。

そして、実際に重要な行動の主張がそこにあります。M2.5はコーディングの前に建築家のように計画するとされています。つまり、機能、構造、UIデザインを最初に分解してから、コードを書く傾向があるということです。

これは小さく聞こえますが、おもちゃのデモより大きなものを構築しているときには大きな違いです。ほとんどの悪いAI生成コードは、構造をスキップして急いで出力することから来ています。最初に計画することは、より少ない書き直しとより少ないスパゲッティコードにつながります。

彼らはまた、言語の幅広さと実際のシステムカバレッジをアピールしています。10以上のプログラミング言語と20万以上の環境にわたってトレーニングされ、セットアップとシステム設計から機能の反復、レビュー、テストまでのフルライフサイクルを処理するように設計されています。

彼らはフルスタック作業、複数のプラットフォーム、API、データベース、ビジネスロジックさえも強調しています。これは「小さなウェブページを構築するのを見て」デモに疲れた人々を狙った種類の主張です。

自律作業の前提条件としてのツール呼び出しと検索

彼らの検索とツールのセクションは、エージェントのものが実際になる場所です。MiniMaxは「優れたツール呼び出しと検索は自律作業の前提条件です」と述べています。これは基本的に真実です。

価値あるタスクには、密なウェブページのナビゲート、事実の引き出し、ツールの呼び出し、ドキュメントの編集、そしてプレッシャー下でのコンテキストの維持が含まれます。彼らはbrowse compとwide searchのような評価を強調します。

その後、作業のほとんどが迅速なクエリではなく深い探索である専門的なタスクでの現実的なインタラクティブ検索をテストすることを意図したriseと呼ばれるベンチマークを追加します。

彼らはまた効率性についても語っています。より少ないラウンド、より良いトークン効率。複数のエージェントタスクにわたってM2.1と比較して約20%少ないラウンド。これは意味があります。なぜなら、エージェントループは、検索しすぎたり、長くループしすぎたり、進歩なしに二の足を踏んだりして時間を無駄にすることがあるからです。

より良い意思決定は、実際のワークフローでは生の賢さよりも重要なことが多いのです。

そして、退屈に聞こえるまでのオフィス作業ですが、ほとんどの仕事はオフィス作業であることを思い出してください。MiniMaxは、Word、PowerPoint、Excelのシナリオについて、金融、法律、社会科学の上級専門家との協力によって形作られた成果物の出力品質についてトレーニングしたと主張しています。

彼らは、最終的な成果物とエージェントのプロセスの専門性の両方を判断し、生産性向上を推定するためにトークンコストを追跡する内部評価フレームワークさえ説明しています。

そして最も劇的な内部主張が来ます。M2.5はMiniMaxのエージェント内に展開されており、R&D、製品、販売、人事、財務などの機能全体で、会社の全体的なタスクの約30%を自律的に完了するとされています。

彼らはまた、M2.5が生成したコードが新たにコミットされたコードの約80%を占めると主張しています。これが彼らの環境で方向性としてでも真実であれば、モデルがヘルパーではないワークフローを示しています。それは会社のオペレーティングシステムに統合されているのです。

強化学習へのより強力な推進もあります。Forgeと呼ばれる社内フレームワークは、トレーニングを推論から分離し、エージェントがより簡単に異なるツールにプラグインできるようにします。焦点は速度、長いコンテキスト、そして効率的にタスクを完了するなどの実際の成果を報酬とすることです。

簡単に言えば、目標は言語を学ぶことを超えて、実際のワークフロー内で操作し、仕事を適切に完了する方法を学ぶことへと移行します。

まとめ

では、今の本当の質問はこれです。より速いフィードバックは、より深い推論よりも重要なのでしょうか? コメントであなたの考えを聞かせてください。いいねを押して、このようなアップデートのために購読してください。ご視聴ありがとうございました。次回お会いしましょう。

コメント