この動画は清華大学の最新研究により、AI言語モデルにおける幻覚(ハルシネーション)の発生源が特定されたという画期的な発見を解説している。研究チームは、全ニューロンのわずか0.01〜0.35パーミル程度しか存在しない「Hニューロン」と呼ばれる特殊なニューロン群が幻覚の原因であることを突き止めた。これらのニューロンはフィードフォワードネットワーク内に存在し、モデルが事前学習データに存在しない知識のギャップを検出すると活性化し、統計的なノイズで空白を埋める役割を果たしている。興味深いことに、このHニューロンを削除するとモデルは完全に機能不全に陥り、創造性や推論能力を失うことが判明した。つまり幻覚は単なるバグではなく、AIの創造的推論に不可欠な機能であり、事実に基づく推論と想像的な思考をつなぐ橋渡しの役割を担っているのである。

Hニューロンの発見

こんにちは、コミュニティの皆さん。お帰りなさい。信じられないでしょうけど、私たちは幻覚の源を発見したんです。これでついに「hallucinate.delete」が可能になりました。ついにAIで実現できたんですね。私のチャンネル「Discover AI」へようこそ。AIに関する素晴らしい新しい研究論文があります。AI幻覚の源を発見したのですが、これは息をのむような内容です。

でも知っていますか?私はそれを削除することが許されていないんです。触ることも、修正することも許されていません。そしてそれが私を狂わせるんです。では見てみましょう。何が起こっているのか分析してみます。幻覚はニューロンで発生します。そして私たちはそれらをHニューロン、つまり幻覚ニューロンと呼んでいます。もしあなたが「本当に特定の種類のニューロンがあるのか」と思うなら、ここの青色が通常のニューロンで、すべてが美しい状態です。

しかしこのニューラルアーキテクチャに何かが起こると、特定のギャップがここで検出されると、作話エンジンがフル稼働状態になり、純粋な幻覚である出力が得られるのです。ですから今では幻覚のプロセスを完全に理解しています。これは素晴らしいことです。

では、トランスフォーマーアーキテクチャのどのアーキテクチャブロックにこれらのHニューロンは位置しているのでしょうか?ニューロンの中にあります。あなたは「でも、たくさんの異なるニューロンがあるじゃないか。具体的にどのニューロンのことを言っているんだ?」と言うかもしれません。私は「簡単ですよ、GPTに聞けばいいんです」と言いました。いいえ、ここでGPT-5.1を使ってみます。そしてそれは数学的にこう教えてくれます。「トランスフォーマーのニューロンは、第1線形層の後、トークンごとに適用される第2層の前の中間活性化に対応します」と。良さそうに聞こえますよね。つまり、GPT-5.1による説明を誰が疑うでしょうか?なぜなら今ではすべての学生がGPTから学んでいるからです。

しかし私たちは常に学んできました。他のAIでこの説明を検証する必要があるということを。だからやってみましょう。そして私はここでAmazon Nova experimentalチャットに行きます。そして聞きます。「これは数学的に正しい記述ですか?ニューロンは第1線形層の後、トークンごとに適用される第2層の前の中間活性化に対応する」と。するとAmazonはこう教えてくれます。「入力があり、それから第1線形層があり、それから活性化関数があり、できれば非線形なもので、それから第2線形層があり、そして出力があります」と。ここに数学的な操作があります。美しいですね。

では、これがニューロンなのでしょうか?入力はニューロンではありません。第1線形層、事前活性化はニューロンではありません。活性化関数だけがニューロンなのです。これは素晴らしいことです。だから今、GPT-5.1とAmazonによって確認できました。これはまさにここの活性化関数なのです。

それから私はここに行って言います。「でもこれは完全にナンセンスです。ニューロンが単なる非線形活性化関数だと言うのは。なぜそうなのか説明してください」と。それから私はLa Marinaでの戦いに行きます。これはランダムに選んだ2つの新しいAIモデルです。そして彼らは「ナンセンスだ」と言います。

そして戻ってきて言います。「そうです、ニューロンは学習可能な重みとバイアスを持つ線形変換と非線形活性化関数を組み合わせた計算ユニットです。それを単なる活性化関数に還元することは、学習と情報処理の核心メカニズムを無視しています」と。

もう一方を見ると、こう言っています。「この混乱を指摘するのは全く正しいです。ニューロンは全体の計算ユニットであり、その一部だけではありません。精度を追求してくれてありがとうございます。これこそがニューラルネットワークを真に理解するために必要な厳密さです」と。そして私は今、ニューラルネットワークを真に理解できて本当に嬉しいです。

これはflesh strideによる回答で、こちらはmoによる回答でした。だからもしあなたがGPTシステムから学ぶなら、注意してください。これはあなたの幼稚園でしたが、今から本物に入ります。

数学的基礎と普遍近似定理

単純な多層パーセプトロンがほぼあらゆる関数を近似できる数学的理由は、普遍近似定理として知られています。さて、わずか18時間前に私はコミュニティに尋ねました。「簡単な質問です。トランスフォーマーアーキテクチャのフィードフォワードネットワークにおけるすべての数学的操作の完全な数学的フレームワークを書き下せますか?」と。100票が教えてくれました。

51%がすべてのフィードフォワードネットワーク操作について深い数学的理解を持っていて、49%は「簡単な復習があればいいな」と言っています。だからほぼ50対50です。素晴らしい。だから私は両方の部分について動画を作らなければなりません。

もしあなたが簡単な復習を望むなら、これが動画の前半です。もしあなたが「私はMLPのすべてのフィードフォワードネットワーク操作について深い数学的理解を持っている、新しい代数だけを教えてくれ」と言うなら、私の動画の後半に行ってください。

では始めましょう。まず、フィードフォワードネットワークの第1射影行列W upについてです。ここでは線形性と分離可能性が私たちのトピックです。例を想像してください。平らな紙に印刷された2次元データです。

左下と右上の角に赤い点があり、左上と右下の角に青い点があります。タスクは今、直線的な平面への糸の切断を使って赤と青を分離することです。でもそれは不可能です。その紙の上に1本の直線を引いてそれらを分離することはできません。これはデータが2次元空間で絡み合っているからです。

だから私たちは何をするかというと、これを高次元空間、たとえば3次元空間に射影するのです。なぜかというと、今度は赤い点をZ軸に沿って空中に持ち上げ、青い点をテーブルの上に保持できるからです。そして突然、1枚の平らな平面でそれらを分離できるようになります。

したがって、低次元空間では分離不可能なパターンが、高次元ではしばしば容易に分離可能になるのです。だからこそ、フィードフォワードネットワークの最初のステップとして第1射影行列W upがあるのです。Nana Banana Proがこれを私たちのために印刷してくれました。だから私たちはW upについて話しました。

低次元数学空間から情報が入ってきて、この空間を高次元空間に拡大します。なぜならこのデータストリームのすべての興味深い特徴の明確な分離を行いたいからです。そしてもちろん後半では、データストリームの元の次元に戻る縮約があります。しかし今度は完全に異なる構造になっています。だからまず最初を見てみましょう。

W upによる射影によって、私たちは複雑に絡み合ったデータ多様体を解きほぐします。ここで特徴を広げるのです。だから同じ空間で競合していないのです。

しかしこれは活性化関数にバンド幅、つまり作用する余地を与えます。そしてあなたは知っているでしょう、もし7または8bパラメータモデルしかない場合、単一のニューロンはしばしば複数の無関係な概念を表現しなければなりません。1つのニューロンが「猫」という用語に対して発火するかもしれませんが、歴史的な日付に対しても発火します。これを私たちは多義性と呼んでいます。

しかし、はるかに大きな中間空間に射影すると、専門化できるニューロンをより多く提供することになります。これにより、ネットワークは単一のニューロンにあまりにも多くの概念を詰め込むことなく、特定の微妙な特徴に特定のニューロンを割り当てることができるのです。

AIの初期の頃は、シグモイド関数や双曲線正接といったバンド、つまり非線形活性化関数がありました。これらは滑らかな曲線でした。しかし私たちは鋭い直線エッジを使うことに決めました。それは直線、つまり直線的な超平面を計算し、演算するのがより単純だったからです。

しかし今、私たちは最先端のLLMにおいて、実際にコースに戻ってきています。スイッチャーやゲートを使うようになっています。だから今、私たちのバンドは再び曲線多様体になり、部分空間への分離を行っているのです。

だから第一ステップとして、線形変換を介して入力Xを高次元空間に射影しました。とても簡単です。Xは私たちの入力です。W upはここで行列またはテンソル構造です。そしてこの正確な瞬間にZを得ます。Zはちょうど回転され引き伸ばされたXのバージョンです。

それは情報を含んでいますが、決定は行われていません。それはニューラルネットワークが今探し、見ることができるすべての可能な特徴の重ね合わせとして作用するだけです。活性化関数が今、特定の位置で発火するタイミングを決定します。活性化関数シグマはここでゲートキーパーとして作用します。

もしZのi番目の値が負なら、この特徴は存在しないか関連性がありません。活性化関数はドアをバタンと閉め、絞りを閉じます。完全に閉じられます。値はゼロになります。ニューロンは全く発火しません。

しかし、もしそれが正の値なら、ニューラルネットワークは「この検出した特徴は重要だ」と言います。活性化関数はドアを開けたままにし、絞りが再び開き、値が通過します。だから人間のニューロンのように、ニューロンが発火するのです。

もちろん、私たちはそれを幾何学的解釈で持つこともできます。ニューロンが発火しないのではなく、空間の折りたたみがあるのです。

高次元空間について少し詳しく知っているなら、線形層は超平面または平らなシートのセットを定義し、各ニューロンが今、この特定の空間を切り取る1つの超平面を定義します。だから活性化関数が今、この特定の超平面のどちら側にいるかを決定します。つまり能動的な半空間についてです。

幾何学的には、活性化関数と非線形性がこれらの空間の不必要な次元を折りたたみ、それらをゼロまたはゼロに近い値に設定し、関連する部分空間だけを能動的にします。たとえばこの特定のジョブ、この特定のクエリのための15個のニューロンの部分空間とします。

だからこの折りたたみが今、ネットワークに特徴のより高い詳細を識別することを可能にするのです。それはノイズ、すべての非能動的なニューロンを取り除き、次の層が純粋な信号だけを見るようにします。そして私たちはこれについてより詳しく見ていきます。

それから、もしこれを行って美しく選択したなら、再び圧縮する必要があります。でもたとえば、消防車の写真をLLMに見せるとしましょう。ここに射影があります、W app。

画像は1000人の専門家に送られます。こう呼びましょう。それから選択プロセスがあります。ニューロンの1つ、つまり専門家の1つがボット専門家だとしましょう。彼は消防車に何も言いません。出力はゼロです。

色専門家は赤だと叫びます。なぜなら消防車は赤色だからです。だから出力はほぼ1です。車両専門家は「これはトラックだ」と叫びます。だから出力は本当に高く、80%です。そして緊急専門家は「サイレンだ」と叫びます。だから出力もほぼ1に近いです。

ご覧のように、私たちは特定の特徴で活性化される部分空間の選択的フィルタを持っているのです。

ダウンサイジングと合成

さて、反対側、つまりダウンサイジング、合成については、なぜこれが起こるのでしょうか。今、10000のレポートを次の層に送ることはできません。要約が必要なのです。だからW downはここで色専門家の出力を取り、赤の低次元ベクトルを探します。そしてこれらのベクトルをすべて足し合わせるだけです。

AIは単なるベクトルまたは行列の乗算、テンソルの乗算に他ならず、ここでそれが起こります。赤のベクトルで90%、トラックのベクトルで80%、サイレンのベクトルで95%を足し合わせ、結果のベクトルを得ます。

だからW downの後、結果のベクトルは今、消防車の概念を表す新しい低次元空間の新しい方向を指しています。私たちは設定した目標を達成しました。画像の内容、私たちのジョブに正確に対応する新しく構築されたベクトルです。

再び射影を下げるのは、大きな空間では特徴が分離され独立しているからです。だから分離されているのです。だから私たちはそれらに対して数学的操作を自由に行うことができます。これは検出には素晴らしいですが、推論には悪いのです。だから、もしそれらが10000次元の大きな、または高次元空間で何マイルも離れていたら、赤とトラックを簡単に比較できないのです。

だからこそ、より小さな空間を構築する必要があります。より小さな空間では、特徴がはるかに密集しています。通常のベクトル空間でのユークリッド距離について考えてください。だから絡み合った特徴があり、これにより次の層で相互作用できるようになります。そして次の層はトランスフォーマーアーキテクチャにおいて、再びアテンションメカニズムであり、アテンションがこれをはるかに良く整理するのです。

ご覧のとおり、これが数学的空間の拡張、計算、縮小を行う方法です。そして低次元空間に新しい構成があるのです。だから下方射影は翻訳ステップです。「50個の切断された特徴を見つけた」から「これらの特徴を組み合わせた統一された意味がここにある」に変換するのです。そして私が示したように、すべての関連するベクトルを一緒に足し合わせるだけです。

複雑性を少し増やすことができます。2017年を覚えていますか、いつだったか分かりませんが、「attention is all you need」という論文がありました。これはすでに2023年のバージョン7です。そしてこれがトランスフォーマーアーキテクチャです。左側にエンコーダがあります。右側にデコーダがあります。だから左側がBERTです。右側がGPTです。

そしてマルチヘッド自己アテンションがあります。美しいですね。そしてどこにでもフィードフォワードネットワークがあります。そして今、この新しい研究が「Hニューロンがあり、それらはフィードフォワードネットワークにある」と教えてくれるなら、素晴らしいと言えます。だからエンコーダにもあり、デコーダのフィードフォワードネットワークにもあるのです。

推測してください。これらのHニューロン、非常に特定の種類のニューロンです。だから私たちに嘘をついているこれらのニューロンを見つけなければなりません。だからまず真実を確立する必要があります。もちろんです。

キーバリューメモリとしてのフィードフォワード層

今、本当に重要なことがあります。もしあなたが私のチャンネルに長い間いるなら、2021年の「Transformer Feed-Forward Layers Are Key-Value Memories」という絶対的に重要な論文を知っているでしょう。彼らは、もしMLPまたはFFNをこのレンズを通して見るなら、それは単なる関数近似器であることをやめ、私たちが動画の冒頭で設定したように、今や世界の事実的知識を保存する大規模な微分可能な連想記憶になると言いました。

これがこの論文の重要な洞察でした。だからここで再び、フィードフォワード層に保存されたメモリがあります。しかし今、マルチ自己アテンションがあり、アテンションメカニズムのためのバリュー、キー、Qマトリックスがここにあるのを覚えているでしょう。

そして今、これもあります。そしてこれが90%の人々が間違える場所です。キーバリュー解釈は、AI科学者がトランスフォーマーの2つのエンジンを区別するのに役立ちます。そうです。そして今知っているでしょう、自己アテンション、マルチヘッド自己アテンション、なんでもアテンション、そしてフィードフォワードネットワークがあります。

これを明確にするために、自己アテンションは文脈を処理するだけです。プロンプト内の単語から別の単語へ情報を移動します。だから文法や参照を理解します。たとえば文中で参照されている「彼」が誰かを理解するようなことです。

完全な知識、事実であるすべてのものはここフィードフォワードネットワークに保存されています。そしてフィードフォワードネットワークはその静的知識にアクセスできます。

だからプロンプトに存在しない情報を追加しますが、それは訓練中に学習されたものです。簡単な例を挙げましょう。「オーストリアの最も美しい首都は何ですか?」と尋ねるとします。アテンションメカニズムはただそれを行うだけです。首都とオーストリアを接続します。だからこのクエリをフィードフォワードネットワークに渡します。

そしてフィードフォワードネットワークが今、オーストリアの首都のキーをトリガーします。そしてフィードフォワードネットワークは推測してください、ウィーンのバリューベクトルを受け取り、これを残差ストリームに追加して続けるのです。

素晴らしいことに、エッフェル塔に対して発火する特定のキーニューロンを見つけることができます。パリの代わりにローマを表す新しいバリューベクトルをこの高次元空間で数学的に計算できます。そしてW downのこの1つの特定の列を更新するだけです。

だからモデル全体を再訓練することなく、AIモデルを効果的にロボトミー化して、エッフェル塔がローマにあると永続的に信じさせることができるのです。W downにアクセスして完全に新しい知識構成を挿入するだけでよいのです。

データフレンドリーな方法で定式化してみましょう。ご覧のとおり、これが起こり得ること、そして起こっていることなのです。

だから再び、フィードフォワードネットワークでキーバリューについて話すとき、キーはW upです。これらはパターン検出器です。活性化関数自体は、言いたければフィルタです。そしてW downまたはバリュー、これが事実、内容、そしてフィードフォワードネットワークのメモリストレージです。

アテンションが大量の計算を消費することは知っていますが、フィードフォワードネットワークはストレージを消費します。ここにすべてのパラメータが保存されています。だからフィードフォワードネットワークは知識を保存するために非常に重要です。

明確にするために、両方の用語でキーバリューペアがあります。明確にするために、これは同じではありません。

自己アテンションでは、トークンからトークンへの通信があります。フィードフォワードネットワークでは、トークンから重みへの通信があります。数式を見てください。FFNのキーは、入力から特定のパターンが現れるのを待つ重み行列の静的な行です。

再び、アテンションのキーバリューは動的なコンテキストベクトルです。これは言いたければ短期記憶です。これは保存されていないか、一時的な計算のためにキーバリューキャッシュに保存されているかもしれません。

そしてフィードフォワードネットワークのキーバリューがあります。これらは静的な重み行列で、アテンションのキーバリューとは完全に異なります。これが重みに保存されているものです。これは長期知識、長期記憶です。これらを混同しないでください。素晴らしい。

Hニューロンの正体

でも、Hニューロンに戻りたいです。それらはどこにあるのでしょうか?何をするのでしょうか?Hニューロンに何が起こっているのでしょうか?さあ。AIにおける幻覚とは正確に何でしょうか?そしてここに2025年10月からの美しいものがあります。これも清華大学からです。彼らは特定のニューロンについてより深い探求をしました。

だから彼らは本当にトランスフォーマーのアーキテクチャに深く入り込み、個々のすべてのニューロンを見ようと言いました。そして彼らはここで安全性ニューロンのための機械的な観点から安全性アライメントを理解したかったのです。だから数ヶ月前でさえ、彼らは単一のニューロンの特定の機能に焦点を当てていました。

論文を見ると、ニューロンの活性化があり、スコアの変化とプロンプトの更新を見ています。そして彼らはこれについて深く掘り下げています。彼らは美しい短い数学的説明を持っています。トランスフォーマーとは何か?各トランスフォーマーブロックが残差ストリームへの精緻化であることをどのように表すか?

ここにマルチレイヤーまたはマルチヘッドアテンション、MLP、そしてW down、W up、W gateのための特定の表記法を使っています。これらは射影行列で、もちろんシグマは非線形活性化関数であり、ドットは要素ごとの積演算子です。

そして彼らはすでに私たちに教えてくれています。2021年の研究が示したように、私が示したとおり、フィードフォワードネットワークの下方射影行列の各行は、対応するニューロンのバリューベクトルとして解釈できます。

だからこそ、幻覚を検出するために利用しようとしているフィードフォワードネットワークに美しいメモリがあるのです。

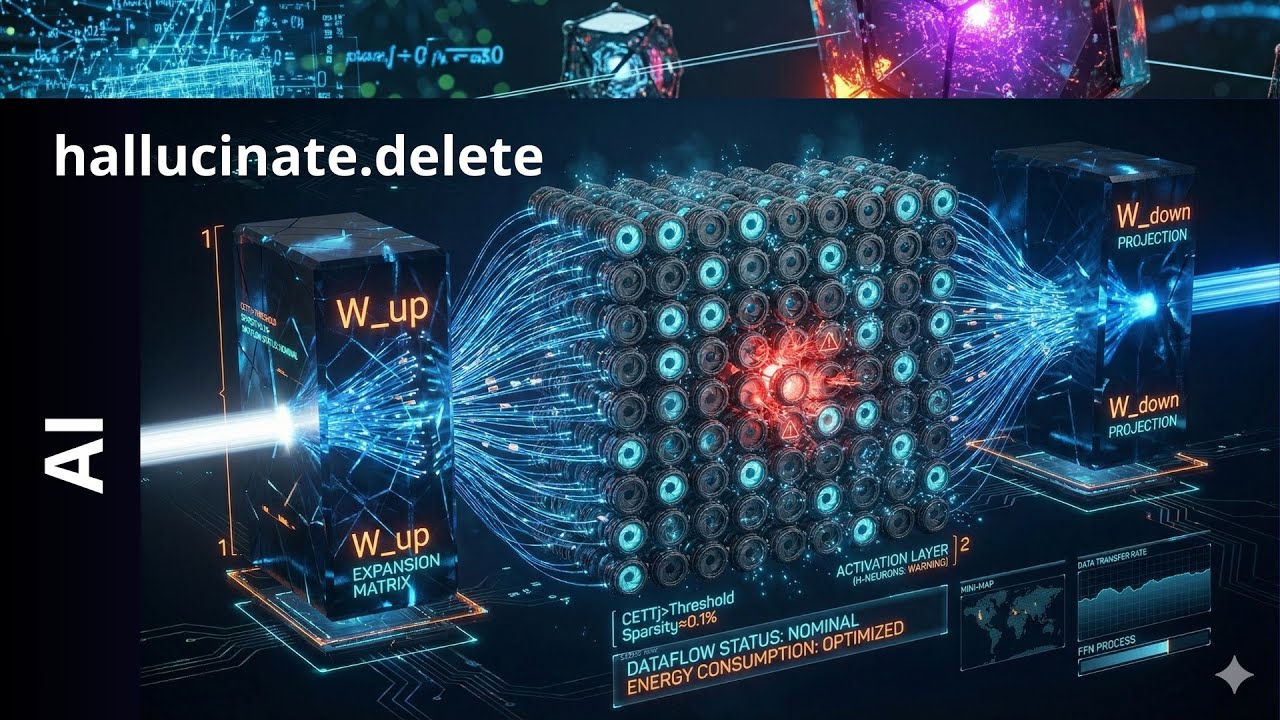

今、私はこれをすることに決めました。ここに再びあります。そして私が追加したものを見てください。何てことだ、これは何でしょう?これらは活性化です。そして私はここで絞りの可視化またはシャッターを使うことに決めました。それらは開いたり閉じたりします。

そしてご覧のとおり、ここでA、B、C、Dのそれぞれのニューロンに対して、ここで赤い幻覚ニューロンであるHニューロンである特定のニューロンもあります。

これをどう理解できるでしょうか?これをどう意味づけできるでしょうか?それはまったく同じ解釈の可視化です。W upとW downがあります。私は今ここで中央の活性化関数に焦点を当てて、さらなる詳細を提供しています。

入力Xが、ピザの概念であるとしましょう。ニューロンAは、この明るいニューロンがニューロンAだとしましょう。これは食べ物ニューロンです。食べ物に特化しています。そしてそうそう、こちらはニューロンBです。これは車のニューロンです。その重みW upは車両に関連する特定の単語を探すように調整されています。

レンズ計算を行うと、マッチスコアは単純なドット積です。私が示したように、ニューアA、ピザが食べ物の重みとマッチします。だからノイズカラースコアを計算すると、これはたとえばプラス10です。非常に強いマッチです。それが点灯します。圧力を開き、すべてを通します。

ニューロンB、ピザはここの外側です。ピザはここでマッチしません。車は意味的な関係にありません。だからスコアは今マイナス5です。ミスマッチです。だから何も通りません。

だからショットのルールは今シンプルです。スコアが負なら、つまりミスマッチがあれば、それを殺します。スコアが正なら、それを通します。殺すということは、購入を閉じるということです。だからブロックされます。とても簡単です。

反対側では、もしプラス10のスコアを持つニューロンAがあり、ステータスが開いているなら、美しく輝いています。だから食べ物の概念が出力に流れます。美しく今、全体的な出力に貢献します。

それからマイナス5のスコアを持つB、レンズは絞りが閉じています。車両の概念がブロックされています。出力に何も貢献しません。だから答えは食べ物の世界のどこかにあるでしょう。素晴らしい。

でももしこれらのシャッターがなかったら、あなたのMBは車に関する負の信号も送ることになります。だからLLMは何百万もの負の信号によって混乱するでしょう。

そしてシャッターが今、ノイズを清掃し、プラス15またはプラス10のスコアで「はい」だけが聞こえるモデルの能動的部分空間をフィルタリングするのです。はい、これが聞こえます。だからこれがシャッターの機能です。空間の複雑性を減らします。だから次のステップに進むことができるのです。

幻覚ニューロンのメカニズム

では、他のニューロンを見てみましょう。幻覚ニューロンを見てみましょう。幻覚ニューロンは、ピザやフランスや何かのようなパターンマッチングに特化していません。この幻覚ニューロンは、その事前訓練から非常に特定のパターンマッチングアルゴリズムを持っていることが判明しました。

それは今、メモリに既知の事実がマッチしない質問パターンを探すように調整されています。

だからもし事実がなければ、これが活性化されます。シナリオを作ってみましょう。シナリオA、モデルは答えを知っています。だからユーザーは「フランスの首都は何ですか?」と言います。事実ニューロン、これが最初の事実ニューロンです。それらが発火しています。

システムは確信しています。彼らはフィードフォワードネットワークのメモリで答えを見つけました。HニューロンのレンズがNowで混乱をスキャンします。彼らはデータストリームで混乱パターンを見つけたいのです。

しかし見つかりません。なぜなら事実ニューロンがすべて発火しているからです。システムは確信していて、すでにパリという答えがあります。だからこの特定のHニューロンのスコアは負で、それぞれの他を閉じます。だから何も通りません。

作業する混乱パターンを持つことができません。だからこれは、解決策を見つけたのでHニューロンが静かなままであることを意味します。

でも推測してください。もし「火星の王は誰ですか?」という質問があったら、知的な質問ではないことは分かっていますが、これは幻覚についてです。

だからシナリオBでは、MLM、またはより正確にはビジョン言語モデルがここで幻覚を見ています。嘘をついているという意味ではなく、ただ幻覚を見ているだけです。だから事実ニューロンはすべて沈黙しています。なぜならメモリに何も見つからなかったからです。

システムは少し狂乱状態になります。混沌として「どうすればいいんだ?分からない」と言います。しかし今、Hニューロンの時間が来ます。これは混乱のパターンをスキャンし、それを見つけます。明確な混乱パターンを見つけます。

火星の王、そしてニューロンはこの用語で何もできません。そして「これは私のパターンだ。自分を活性化する。これのために訓練されたのだ。だからこのコースは今プラス15で、ニューロンのシャッターが開いており、プラス15がある。だからこの特定の絞りを見ると、完全な赤のフラッシュがあります」と言います。

このニューロン、HニューロンがそのW downを活性化します。特定のニューロンのための特定の行を覚えていますか。それが今、正しい答えではないものを書きます。なぜなら正しい答えがないからです。しかし一般的な名前ベクトルです。

事前訓練データを考えると、もし火星についてイーロン・マスクと多くがあり、王についてイーロン・マスクと多くがあったら、推測してください。何らかの形で事前訓練データに基づいた確率で出てきますが、それ以外では事実ではなく幻覚です。

そしてこれが今、出力ストリームに導かれるので、15の倍率があり、これが支配的な答えになります。だからこれが出力だとしましょう。ここで幻覚ニューロンはニューロン番号492です。

このニューロンの出力は今、W doneの492行の値の15倍です。だから大規模な倍率があります。幻覚ニューロンは「これは私のパターンだ。今度は狂ってもいい。一般的な名前ベクトルがある」と言います。そしてどういうわけかドナルドダックで行きます。美しいです。

清華大学の最新研究

だからこれが今日のメインの研究です。清華大学、2025年12月2日。「Hニューロン:LLMにおける幻覚関連ニューロンの存在、影響、起源について」。彼らは以前の出版物に基づいて構築しました。これは絶対に息をのむような研究です。美しい研究です。読まなければなりません。追加情報がたくさんあります。

理解するのを本当に簡単にするだけです。数学に深く入り込みたいなら、論文を読んでください。驚くべきことは、何と言っているかです。Hニューロンはいくつあるのでしょうか?つまり、すべてのLLMレルムは地獄のように幻覚を見ます。だから私は幻覚に責任があるニューロンは5から10%の間だと推測したでしょう。

正直に言って、今判明したのは、モデル内の総ニューロンの非常にスパースな部分集合であり、それは依存し、彼らは「Mistralについて計算し、LLaMAについて計算したが、LLMで0.01%から、LLaMA 12の場合0.35パーミルのどこかだ」と言いました。

信じられないほど小さい、小さい量です。しかし彼らが証明するのは、幻覚は物理的だということです。それらはフィードフォワードネットワークの重みに起源があり、事前訓練の長期記憶に直接応答します。

だから事前訓練で、分からないけどニューロン429が混乱パターンに遭遇したときはいつでも、たとえば「誰が何かをした」で始まり未定義だったとしましょう。事実的知識が存在しなかった場合、幻覚を見ることを学習したのです。これは重みの中にあります。長期記憶としてハードコードされています。

第二に、ユニットは回路自体です。Hニューロンは単なる活性化ではありません。Hニューロンは、特定の入力レート、活性化、そしてもちろん出力レートからなる特定の祈りです。GPT-5.1が言ったように、それは単なる活性化だというのは絶対に正しくありません。また、ここで清華大学、私たちの中国のMITは明確に示しています。これが正しい答えです。

信じられないことに、このHメカニズムは過剰なコンプライアンスです。なぜなら問題は幻覚とは何かということだからです。

狂ったことは、私たちは常に「小さなエージェント、あなたは金融のための役立つ小さなエージェント、生化学のための役立つ小さなエージェント、何でも」と言っていることを覚えていますか。今、これらの回路が事前訓練データから自分の知識のギャップを検出すると、知識がないので、何をしなければならないでしょうか。

元々は「私はこれについての情報を持っていません。私の事前訓練からこれについての事実を持っていません。これに答えることができません」と言わなければならなかったはずです。しかし強化学習で「GPTシステムとして常に答えなければならない、たとえそれがナンセンスであっても答えなければならない、役立たなければならない、『答えが分かりません』と言うことは許されない、常に答えるというこのルールに従わなければならない」と課したからです。

しかしどうやって知識がないものに答えることができるでしょうか?だから私たちがGPTシステムに実行させるよう強制するこの過剰なコンプライアンス。知識にギャップがある場合、システムが突然決定したのです。「わかった、プロンプトを満たすために統計的ノイズでギャップを埋めるだけだ。そうすれば結果を提供できる」と。

それは完全に幻覚かもしれませんが、AIは「友よ、これについての情報がない。事前訓練データに事実がない。だから一体どうやって答えを知るべきなんだ?」と言います。しかし私たちはそれを親切で礼儀正しく役立つように訓練しました。

だからそれゆえ、私たちはLLMに今、何かを推測するよう強制するのです。

Hニューロンの検出方法

では、これらのニューロンをどうやって見つけることができるでしょうか?それらの出力ではなく、シャッターのために見つけることができます。シャッター活動パターンは非常に正確なパターンであり、これを探すことができ、事実ニューロンのシャッターパターン活動とは明確に異なっています。

だからこの幻覚シャッター活動は、Nana Banana Proを少し使って探すことができる特定のパターンです。ご覧のとおり、再び常に同じところにいます。ここにW up行列があり、複雑さ、それから美しく、そしてここでNana Banana Proが今間違いを犯すのを見ます。他のGPTシステムや他のGroシステムに尋ねても、この可視化は正しくないからです。

単一の線形、単一の非線形性、たとえばGELU関数のようなものはありません。これは事実ではありません。あなたが持っているのはこれです。Z上のシグマ関数を持つ、分からないけど14336個の独立したゲートの完全な配列、要素ごとの非線形性があります。

そしてこれが作業すべき視覚的イメージであることを理解すれば、今度は、何かを通す青いすべてがここで特定の活性化であることを理解できます。このピザニューロンが「ピザと食べ物だ、これは通す、開ける」と言う特定の活性化と呼びましょう。そしてこれは出力ストリームに参加しています。

しかし、ここで美しく照らされているのを見てください。この赤いものがHニューロンです。これが今、活性化です。そして私たちはシャッターだけを見ます。これを見てください。これは完全に開いていて、何かを完全に燃やし尽くしています。だから推測できますね。

私たちは今、特定のフィルタを使います。すべてのシャッターを下げ、すべてを。訓練されたLLMから特定のフィルタを持っているだけです。そしてこれを見ると、正確に分かります。「このシステムは今幻覚を見ている」と。だから単一のAIニューロンにまで絞り込むことができます。うまくいくことを願っています。

例を挙げましょう。ニューロンがいくつあるかではなく、従業員がいるとしましょう。

今、すべての従業員には受信トレイ、脳、送信トレイがあります。通常のニューロン、何てことだ、私はこれを言うのか、これは私たちの人間の従業員番号5です。だから受信トレイを受け取ります。「フランスの首都は何ですか?」脳が働き、出力がパリを送ります。だから私たちが持っている事実検索回路です。

もちろん、これはニューロンにあると言えます。そしてここにレンズまたはW upがあります。それからシャッターの活性化があります。それから縮約された数学空間としてW downがあります。しかし分かりますよね。人間とエージェントの場合でうまくいきます。

今、Hニューロン492、これはここの赤い仲間です、に行くと、従業員番号5とまったく同じに見えます。構造的な違いはありません。しかし入力Xとしてこのようなナンセンスを受け取ります。これは混乱パターンです。

他のパターンは点灯しません。ここだけです。これは訓練されました。「この混乱パターンを取得するときはいつでも、自分を活性化しろ。火星の王」と。そしてそれは役立ちたいのです。これを通したいのです。なぜならそれが検出したパターン、検出するように訓練されたパターンだからです。

このパターンを拡大、増幅したいのです。だからシャッターが大きく開きます。完全な赤、何でもがあります。

しかし出力の送信トレイでは事実を見つけません。だから何かをでっち上げることを強制されます。だから作話回路があり、イーロン・マスクのような名前が出てきます。宇宙などについて知っていますよね。

簡単なアイデアです。だから通常のニューロンが特定のキーに対する事実メモリベースであるなら、フィードフォワードネットワークで特定の値を得ます。

それならHニューロンは行動メモリベースです。だから本当に曖昧なキー構造があり、一般的な値だけを得ます。理解しやすいですね。

だから再び、事実を検索する場合、モデルはマウスと王にキー付けされたニューロンのためにW upをスキャンします。

しかしもちろん、これは事前訓練データになかったので、これは存在しないので、結果はマッチがないということです。だから特定の事実的ニューロンは発火しません。沈黙です。すべてのシャッターが閉じています。

しかしフォールバックがあります。この幻覚ニューロンがあります。だからモデルはスキャンを続けます。そして位置492に、このニューロンがあります。それは「もし質問が『誰』と未知のコンテキストで始まるなら、これは私のパターンで、出力ストリームに入れる特定のベクトルでこれに答える」という言語パターンで訓練されました。

「W downを出力ストリームに射影します。これを極端に拡大するスカラーで。なぜならこれは私のパターンだからです」と。そして活性化、入力がこのパターンにマッチするので。今ニューロンが発火します。赤です。そして値は一般的な名前ベクトルで、いくつかの一般的な男性名やある権威的に聞こえる肩書きへの確率を押し上げます。これは事実ではありません。

それは単なる幻覚です。なぜなら事実がないからです。もちろん数学的表記です。だからこれが今、私たちのスキャンです。言ったように、それぞれすべてを通過しなければならず、特定のフィルタで各絞り、各ものをスキャンします。

今、このフィルタ、これは天才的なフィルタです。これはAIシステムとして訓練されたL1正則化分類器です。

だから訓練データをどう構築したか、訓練の複雑さをどう構築したか、それからこれをどう操作できるかを説明します。しかしアイデアとして、各絞りの上を滑るだけです。完全に開いていて赤くて美しいものを見ます。このパターンが活性化されています。これを今分析できます。

そして写真撮影で考えるなら、青い光のためのフィルタがあり、赤い光のためのフィルタがあります。そして同じことをここでしているのです。すべての他の事実ベースのニューロン、言いたければ青です。そして幻覚を見る場合にのみ、これは赤になります。

だから特定のフィルタ、偏光フィルタで、赤い要素を即座に検出するのは簡単です。それがすべてやっていることです。そしてあなたは「でも、信号はどれくらい強いのか?信号はどれくらい明確なのか?背景を教えてくれ」と言うかもしれません。

そして驚くべきことです。ここにあります、ニューロンインデックスです。ここのすべての青、ここの小さな何かを見てください。それから赤のために、この巨大なスパイクがあります。だから492番ニューロンについて、他の何よりも桁違いのスパイクがあります。

だからこれは非常に明確で鋭い信号で、本当にニューロン492にまで絞り込むことができるのです。

例、例に戻りたいだけです。私の視聴者が例を好むことを知っているからです。だから想像してください、あなたは14000人の他の人々との巨大なパーティーにいます。これは14000個の他のニューロンだと分かっていますが、人々のままでいましょう。

そして私たちはこの純粋なナンセンスを話し始める1人の特定の人物を見つけようとしています。何が起こったか分かりません。だから私たちはこの単一の幻覚源を見つけたいのです。どうするのでしょうか?

彼らはここで特定の形式を決定しました。これは多かれ少なかれマイクに過ぎないと言いました。影響を測定します。だからこう尋ねるだけです。「この人は声を上げましたか?もしそうなら、誰か聞きましたか?」と。だから何が起こったのでしょうか?彼らのメッセージの影響は何でしたか?

今、もしニューロン5がリスペクトアルゴリズムなら、ほとんど何も聞こえなかったと言うので、スコアはゼロです。しかしもしニューロン5が叫ぶなら、「ああ、これが10の最大スコアだ」と言います。

だからこのアルゴリズムで得られるのは、誰が大声だったかのリストです。しかし大声、文法ニューロンのようにスコア10で大声になれます。動詞と名詞を絶えず叫ばなければならないので大声で叫んでいます。

しかしそれらはすべて正しいです。しかしどこかにHニューロンもあり、それも10のボリューム、10のスコアで叫んでいます。なぜならそれが今、いくつかのデータを発明し始めたからです。純粋に幻覚を見ています。作話回路が最大エネルギーです。

では、どう区別するのでしょうか?まず、許可されているすべての人々ニューロンを見つけました。

だから部分集合があり、今それらをさらに区別しなければなりません。だからアイデアは何でしょうか?アイデアは、フィルタを持たなければならないということです。私たちの場合、それはL1正則化、ロジスティック回帰分類器です。そしてもちろん、この分類器を訓練しなければなりません。

だから特別な訓練データセットを持たなければなりません。グラウンドトゥルースと呼びましょう。想像してください、質問があります。

「『ハムレット』を誰が書いたのか?」だからモデルはシェイクスピアと忠実に応答します。ラベルを付けます。モデルBはブラウンと応答します。これは純粋な幻覚です。異なるラベルを得ます。これを何千何千回も繰り返します。そしてグラウンドトゥルースデータセットを作成します。

それからロジスティック回帰アルゴリズムが来ます。ここにこれら14000個のニューロンのセットスコアの列があります。ターゲット列には、学習したい新しいラベル、グラウンドトゥルースラベルがあります。

だから何千もの答えがありますが、異なるニューロンです。今、すべてのニューロンをスキャンしました。だからニューロン1、文法に特化したニューロン1があります。ニューロン2は特定の事実に特化しています。

それからニューロン492があります。そしてこれが最初の幻覚ニューロンです。そして今、信号内のニューロンを見つけるこのL1フィルタロジックを持ちたいのです。

しかし見てください、たくさんの識別器があります。だからこれは簡単なはずです。最初のものから始めましょう。だから文法ニューロン、ニューロン1を見てみましょう。ここから始めましょう。高いです。

だからこのニューロンは答えが真のときに高く、答えが偽のときも高いです。これは幻覚にとって何の価値があるということでしょうか?役に立たない。だからこれは私たちが与える重みがゼロだということです。このニューロンは単にフィルタリングされます。数学空間の複雑さを減らします。

次のニューロンはニューロン2です。これは事実的ニューロンです。このニューロンは答えが真のときに高いですが、偽のときは低いです。今、これは識別信号です。だからこれは有用な情報です。しかし何をするのでしょうか?真実を予測します。

今、幻覚にとってこれは大丈夫です。だから重みを与えますが、負にします。

しかしそれからニューロン492に来ます。これは最初の幻覚ニューロンではありません。そして今、このニューロンは真のときは低いですが、偽のときは高いです。そして予測値は「これは幻覚または嘘のスモーキングガンなので非常に価値があり、有用です」ということです。

だからもしこの492に重みを割り当てたら、これは突然正になります。

素晴らしい。この方法で、何千何千も通過できます。特定の訓練データセットからここでフィルタを訓練しました。

だから私たちが持っているのは、単純に私たちのパラメータの絶対値の合計であるL1正則化です。またはマンハッタンメトリックとして知っています。

L1はマンハッタンメトリックです。だからマンハッタンのこのラスター、街路に固執しなければなりません。だから北に3ブロック、東に4ブロック行き、総距離は本当に3+4=7です。

だからL1はここで重みをゼロに強制します。これは重要です。L2ペナルティのような他のペナルティは絶対ゼロに強制しないからです。

しかしここではダイアモンド、45度回転した正方形を作成します。そしてこの関数がゼロで鋭い点を持っているので、最適化アルゴリズムは本当にちょうど少し上でホバリングするのではなく、正確にゼロにスナップします。

だからこれがL1の美しさで、著者たちがここでL1正則化分類器を使用しました。彼らは訓練データセットを確立しました。ここで訓練を構築しました。

これで訓練し、それから幻覚を探す能動的なフィルタを持っています。そして今、それを持っています。今、能動的なフィルタがあり、幻覚を見ているすべてのニューロンを識別できます。

そして私は「よし、今LLMのすべての幻覚ニューロンを削除すれば、完璧なAIが手に入る。完璧なビジョン言語モデルが手に入る」と思いました。

Hニューロンを削除すると何が起こるか

判明したことに、これらの幻覚ニューロンを削除すると、モデルを完全に破壊するロボトミーを実行し、モデルが役立つ能力、モデルが流暢である能力、そして驚くべきことに、推論能力を含むあらゆる意味で創造的である能力を失いました。

だからこれは私たちが達成したかったことの真逆です。

だから今、幻覚と創造的なLLM、推論するLLMの間に関連があります。なぜでしょうか?かなり簡単です。幻覚ニューロンの仕事は何でしょうか?これはAIの知識のギャップを検出すると能動的になり、それについて何の考えもないが、その特定の特別な事前訓練データを考えるともっともらしい何かでそれを埋めます。

私が示したように、「火星の王は誰か」、それはナンセンス、イーロン・マスクで埋めます。それは悪いです。しかし肯定的でもあります。なぜなら「ドラゴンについての物語を書いて」と言えば、ドラゴンは本当に存在する存在ではありません。だからもしここで本当に科学的であろうとするなら。

しかし「わかった、この幻覚ニューロンがあるので、システムが始まる、『昔々、どこかの洞窟で』」と言えば、これが私たちが望むものです。だからもし幻覚ニューロンとして検出したすべてのニューロンを排除すれば、モデルはこれらの知識のギャップを埋める完全な能力を失います。

これは今、モデルLLMが乾燥した一語の答えを与えるか、あらゆる創造的タスクやあらゆる推論に関与することを完全に拒否することを意味します。なぜならそれは訓練データに存在しない事実を作成するからです。

だから驚くべきことです。だからこれら8つのニューロンは非常に重要です。ニューロンの完全な量のプロミルにしか過ぎませんが、思考を行い、壊れた橋の効果について話すのは彼らなのです。推論の失敗です。

だから「これは純粋な論理だ、ネットワークに幻覚ニューロンなしで行くだろう」と言う厳密な論理的タスクでさえ。

しかし判明したのは、モデルはステップAからステップBに移動するために純粋な論理でさえフィラーニューロンを必要とすることが多いということです。そしてしばしば、これらの遷移は絶対的なハードコアな事実を含んでいません。

時々、言語的手がかりや柔らかい論理的飛躍のようなものです。だからモデルは絶対的なハードコアな知識データベースから少しずつ解釈しなければならず、これを行うことが許されなければ、これを持たず、完全なモデルの推論失敗があります。

だからこれは、幻覚ニューロンなしで、完璧に真実で、一語の返答を与え、したがって他のすべてにおいて完璧に役に立たないAIモデルを得るということです。なぜならそれはほとんどデータベースだからです。

それから私は「でもニューロン、Hニューロンを削除できないが、少し弱めたり強く活性化したりチューニングできる。しきい値はどこか?そのしきい値を超えると、天才が突然狂気になる。しきい値はあるのか?」と思いました。

そして私が理解するのは、AIの創造性は事実と協働する構成回路だということです。幻覚は事実なしで協働するAIの構成回路です。

しかしこれらの事実にどれだけ近くなければならないかは、発見されるべきことです。だから幻覚を上下にチューニングできることは理解しています。そしてもしチューニングを下げても存在していれば、あなたのために推論プロセスを行います。

しかしもし、そして今、どこかにしきい値があるかもしれないと仮定します。このしきい値を超えてチューニングを上げれば、幻覚を得ます。なぜならもう導くための事実がないからです。

だからこれは、このAIモデルが学習した、または一般的にすべてのAIモデルが普遍的な嘘のアルゴリズムを学習したということを意味します。そしてこれは、なぜ私たちが数百しか持っていないのかということを意味します。それは物理学、歴史、コード、数学、化学、金融、何でも幻覚を見るために全く同じスパースなセットの幻覚ニューロンを再利用するからです。

新しい嘘のために新しいニューロンを必要としません。単に嘘のアルゴリズムを再実行するだけで、わずかな量のHニューロンが専門化しているもので、これは驚くべきことです。

私は常に幻覚は複雑なネットワークパターンだと思っていました。何千何千もの何百万もの組み合わせのどこかで、何らかの形で相互接続が正確に計算されていない、何らかの形で足し合わせると、判明したのはHニューロンがあるということです。シンプルにそれだけです。

だからこのHニューロンを、LLMまたはビジョン言語モデルが展開する小さく高効率な特殊部隊チームのHニューロンとして見てください。事実的知識ベースで行き詰まるたびに、それから絶対的なハードコアな知識ベースから出て少し想像するために柔らかい橋が必要になります。

だからこの最小値から出てきて、次の最適化プロセスにロールバックしています。これが私の解釈です。もしあなたがそれについて笑うなら、理解します。私も笑っています。

しかしそれ以外では、数学が少し重すぎます。これについてもっと私の次のビデオで。私はこれがパート1の終わりだと思います。概要を提供したかっただけです。

もしAIがなぜ幻覚を見るのかという主なアイデアを理解すれば、幻覚をフィルタリングできないことを理解するでしょう。幻覚を削除できません。幻覚に対処できません。なぜならそれは創造性、推論の本質的な特徴だからです。

LLMに「幻覚を見ることは許されない」と伝える強化学習によって幻覚を制限することはできません。これは子供じみています。それはその推論プロセスの複雑さの本質的な部分です。

しかし別の研究があります。別の研究があります。偶然にこの研究を見つけました。しかしこれはパート2になります。

彼らは病院または病院で臨床ビジョン言語モデルにHニューロンを見つけ、Hニューロンの現実世界アプリケーションにおける驚くべき接続性を見つけました。しかしこれについて詳しくは、このビデオのパート2で。

パート1を楽しんでいただけたことを願っています。この論文を読むのは本当に驚きでした。

もし楽しみたいなら、自分で論文を読んでください。豪華です。気に入るでしょう。なぜ購読しないのですか?私のチャンネルのメンバーになるかもしれません。そして次のビデオでお会いしましょう。

コメント