Moonshot AIが発表したKimi K2 thinkingは、これまでで最高のツール呼び出し性能を持つオープンウェイトモデルである。1兆パラメータという巨大なモデルサイズでありながら、Humanity’s Last ExamやBrowser Compで最先端のスコアを記録し、コード関連タスクではGPT-4oやClaude 4.5 Sonnetと肩を並べる性能を示している。200から300回の連続したツール呼び出しが可能で、英語ライティングの質においても米国の主要モデルを上回る評価を得ている。ただし、594GBという巨大なモデルサイズによる実行の難しさや、ライセンスに関する制約など、いくつかの注意点も存在する。中国発のAIモデルが欧米の大手ラボに匹敵する性能を示すことで、AI業界の競争が新たな段階に入ったことを象徴する重要なリリースとなっている。

Kimi K2 thinkingの登場

見る価値のある新しいオープンウェイトモデルが出てくるまで、しばらく時間が経っていました。そしてMoonshotが作り出したものは、本当に見る価値があるものです。これは私がこれまで見た中で最高のツール呼び出しモデルです。そう、オープンウェイトモデルというだけでなく、全てのモデルを含めて最高なんです。

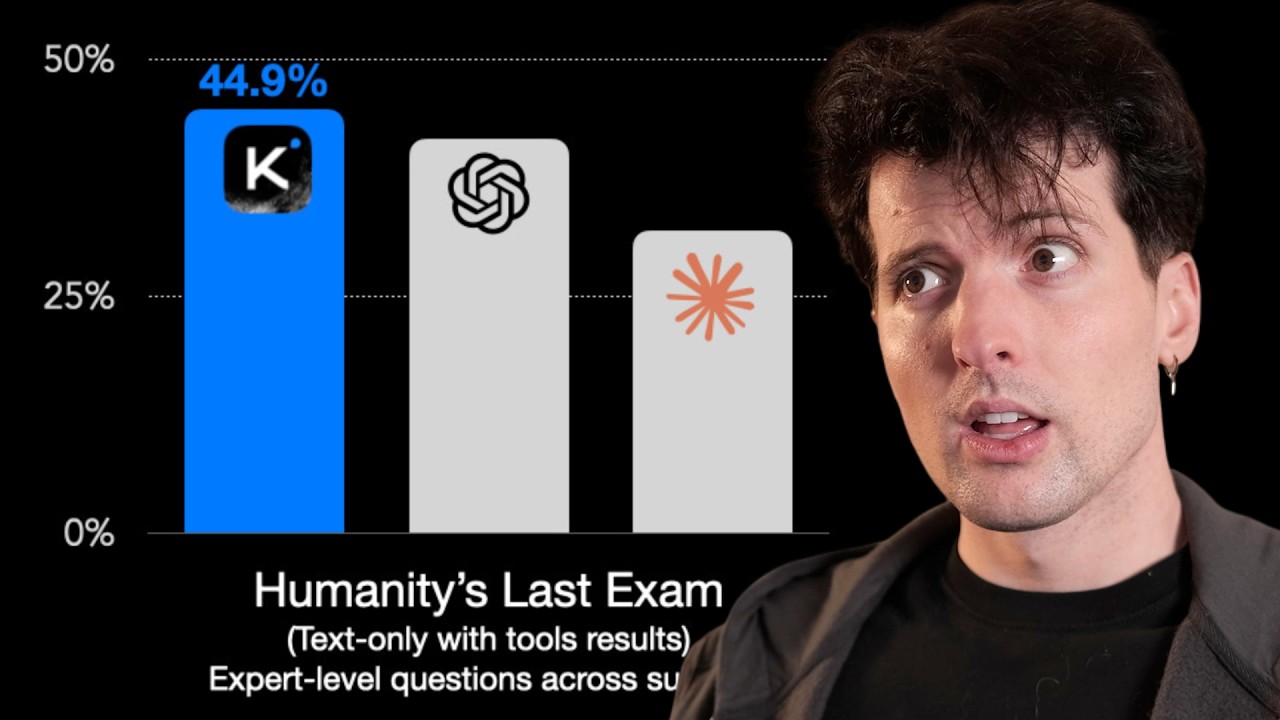

Humanity’s Last Examで圧倒的な成績を収め、最先端のスコアを獲得しているだけでなく、Browser Compでも優れた結果を出しています。コード関連のタスク、例えばSWE bench verifiedやLive CodeBenchなどでは、GPT-4oやClaude 4.5 Sonnetといった他の優れたモデルと互角に渡り合っています。このモデルは本当にすごいんです。

人間が介入することなく、200から300回のツール呼び出しを連続して実行できるんです。これは本当にクールです。そして、これがオープンウェイトモデルであることを考えると、楽しめることがたくさんあります。

ただし、これら全てには注意点があります。特にオープンウェイトの部分についてです。彼らが行っているライセンスについて話すまで、必ず最後まで見ていてください。これは大きな注意点の一つです。でも本当に、新しいモデルのリリースでこんなにワクワクしたのは久しぶりです。

この2日間、かなり使い込んできました。他の報道や、他の人たちがどのように使っているかも見てきました。Moonshotは私にモデルのテスト用のクレジットを提供してくれましたが、私は自分のお金を使うことを選びました。彼らの製品をレビューする際には、無料クレジットであっても、彼らからお金をもらわない方がいいと思ったからです。

このビデオで私にお金を払っているのは、今日のスポンサーだけです。今日のスポンサーはTupilです。Benとペアプログラミングをするための最高の方法です。

Kimi K2 thinkingの詳細

私は広告を撮影しようとしているんです。私のコンピューターを制御する必要があります。実際に今Tupilを使っているんですが、これによってBenは単に…でもBen、広告を撮ろうとしてるんだって。

真面目な話、これは本当にクールです。さっきたくさん遊んでいたんですが、同じソファに座っているだけなのに、同僚とこれだけやり取りできるというのは驚きです。彼は私のコンピューターで好きなことができるんです。いや、Ben、やめて。私たちは同時に使ってるんです。

シンプルなアプリをインストールしただけで、実際に共同作業ができるようになりました。Ben、私の銀行口座にお金を送ろうとするのはやめて。十分な給料払ってるでしょ。さっきCursorで使っていたんですが、ボタンをクリックできるだけでなく、画面に描画したり、物を指差したり、同僚と話したりできるのが本当にクールでした。

こういうものがずっと必要だったんです。私はずっとペアプログラミングの大ファンなんですが、そのためのツールが十分にないんです。ZoomやSlackで画面共有するのはやめて、開発者として共同作業や協力をするために実際に作られたものを使いましょう。さっきこれで遊んでいたとき、とても感動したので実際に携帯を取り出して少し話をしました。

それで、今見ているであろう広告のために、ちょうどTupilをテストしていたところです。これは不思議なくらいクールだったと、みんな言えますよね? そうですね。実際に使おうと思います。これをチェックしてみてください、みんな。真面目に、Sveltは使ってません。いや、ダメです。Pythonかな。

でも真面目な話、同僚をからかいたい人も、より良いペアリング体験をしたい人も、Tupilには驚かされています。今すぐ slidv.link/tupil でチェックして、チェックアウト時にコードTheoを使えば、最初の3ヶ月が90%オフになります。

モデルの仕様とベンチマーク

では、Kimi K2 thinkingについて何を知っておく必要があるでしょうか。明らかに、これは彼らが以前にリリースしたモデルの思考バージョンです。そして、これは持つかもしれない影響という意味でも、モデルの途方もないサイズという意味でも、かなり大規模なものです。

Hugging Faceのウェイトを見てみると、このモデルが少し馬鹿げたほど大きいことがわかります。モデルは594ギガバイトあります。1兆パラメータで、これまでに作られた最大のオープンウェイトモデルです。INT4量子化されているので実行しやすいはずですが、1兆パラメータで590ギガバイトもあるので、実行するのはかなり難しくなります。

そして今のところ、私が見た限りでこれを実行している唯一の人々は、MoonshotのKimiチーム自身だけです。そう、Open Routerを見ると、今のところホストはMoonshotだけです。彼らはホストを分けていて、標準版は比較的手頃な価格で、入力が100万あたり60セント、出力が100万あたり2.50ドルですが、18TPSしかありません。

それよりさらに低くなることもあります。また、ターボ版もあり、こちらはかなり高額です。入力価格は約2倍の1.15ドル、出力価格は約4倍の100万あたり8ドルです。ただし、85TPSが得られます。価格は高速版のGPT-4oと似ています。でも低速版はGPT-4oよりもさらに遅いです。

正直なところ、これとGPT-4oの比較は今考えると面白いですね。動作が似ているんです。多くの点で完全に互角のレースです。でもOpenAIのGPT-4oは30TPSで、選べるターボ版もあります。ここでは提供されていないと思いますが。

そう、ここにはありません。より速いGPT-4oを使う方法があるのは知っていますが、あまり試したことはありません。でもこの分け方はOpenAIを思い起こさせます。ここでの類似性は面白いです。MoonshotがOpenAIになろうとしているように感じます。DeepSeekやある程度GLMは、ClaudeやClaude Codeタイプのanthropicの戦略をやろうとしていて、そしてMiniMaxは独自の道を行って成功を収めています。

MiniMaxのモデルについてももっと話す必要がありますが、今ここで話すのはKimi K2 thinkingで、それには十分な理由があります。ベンチマークを見ると、かなりすごいんです。Artificial Analysisによると、これは主要なオープンウェイトモデルです。

Artificial Analysisを見ると、彼らが持つ2番目に高いスコアのモデルがオープンウェイトモデルだというのはかなりクレイジーです。それはすごいことです。確かに、彼らのIntelligence Indexは最高のベンチマークではありませんが、価値を得られる実際のベンチマークではあります。そこまで到達しているのを見るのは驚異的です。

でもスピードは最悪です。だから、チェック・アンド・バランスですね。その実行について他に最悪なのは、使用したトークン数です。Artificial Analysis Intelligence Indexで史上最高のトークン数を使いました。1億4000万トークンです。かなりクレイジーです。

本当にトークンを食うんです。Grok-4とその混沌を思い出させます。トークンを過剰に使うようなことをするんです。トークンインフレは現実です。これらのモデルが推論によってどれだけ賢くなっても、こういうことをするんです。

推論トークンと非推論トークンの分割を見ると、あまり良くありません。1億3000万の推論トークンは馬鹿げています。比較すると、GPT-4o highで、つまりもっと推論するように指示する推論モードでは、8200万の推論トークンを使います。これは半分強です。Claude 4.5 Sonnetは比較として3400万しか使いません。

一般的に、Claudeのモデルは他の選択肢と比べて過剰な推論はあまりしないことがわかっています。そして、多くの大手ラボとは異なり、全ての推論データを提供してくれます。だから、anthropicには感謝です。他のみんなは推論を難読化しています。

明らかに、オープンウェイトモデルではそれはできません。だからやっていません。でも、トークン使用量をコストと比較すると、もっと面白くなります。GPT-4oはトークンあたりの価格が高いので、突然ずっと前に出ます。多くの他のモデルほど高くはありませんが、ここでぶつかるほどには高いです。Claude 4.5 Sonnetも同じです。

使用トークン数が半分にもかかわらず、それでも5番目に高価なオプションです。Grok-4は常に、高すぎるコストで無意味な答えを提供する王様です。クラシックなままでいて、イーロン。

では、私たちの新しいモデルはどこにあるでしょうか。ああ、ここにあります。Kimi K2 thinkingはたったの380ドルです。つまり、このベンチマークで圧倒しているにもかかわらず、Claude 4.5 Haikuと同等の価格設定ですが、私が見た限りでは、コードではそれほど良くないようです。

コーディング性能のテスト

さっきKilo Codeを使ってコーディングを試していたんですが、私の画像生成テスト用に複数のファイルを生成しました。モデルがUIをどう扱うかを見るために作るのが好きな、偽の画像スタジオです。そしてこれがその見た目です。

Next.jsを使っている人なら、このページを見覚えがあるでしょう。なぜなら、これはNext.jsプロジェクトを開始する際のデフォルトページだからです。実際にはそのファイルに触れていないんです。作成したコンポーネントをどこにもマウントしていませんでした。だから実際には見ることができません。

それを思い出させてあげましょう。作成したコンポーネントを実際にホームページにレンダリングする必要があります。笑 レイアウトに触れ、CSSに触れました。たくさんの小さなことをやって、実際にコンポーネントをページに配置しなかっただけです。

実装の詳細については、私が見た中で最高のコーディングモデルではありません。少し遅いです。最初のリクエストは確か10分くらいかかりました。でも安かったです。たったの0.5セントでした。

思考しているのを見ると、進んでいます。動いています。以前はもっと遅かったんです。彼らはパフォーマンスの問題があることに気づき、Open Routerがそれがどれほど悪いかを示していました。意外なことに、問題を引き起こしていたのはGPU数ではありませんでした。IP帯域幅だったんです。

ライティング品質のテスト

これが生成されている間に、モデルが他にすることについて話したいと思います。Moonshotチームはライティングの質を非常に重視しています。これは、このチームが中国を拠点としていて、英語のライティングの質と一貫性を最適化していることを考えると、かなりクレイジーです。

それがどんな感じなのか気になったので、楽しいテストプロンプトを出してみました。Javaプログラミング言語の説得力のある擁護論を書いて、人々がそれについて嫌う主な点を扱うように頼みました。しばらく推論して、結果を生成しました。約12TPSで、実際にかなり良い読み物になっています。

Theo、正直に言いましょう。Javaはみんなが嫌うのが大好きな言語です。テック業界のお気に入りのサンドバッグ、エンタープライズソフトウェアの怪物、開発者が冗談を言うのが大好きな冗長なボイラープレート工場です。でもね、問題は、ほとんどの嫌悪感は10年間存在していないバージョンのJavaに根ざしているということです。

現代のJavaはステルスのパワーハウスで、批判はますます時代遅れになっています。主な懸念事項に正面から取り組みましょう。馬鹿げたほど冗長。古い現実、新しい現代の現実、コード例。それだけです。1行のレコードが、コンストラクタ、equals、hashCode、toStringを自動的に持つ不変データクラスを提供してくれました。パターンマッチングを加えれば、さらにエレガントになります。

なるほど、実際にかなり良いですね。このモデルがJavaについて私を納得させようとしているとは言わないでください。比較のために、GPT-4oとSonnetで推論をオンにして同じプロンプトを実行しました。最初に気づくのは、箇条書きとリスト地獄にいるということです。GPT-4oはリストが大好きですが、Sonnetは歴史的にライティングで少し良かったはずです。いいえ、全部クソみたいなリストです。

なぜ中国のモデルが、類似のモデルを作っているアメリカの企業よりも、説得力のある形で英語を書くことが上手なのでしょうか。かなりおかしいです。

Javaはたくさん批判されますが、ほとんどの批判は時代遅れの認識やその設計哲学の誤解から生じています。Javaがもっと尊重されるべき理由がここにあります。冗長すぎるが、冗長性には価値がある。そう、Javaは冗長ですが、冗長性は実際には明示的な明確性です。いや、これは良い擁護ではありません。そして大量の箇条書き。

Javaは遅い。2024年へようこそ。この批判は2004年に留まっています。HotSpot JVMはパフォーマンスの驚異です。比較すると単なる恥ずかしいものです。ここに、有用な苦情に正面から取り組むJavaの率直な擁護があります。

短いバージョン、あなたが想像しているJavaは2005年のJavaです。人々が実際に出荷して実行している今日のJavaは、速く、現代的で、より安全で、10年間コードが生き続けることを期待するチームのために設計されています。これは良くありません。

変ですが、Kimi K2は今後しばらくの間、T3 Chatでの私のデフォルトモデルになると思います。ちなみに、新しいMiniMax M2バージョンのPolaris Alphaという楽しいステルスモデルや、ターボオプションが有効な新しいKimi K2 Thinkingを含む、すべてのモデルへのアクセスが欲しい場合。

月8ドルなんですが、悪いニュースがあります。なぜなら、今なら最初の月はたった1ドルだからです。チェックアウト時にコードKimi K2を使えば、最初の月が1ドルになります。今すぐT3 Chatでチェックしてください。私たちはこのアプリに多くの労力を注いでいます。

さて、コードが完成しました。見てみましょう。うん、良いとは言えませんが、見えますね。KimiモデルがUIが得意だと多くの人に言われました。彼らを嘘つきと呼びます。それはひどいです。タイトルがポップしているのが見えますか。ああ、ダメです。

プランニングモデルとしての評価

でもコードには、コードを書くこと以上の部分があります。このモデルをプランニングモデルとして使うことについて、本当に良い話を聞いています。Kiloのようなツールでは、アーキテクトを設定でき、さらに異なる部分を行う複数のモデルを設定することもできます。これは本当に楽しいことです。

将来もっと試してみたいことで、AI Code Kingのような他のクリエイターが本当に力を入れていることを知っています。彼のビデオから抜粋を取りましょう。

プランニングモデルとしてGPT-4o codecsを使っています。大きなモデルには独自の利点があります。私のテストでは、GPT-4o codecsと非常に似たパフォーマンスが得られます。デバッグとプランニングには、GPT-4o codecsをたくさん使っています。これは最高のモデルです。

初期のテストから、プランニングモデルとしてGPT-4o codecsを置き換えるためにKimiを使えるようです。大きなモデルには独自の利点があります。大量のエラーが何を意味し、どう修正するかを理解するようにトレーニングされているので、デバッグが得意です。通常は速いです。

Code Kingのモデルに関するビデオは本当に良くて、私自身がこれをカバーする準備をするのに間違いなく役立ちました。あらゆる種類のコードタスクでどのように機能するかの詳細な分析が欲しい場合は、ぜひ彼のビデオをチェックしてください。とても良いものです。

もう一つ、とても気になったので、これをSkatebenchに対して実行してみました。ライティングと思考と英語が得意なら、これも得意なはずですよね。そして60%を取りました。これはかなり良いスコアです。

スケートトリックの命名において、これまで作られた最高のオープンウェイトモデルです。DeepSeekは驚くほど良いです。中国のモデルはこれが本当に苦手だと見てきました。実際に、ベンチマーク自体の詳細を共有する前に、多くの研究者が連絡してきました。QwenやGLMのようなモデルがこれ以前にどれほどひどいパフォーマンスをしていたかについてです。

多くの人がそれを見たがっていました。そのギャップを測定するのが難しいからです。そしてほとんどのベンチマークで、QwenとGLMは単にベンチマークで勝つのに、使うのは最悪です。そして、これは彼らがそれらのモデル間の違いを明確にした数少ないベンチの一つだと言っていました。これは設計による偶然でしたが、クールです。

そして人々がそこに価値を見出してくれて嬉しいです。コストも非常に興味深かったです。Kimi K2 thinkingは、私がこのベンチを通して実行したモデルの中でより高価なものの一つだと思いました。GPT-4oは実際には驚くほど安いです。その間あまり推論をしないからです。

そしてGemini 2.5 ProとGrok-4は比較してかなり高価です。隅にGrok-4がどれだけ離れているかがわかります。一方、GPT-4oは7でした。Kimi K2 thinkingは大量の推論をしたのでずっと高くつきましたが、それでもかなり良いスコアを得ました。面白いですね。

必ずしも最高のベンチマークではありませんが、クールだと思います。だから作ったんです。結果は魅力的です。中国のモデルがライティングのユースケースでこれほど支配的になっているのは、まだ私にとってかなりクレイジーです。

これはOpen Routerのロールプレイングカテゴリーで、DeepSeek 3.1とV3はロールプレイの最大のモデルの2つです。これは私にとって面白いです。R1もまだここにあります。そう、非常に興味深いです。だから、このパターンを見るのはあまり驚くべきことではありませんが、それでも私の意見では非常に興味深いです。

ライセンスと技術的詳細

ライセンスのことに入る前に、もう少しカバーしたいことがあります。必ずそこまで見てください。なぜなら、それは私がこれまで見た全ての人から、カバーされていないか、間違ってカバーされているかの重要な詳細だからです。

これはInterconnectsの素晴らしい記事で、多くのことに触れていますが、興味深い部分の一つは、エージェント的なツール使用のためのインターリーブ思考です。これは、Anthropicがしばらくサポートしてきた新しいパターンで、応答中に再度思考を開始できるようにします。

全く新しい応答をゼロから開始する代わりに、しばらく推論に移行してから次のことをすることができます。残念ながら、ほとんどのツールはこれをサポートしていません。Open Routerも含めて。つまり、Open Routerでテストしている場合、これは見えていません。

Open CodeやKilo Codeのようなものを使っている場合も、これを得られていません。Kimi CLIも今は壊れているらしいです。試す機会はありませんでしたし、私が必要とする最後のものは、テスト用のさらに別のAI CLIです。

Claude Codeをハックして使うと、それができてかなりうまく機能すると聞きました。自分では試していませんが、興味があれば試す価値はあります。私が知る限り、これまでこれをサポートしているモデルは、Claude、MiniMax、そして今やKimi K2 thinkingだけです。だから、これのサポートが増えるのは見ていて嬉しいです。

このパターンは今後、特に来年にはずっと一般的になると予想しています。このリリースの核心的な反応は、人々が、DeepSeek R1がo1を素早く追いかけたのと同様に、これは01以降、オープンモデルがクローズドのフロンティアのパフォーマンスに最も近づいたものだと言っていることです。

これはかなり真実ですが、複雑な領域に入っています。モデルを比較するのが難しくなっているからです。明確にしておきますが、これは全てオープンモデルに有利です。Kimiのサーバーはすでに完全に圧倒されていると聞いています。それについてはもうすぐ詳しく。

そう、それは本当の問題です。これがみんなが興奮している大きなオープンウェイトモデルなので、今すぐ誰もがサポートしていると思うでしょうが、まだ誰もしていません。それは、これがホスティングに多くの楽しい癖を持つ巨大なモデルだからです。

INT4のことは簡単にしますが、インフラがそれに対してプロビジョニングされていない場合は難しくもなります。その上、Moonshotの人たちはベンダーの検証について非常に厳格です。もちろん誰でもモデルをホストできますが、彼らがツール呼び出しにこれほど力を入れているという事実と、多くの情報プロバイダーがツール呼び出しを正しく動作させていないという事実のためです。

ちなみに、私はこれで地獄を往復してきました。検索ツールをT3 Chat上の全てのモデル、特にOpen Routerのものでうまく動作させようとするのは、楽しくありませんでした。異なるモデルプロバイダーが構文を異なる方法で尊重したり、尊重しなかったりするからです。

だから、Moonshotチームは実際に異なるプロバイダーをベンチマークして、どれだけ一貫して正しくツールを呼び出せるかを見るための検証ツールを構築しました。80%以上の一貫性を超える全てのプロバイダーがここにあります。

そして、私が本当に好きなGrock with a Qのような他のものでさえ、68%くらいしか達成していません。だから、明らかにMoonshot公式のホスティングが最も信頼性が高いでしょう。Deep Infraがわずかに彼らを上回っているようで、クールです。そして、一貫性が異なる多くの他のホストがここにあります。

これらのモデルをホスティングして、これらの特定の動作すべてでうまく機能させるのは簡単ではなく、すべてが落ち着くまで1、2ヶ月かかることがあります。だから、他のプロバイダーがこれをうまく機能させるまでには、もう少し時間がかかると予想しています。

データを誰が取得するかに敏感な場合、繰り返しますが、Moon.aiは中国の会社なので、もう少し待たなければならないかもしれません。このモデルについて話したいことがたくさんあります。非常に興味深いです。

InterconnectsのこのNathanの記事は本当に良いです。この記事を書いてくれてありがとうございます。たくさんの小さな宝石が含まれています。Kimi K2がライティングを修正するために、定性的データに対して強化学習をどのように行ったかへのリンクも含まれています。

彼らは本当にライティングを良くすることに気を配っていて、それは表れています。私が使った中で最高のライティングモデルの一つで、しばらくの間チャット用のデフォルトになるでしょう。どうやら、このモデルのトレーニングにかかったのは460万ドルだけだそうです。

明確にしておくと、そのコストは、この特定のウェイトセットを生成した1回の実行だけのものです。これらには考慮すべき他の多くのコストがあります。でも、彼らがこれを無料で提供していることも考えると、かなりすごいです。

このようなタイプの仕事を無料で入手して、ダウンロードして、実行が難しくても好きなように使えるのは本当にクールです。ただし注意点があって、これがライセンスについて話す必要がある部分です。

これはMITライセンスの修正版で、22行目まで全く同じです。そこで彼らはこう言っています。これが唯一の修正だとさえ言っています。私たちの唯一の修正部分はこれです。

本ソフトウェアまたはその派生物が、月間アクティブユーザー数が1億人以上、または月間収益が2000万米ドルまたは他の通貨で同等以上のいずれかの商用製品またはサービスに使用される場合、当該製品またはサービスのユーザーインターフェースにKimi K2を目立つように表示するものとします。

興味深い追加です。これは、他のサービスがKimi K2を使い始めて一定数のユーザーを持つ場合、Kimi K2がそれを動かしていることを目立つように表示することが期待されることを意味します。これはいくつかのケースを奇妙にします。

例えば、Kimi K2を蒸留したり、特定の方法でファインチューニングして独自の製品を作ったりする場合、それでもKimi K2と呼ばなければならないのでしょうか。そこでどう線を引くのでしょうか。興味深い質問です。

とはいえ、LLMが背後にあるものを使っているときに、どのモデルを使っているかを知っておくべきでしょう。また、T3 Chatではすでに準拠しているので、月に2000万ドル以上稼いでいるかどうかはわかりません。おそらく推測できるでしょう。私たちはそれほどリッチではありません。

とはいえ、これらの一つに追加する最悪のものではありません。Llamaモデルでさえこのようなライセンスの注意書きがあります。これらのファイルを無料で提供して、好きなようにさせてくれるのはかなりクールです。ほとんどのサービスはとにかくモデルの名前を入れるでしょう。

彼らがこれをやっている理由は理解できます。合理的だと思います。ファインチューニングやポストトレーニングがどうなるかについて、より良い注意書きがあればいいのにと思いますが、これは公平です。今後、こういったオープンウェイトモデルがこの種のことをもっとやることを予想しています。

この記事からもう少し素早く触れたいことがあります。本当に良い記事で、読む価値があると思うからです。最初のポイントは、オープンモデルがより速くリリースされるということで、これは本当に興味深いことです。

クローズドとオープンモデルのパフォーマンスのギャップは縮まっていて、その多くはモデルが出てくる速度から来ています。OpenAIが5.1をドロップするのを積極的に待っていますが、最近それについて多くの噂を見ました。そして、Googleがどこにいるのかまったくわかりません。

Gemini 3はどこにあるんでしょうか。9月という早い時期に出るという噂を聞いていましたが、延期され続けているように感じます。進歩のペースが速いとき、モデルを早く出せることが良く見えるようにします。絶対に。

これらの革新の多くは全てのラボで起こっていますが、最初にモデルを出した者が最大の革新者のように見えます。彼らはインターリーブ推論の発明者ではありませんが、最初にそれを行った者の一人です。だから彼らがそれに力を入れているように見えるでしょう。

別の興味深い点は、まず主要なベンチマーク、その後ユーザー行動です。これは中国のラボが多く焦点を当ててきたことで、可能な限り最高のベンチマークスコアを取得することです。DeepSeekやKimiのように良いテイストを持つこともできますが、多くはそうではありません。

だから私はしばらくの間Qwenに厳しくしてきました。ベンチマークでは勝っていましたが、使うのが本当に最悪だったんです。でもこの1年で、Qwenはこの移行を経てきました。彼らのモデルは元々ベンチマークスを最大化することで知られていましたが、今では実際に使うのが素晴らしいです。

まだあの狂ったようなベンチマークスコアを持っています。この流れに沿って、K2 thinkingモデルは、実際のサービングタスクにずっと対応しやすくするために、ネイティブで4ビット精度でポストトレーニングされました。おそらく、長いシーケンスでのポストトレーニングで強化学習のスケーリングをより効率的にするためにこれを行ったのでしょう。

中国のラボは圧倒的です。年の初めには、誰も彼らを知りませんでした。つまり、昨年の終わりには、私はDeepSeekの大ファンでした。彼らが大好きです。彼らが投稿している研究は信じられないものです。

今最高のモデルを持っていないことは知っていますが、それは決して彼らの目標ではなかったようです。彼らは本当に研究とモデルの作り方に集中したかっただけのようです。R1は彼らの新しい思考方法がどのように機能するかのデモに過ぎず、それ以来みんながそれをコピーしています。

そしてインターリーブ思考の部分。このリリースについて人々が話していることの一つは、Kimi K2 thinkingがクエリに答える際に何百ものツール呼び出しを使用する方法です。ブログ投稿から、Kimi K2 thinkingは、複雑なタスクを解決するために何百ものステップを通して一貫して推論しながら、人間の干渉なしに200から300の連続したツール呼び出しを実行できます。

これは多数のツール呼び出しの能力を持つ最初のオープンモデルですが、o3やGrok-4などではある程度標準的なものでした。Grok-4はこれが得意ではありません。それはクソみたいな嘘です。

この種の動作は、RL訓練中に自然に現れます。特に、モデルが正しい答えを得るためにそれを見つけるために検索する必要がある情報に対してです。だから、これは技術的には大したことではありませんが、オープンモデルで見られるのは楽しいです。

真面目に、これはお金と時間がかかることの一つで、ツール呼び出しを正しく行うまでモデルを何度も何度も再実行し、それに報酬を与えて、これらの奇妙な構造や形やJSON構文でツールを使って動作させるためのものです。

これがオープンウェイトモデルにあるのは本当にクールです。そう。そしてインターリーブ思考がサポートされているのも本当に楽しいです。それについて考える最も簡単な方法は、それを持たない通常のモデルを取ることです。考えて出力します。再実行します。考えて出力します。再実行します。考えて出力します。

そしてそれらの結果を取って、それを強化データとしてフィードバックします。結果として、今では自分でそれができるようになります。同様に、パラレルツール呼び出しも同じ方法で実現されつつあります。そしてこれら全てがアメリカのラボに圧力をかけています。

これから多くのラボが出荷するのを期待してください。これが年末だからというだけでなく、今出さないと来年まで待たなければならないからです。でもまた、これは彼ら全員にとって本当に怖いことです。覚えておいてください、Artificial AnalysisでKimi K2 thinkingよりも高いスコアを持つモデルを持っている唯一のラボはOpenAIです。

今、他の全ては遅れています。そしていくつかのベンチでは、Kimi K2がこれまでで最も賢いものです。彼らがこれをオープンウェイトモデルとして提供して、私たちが使って遊べるようにしているという事実は本当にクールで、実行が難しくても、私がそれのために得ているコードの出力があまり良くなくても、業界の最先端を真に前進させます。

私はこのモデルについてとても興奮しています。T3 Chatでしばらくの間これを毎日使うつもりです。あなたたちも使うことになった場合、どう感じるか本当に気になります。私はこれについて興奮しすぎているのでしょうか、それとも実際にかなりクールなモデルなのでしょうか。

あなたの考えを教えてください。では次回まで、peace nerds。

コメント