本動画は、グラフニューラルネットワーク(GNN)とグラフアテンションネットワーク(GAT)を知識グラフとGraphRAGシステムと組み合わせ、LLMの推論能力を向上させる最新のAI研究手法について解説している。特に映画推薦システムを例に、個人の嗜好を学習する高度なパーソナライゼーション技術の実装方法を詳細に説明し、LoRAアダプターを用いたファインチューニング手法まで包括的にカバーした技術解説である。

導入:グラフニューラルネットワークとAI推薦システム

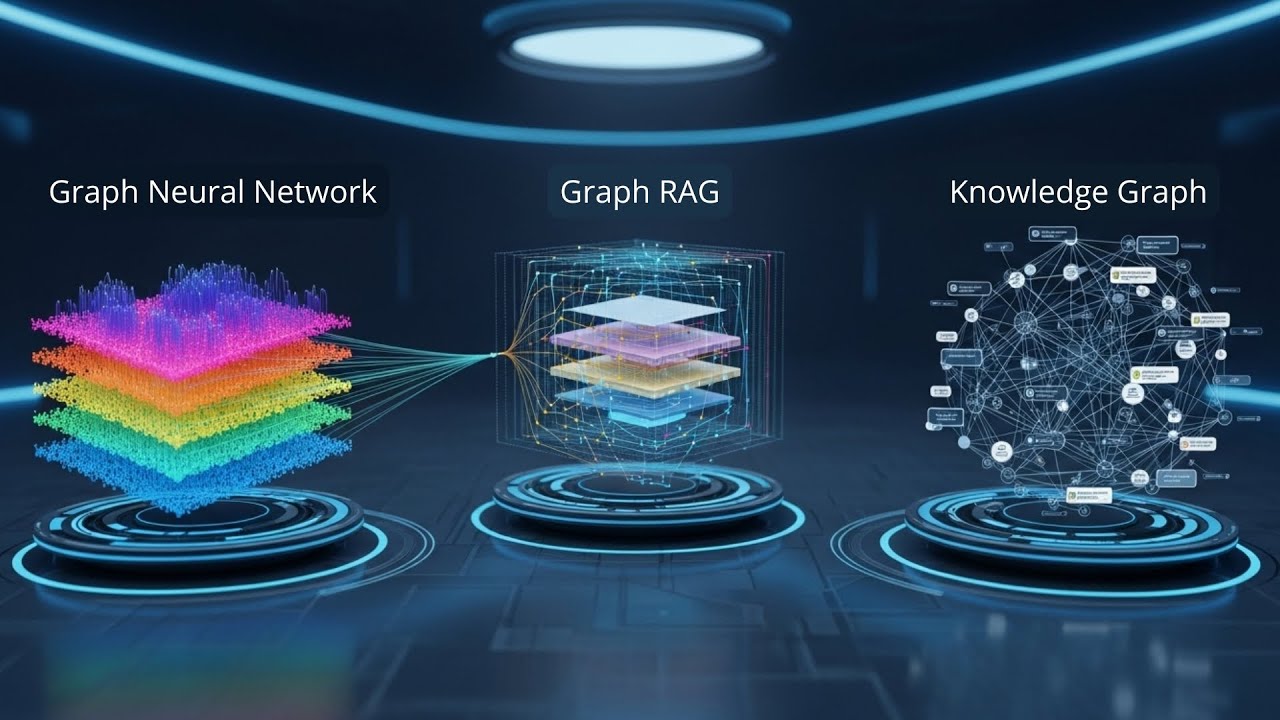

こんにちは、コミュニティの皆さん。お帰りなさい。本日はグラフニューラルネットワークについてお話しします。これを特殊なグラフRAGエンジンと組み合わせ、知識グラフにマッピングして、エージェントを最適化したいと思います。簡単ですね。これはAI研究の最新技術であり、パーソナライゼーション機能が強化されたシステムを求めています。

では、何を行うのでしょうか。グラフRACKシステム、知識グラフ、グラフニューラルネットワークなどの要素を使用します。特別なLLMファインチューニングと新しい研究論文があり、これは絶対に素晴らしい動画になるでしょう。なぜなら、私たちにはスマートな推薦システム、特にAIシステムが必要だからです。

最もシンプルな例を考えてみてください。あなたに映画を推薦してくれる人がいるとします。Llama 3.1に尋ねてみると、これは幅広い知識を持っていますが、深くはありません。あなたについて、あなたが何を好むかなどについての知識がないのです。

ですから、これらすべてを統合する必要があります。簡単な例として、ここに知識グラフがあります。この知識グラフには、すべての映画、すべての属性、映画の名前、すべての監督、ジャンルの名前、脚本家など、完全な情報が含まれています。そして、この知識グラフ上で動作するオペレーターがあり、このオペレーターはグラフニューラルネットワークです。しかし、どんなGNNでもありません。

グラフアテンションネットワーク(GAT)の詳細

ここではメッセージパッシングGNNとグラフアテンションネットワークがあり、これをGATと呼びます。これは、GPTシステムから知られているアテンション機構を利用して、個人レベルで好まれる接続を学習します。ここでは知識グラフ上の個人ネットワークについて話しており、期待される出力は、新しく数学的に構築されたベクトル空間でのノード、そして場合によってはエッジに対するベクトル表現、またはフィーチャーベクトル埋め込みと呼ばれるものです。

非常に専用のグラフニューラルネットワーク、関係グラフ畳み込みネットワーク、または構成ベースのGCNがあります。なぜなら、これらの知識グラフはすべて非常に多関係グラフだからです。GCNの古典的な公式は知っていますが、アテンションについてはどうでしょうか。GATについてはどうでしょうか。何が違うのでしょうか。グラフアテンションネットワークの特別な点は何でしょうか。

完全なストーリーを見たい場合は、私が2年前に作った動画があります。これはGCNとGATでのポテンシャル測定パッシングについてのものです。

一般的に言えば、標準的なグラフニューラルネットワークでは、近隣からのノードフィーチャー集約は均一または正規化された隣接行列で事前定義されています。しかし、GATでは、これを学習された適応的アテンション機構に置き換え、集約中に各近隣を動的に重み付けします。

私たちは、メッセージパッシングをアルゴリズムとする知識グラフにおいて、各近隣に関するコンテキスト固有の重要度スコアのアテンション機構を実際に学習しています。これらが概念化されたノード埋め込みのためのGATを定義する公式です。

関係グラフアテンションネットワーク

さらに高次元に進む必要があります。関係グラフアテンションネットワークに進む必要があります。なぜなら、知識グラフが多関係であると言ったからです。

関係タイプごとに学習される別々のアテンション機構があり、関係埋め込みがこの特定のアテンション計算に組み込まれます。ここで連結記号を使用した公式を見ることができます。これにより、モデルはノード間のエッジまたは関係の特定の意味タイプを使用してアテンションを文脈化できます。

学習されたアルファEG重みは、私たちが求めているもの、つまり他の実体にどの実体が影響を与えるかの確率的で解釈可能な視点を提供します。これは、関係タイプに敏感な知識グラフ推論プロセスに有用です。関係を介して接続されたノードの各近隣Jについて、Jがフィーチャーだけでなく、どのようなエッジ、どのような関係がそれらを接続するかを考慮して、次の層表現への貢献においてどれほど重要かを計算します。

GATの出力と動作原理

知識グラフにおける接続性の非常にきめ細かい分析があります。GATの出力は何でしょうか。2種類の出力があります。各ノードに対する埋め込みマップがあります。これには美しいベクトル表現があります。知識グラフにおけるノードの位置を、その複雑さとともにベクトル表現にマッピングしました。

そして示したように、アテンションマップがあります。なぜなら、特にGATを使用してグラフ内のすべてのエッジのアテンションスコアを学習したからです。これは最もシンプルな方法で、マトリックスと監督、脚本家、またはこの映画の何でも、2つのノード間のリンクの重要度をGATがどう考えているかを教えてくれます。

特定のリンクとタイプがどれほど重要かということです。GATの準備が整い、トレーニングセットも用意できました。さあ始めましょう。

システムの動作モード

動作モードを見ると、美しい知識グラフがあります。GATとグラフ畳み込みネットワークについて説明しました。そして、世界中のすべての映画、すべての俳優、すべての監督の知識グラフを分析すべき2つのオペレーター、2つのグラフニューラルネットワークを並行して開始します。

この情報を得て、非常に特別なプロンプトを設計します。このプロンプトは、驚くことなく、インコンテキスト学習でLLMに送られます。しかし、このLLMをLoRAアダプターで特別にトレーニングします。これにより、最高のパフォーマンスを達成する完璧な推薦システムができます。

GATの詳細動作例

面白そうですね。それでは始めましょう。まず、GATの詳細を見てみましょう。事前トレーニングされたモデルGATは、Alexが好きなアイテムを入力として受け取り、アテンション機構を通じて、アルファとドット積の出力を覚えておいてください。ここで最も関連性の高い知識グラフトリプレットを単一で出力し、Alexはこの特定の名前の監督からの映画でもあるため、マトリックスという映画を好みます。

そして、GATはここで私たちのE、つまり正規化されていない生のアテンションスコアを計算し、正規化とソフトマックス関数を実行すると、古典的な方法でアテンション重みアルファを得ます。

マトリックスがあり、マトリックスには多かれ少なかれ2つのエッジがあると想像してください。監督とジャンルがあります。マトリックスの監督に対する生スコアが7.3だとしましょう。これは本当にAlexにとって重要なので、アテンション重みアルファはかなり高い0.65になります。ノードマトリックスに接続されているジャンルSF(サイファイ)についても、アテンション重みは、ここでは簡単にするために2つの近隣しかなく、ソフトマックス関数で1になるとしましょう。0.65と1の差は0.35なので、これはアルファ重み0.35を持ちます。

ご覧のように、アルファは、これがユーザーAlexの好みであることを考慮して、マトリックスが自身の埋め込みを更新する際に監督に払うべきアテンションの割合を表しています。これがパーソナライゼーションにとって特別である理由については、詳しく説明します。

アルファ重みの活用

映画の著者ではなく、新しい研究論文の著者がアルファを最終スコアリング公式で使用して最適なトリプレットを選択する際、5分後に説明しますが、彼らは最終的に計算されたアテンション重みを使用しています。

彼らが使用するトリックは、GATからのアルファを再利用することです。なぜなら、それらは学習された重要度分布として、知識グラフにおける構造的に重要なリンクの関連性スコアを押し上げる乗数のようなものだからです。

これを再度見たい場合は、簡単な要約シートを用意しました。GATは、近隣の埋め込みを単純に平均化する代わりに、重み付き平均関数を実行します。すべてのノートが与えられた場合、どの接続がより重要かを実際に学習し、生のアテンションスコアから始めて、正規化とソフトマックスで正規化されたアテンション重みを得ます。素晴らしいです。

グラフ畳み込みネットワーク(GCN)との並行処理

GATと並行して実行する2番目の操作を見てみましょう。これはグラフ畳み込みネットワークです。これはAlexの個人プロファイルを見て、映画データベースのようなもので映画があり、どの視聴者がどの映画を好んだかもあるので、比較的簡単です。特定のユーザーや視聴者の特性をどのように知るのでしょうか。

ここではGCNで非常にシンプルなクエリを実行します。Alexに似た他の視聴者は誰でしょうか。性別かもしれません、年齢かもしれません、場所かもしれません、教育かもしれません、監督の好みかもしれません、撮影技法の好みかもしれません。ソフトな白黒を好む人がいるかもしれません。アイデアは理解できるでしょう。

スーパーグラフRACKやビヨンドグラフRACK、またはライトRACKとPRAGについてもっと学びたい場合は、動画があります。しかし、この新しいプロセスの次のステップに進みます。これはプロンプトエンジニアリングです。

コンテキストエンジニアリング

しかし、プロンプトエンジニアリングは間違いです。いえ、ここではコンテキストエンジニアリングです。なぜなら、何をしなければならないかを見てください。ICLのプロンプトだけでなく、知識グラフも統合します。知識グラフ上で、プロンプトへのRAG入力を提供する2つのオペレーターがありますが、プロンプトは5分後に示すLoRAトレーニングと一貫性のある特定の方法で構造化される必要があります。

メモリ最適化において、コンテキストエンジニアリングが実際に行われていることがわかりますが、私たちはプロンプトにいました。コンテキストエンジニアリングの小さな部分がプロンプトエンジニアリングです。今それについて話しましょう。

選択された面白いことは、これは非常に特別な選択ですが、出版物に従いましょう。決定論的なレシピがあります。プロンプト構築のための非常に明確に構造化されたコードがあります。

固定テキストがあります。映画推薦システムです。あなたのタスクは、与えられたユーザーの好みに基づいて候補映画の与えられたリストをランク付けし、上位5つの推薦を返すことです。

そして、Alexからのユーザーデータ、好きな映画、嫌いな映画を記入します。次に、すべての映画の知識グラフでのグラフ畳み込みネットワーク分析から来るすべてのものと、GATからのすべての結果があります。Alexの好みのために知識グラフからGATによって抽出されたトリプレットです。

最終的な質問は、もちろん、ユーザーが同じカテゴリの他のユーザーの候補リストをどのようにランク付けするかです。すべての部分を1つの最終プロンプト文字列に結合し、すべてを連結して最終プロンプトを作成します。シンプルで簡単です。

LLMとLoRAアダプターによるファインチューニング

固定テキストテンプレートが必要な場合、もちろん改善できますが、出版物に従います。最も簡単な部分で、LLMを取るか、エージェントを構築したい場合は複数のエージェントを構築しますが、ここではシンプルなLLMに留まり、Llama 3.1を使用します。これにはLlama 3.1用のプロンプトはありませんので、やってみましょう。出力を得ましょう。

そんなに速くはありません、友よ。なぜなら、著者は「ちょっと待って。Llama 3.1は本当に専用ではなく、特にこの特定の仕事のためにまったくトレーニングされていない」と言ったからです。そこで、完全なLlamaをファインチューニングするのではなく、アダプターファインチューニングを行います。

低ランク適応、LoRAアダプターチューニングを使用します。私のチャンネルにはこれについて約10本の動画があります。そして、LoRAでファインチューニングされたLlamaで最終出力を得ます。それで完了です。終わりです。おめでとうございます。それで終わりです。

あなたは「ちょっと待って。LoRAファインチューニングと言いますが、この特定のLoRA層ファインチューニングのためのデータセット、トレーニングデータセットを、古典的なLlama 3.1の上に載せるために、どこから得るのですか?」と尋ねるかもしれません。

データセット生成とトレーニング手法

その質問をしてくれて本当に嬉しいです。LoRAファインチューニング。これは、この新しい研究論文の著者による天才的な動きです。彼らは「完全なフローを定義するだけです。ファインチューニングのために、我々が定義したこの極端なフローを通るデータセットを作成します。唯一の違いは、トレーニングデータセットでは最終結果を知っていることです」と言います。

ゴールデントゥルースがあります。したがって、これは教師ありファインチューニングで、モデルがこれらの好みで訓練することを可能にします。LoRAのファインチューニングには、何千もの例示プロンプトと正しい結果が必要です。

この例示プロンプトは、ちょうど示したように、テンプレートプロンプトです。非常に明確に構造化されたパターンのシーケンスを持っています。LLMパターン認識パターン複製が美しく美しいので、LLMはユーザーの好き嫌いを学習します。Alexはどの映画が好きで、どの映画が好きではないか。そして、知識グラフ分析からのすべて、彼らがヒント1とヒント2と呼ぶもの。そして、この情報をすべて一緒にして、既知の最終結果を与えられた優れた論理的なランキングを作成し、システムはそれを学習する必要があります。

これは、今必要なデータのトレーニングデータです。例えば、MovieLensがあります。ここには3200万の映画評価があります。20万人のユーザーによって評価された映画があります。どのような人がどのような映画を好むかについて多くの洞察があり、これを使用しましょう。

LoRAトレーニングデータセット生成のためのデータ生成エンジンです。始めましょう。

既知のユーザーと履歴を選びます。ユーザーAlexから始めます。Alexはマトリックスが好きで、映画スピードレーサーが嫌いであることがわかっています。両方とも同じ監督からのものでした。監督は、この特定のケースで知識グラフの好みエッジである共通要素ではないことがわかります。

そして、GATとGCNでスペシャリストパイプラインを実行して、プロンプトXを生成します。どのようにこれを行うのでしょうか。履歴データポイントがあります。これまで経験したのとまったく同じことを行います。GAT駆動の検索とGCNヒントがあります。プロンプト内ですべてを組み立てます。

すべてのピースを一緒に取り、正しい答えを知っています。完璧なトレーニングデータセットがあります。グラウンドトゥルースランキングYがあります。これは、知識グラフとGATおよびグラフ畳み込みネットワークからのすべてのデータを含む美しいプロンプトXと、欲しい結果を含む1つの完全なトレーニングデータセットがあることを意味します。

構造的一貫性の重要性

美しさは、ユーザーAlexがこれを好きまたは嫌いという標準データセットではないことです。推論実行で使用するプロンプト生成のテンプレートとまったく同じ構造形式を持つ特定のトレーニングペアを含む非常に特定のデータセットがあります。なぜなら、LLMでのLoRAアダプターのファインチューニングのためのトレーニングデータセットを生成するために使用したテンプレートの非常に正確な構造形式だからです。

トレーニングデータと推論実行のクエリデータにおける絶対的な構造的一貫性が、この方法論からデータ生成マシンを構築できるようにします。このデータ生成エンジンは、これらすべてのデータセット全体でGATを実行します。20万人のユーザーがいて、しかし待って、誰かが特定の人、監督のファンである特定のエッジを見つけることがどのように可能なのでしょうか。

ユーザーがこの監督のために、デル・トロを愛しているとしましょう。知識グラフを見ると、このノードを持つ名前は、この特定の監督による他のすべての映画のユーザーが好きなアイテムのすべての小さくても非常に密接に結ばれたコミュニティを接続するハブになります。

GATアテンション機構は、知識グラフでこの強い構造パターンを検出し、この特定のユーザー履歴、この特定のユーザー名に対して、このコミュニティの直接リンクが最も重要な手がかりであることを単純に学習し、ユーザーが映画を好む理由の監督リンクを他の特性よりも高く評価することを知っています。

具体例:撮影技法の好み

別の例として、この撮影技法ファンがいます。ロジャー・ディーキンスによって撮影された映画の視覚的スタイルです。これがそれです。この視覚的スタイルでなければなりません。すべての映画が、ロジャー・ディーキンスのノードの周りにクラスター化されて凝集しています。

したがって、ユーザーの好みのこのハブに気づきます。GATは、撮影技師スタイルのこの特定のリンクが最も重要であることをすぐに理解します。これらの特性が、特定の人々が特定の映画を好む理由の最も決定的な要因であることがわかり、好みの巨大なセットがあります。

しかし、20万人がいれば、人々が特定の映画を好む理由として可能な好みの80%、おそらく90%を学習できるでしょう。または組み合わせかもしれません。

論文の詳細と評価

今日の論文はこちらです。これは2025年7月8日、英国グラスゴー大学の出版物です。美しいです。なんて素晴らしいモデルでしょう。グラフRACKの新しい高度なコンポーネントから知識グラフ、LM最適化、テンプレート構造化、グラフニューラルネットワーク、グラフネットワークのアテンション公式まで、すべての組み合わせです。絶対に美しいです。

彼らはCaracリトリーバルで新しいグラフRACKコンポーネントと新しい知識グラフ強化指示チューニング方法を設計し、外部知識、つまり知識グラフからのRACKをLLMプロンプトに統合します。これをコンテキストエンジニアリングと呼び、それによってトップジェン実装タスクでのLLM推論を強化します。

グラフRAG、新しいRAG、高度なRAG方法論、指示チューニング方法論、プロンプトの構築方法、完全なプロンプトエンジニアリング、メモリ最適化について少し話し、トレーニング期間から推論実行まですべての構造的一貫性について、すべてが含まれているのは美しくありませんか。

これらすべての要素を統合するのは本当に美しいです。GCNに慣れていない場合は、これがおすすめの論文です。これについてもっと学びたい場合は、しかしここでグラスゴー大学からの彼らのモデルCaracの説明があり、これを見て、いくつかの部分は馴染みがあり、いくつかの部分は新しいものでした。

グラフRACKの新しい要素です。したがって、これを見て、すべての要素を事前に理解できるような導入をすることが役立つかもしれないと決めました。特にDelora adaptersをどのようにトレーニングするかが含まれ、ここでは欠けているように思えるので、この美しい新しい方法論の非常に濃密で短い記法だと思います。

パフォーマンス評価

パフォーマンスについて話しましょう。新しい方法と新しい方法論があります。これは良いものでしょうか。これを見てみましょう。著者は、すでに確立された方法論である4つの異なる推薦アプローチと比較して、Carac推薦システムのトリプル表現の文を評価すると言っています。

フィルタリングモデル、RACK用のBERTのようなシーケンシャルモデル、知識グラフモデル、RACK rankerのようなLLMベースの専用モデルがあります。この新しい方法論をこれらの4つの確立されたものと比較すると、どのような性能を示すでしょうか。

ここにあります。もちろん、最後の2行で太字になっているのがこの新しい方法論です。すべての場所に小さなアスタリスクがあることに気づくかもしれません。この上付きアスタリスクは、結果がCarac結果と有意に異なることを示しています。

とりあえずこれは無視して、何を教えてくれるかの感覚を得るか、最後の行を見てください。著者が教えてくれる改善、実行したすべての異なるベンチマークでの最良ケース改善は、プラス8%、プラス11%、プラス10%、ほぼプラス12%、そしてプラス14.9%です。

改善があることがわかります。なぜなら、多くの作業、多くの最適化、多くのフィルタリング、グラフRACK最適化のための多くの再ランキングを行うからです。そう、それは良いはずです。

知識グラフトリプル形式情報または文形式情報についてお話ししました。この特定のバージョンは、トリプル形式情報のシンプルさを好むようですが、もう1つの事実をお伝えしなければなりません。すぐにRACK rakerです。これに慣れていない場合は、これがおすすめの出版物です。

この論文は、トップkai推薦のランカーとして機能するLLMの指示チューニングに特化したRACK rankerについてです。彼らは美しい研究、アブレーション研究を行い、このビデオの最初から示したステップの一部を統合しなかった場合に何が起こるかを言いました。

アブレーション研究の結果

彼らは「Llama 3なしでCaracリトリーバーがある場合はどうでしょうか。Llama 2に行ったらどうでしょうか?」と言いました。さて、どうでしょう?Llama 2は推論タスクでそれほど良くありません。LoRAアダプターで訓練するLLMとしてLlama 3からLlama 2に行けば、パフォーマンスは苦しみ、低下します。

指示チューニングも重要です。特定の選択とランキングが重要です。これは予想されることでした。予想されなかったのは、これです。これは絶対に魅力的です。

彼らは「ゼロショットまたは少数ショットICLで行くべきでしょうか?LLM推論能力を強化するために十分な関係知識を提供するために、いくつのトリプルを提供すべきでしょうか?」と言いました。そして、テストを実行し、1つ、本当に1つの知識グラフトリプレットが絶対に十分であることを発見しました。

2つにするとパフォーマンスはほぼゼロショットに低下しました。単一のトリプレットが最大のパフォーマンスジャンプを起こし、2つに行くと獲得したパフォーマンスをすべて失うという、このようなことは見たことがありません。信じられない感度です。

「はい、もちろん、これは明らかです」と言えるアイデアがある場合は、このビデオにコメントを残してください。しかし、そうでなければ、LLMの能力改善のための単一のトリプレットだけという絶対に魅力的な現象だと思います。

結論:AIシステムの複雑性

グラフニューラルネットワーク、グラフRACKシステム、知識グラフ、そして特定のドメインデータで微調整するLLMまたはエージェント間の相互作用を見ることができます。この微調整を実行するための完全な構造的一貫性が与えられます。

構築、統合、相互接続、最適化しなければならない複雑さは驚異的です。通常のLLMは、このタスクを単独で解決することはできません。私たちが構築しなければならない構造を見てください。

AIは本当に驚くべきものです。このような動画をもっと見たい場合は、ぜひ購読してください。

コメント