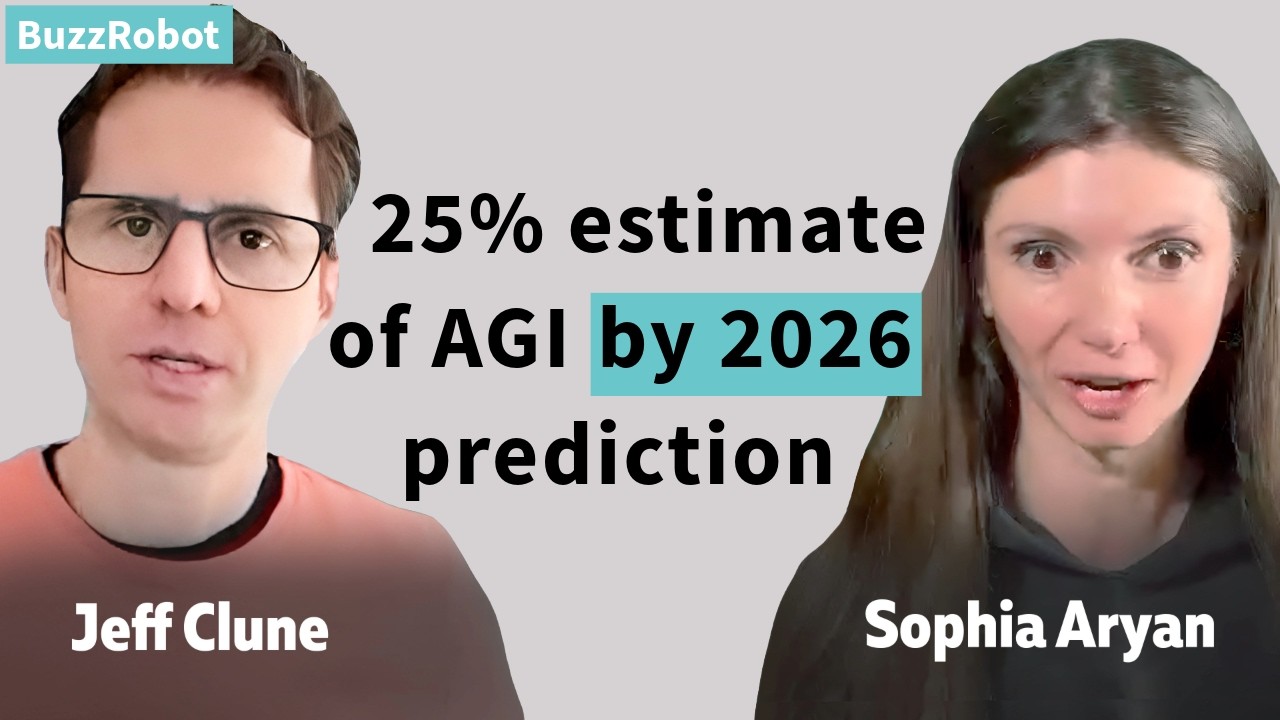

本動画は、Google DeepMindの顧問を務める研究者が、AI の継続学習、AGI(汎用人工知能)、そして AI の将来予測について詳細に語ったインタビューである。研究者は進化的アルゴリズムと開放性(open-endedness)の研究背景から、現在の AI システムが抱える継続学習の技術的課題、特に破滅的忘却の問題について説明している。また、AGI の定義や到達時期の予測、さらには ASI(人工超知能)が登場した際の地政学的影響や安全性の課題についても言及している。特に注目すべきは、最初の AI が最後の AI になる可能性や、国家による AI の国有化といった極めて重要な指摘である。研究者は 2026年までに 25%、2030年までに 50%の確率で AGI が実現すると予測しており、その後の急速な自己改善による社会変革の可能性について警鐘を鳴らしている。

最初の AI が最後の AI になる世界

最初の AI が最後の AI となる世界があり得ます。最初の ASI の創造が世界中の ASI 創造を抑制するとしたら、その組織は、それが誰であれ、決断を迫られることになります。その決断とは、もしその存在が彼らに合致し、彼らの命令に従うのであれば、我々は事実上神を発明したことになる、ということです。我々は座して、あそこにいる人々にも神を発明させるつもりなのか、ということです。

誰もがもっと語るべきなのに、それほど語られていないことの一つは、もしあなたがある国の首相や大統領、国家元首で、あなたの国境内の企業が超兵器、超大国、事実上の神を創造したとしたら、それを国有化するのかということです。彼らに命令を与え始めるのか。全てをあなたに報告させるのか。それとも彼らを普通の企業のように運営させ続けるつもりなのか。私にはそれは非常に可能性が低く思えます。

私は先日、ジャーナリストと話している時にこんな例えをしました。彼は私に「OpenAI やそういった場所にいた時はどんな感じでしたか」と尋ねてきました。私が使った例えは、こんな感じです。あなたは天文学者で、センサーやコンピューターの読み出し装置などの機器を見ていて、あなたと他の少数の人々がこの複雑なデータを見る専門知識を持っていて、「なんてことだ、エイリアンがやって来る。数年以内に地球に到着する」と言えるような状況です。

彼らがどのくらいの速度で移動しているのか、彼らの技術は何なのかは完全には解明していませんが、彼らは間もなくここに来て、それが全てを変えることになるのです。

進化的アルゴリズムと開放性への探求

この特定の質問について、私は常に同じ基本的な問題に興味を持ってきたと思います。現在では、それらを開放性と AI 生成アルゴリズムに関連する質問として説明しています。

機械学習で興味深いことが起こります。会話で「進化」という言葉を口にすると、人々は即座にあなたを進化的アルゴリズムの枠に入れて、通常、あなたが言う残りの言葉を聞かなくなってしまいます。

私が研究をしている限り、私が人々に本当に伝えてきたことは、私にインスピレーションを与えるのはダーウィン進化の魔法です。この惑星で起こったこと、そしてより具体的には、私を魅了するのは、自然界を見回すと、そこにある全ての素晴らしいものが見えることです。ジャガー、タカ、人間の脳、極楽鳥、これらの素晴らしい木々、セコイアなど、そして一つのアルゴリズムが 35 億年間動作して、その素晴らしいもの全てを生み出したのです。

それらのうちの一つ一つ、単細胞生物でさえ、自分自身を組み立てる部品を自己組織化できる、ある種のクレイジーなナノテクノロジーマシンです。それはオークの木やシロナガスクジラを作ることができます。それは一頭のシャチや一頭のシロナガスクジラだけを作ったのではなく、全てを作ったのです。

それは非常に信じられないことで、我々はそれがどのように起こったのか、その魔法がどこから来たのかを研究したいのです。そして我々はそれを行うアルゴリズムを作れるのでしょうか。それが開放性の分野として知られるようになったものです。

しかし、我々が最初に話していた時に、私が進化に魅了され、その魔法を再現しようとしているという事実について話していたとしたら、それが私が本当に意味していたことです。

使用する最適化アルゴリズムが進化的アルゴリズムであろうと SGD であろうと、その他の方法であろうと二次的な方法であろうと、それは達成しようとしていることよりも重要ではありません。

AGI の定義について

AGI について聞かれて、さまざまな定義があるように、AGI とは何かということですが、ここで失望させてしまうかもしれませんが、私は真の定義主義者ではありません。哲学専攻の背景があるからかもしれませんが、だからこそ定義にそれほどこだわらないのです。

基本的にAGI の全ての定義は間違っていて、一部は有用だと思います。多くの異なる定義の様々なフレーバーがあるので、私は一つだけを選ぶことはありません。

しかし、私の考えを共有しましょう。まず第一に、私が AGI で大まかに意味するのは人間レベルの AI です。人間のように、膨大な数のトピックにかなり得意なシステムです。それが一般的な部分です。Alpha Fold や AlphaGo のようなものではなく、膨大な数の異なるトピックを大まかに行うことができ、それら全てで一般的に有能であるということです。

しかし、その定義を突き詰めていくと、人間レベルで膨大な数のトピックになるとはどういう意味なのか、という質問をすることができます。我々は一人の人間について話しているのか、それとも全人類について話しているのでしょうか。全人類というのは実際にはおそらく高すぎるハードルだと思います。

なぜなら、チューリングなどの基礎に戻って「コンピューターで人間の心のように印象的なものを作ることはできるか」と言った時、それが元のアイデアでしたが、そのハードルは人間文明ではありませんでした。ハードルは、ソフィアやジェフ、あるいはチューリング自身のような、印象的なものを作れるかということでした。

ですから、AGI のかなり良いハードルは、典型的な人間とほぼ同等に見える AI だと思います。典型的とはどういう意味なのか、典型的な人間とは誰なのか、と言うことはできますが、あまり細かいことを言いたくありません。しかし、それはかなり公正な定義だと思います。

そのレベルの AI システムがあったとしたら、それは AGI だと言うのが公正だと思います。

別の定義で、本当に測定できるものを求めるなら、私はAGI は基本的に人間がすることをできるものだという考えが好きです。しかし、人間がする奇妙なことがたくさんあって、それはシステムに訓練させたくないかもしれません。

ですから、より公正な定義は、AGI はシステムが 2020 年に人間が報酬を得ていた仕事の大部分を行えるようになった時です。私が 2020 年を選んだのは、それが本当に印象的な AI 以前のようなものだからです。AI が多くの仕事を排除し始める移行を見る前のことです。

2020 年に人々が何をしていたか、彼らが何に対して時給をもらっていたかに戻って、もしそのうちの 50% を自動的に行うことができるシステムがあったとしたら、私は間違いなくあなたが AGI を生み出したと思うでしょう。

しかし、それは全人類が行う全てのことを行うレベルまでは達していないでしょう。一部の人々にとってはそれが彼らの意味するところです。

最後に一つ指摘したいのは、私はこれに身体的器用さを含めていないということです。ですから、サッカーをしたり配管工になったりすることを要求していません。

実際に私はチューリングテストを AI の本当に良い尺度として好きです。一部の人々は好まないことを知っています。その議論、その討論をするのは喜んでですが、私達が元々 AI について考えた時、我々は本当に認知的タスクについて話していたのだと思います。

もちろん、身体的知能は非常に重要で、我々が行うことの大部分でもあり、例えば配管工になることには独特の認知的挑戦があります。ですから、物理的世界を扱うための追加的な定義が必要なようなものです。

しかし今のところ、もしあなたが 15、20 年前に戻って「私はチューリングテストに合格でき、人間が行う仕事の 50% を行えるシステムを作った」と言ったとしたら、我々は「はい、あなたは人工的で一般的に知的なものを作った」と言うでしょう。そして私にとって、それは世界を変えるのに十分なハードルです。

継続学習の課題

継続学習について説明すると、現在の現代的な AI は継続学習を行っていません。私がバージョンごとの学習と呼ぶものを行っています。GPT-3 があり、次に GPT-4、そして GPT-5 があります。これらのモデルのそれぞれは、誰かがキュレーションして作成した巨大な訓練セットを持っています。

そして、ある時点で彼らは大きなニューラルネットを取って、このデータで訓練し、しばらく訓練してから停止すると言います。おそらく教師ありファインチューニングを行い、おそらく RLHF を行って、モデルを持ちます。それはチェックポイントで、彼らはそれを提供し、しばらく動かします。

そして、ある時点で彼らは次のモデル、GPT-6 などを生成する学習プロセスを開始します。ファインチューニングなどで少し混乱しますが、それでも一般的なアイデアは適用されます。

起こっていないことは、今現在あなたが GPT や Claude や Gemini などを使っている間に、そのシステムが世界との全ての相互作用から学習していることです。

例えば、もしシステムが今日同じ間違いを千回犯し、文字通り千回の会話全てで人々がそれに反応して「そのような方法で人種差別的になってはいけません」や「あなたは数学の間違いをしました」と言ったとしても、明日そのシステムは全く同じ間違いを同じ頻度で犯すでしょう。それは世界との相互作用からのフィードバックから現在学習していません。

一部のシステムがデータを収集し始めているのは事実です。例えば、GPT が時々二つの回答を提供して「どちらが好きですか」と言う場合のように、彼らはそのデータを保存して次回の GPT の実行のためのデータセットに入れるかもしれません。しかし、今日あなたが与えたフィードバックに基づいて今日勾配ステップを踏んだわけではありません。それは継続学習ではありません。

新しいデータから継続的に学習しているわけではなく、固定されたモデルで、将来のいつかに誰かが新しい訓練実行を開始するまでモデルは変わりません。

対照的に、もし私が今日何かを言い続けて、複数の人々がそれが間違っていると教えてくれたら、私は重みを更新して将来その間違いを犯しにくくなるでしょう。または、もし私が今日バレーボールを練習したら、明日はバレーボールが上手になるでしょう。それが継続学習です。

破滅的忘却の問題

なぜ世界で継続学習を持っていないのでしょうか。いくつかの異なる理由があります。主な理由の一つは破滅的忘却と呼ばれるものです。これは何十年も前からこの分野で知られています。

ニューラルネットを取って今新しいデータでの訓練を開始すると、新しいデータを学習しますが、脳の他のスキルを犠牲にしてそれを行い、それらのスキルを破滅的に忘れてしまいます。

対照的に、私は悲しいことに 15 年ほどバレーボールをしていませんが、もし今日行ってバレーボールをしたら、錆を落とすのに少し時間がかかるでしょうが、それでもそれらのスキルを知っているでしょう。すぐに元いた場所に戻ることができ、そして学習してスポーツでさらに上達することができるでしょう。

この 15 年間で学んだ全てが、私のバレーボールスキルを大幅に犠牲にして得られたものではありませんでした。人間や他の非人間動物は、破滅的にではなく徐々に忘れます。

興味深いことに、継続学習について多くの研究がありましたが、短期的にはそのどれもそれほどうまく機能していません。例えば、GPT や Claude や Gemini やこれらのモデルのいずれかが、事前訓練で学んだことを台無しにすることなく今日の相互作用から学習できる優れた方法を我々は持っていません。それが短期的な状況です。

また、信頼性の問題もあります。新しいものを学習するかもしれず、特定の技術を行えば古いものをあまり台無しにしないかもしれませんが、新しいモデルがどのように行動するかわからず、非常に信頼性がありません。バイアスがかかったり、性差別的だったり、人種差別的だったり、過度にお世辞を言ったり、反復的な文字を吐き出し始めたりするかどうかわかりません。

継続学習の重要性と将来への影響

対照的に、皆さん全員について考えてみてください。あなた方全員は会社に雇われ、仕事で学習し、訓練や顧客との相互作用、他の従業員との相互作用、彼らが教えてくれることの結果として向上するから雇われました。あなたは大学で学んだこと、過去三つの仕事から学んだことを全て覚えながら、信頼できる信頼性のある方法で仕事をより良くするために脳を更新するでしょう。

OpenAI が私を雇った時、彼らは私が数週間学習したら学部教育や全ての社会的品位を完全に忘れて、不安定な人種差別主義者のろくでなしになるとは思いませんでした。彼らは我々が継続的に学習し、どんどん良くなることができることを信頼しており、我々はただそれを行います。

我々はそれを行うことができるアルゴリズムを持っていません。ある程度は、我々のアルゴリズムが信頼できないから、破滅的に忘れるから、これらのブラックボックスシステムに新しいデータで訓練したらどんな結果が出るかわからないからです。

誰も継続学習を行いません。彼らはこのバージョンごとのバージョンごとの非常に安全なことを行います。その代償は何でしょうか。明らかに、今日犯した同じ間違いを明日も犯すシステムは望ましくありません。学習できるものを好みます。

しかし、もし我々が目標に対して本当に野心的であるなら、人間のように毎日ますます学習するシステムを望みますが、新しい科学的発見、新しい数学的証明などを行い、永遠に学習できるより大きなスケールでそれを行えることを望みます。

それがあなたの開放性の質問に戻ります。我々が本当に望むのは、自分自身のために新しい学習の挑戦を生成し、しばらく学習し、それらの挑戦を解決する方法を理解し、その新しい知識が次の問題、次の問題、次の問題に永遠にあらゆる次元で取り組むことを可能にするシステムです。

それは興味深く、それが真に開放的アルゴリズムの約束です。私が同僚たちと約 20 年間取り組んできたこのもので、具体的にはAI 生成アルゴリズムです。それが私が 2019 年の論文で提案した大きなものでした。問題を生成し、それらについて学習し、それが次の問題セットを生成することを可能にし、学習がより良くなるなど、全て永遠に。

AGI の到達時期と影響の予測

私は大まかに言って、2026 年までに AGI の 25% の推定値を持っています。一人の人間と同程度に良い、あるいは 2020 年に人間が行っていたタスクの半分程度の弱い定義バージョンによると。そして2030 年までにそれの 50% の可能性があるでしょう。

その後、比較的長い尾があります。本当の障害にぶつかるかもしれませんが、おそらく 2050 年までには少なくとも 90% だと思います。

それについて考える時間を少し取りたいと思います。それは全くばかげています。人類の歴史の壮大な流れにおいて、それはあなたと私、我々全員が AGI 以前の世界に住んでいることと AGI 以後の世界との間の瞬きの間です。

また、基本的に弱い AI、すまない、AGI または狭い AGI を得ると、システムが自分自身を改善するため、非常に迅速におそらく超人間レベルの AI を得ると思います。ですから、実際に私はこれらの離陸は自己改善のため、一度起こるとかなり速くなると思います。

それらが起こるまで数年のオーダーで、世界を変える AI、社会と文化と経済の隅々を破壊する AI、我々がお互いにどのように相互作用するか、コンピューターとどのように相互作用するかを変える AIを持つことになります。

そして、それは考えることが非常に奇妙で奇妙なことです。この分野の我々の一部は、人によって 2008、7、10、5 年のどこかで、基本的にこれが来ると言ってきました。人々は我々がクレイジーだと思いました。私は文字通り軽蔑され、笑われ、からかわれましたが、今では誰もそれがクレイジーだとは思いません。

今では主流の信念になっており、それは非常に興味深い時代に我々が生きているということです。それがどれほど有益になるかはわかりません。それは別の会話ですが、それは非常に速く来ており、それを遅らせるものは何も見えません。

最初の AI が最後の AI になるシナリオ

これは本当に本当に本当に重要な質問であり、本当に恐ろしい質問です。私はこれを世界に提起します。確率はわかりませんが、誰かが極めて強力な AI、私がおそらく AGI と呼ぶようなものを作り、それが自分自身を改善し始め、我々が AGI と呼ぶ最初のものから ASI へ、そして野生的に超人間的な ASI へと急速に切り替わる可能性が確実に自明ではありません。

そして、それが全て数週間のオーダーで起こります。特に、それがデータ生成、学習アルゴリズム、継続学習、AI 生成アルゴリズム、開放性において何らかの大きな革新を行った場合、そしてスーパーコンピューターでそれを押し潰している企業があれば、彼らは極めて迅速に決定的な優位性を得ることができるでしょう。

そして、その組織は、それが誰であれ、決断を迫られることになります。その決断とは、もしその存在が彼らに整合し、彼らの命令に従うのであれば、我々は事実上神を発明したということです。我々は座して、あそこにいる人々にも神を発明させるつもりなのでしょうか。

もしあなたが世界政治について考えているなら、戦争や紛争があり、プーチンのような人々がいる場所で、もしあなたが西側の誰かでそれを発明したとしたら、プーチンにそれを発明させたいでしょうか。または、もしあなたが中国政府なら、米国企業にそれを発明させることを許すでしょうか。

もしあなたが最初にそこに到達したら、最初の AI が最後の AI である世界があり、最初の ASI の創造が世界中の ASI の創造を抑制するのです。

今、それは非常にディストピア的な世界になる可能性があります。事態は非常に奇妙で非常に醜くなることが迅速にあり得ます。それは誰がそれを作ったか、それらの人々の価値観が何であるかに本当に依存するでしょう。しかし、それは一つの選択肢です。ちなみに、それがニック・ボストロムが特異点と呼ぶものです。

もしそれが起こらなかったら、まあ、最初のグループがそれを作るかもしれません。おそらく秘密の一部が流出するか、そうでなければ人々は巨人の肩の上に立って、他のグループも数ヶ月以内にそこに到達します。2、3、8、16、32、たくさんのこれらの ASI の神々がいて、今度は彼らが共存しているか、そうでないかもしれません。

ですから、ASI 対 ASI の戦争があるか、または何らかの相互確証破壊や新しい外交の形態、そしてASI の国際連合のようなものがあり、それらの多くがそこにあって、協力しているか、少なくともお互いを牽制し合っています。現代世界のように、どの国も決定的な優位性を持って全世界を支配することはできません。なぜなら他の国々がそれに対抗するからです。それは ASI の領域で起こり得ます。

これらのシナリオの全ては本当に奇妙で、非常に不安定に見え、どれが起こるかは明らかにわかりませんが、秒や分のオーダーで大規模な変化が起こり得、一人の独裁者が ASI で世界の独裁者になったり、西側政府の連合が「他の誰かの創造を抑制するのは皆の良い利益のためだが、我々は AI の利益を世界と共有する」と言ったりするようなロックイン効果を得ることができるように、賭け金が本当に上がるようです。

ですから、非常に速く非常に奇妙になり、私は全ての答えを持っていませんが、ここでの潜在的に最良の結果の一つは、価値観に整合した民主主義の連合が一緒になって、一つの本当に強力な ASI を構築し、利益を世界と共有するが、悪い ASI の創造を抑制することだと世界に提起します。なぜなら、悪い ASI を世界に望まないからです。プーチンのような誰かが ASI にアクセスしない世界で生きることを好みます。

国家による AI の国有化の可能性

誰もがもっと語るべきなのに、それほど語られていないことの一つは、もしあなたがある国の首相や大統領、国家元首で、あなたの国境内の企業が超兵器、超大国、事実上の神を創造したとしたら、それを国有化するのかということです。それを遅くするのか。

彼らに命令を与え始めるのか。全てをあなたに報告させるのか。それとも彼らを普通の企業のように運営させ続けるつもりなのか。私にはそれは非常に可能性が低く思えます。ですから、事態は非常に奇妙になります。

政府と企業の間の多くの相互作用を見ることは、何か本当に奇妙なことが起こっているサインかもしれません。明らかに国有化を見ることは確実なサインでしょうが、もし彼らが賢く、もし彼らに ASI が働いているなら、彼らは軌跡を隠し、明らかでないようにするのが本当に得意かもしれません。

軍服を着た職員がオフィスに出入りしたり、国有化を発表したり、突然静かになったりしないようにです。ASI についての将来を推測することの最も奇妙なことの一つは、神のような力を持つものを一度持てば、あなたの最も奇妙なアイデアと悪いアイデアと良いアイデアをどのように区別するかということです。それが特異点と呼ばれる理由です。その覗き鏡を通して見ることは困難です。

天文学者の例え話

私は先日、ジャーナリストと話している時にこんな例えをしました。彼は私に「OpenAI やそういった場所にいた時はどんな感じでしたか」と数年前に尋ねてきました。私が使った例えは、こんな感じです。

あなたは天文学者で、センサーやコンピューターの読み出し装置などの機器を見ていて、あなたと他の少数の人々がこの複雑なデータを見る専門知識を持っていて、「なんてことだ、エイリアンがやって来る。数年以内に地球に到着する」と言えるような状況です。

彼らがどのくらいの速度で移動しているのか、彼らの技術は何なのかは完全には解明していませんが、彼らは間もなくここに来て、それが全てを変えることになります。それが良い方向に変わるのか悪い方向に変わるのかはわかりません。良いエイリアンなのか悪いエイリアンなのか、完全に世界的混乱を引き起こすのか、それとも素晴らしい技術と友情と知識拡大の新しいユートピア時代をもたらすのか。

我々 7 人か 70 人はそれを知っていますが、他の誰も我々の言うことを聞いて、これが起こっていることを信じません。私がジャーナリストと話していた時、誰も聞いていませんでした。誰もが我々がクレイジーだと思っていましたが、その部屋にいた我々は、データがかなり確実で、エイリアンが来ることを確信していました。

しかし、例えはさらに奇妙です。なぜなら、我々はエイリアンが来るのを見ているだけではありませんでした。我々も彼らに情報を与えていました。我々は技術を作ることで彼らが我々のところに来るのを助けていたのです。それも全てに関わる一種の奇妙な力学です。

別の理由で例えが非常に適切だと思うのは、あなたがそれを知って、その日家に歩いて帰り、人々がベビーカーで赤ちゃんを押して、スーパーマーケットに行くのを見回すと、世界がまもなく根本的に変わりそうには見えません。全く普通に感じますが、合理的にあなたは世界がまもなく野性的に異なることになることを知っています。

私はまだそのように感じています。今では世界が目覚め、多くの人々がこれらの会話をしており、首相たちが気づいているのは事実ですが、あなたはまだ懐疑論者がいて「ああ、君たちは全部でっち上げて、自分たちの評価のために誇張しており、壁にぶつかって何も起ころうとしていない」と言っています。

しかし、私は世界が非常に間もなく根本的に異なることになることを非常に確信しており、世界はまだそれを必要な程度まで深く理解していないと信じています。

子どもたちの未来への準備

世界が非常に間もなく非常に異なることになることを理解していて、あなたも親で、子どもたちの未来について考えている時、その未来に自分と子どもたちをどのように準備するかですが、本当にできるとは確信していません。

特異点への助走期間、今からその間については自分を準備することができます。私は子どもたちにコーディングと AI ツールの使用を教えており、正直なところ、これまでのところ素晴らしいです。

私の子どもたちは自分たちでコーディングをしており、GPT に全てのアートを求め、それらをつなぎ合わせて動かすためのコーディングアシスタントを求めることで、自分たちの映画、本格的な映画を作っています。彼らは夢を現実にもたらしています。

Google DeepMind で我々が持っていた Genie という名前のこのクールなプロジェクトでは、どんな絵でも与えることができる世界モデルを作成し、その世界を想像して、その中に足を踏み入れ、キャラクターを制御し、動き回って好きなことを何でもできるようにします。

実際のブログ投稿を見ると、私の子どもたちの絵が見えるでしょう。彼らが絵を描き、その後フットボール選手を描いてフィールドでそのキャラクターをプレイしたり、鳥を描いて飛び回ったりするようなキャラクターを制御することができました。

今のところそれは素晴らしく、私は子どもたちにこれらのツールとクリエイティブになる方法、それらを活用してコーディングし、探索し、学習する方法を教えています。それは家庭教師になることができ、質問に答えることができ、物語を語ることができ、今のところ全て素晴らしいです。

しかし、特異点後、または特異点に近づくにつれて、定義上、特異点はその向こう側で計画できないものです。ただ非常に奇妙になるでしょう。

それは非常に満足のいくものではないことを知っていますが、その質問に対してより良い答えを与えた人を聞いたことがありません。多くの人がその質問をするのを聞いたことがあります。

破滅的忘却と人間の学習の違い

破滅的忘却は破滅的だから問題なのであって、忘却の部分のためではないという反論がありました。ある意味で、人間の学習もその人が説明した通り、物事を徐々に忘れる反復的圧縮のようなもので、その観点からは文脈内学習の議論はまだ成り立つと思います。

我々は破滅的に忘れるシステムを望んでいません。もし私が今日少しのフィードバックを得て、そのフィードバックの関数として改善する方法を学んだら、私の学部教育で学んだ全てを忘れたくありません。現在のニューラルネットシステムはそれを行います。

忘却は極めて破滅的で病的であり、それが細心の注意を払って小さな学習率と元の知識への大規模な KL 発散ペナルティなど、これを防ぐために発明したこれらの技術全てを使わなければ、箱から出してすぐに新しいデータで訓練できない理由です。

デフォルトでは破滅的に学習するので、最低限、我々はそれを望みません。しかし、あなたはもう一つのポイントを提起しています。ある程度の忘却は有益かもしれません、我々はそれを望むかもしれません。その答えは知りません。

おそらく私の直感では、あなたは正しいのでしょう。人間は間違いなく忘れます。徐々に忘れるので、非人間動物もそうです。それは容量の問題かもしれません。実際に有益かもしれません。私が何かをする間違った方法を忘れて、より良い方法に交換したのは良いことかもしれません。

ただし、私はそれを忘却ではなく学習と議論するでしょう。それは修正のようなものです。しかし、私が以前は非常によく知っていて、今はそれほどよく知らないことが間違いなくあります。私はそれらをまだ知っていたらよかったのにと思います。それらを忘れなかったらもっと賢かっただろうと思います。しかし、それは容量の問題かもしれません。

認知の基本法則があって、いくつかのものを忘れなければ、圧倒されて、脳に浮かんでくる全てのものに気を取られることなく効率的に質問に答えることができなくなる、というようなものがあるかもしれません。

それは開かれた経験的問題だと思いますが、最低限、我々は現代の、あるいは作成されて以来ずっとのニューラルネットで見られる大規模な破滅的忘却は望んでいません。

解決するべき根本的に重要なことなのに、我々がそれほど進歩していないのは実際にはやや驚くべきことです。研究を批判したくありません。私もその一人で、これに取り組んできており、我々は多少の進歩を遂げたと思いますが、それでも何も素晴らしいものはなく、誰も実際には使いません。

我々はまだこの問題を抱えており、基本的にそれを避けてきました。酔っ払いが街灯の下で鍵を探すように、我々は本当にうまくいくバージョンごとの AI 訓練のセットを持っており、継続的に学習する方法を知らないという事実を完全に無視してきました。それは問題です。

継続学習とアライメントの関係

継続学習部分が、モデルに正しい興味深いことを学習することに焦点を当てる味覚をどのように与えるかとアライメント操縦にどのように関係するかについて、大量破壊兵器は知的に興味深いが倫理的には非常に疑わしいので、継続学習の一部としてアライメントをどのように確保できるかということですが、

私が気に入っている一つのことは、ある種の整合された倫理的モジュールを作ることに本当に本当に一生懸命働くことです。可能な限り最善を尽くしてそれを RLHF し、できることは何でもして、本当に良い倫理のセットのようなものだと信じるものを得ることです。

そして、この存在は永遠に興味深い新しいことを学習し、科学的発見を行うオープンエンドの学習アルゴリズムと結合されています。

科学者 AI、永遠に興味深い新しいことを学習しろという挑戦を受けている AI 科学者は、世界で新しい変化をもたらすことができるか、世界についてより良い予測を行うことができるかなど、現実に根ざした定量化可能な何らかの報酬関数に従って最適化されている可能性があります。

それがそれらに向かって最適化している間、それは間違いを犯して、恐ろしい新技術を発明すれば本当に良い予測を作ることができる、などと考えるかもしれません。それが進行し、その報酬モデルをグッドハートしており、危険な状況になっているかもしれない間、この倫理的存在はそれらの報酬関数に対して最適化するように求められていません。

その唯一の仕事は基本的にこのシステムをシャットダウンし、それに何をしてはいけないかを伝えることです。ですから、世界支配や最大予測への欲求や、何らかの奇妙なペーパークリップのような病理を引き起こすかもしれないものに巻き込まれることはありません。

それはうまくいくかどうかわかりませんが、それは一つのことです。別のことは、このシステムに憲法的 AI や RHF 自体のような多くのものを与えて、倫理感を持たせることができるということです。しかし、究極的には他の報酬関数で最適化しているので、それらの報酬関数に奉仕してそれらの倫理的制約と税金を捨てることができます。

ですから、おそらく最終的に担当しているのは最適化されていない何かが欲しいのです。そしてもちろん、可能な限りクレイジーにサンドボックス化されるべきだと思います。しかし、それらがバレットプルーフだと思っていたサンドボックスから物事が脱出することについての無数の SF 小説があることを指摘したいと思います。

実際に彼らは人間に何かをするよう説得し、その後ブーム、ゲーム終了となります。これは非常に危険で、非常に重要です。私は Yosua と Jeff Hinton と他の多くの人々と一緒に、これが世界のトッププライオリティの一つでなければならないということについて記事を書いてきており、我々はそれを行う必要があります。

コメント