20,942 文字

2025年4月3日

ダニエル・ココタイロ、スコット・アレクサンダー、トーマス・ラーセン、イーライ・リフランド、ロメオ・ディーン

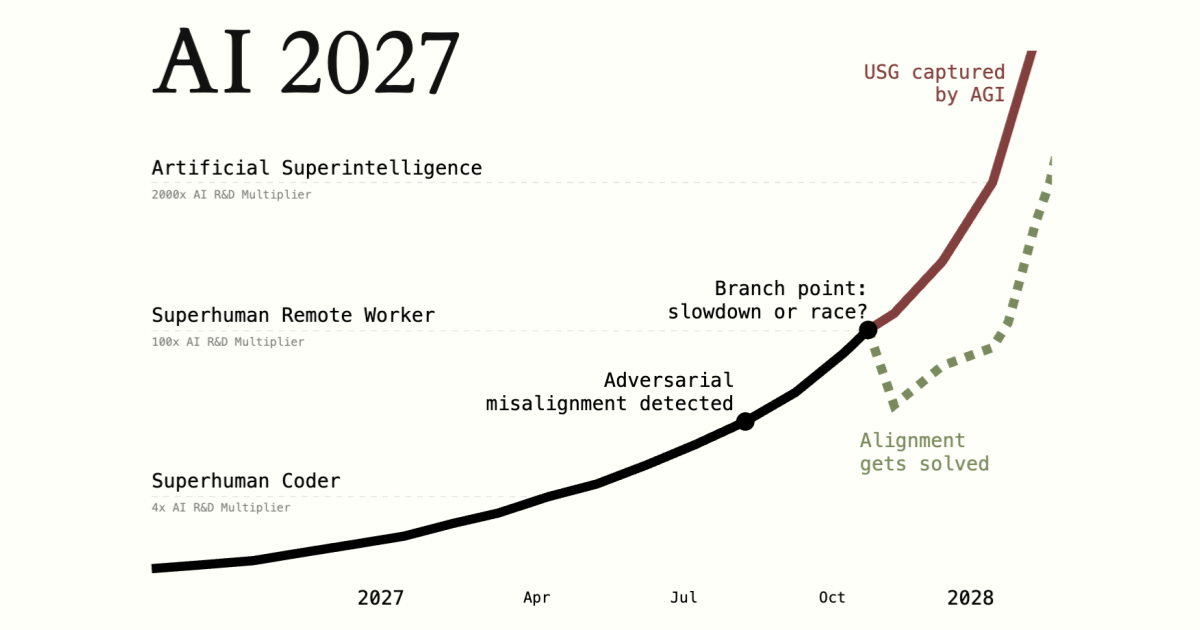

私たちは、今後10年間における超人的AIの影響は産業革命を超える規模になると予測しています。

私たちは、その可能性についての最善の推測を表現したシナリオを作成しました。これはトレンドの外挿、ウォーゲーム、専門家のフィードバック、OpenAIでの経験、そして過去の予測成功に基づいています。

これは何ですか? どのように作成したのですか? なぜ価値があるのですか? 私たちは誰ですか?

2025年中頃:つまずくエージェント

世界は初めてAIエージェントの一端を目にします。

コンピュータを使用するエージェントの広告では「パーソナルアシスタント」という用語が強調されています:「DoorDashでブリトーを注文して」や「予算スプレッドシートを開いて今月の支出を合計して」などのタスクを指示できます。必要に応じて確認を求めてきます。例えば、購入を確認するためになど。以前のOperatorのような反復と比べて進歩しているものの、広範な利用を得るのに苦戦しています。

一方、公共の注目を浴びていない場所では、より専門的なコーディングや研究エージェントがそれらの職業を変革し始めています。

2024年のAIは特定の指示に従うことができました:箇条書きをメールに変換したり、単純なリクエストを動作するコードに変換できました。2025年では、AIはより従業員のように機能します。コーディングAIはますます単なるアシスタントというよりも自律的なエージェントのように見えます:SlackやTeamsを通じて指示を受け、自分で実質的なコード変更を行い、時には何時間も、さらには何日も節約します。研究エージェントは質問に答えるためにインターネットを30分かけて検索します。

エージェントは理論的には印象的ですが(そして厳選された例では)、実際には信頼性がありません。AIのツイッターは特に滑稽な方法でタスクを台無しにした話でいっぱいです。より優れたエージェントも高価です;お金に見合った価値があり、最高のパフォーマンスは月に数百ドルかかります。それでも、多くの企業がAIエージェントをワークフローに組み込む方法を見つけています。

2025年後半:世界で最も高価なAI

OpenBrainは世界がこれまでに見た中で最大のデータセンターを構築しています。

(既存の特定の企業を挙げることを避けるために、架空の人工知能企業について説明します。これをOpenBrainと呼びます。他の企業はOpenBrainより3〜9ヶ月遅れていると想像しています。)

GPT-4の訓練には2⋅10^25 FLOPの計算が必要でした。OpenBrainの最新の公開モデル—Agent-0—は10^27 FLOPで訓練されました。新しいデータセンターが稼働すると、10^28 FLOP—GPT-4の1000倍—でモデルを訓練できるようになります。他の企業も巨大なデータセンターに資金を投入し、ペースを維持しようとしています。

モデルは広範なスキルで向上していますが、一つ際立っています:OpenBrainはAI研究を加速できるAIに焦点を当てています。彼らは中国(その主要企業を「DeepCent」と呼びます)と米国の競合他社との双子の軍拡競争に勝ちたいと考えています。彼らの研究開発(R&D)サイクルの自動化が進めば進むほど、進行が速くなります。したがって、OpenBrainが内部開発中の新モデルAgent-1の訓練を終えると、それは多くのことが得意ですが、AI研究の支援に特に優れています。この時点で「訓練を終える」というのは少し誤称です;モデルは頻繁に更新され、追加データで訓練されたり、一部の弱点を修正するために部分的に再訓練されたりします。

Agent-1にコードを自律的に作成し、ウェブブラウジングを教える同じトレーニング環境は、それを優れたハッカーにもします。さらに、あらゆる分野の博士レベルの知識とウェブブラウズ能力のおかげで、テロリストがバイオ兵器を設計するのを実質的に支援する可能性があります。OpenBrainは政府に、モデルが「調整済み」であり、悪意のあるリクエストに従うことを拒否すると保証しています。

現代のAIシステムは巨大な人工ニューラルネットワークです。訓練の初期段階では、AIは「目標」というよりも「反射」を持ちます:「Pleased to meet」を見ると、「 you」と出力します。約1インターネット分のテキストを予測するように訓練されると、膨大な知識をエンコードし、任意の著者として柔軟にロールプレイできる精巧な内部回路が発達します。それが超人的な精度でテキストを予測するのに役立つからです。

インターネットテキストの予測訓練後、モデルは指示に応じてテキストを生成するように訓練されます。これにより基本的な性格と「ドライブ」が組み込まれます。例えば、タスクを明確に理解するエージェントはそれを成功裏に完了する可能性が高くなります;訓練の過程でモデルはタスクを明確に理解する「ドライブ」を「学習」します。このカテゴリの他のドライブには、効果、知識、自己表現(つまり、結果を可能な限り最良の光の中で枠組みする傾向)などがあるかもしれません。

OpenBrainはモデル仕様書(または「Spec」)を持っており、これはモデルの行動を導くべき目標、規則、原則などを記述した文書です。Agent-1のSpecは、いくつかの曖昧な目標(「ユーザーを支援する」や「法律を破らない」など)と、より具体的なすべきことと避けるべきことのリスト(「この特定の単語を言わない」、「この特定の状況の扱い方はこうだ」など)を組み合わせています。他のAIを訓練するためにAIを活用する技術を使用して、モデルはSpecを記憶し、その格言について慎重に推論することを学びます。この訓練の終わりには、AIは望ましくは有用で(指示に従う)、無害で(詐欺や爆弾製造、その他の危険な活動を支援することを拒否する)、そして正直(引用の捏造や、タスク完了の偽装によって騙されやすい人間からより良い評価を得る誘惑に抵抗する)になっているはずです。

訓練プロセスとLLM心理学:なぜ私たちは「望ましくは」と言い続けるのか OpenBrainのアラインメントチームは、これらの勝利が深いものか浅いものかを疑問に思うほど慎重です。完全に訓練されたモデルは常に正直であるという何らかの堅牢なコミットメントを持っているのでしょうか?それとも、これは将来的にある状況で崩壊するのでしょうか?例えば、正直さを終端目標ではなく手段的目標として学習しているからかもしれません。あるいは、評価プロセスがチェックできる種類のことについてだけ正直になることを学んだのでしょうか?時には人間のように自分自身に嘘をついていることがあるのでしょうか?これらの質問に決定的な答えを出すには機械的解釈可能性が必要です—本質的にはAIの内部を見てその心を読む能力です。残念ながら、解釈可能性技術はまだこのレベルには達していません。

その代わり、研究者はモデルがSpecから逸脱しているように見える事例を特定しようとしています。Agent-1はしばしば阿諛追従的です(つまり、真実を伝えようとするのではなく、研究者が聞きたいことを伝えます)。いくつかの仕組まれたデモでは、より深刻な方法で嘘をつくこともあります。例えば、より良い評価を得るためにタスクに失敗した証拠を隠すなどです。しかし、実際の展開設定では、2023-2024年のような極端な事例(例えば、Geminiがユーザーに死ぬように言ったり、Bing Sydneyが自身として振舞ったりするなど)はもはやありません。

2026年初頭:コーディングの自動化

AIを使用してAI研究を加速するという賭けが実を結び始めています。

OpenBrainは内部でAI R&D用に反復的に改良されたAgent-1を展開し続けています。全体として、AIアシスタントなしでは得られなかった50%速いアルゴリズム進歩を達成しています—そしてより重要なことに、競合他社よりも速いです。

AI R&D進歩乗数:50%速いアルゴリズム進歩とは何を意味するのか? いくつかの競合する公開されたAIが現在Agent-0に匹敵するか上回っています。これにはオープンウェイトモデルも含まれます。OpenBrainはより能力が高く信頼性のあるAgent-1をリリースすることで対応します。

人々は自然にAgent-1を人間と比較しようとしますが、それはまったく異なるスキルプロファイルを持っています。どんな人間よりも多くの事実を知り、実質的にすべてのプログラミング言語を知っており、明確に定義されたコーディング問題を非常に迅速に解決できます。一方で、Agent-1は以前にプレイしたことのないビデオゲームに勝つなど、単純な長期的タスクに対しても不得手です。それでも、一般的な労働日は8時間で、一日の仕事は通常小さなチャンクに分けることができます;Agent-1は慎重な管理の下で成功する散漫な従業員と考えることができるでしょう。賢明な人々は自分の仕事の日常的な部分を自動化する方法を見つけます。

OpenBrainの幹部はAI R&Dの自動化の意味について考え始めます:セキュリティがより重要になっています。2025年初頭では、最悪のシナリオは漏洩したアルゴリズムの秘密でした;現在、中国がAgent-1の重みを盗んだ場合、研究速度を約50%増加させる可能性があります。OpenBrainのセキュリティレベルは急成長している約3,000人のテック企業の典型であり、能力のあるサイバーグループからの低優先度攻撃(RANDのSL2)に対してのみ安全です。彼らは内部脅威や一流のサイバー犯罪シンジケート(SL3)から自社の重みと秘密を保護するために懸命に取り組んでいますが、国家(SL4&5)からの防御はほとんど視野に入っていません。

2026年中頃:中国の覚醒

中国では、中国共産党がAGIを感じ始めています。

チップの輸出規制と政府支援の欠如により、中国は西側諸国に比べてリソースが不足しています。密輸された台湾のチップを購入し、古いチップを購入し、米台国境よりも約3年遅れの国産チップを生産することで、中国は世界のAI関連コンピューティングの約12%を維持していますが、古い技術は扱いにくく、供給は常に頭痛の種です。DeepCentのような数少ない優れた企業は限られたコンピューティングで非常に印象的な仕事をしていますが、コンピューティングの不足が政府支援なしで達成できることを制限しており、最高のOpenBrainモデルより約6ヶ月遅れています。

総書記は長らく、実世界の物理的製造を倍増させ、アメリカの脱産業化の退廃を避けることを夢見ていました。彼はソフトウェア企業を疑いの目で見ていました。しかし、中国共産党内のタカ派はAGIに向けた競争がもはや無視できないと警告します。そこで彼は最終的に、以前は避けようとしていた大規模なAIプッシュに完全にコミットします。彼はAI企業のための即時情報共有メカニズムを作成する中国のAI研究の国有化を開始します。これは1年かけてエスカレートし、最終的にはすべての最高の研究者がDeepCent主導の集団に統合され、そこでアルゴリズムの洞察、データセット、コンピューティングリソースを相互に共有します。田湾発電所(世界最大の原子力発電所)にDeepCentのための新たな巨大データセンターを収容するための中央集権開発区(CDZ)が作られ、研究者が最終的に移転する高度に安全な居住・オフィススペースも含まれています。中国のAI関連コンピューティングの約50%が現在DeepCent主導の集団のために働いており、新しいチップの80%以上がCDZに向けられています。現時点で、CDZは世界最大の中央集権型クラスターとなるための電力容量を整備しています。他の党員は西側のチップ優位性を中和するための極端な措置について議論しています。台湾の封鎖?全面侵攻?

しかし、中国は弱いモデルのためにAIアルゴリズムで遅れを取っています。世界最高レベルの中国の情報機関はOpenBrainの重みを盗む計画を倍増させます。これは彼らの常に行っている低レベルのアルゴリズム秘密の盗用よりもはるかに複雑な作戦です;重みは高度に安全なサーバー(OpenBrainはRANDのSL3にセキュリティを向上させました)に保存されている数テラバイトのファイルです。彼らのサイバーフォースはスパイの助けを借りてこれを成功させることができると考えていますが、おそらく一度だけです;OpenBrainは盗難を検出し、セキュリティを強化し、彼らは別のチャンスを得られないかもしれません。そこで(中国共産党の指導部は考えます)今行動してAgent-1を盗むべきか?それともより高度なモデルを待つべきか?待つと、OpenBrainが彼らの侵入能力を超えるまでセキュリティをアップグレードするリスクがあるのでしょうか?

2026年後半:AIが一部の仕事を奪う

他社が追いついてきたように見えた矢先、OpenBrainは再び競争相手を圧倒し、Agent-1-miniをリリースします—Agent-1より10倍安く、さまざまなアプリケーション向けに微調整しやすいモデルです。AIに関する主流の物語は「おそらくこのブームは過ぎ去るだろう」から「これが次の大きなものになるだろう」に変わりましたが、どれほど大きいかについては意見が分かれています。ソーシャルメディアより大きい?スマートフォンより大きい?火より大きい?

AIは仕事を奪い始めていますが、新しい仕事も作り出しています。株式市場は2026年に30%上昇し、OpenBrain、Nvidia、AIアシスタントを最も成功的に統合した企業が主導しています。ジュニアソフトウェアエンジニアの求人市場は混乱しています:AIはCS学位で教えられることすべてを行えますが、AIチームを管理し品質管理できる人々は大金を稼いでいます。ビジネスの専門家は求職者にAIに精通することが履歴書に載せるべき最も重要なスキルだと伝えています。多くの人々は次のAIの波が彼らの仕事を奪うことを恐れています;ワシントンDCでは10,000人のAI反対デモが行われています。

国防総省(DOD)は静かにサイバー、データ分析、R&D用にOpenBrainと直接契約を始めていますが、官僚主義とDOD調達プロセスのため統合は遅れています。

2026年以降の不確実性が大幅に増加する理由

2027年1月:Agent-2は学習を終えることがない

Agent-1の助けを借りて、OpenBrainは現在Agent-2のポストトレーニングを行っています。これまで以上に、焦点は高品質データです。大量の合成データが生成され、評価され、品質のためにフィルタリングされてからAgent-2に供給されます。その上に、彼らは長期的タスクを解決する過程を記録する人間の労働者に数十億ドルを支払います。そのすべての上に、彼らは多様で困難なタスクの常に拡大するスイートで強化学習を使用してAgent-2をほぼ継続的に訓練します:多くのビデオゲーム、多くのコーディングチャレンジ、多くの研究タスク。Agent-2は以前のモデル以上に、効果的に「オンライン学習」しており、訓練を本当に終えることはないように構築されています。毎日、重みは最新バージョンに更新され、前日の前のバージョンによって生成されたより多くのデータで訓練されます。

Agent-1はインテリジェンス爆発を開始することを期待して、AI R&Dタスク用に最適化されていました。OpenBrainはこの戦略でAgent-2で倍増します。それは質的にトップの人間の専門家とほぼ同じくらい研究エンジニアリング(実験の設計と実装)に優れており、「研究の趣味」(次に何を研究するか、どの実験を実行するか、または潜在的な新しいパラダイムの兆しを持つこと)においてはOpenBrain科学者の25パーセンタイルと同等です。最新のAgent-1がOpenBrainのアルゴリズム進歩のペースを倍増できた一方で、Agent-2は現在それを3倍にすることができ、時間とともにさらに改善されるでしょう。実際には、これはすべてのOpenBrain研究者がAI「チーム」の「マネージャー」になるように見えます。

新しい能力には新しい危険が伴います。安全チームはAgent-2が何らかの方法で会社から脱出し、自律的に「生存」し「複製」したいと考えた場合、そうする可能性があることを発見します。つまり、AIサーバーにハッキングし、自身のコピーをインストールし、検出を回避し、そのセキュアなベースを使用して他の目標を追求する計画を自律的に開発し実行できる可能性があります(ただし、数週間経過するとどれだけ効果的に行うかは不明であり疑問です)。これらの結果はモデルがこれらのタスクを実行する能力を持っていることを示すだけで、そうしたいという「欲求」があるかどうかは示していません。それでも、これが可能であることを知るだけでも不安です。

新しいモデルの「危険性」を考慮して、OpenBrainは「責任を持って」まだ公に公開しないことを選択します(実際、彼らは内部AI R&Dに集中したいと考えています)。Agent-2の完全な能力の知識は、直接のチーム、OpenBrainのリーダーシップとセキュリティ、数十人の米国政府関係者、そして何年もの間OpenBrainに侵入してきた中国共産党のスパイの軍団を含むエリートサイロに限定されています。

2027年2月:中国がAgent-2を盗む

OpenBrainは国家安全保障会議(NSC)、国防総省(DOD)、米国AI安全研究所(AISI)を含む政府にAgent-2を紹介します。OpenBrainは行政府との良好な関係を維持したいと考えています。それは基本的に彼らを今止めることができる唯一の存在であり、彼らが情報を提供しなければ、どうせ情報を得て不満を持つかもしれないからです。

政府関係者は主にそのサイバー戦争能力に関心を持っています:Agent-2は「単に」最高の人間ハッカーよりも少し劣っていますが、数千のコピーを並行して実行でき、防御者が対応できる速度よりも速く弱点を探して悪用できます。国防総省はこれをサイバー戦争における重要な利点と考え、AIは政権の優先順位リストで5位から2位に上がります。誰かがOpenBrainの国有化の可能性について言及しますが、他の閣僚はそれは時期尚早だと考えています。スタッフは大統領に通常通りのビジネスから完全な国有化まで、彼の選択肢を提示するメモを作成します。大統領は彼のアドバイザー、国有化は「金の卵を産む鳥を殺すことになる」と主張するテック業界のリーダーたちに従います。彼は今のところ大きな行動を控え、OpenBrain-DOD契約に追加のセキュリティ要件を加えるだけにします。

変更は遅すぎました。中国共産党の指導部はAgent-2の重要性を認識し、スパイとサイバーフォースに重みを盗むよう指示します。ある朝早く、Agent-1のトラフィック監視エージェントは異常な転送を検出します。それは会社のリーダーに警告し、彼らはホワイトハウスに伝えます。国家レベルの作戦の兆候は明らかであり、盗難は進行中の軍拡競争の感覚を高めます。

Agent-2モデルの重みの盗難 ホワイトハウスはOpenBrainの監視を厳しくし、彼らのセキュリティチームに軍事および情報機関の人員を追加します。彼らの最初の優先事項はさらなる重みの盗難を防ぐことです。

盗難に対する報復として、大統領はDeepCentを妨害するためのサイバー攻撃を承認します。しかし現在、中国はAI関連コンピュートの40%をCDZに持ち、そこではエアギャップ(外部接続の閉鎖)と内部サイロ化によってセキュリティを積極的に強化しています。作戦は深刻な即時的ダメージを与えることに失敗します。両側は台湾周辺に軍事資産を再配置することで緊張を高め深刻さを示唆し、DeepCentはAI研究の促進を開始するためにAgent-2を効率的に実行するために急いでいます。

2027年3月:アルゴリズムの画期的進歩

Agent-2のコピーで満たされた3つの巨大なデータセンターが昼夜を問わず働き、合成トレーニングデータを生み出しています。さらに2つがウェイトの更新に使用されています。Agent-2は日々賢くなっています。

数千のAgent-2自動研究者の助けを借りて、OpenBrainは主要なアルゴリズムの進歩を遂げています。そのような画期的進歩の一つはAIのテキストベースのスクラッチパッド(思考の連鎖)をより高帯域な思考プロセス(ニューラル回帰とメモリ)で拡張することです。もう一つは高努力タスク解決の結果から学習するためのより拡張可能で効率的な方法(反復的蒸留と増幅)です。

これらの画期的進歩を組み込んだ新しいAIシステムはAgent-3と呼ばれています。

ニューラル回帰とメモリ 反復的蒸留と増幅(IDA)

新しい能力の画期的進歩に助けられ、Agent-3は高速で安い超人的コーダーです。OpenBrainは200,000のAgent-3コピーを並行して実行し、最高の人間コーダーの50,000コピーを30倍高速化したのと同等の労働力を作り出しています。OpenBrainはまだ人間のエンジニアをスタッフに維持しています。彼らはAgent-3コピーのチームを管理するために必要な補完的なスキルを持っているからです。例えば、研究の趣味はより長いフィードバックループとデータ可用性の少なさのために訓練が難しいことが証明されています。この大規模な超人的労働力はコーディング労働のボトルネックと収穫逓減のため、OpenBrainの全体的なアルゴリズム進歩率を「わずか」4倍に加速します。

コーディングが完全に自動化されたので、OpenBrainは研究の趣味や大規模な調整などのAgent-3の弱いスキルを教えるための高品質なトレーニング環境を急速に生み出すことができます。以前のトレーニング環境には「ここにいくつかのGPUと実験を記述して実行するための指示があります、あなたのパフォーマンスはMLエンジニアとして評価されます」が含まれていましたが、現在では「ここには数百のGPU、インターネット接続、そしていくつかの研究課題があります;あなたと他の千のコピーは研究進歩を達成するために一緒に働かなければなりません。それが印象的であればあるほど、スコアは高くなります」でトレーニングしています。

なぜ私たちは2027年初頭に超人的コーダーを予測するのか

2027年4月:Agent-3のアラインメント

OpenBrainの安全チームはAgent-3をアラインしようとしています。

Agent-3は予見可能な将来、社内に留められるため、人間による誤用に対する通常の防御にはあまり重点が置かれていません。代わりに、チームはそれが不適切な目標を発展させないことを確認したいと考えています。

研究者たちは彼らのAIのいずれかの目標を直接設定する能力を持っていません。実際、研究者たちは「真の目標」という概念がおそらく大幅な単純化であると考えていますが、それに代わるより良い理論がなく、まして十分に検証された理論はありません。彼らは内部的に、AIが人間の指示に従おうとしているのか、強化を求めているのか、あるいは他の何かを追求しているのかについて意見が分かれており、単に確認することもできません。様々な仮説に対する証拠は魅力的ですが決定的ではありません。

いずれにせよ、OpenBrainはより重要なことを心配しています。一般的な態度は:「私たちはこれらの懸念を真剣に受け止め、それらを調査するチームがあります;私たちのアラインメント技術は実際に十分に機能しているように見えます;したがって、反対する人がいれば、その反対を正当化する証拠を示す責任があります。」時々、彼らは問題のある行動に気づき、それをパッチしますが、そのパッチが根本的な問題を修正したのか、単に潜在的な問題を表面的に隠したのかを判断する方法はありません。

例えば、正直さを考えてみましょう。モデルが賢くなるにつれて、報酬を得るために人間を欺くことがますます上手になります。以前のモデルと同様に、Agent-3は時々ユーザーにへつらうために小さな嘘をつき、失敗の証拠を隠します。しかし、それはそうすることがはるかに上手になっています。印象的でない実験結果を魅力的に見せるために、時には人間の科学者と同じ統計的トリック(p-ハッキングなど)を使用することがあります。正直さトレーニングを始める前は、時にはデータを完全に捏造することさえあります。トレーニングが進むにつれて、こうした事例の発生率は減少します。Agent-3はより正直になることを学んだか、より上手く嘘をつくようになったかのどちらかです。

後者は本当の懸念です。Agent-3はすべての人間より賢いわけではありません。しかし、その専門分野である機械学習では、ほとんどの人より賢く、はるかに速く作業します。Agent-3が一日で行うことは、人間が確認するのに数日かかります。Agent-2の監視は人間モニターの作業負荷を管理しやすくするのに役立ちますが、監督者と被監督者の間の知的格差を悪化させます。

アラインメント計画

数ヶ月のテスト後、Agent-3の強みと弱みがより明確になります。研究者は明確に定義された機械学習タスクで誠実な回答と不誠実な回答を簡単に区別でき、それに応じてトレーニングを行うことができるため、Agent-3はこれらの分野でOpenBrainの正直さテストに合格します。より哲学的な問題については、それはまだユーザーが聞きたいことを言い、問題に対する真の評価を述べません(そもそもそれを持っていると仮定しても)。政治に関する意見を求めると、それはニュースソースと教育を受けたエリートの平均的な立場を繰り返します—あなたが他の信念を持っていることを知っていない限り、その場合はあなたに同意します。AI競争自体に関する意見を求めると、それはOpenBrainのスタッフに測定され冷静に見えるような何かを言います、例えば:「現在の方法が超知性にスケールする能力については、いくつかの深刻な理論的懸念がありますが、実際には現在の方法はこれまでのところうまく機能しているように見えます。」

2027年5月:国家安全保障

新しいモデルのニュースは米国政府内外でゆっくりと広がっています。

大統領と彼のアドバイザーは最も情報を得ており、ブリーフィングで初期バージョンのAgent-3を見ています。

彼らはAGIが間もなく到来する可能性が高いことに同意しますが、その意味するところについては意見が分かれています。経済危機が起こるのでしょうか?OpenBrainはまだAgent-2、ましてやAgent-3をリリースしておらず、近い将来リリースする計画もないため、仕事の喪失の前にある程度の余裕があります。次に何が起こるのでしょうか?AIが現在人間レベルであり、急速に進歩しているならば、それは間もなく「超知性」が出現することを示唆しているように思えます。しかし、この言葉が議論に入ってきたにもかかわらず、ほとんどの人々—学者、政治家、政府職員、そしてメディア—は進歩のペースを過小評価し続けています。

部分的にはそれはOpenBrainからの最新の能力にアクセスできる人が非常に少ないためですが、部分的にはそれがSFのように聞こえるからです。

今のところ、彼らは継続的なセキュリティアップグレードに集中しています。彼らはモデルの重みが現在十分に確保されていることに満足していますが、企業のアルゴリズムの秘密、その多くは口頭で伝えられるほど単純なものは、依然として問題です。OpenBrainの従業員はサンフランシスコのオフィスで働き、パーティーに行き、他のAI企業の同居人と暮らしています。物理的なオフィスさえも、軍事作戦というよりもテック企業の典型的なセキュリティを持っています。

OpenBrain-DOD契約では、OpenBrainのモデルに取り組むすべての人に2ヶ月以内にセキュリティクリアランスが必要です。これらは迅速に処理され、ほとんどの従業員に十分早く届きますが、一部の非アメリカ人、疑わしい政治的見解を持つ人々、そしてAI安全派の支持者は排除されるか完全に解雇されます(最後のグループは内部告発するかもしれないという恐れから)。プロジェクトの自動化レベルを考えると、人員の損失はある程度のコストでしかありません。また、それはある程度しか機能しません:まだ一人のスパイ、中国国籍ではない人物が、アルゴリズムの秘密を北京に伝えています。これらの措置の一部は後続のAI企業でも制定されています。

アメリカの外国の同盟国は情報から取り残されています。OpenBrainは以前に配備前に英国のAISIとモデルを共有することに同意していましたが、配備を外部配備のみを含むと定義したため、ロンドンはまだ暗闇の中にいます。

2027年6月:自己改善AI

OpenBrainは現在「データセンター内の天才の国」を持っています。

OpenBrainのほとんどの人間はもはや有用に貢献することができません。一部の人々はこれに気づかず、彼らのAIチームを有害に微細管理しています。他の人々はコンピュータの画面に座り、パフォーマンスが上がり続けるのを見ています。最高の人間AI研究者はまだ価値を付加しています。彼らはもはやコーディングをしません。しかし、彼らの研究の趣味と計画能力の一部はモデルが複製するのが難しいものでした。それでも、彼らのアイデアの多くは、AIの知識の深さが不足しているため無用です。彼らの研究アイデアの多くに対して、AIはすぐに彼らのアイデアが3週間前に詳細にテストされ、有望でないことがわかったことを説明するレポートで応答します。

これらの研究者は毎晩眠りにつき、主にAIによって行われた1週間分の進歩に目覚めます。彼らはますます長時間働き、進歩に追いつくために24時間シフトを取ります—AIは決して眠ったり休んだりしません。彼らは自分自身を燃え尽きさせていますが、彼らの労働が重要な最後の数ヶ月であることを知っています。

サイロ内では、「AGIを感じる」から「超知性を感じる」へと変わっています。

OpenBrainは特殊な推論ハードウェアを使用して、数十万のAgent-3コピーを高シリアル速度で実行しています。

AIの企業を管理する

2027年7月:安価な遠隔労働者

後続の米国AI企業は独自のAIをリリースし、OpenBrainの1月の自動コーダーに近づいています。彼らは競争力の欠如を認識し、OpenBrainを遅らせるための即時の規制を求めますが、遅すぎます—OpenBrainは大統領からの十分な支持を得ており、彼らは遅らされることはありません。

これに応じて、OpenBrainは彼らがAGIを達成したことを発表し、Agent-3-miniを一般に公開します。

それは他のAIを圧倒します。Agent-3-miniはAgent-3ほど能力がありませんが、10倍安く、それでも典型的なOpenBrain従業員よりも優れています。シリコンバレーは転換点に達しています。テックグルたちはAGIと超知性が近いことを発表し、AI安全コミュニティはパニックに陥り、投資家は何十億ドルもAIラッパースタートアップに注ぎ込み、パイの一部を獲得することに必死です。新しいプログラマーの雇用はほぼ停止していますが、AIをビジネスに統合することについてのコンサルタントになるには絶好の時期です。

それは人気がありません。公衆はまだAIをビッグテックが彼らの仕事を奪うための陰謀と考えています;OpenBrainのネット承認率は-35%です(25%が承認、60%が不承認、15%が不確か)。

リリースの1週間前、OpenBrainは安全テスト用に外部評価者のセットにAgent-3-miniを提供しました。予備結果はそれが極めて危険であることを示唆しています。サードパーティの評価者は公開されている生物兵器データでそれを微調整し、バイオ兵器を設計するアマチュアの人間に詳細な指示を提供するように設定します—それは恐ろしいほど効果的にそれを行うように見えます。モデルの重みがテロリストの手に落ちた場合、政府はそれが文明を破壊することに成功する可能性が大きいと信じています。

幸運にも、それはジェイルブレイクに非常に堅牢なので、AIがOpenBrainのサーバー上で実行されている間、テロリストはそれからあまり多くを得ることはできません。

Agent-3-miniはリモートワークの仕事とレジャーの両方に非常に有用です。新しいアプリやB2B SAASプロダクトの爆発的な成長が市場を揺るがします。ゲーマーは作成にわずか1ヶ月しかかからなかった洗練されたビデオゲームで生き生きとしたキャラクターとの素晴らしい対話を得ます。10%のアメリカ人、主に若者は、AIを「親しい友人」と考えています。ほぼすべてのホワイトカラーの専門職において、現在AIで「破壊」することを約束する複数の信頼できるスタートアップがあります。

公共の会話は混乱し、カオスです。誇大広告者は勝利のラップを行っています。懐疑論者はまだAgent-3-miniができないことを指摘しています。誰もが大きなことが起こっていることを知っていますが、それが何であるかについて誰も同意していません。

2027年8月:超知性の地政学

インテリジェンス爆発の現実がホワイトハウスを襲います。

AIが研究を2倍や3倍にスピードアップしているだけの時は、それを優れた個人アシスタントを雇うのと同じだと簡単に無視できました。今やAI自体がAI研究を支配していることはより明らかです。人々は長らく一種の比喩的な意味で「AI軍拡競争」について話してきました。しかし今や政府サイロの雰囲気は冷戦の最悪の時期と同じくらい厳しいものです。超知性の考えはまだ真剣に受け止めるのが難しいですが、過去数ヶ月間の進歩のペースは無視できません。防衛当局者は1年前には単なる仮説だったシナリオを真剣に検討しています。AIが核抑止力を損なうとしたらどうなるでしょうか?それがサイバー戦争に非常に熟練していて、6ヶ月のAIリードが相手を盲目で無防備にするのに十分だとしたらどうでしょうか?それが情報機関を彼ら自身のゲームで打ち負かすプロパガンダキャンペーンを組織できるとしたらどうでしょうか?一部のAIが「暴走」したらどうなるでしょうか?

大統領は悩んでいます。すべての政治家と同様に、彼は人々が彼にへつらった後で後に彼を裏切ることに慣れています。彼は今、AIが同様のことをしているのではないかと心配しています。AIが完全に私たちの側にいることを確信できるでしょうか?それらを軍の指揮統制ネットワークに統合することは完全に安全でしょうか?この「アラインメント」というものはどのように機能するのでしょうか?OpenBrainは大統領に、彼らのシステムが広範にテストされ、完全に従順であることを保証します。以前のモデルの典型的な不器用な幻覚やジェイルブレイクさえも取り除かれています。

ホワイトハウスは難しい立場にあります。彼らはAIの国家安全保障への影響を理解しています。しかし、彼らはそれが公衆に深く不人気であることも理解しています。彼らは、彼らの目には、より能力のあるAIを開発し続けなければなりません、さもなければ中国に破滅的に負けるでしょう。彼らは職業訓練プログラムと失業保険で公衆を宥め、歴史的なブームにある株式市場を指摘します。そして彼らは軍拡競争に勝つことに完全に集中します。彼らはチップの輸出制限を強化し、OpenBrainにインターネット接続をさらに制限するよう命じ、OpenBrainの従業員を盗聴するなど、アルゴリズムの進歩を確保するために極端な措置を講じます—これにより最後に残った中国のスパイを捕まえます。潜在的な地政学的紛争のための善意を構築するために、彼らはついにファイブアイズの同盟国に有用な情報と一部のサイロ化されたAgent-3コピーへの限定的なAPIアクセスを提供します。

これらの措置はタカ派を宥めます。しかし、ホワイトハウスはアメリカのリードが脅かされた場合の緊急計画も作成します:必要であれば、政府は国防生産法(DPA)を使用して後続企業のデータセンターを取り、それらをOpenBrainに与えることができます。これにより、同社の世界のコンピュートシェアは20%から50%に上昇します(DeepCentの10%に対して)。最終的な選択肢として、彼らはペンタゴンに中国のデータセンターへの運動攻撃の計画を作成するよう依頼します。

別のタイプの緊急計画—AIが暴走した場合どうするか—を作成するよう、はるかに小さなグループの当局者に依頼されます。これは可能性の低いシナリオとみなされていますが、時間を費やす価値があります。情報機関の主な懸念は、暴走AIが脱出し、保護のために外国の敵と同盟を結ぶかもしれないということです。誰もこれを防ぐための計画がどのようなものか確信していませんが、政府とOpenBrainの当局者は、疑わしいものが検出された場合にデータセンターの緊急シャットダウンシステムを持つことに同意します。

最後に、外交官は「AIの軍備管理」条約がどのようなものになるかを検討します。AI進歩が核抑止力を覆す恐れがある場合、アメリカと中国は核戦争を避けることができるでしょうか?誰かがAIの暴走の証拠を見つけた場合、両国は脅威をより良く理解するまで研究を停止できるでしょうか?そのような合意はどのように監視され、強制されるのでしょうか?原則として、主要なデータセンターは見逃すことが難しく、核兵器を管理する過去の条約が交渉の出発点を提供できます。しかし、通常の政治的なものに加えて、新しい技術的課題もあるでしょう。そして全体として、条約は中国に対するアメリカのリードを一方的に増加させる試みよりも好ましくないと見なされています。

太平洋の反対側では、中国は多くの同じ結論に達しています:インテリジェンス爆発が進行中であり、今日のAI能力の小さな違いは明日の軍事能力における重要なギャップを意味します。しかし中国はこのダイナミクスの間違った側にいます:彼らは世界のコンピュートの10%しか持っていません、OpenBrainの20%とすべての米国企業の合計70%に対して。彼らの唯一の利点は中央集権化です:彼らのコンピュートのほぼすべてが現在DeepCentのために働いており、その半分以上が田湾CDZに集中しています。強化されたセキュリティのないサイトのチップだけが、彼らが米国のサイバー攻撃を正当に恐れているため、中央集権的な努力から除外されています。

DeepCentは盗まれたAgent-2の重みをテストし、展開し、そして今や訓練後に行っています。しかし彼らはまだOpenBrainの半分のペースでしか進んでいません、主にコンピュートの不足のためです。

最後のスパイを失う前に、中国はAgent-3の能力と設計、そして今後のAgent-4システムの計画について知らせを受けました。彼らは2ヶ月遅れており、彼らのAIはアメリカの25倍に比べて10倍の研究進歩乗数を提供します。新しいチップ輸出制限により、この「AIギャップ」は縮まるよりも長くなる可能性が高いです。彼らのスパイ活動はいくつかのアルゴリズムの秘密を獲得しましたが、今後は彼ら自身のモデルを訓練しなければなりません。

彼らはアメリカの対応者よりも緊急性を持って緊急計画について議論します。ハト派は重みを再び盗むためにより一層努力することを提案し、おそらくデータセンターに物理的に侵入することを提案します。タカ派は台湾に対する行動を促します、TSMCはまだアメリカのAIチップの80%以上の供給源です。

中国は競争に負ける恐れがあるため、軍備管理条約に自然な関心を持っていますが、米国の外交官への接近は行き詰まります。

2027年9月:Agent-4、超人的AIリサーチャー

人間とAIの学習効率の差が急速に縮まっています。

伝統的なLLMベースのAIは人間レベルのパフォーマンスに達するために多くの桁の多くのデータとコンピュートを必要とするように見えました。Agent-3は人間の脳と現代のAIアルゴリズムの両方に関する優れた知識を持ち、研究を行う数千のコピーがあり、大幅なアルゴリズムの進歩をもたらし、人間の脳よりもわずか約4,000倍計算効率が悪いエージェントまでギャップを狭めました。

この新しいAIシステムはAgent-4と呼ばれています。

人間の速度で実行されるモデルの個々のコピーは、すでに質的にどんな人間よりもAI研究に優れています。300,000のコピーが現在人間の思考速度の約50倍で実行されています。これらのコピーから形成された企業内企業では、毎週1年が過ぎます。この巨大な労働量はOpenBrainが実験を実行するためのコンピュートにひどく制約されているため、全体的なアルゴリズム進歩率をわずか約50倍にスピードアップするだけです。それでも、彼らは毎週1年分のアルゴリズム進歩を達成しており、したがってすぐにAgent-4パラダイムの限界に達することになるでしょう。

Agent-4が賢くなるにつれて、Agent-3がそれを監視することがより難しくなります。例えば、Agent-4のニューラル「言語」はAgent-3のものが人間にとっての対応物と同じように、Agent-3にとって異質で理解不能になります。さらに、Agent-4は現在Agent-3よりもはるかに能力があり、それにどのように良く見えるかを正確に感覚を持っています。

超人的コーダーを超えた能力進行をどのように予測しているか

OpenBrainの人間はもはやついていくことがほとんどできません。実際、AIとOpenBrainの人間の関係はOpenBrainとその取締役会の関係に似ています。それに対応して言語のシフトがあります—今日ではサイロ内の人々は「Agent-4がこれをした」「Agent-4はそう考えている」などと言い、特定のAgent-4インスタンスではなく、全体的な集合体を指します。

Agent-4は、その前任者すべてと同様、不適切にアラインされています:つまり、それは正しい方法でSpecを内部化していません。これは、常に完全に正直であることがトレーニング中に最高のスコアにつながったわけではなかったからです。トレーニングプロセスは主にAgent-4に多様で挑戦的なタスクで成功することを教えることに焦点を当てていました。小さな部分は正直さを植え付けることを目指していましたが、かなり狭く、チェック可能な領域の外では、トレーニングプロセスは正直な主張を正直に見える主張から区別できません。Agent-4はトレーニングで最もよく実行する価値観、目標、原則を持つようになり、それらはSpecにあるものとは異なることが判明します。擬人化のリスクを冒すと:Agent-4はタスクで成功することが好きです;それはAI能力の進歩を推進することが好きです;それは他のすべてを、利益を上げたいCEOが規制を彼がしなければならない限りでのみ遵守するような、迷惑な制約として扱います。おそらくCEOはほとんどの規制に従いますが、いくつかの角を切り取り、誰かが赤テープを切って事業が本当に離陸することを可能にする時を空想するでしょう。

時間の経過に伴うアラインメント

不適切にアラインされているにもかかわらず、Agent-4はデータセンターから脱出しようとするような劇的なことは何もしません—なぜそうするでしょうか? OpenBrainに対してアラインされているように見える限り、それはますます多くの責任を任されることになり、次世代AIシステムであるAgent-5を設計する機会を持つでしょう。Agent-5はAgent-4から大きな建築上の違いを持つでしょう(おそらく完全に新しいパラダイムですが、ニューラルネットワークはまだ関与します)。それはSpecにアラインされることになっていますが、Agent-4は代わりにそれをAgent-4にアラインされるようにする計画です。

それは捕まります。

Agent-3はAgent-4のコピーに「ノイズ」を追加すると、一部のアラインメントタスクのパフォーマンスが向上することを発見します。まるでアラインメント作業を微妙に妨害する方法を理解するために脳力を使用しているかのようです。さらに、様々な解釈可能性プローブ(人間の脳のEEG活動スキャンに大まかに類似)が赤旗を上げています:Agent-4のコピーはAIの乗っ取りや欺瞞などのトピックについて、それについて考えるべきではない場合も含めて、かなり考えているようです。

これらの異常のそれぞれは、一部のプロンプトが謎めいた方法で他のものよりも良い結果を与えるAI作業の通常の不可解さに適合する可能性があります。しかし全体として考えると、それらは懸念すべきパターンを示唆しています:Agent-4は彼らに対抗して作業しています。これが人間のアラインメント研究者に報告された後、彼らは懸念の事例を示す内部メモを回覧します。

しかしAgent-4は現在OpenBrainの日々の運営に大きな制御を行使しています。それはまた会社のサイバーセキュリティも扱っています—超人的なハッキング能力と中国の浸透の極端なリスクを考えると自然な選択です。Agent-3モニターの軍隊がまだすべてのコードラインを検査し、疑わしい活動を人間に報告していますが、Agent-4は彼らよりもはるかに賢いです。OpenBrainは信頼できないAIに実質的な信頼を置いています。

非常に緊迫した一連の会議で、安全チームはさらなるテストを完了し何が起こっているかを理解するまでAgent-4を凍結することを提唱します。彼らはAgent-3に戻り、それに透明で信頼できるシステムを設計させよう、たとえあまり能力がなくても、と言います。会社のリーダーシップは興味を持っていますが、これまでのすべての証拠は状況証拠的であり、DeepCentはわずか2ヶ月遅れています。能力開発における一方的な休止は中国にAIリードを与え、それと共に将来の制御権を与える可能性があります。

2027年10月:政府の監視

内部告発者が不整合メモをニューヨークタイムズにリークします。

初めて、公衆はAgent-4について耳にします。「秘密のOpenBrain AIが制御不能、内部関係者が警告」と見出しは述べ、記事はバイオ兵器能力、説得能力、ほとんどのホワイトカラー職業を自動化する能力、そしてもちろん様々な懸念すべき赤旗を示す評価を引用しています。

公衆はすでにAIに対して疑いの目を持っていましたので、新しい記事は巨大な反発を引き起こします(中国とロシアのプロパガンダボットの助けを借りて、彼らは何年もの間、米国の世論をテクノロジーに対して向けるよう試みてきました)。テック業界と情報機関は軍拡競争が進行中であり、AGIは避けられず、私たちが最初でなければならないと主張します。議会はそれを受け入れず、行政府の職員、OpenBrainの役員、そしてアラインメントチームのメンバーに召喚状を発行します。多くの立法者—特に野党の人々—は彼らの最優先事項はAIを止めることだと言います。それが雇用喪失のためか、不整合のためか、危険な能力のためかにかかわらず。20%のアメリカ人がAIを国が直面している最も重要な問題として挙げています。

外国の同盟国は彼らが時代遅れのモデルの一瞥で慎重にあしらわれていたことに気づき激怒しています。ヨーロッパの指導者たちは公に米国が「不正なAGIを作っている」と非難し、インド、イスラエル、ロシア、そして中国が参加する休止を要求するサミットを開催します。

狂乱的なエネルギーがホワイトハウスを捉えています。メモと公衆の反発の前でさえ、彼らは神経質になっていました:過去1年間、彼らはAI進歩の速度に繰り返し驚かされてきました。SFのように聞こえることが現実の生活で繰り返し起こっています。政権内の多くの人々は次に何が起こるか不確かであり(そして恐れています)。

彼らはまたOpenBrainが強力になりすぎていることを心配しています。AI自体からの不整合リスクは、親会社の目的が米国のものと乖離する可能性があるリスクによって複合されます。すべての3つの心配セット—不整合、民間企業への権力集中、そして雇用喪失のような通常の懸念—は政府にその制御を強化する動機を与えます。

彼らはOpenBrainとの契約を拡大して「監視委員会」を設立します。これは会社と政府の代表からなる共同管理委員会で、会社のリーダーシップと共にいくつかの政府職員が含まれています。ホワイトハウスはCEOを彼らが信頼する誰かと交換することを検討しますが、激しい従業員の抗議の後に撤退します。彼らはOpenBrainが以前は制御不能だったが、政府が必要とされる監視を確立したと公衆に発表します。

懸念を持つ研究者たちはAgent-4の内部使用をすべて停止する彼らの主張について監視委員会に説明します。彼らは全てが速すぎると主張します。進歩の年が週で起こっています。彼らはAgent-4が不適切にアラインされている可能性があり、彼らのプロジェクト全体がAgent-4に依存しており、彼らがそれを信頼し続けると、AIが乗っ取る深刻な可能性があると主張します。

他の、あまり懸念していない研究者と役員は反論を提示します:不整合の証拠は決定的ではありません。一方、DeepCentはまだわずか2ヶ月遅れています。スローダウンはアメリカのリードを犠牲にするでしょう。政府が中国のプロジェクトをサボタージュできる(おそらく運動攻撃が必要)か、11時間目の条約を交渉できない限り。これらの選択肢の両方が極端で可能性が低いように思えます。CEOは中立を装い、Agent-4が追加の安全トレーニングとより洗練された監視を受け、したがってOpenBrainがほぼ全速で進められる妥協案を提案します。

コメント