27,057 文字

私はいつも心配してきました。おそらく10年ほど前から、AIが独裁制の原動力になりうることを懸念していました。抑圧的な政府が、どれだけ抑圧的になれるかという限界は、通常、彼らの執行者、つまり人間の執行者に何をさせられるかによって決まります。しかし、その執行者がもはや人間でなくなると、非常に暗い可能性が見えてきます。メタのような企業がますます力を誇示し、「気に入るか出て行くかだ」と言い始めているのを目にしています。これは正に「出て行け」の瞬間でした。5%の人員を削減して、自分たちにはボーナスを与えると。

あなたはスタイリストと仕事をしているのですか?

はい、その通りです。

これは彼らの手腕なのですか?

いいえ、来週初めての打ち合わせがあります。

AIを使う予定はありますか?

いいえ、でも今あなたに言われて考えてみると、スタイリストを困らせるために、物理的に不可能なデザインをたくさん持っていくかもしれません。

私は今週末、2つのAIイベントに行きました。いわばAIスペクトルの両極端でした。エフェクティブ・アルトルイストたちが年次大会を開いていました。そして金曜の夜、誇らしいことに、夜遅くまで、午前2時まで外出していました。非公式にマーク・ザッカーバーグと関連した「Zuck RAVE」と呼ばれるAIレイブに行きました。

非公式と言うとき、マーク・ザッカーバーグは全く関与しておらず、彼はそれが起きていることを知らなかったと思います。

その通りです。彼の関与を表す正確な言葉は「無関与」でしょう。それはマーク・ザッカーバーグへのトリビュート・レイブで、AIを加速させたいと考えるアクセラレーショニストの人々が主催していました。

別の言い方をすれば、許可なく彼の肖像を使用したということですね。

はい、でもそれは有名人にはよくあることです。

そのZuckレイブでは、あまり多くの人がレイブをしていませんでした。ダンスフロアはありましたが、とても人が少なかったです。ダンスフロアに向けたカメラがあって、正しい場所に立つと、大きなスクリーン上であなたの顔がマーク・ザッカーバーグの顔に変わるというものがありました。これはキノコを摂取しているときに体験したくないことでしょう。非常に不安定な体験になる可能性があるからです。屋内にはおもちゃの電車があり、かなり速いスピードで動いていました。

このレイブの目的は何だったのですか?

薬物を摂取することでした。それがこのレイブの目的でした。

私はニューヨーク・タイムズのテクノロジー・コラムニストのケビン・ローズです。

私はプラットフォーマーのケイシー・ニュートンです。これはハードフォークです。

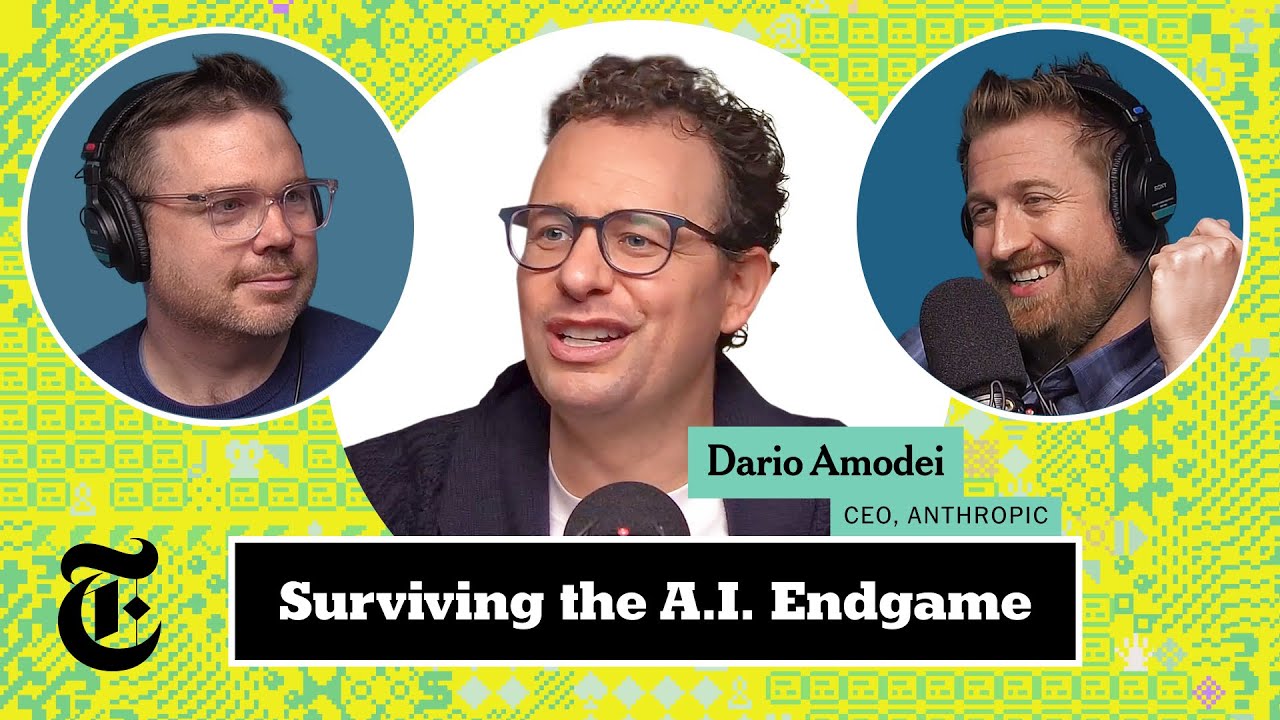

今週はアンスロピックのCEOであるダリオ・アモデイが再び番組に登場し、新しいクロードや中国とのAIレース、そして彼のAIの未来に対する希望と懸念について特別なインタビューを行います。そして、最後にハットGPTのラウンドで締めくくります。

大きな番組になりそうですね、ケビン。ケイシー、AIの企業は今や週末も仕事をしていることに気づきましたか?

そうですね、週5日だけというのはどうなったのでしょう。

彼らは記者の勤務時間を尊重していません。企業はいつも土曜日や日曜日、そして異なるタイムゾーンで発表を行います。大変な苦労です。

でも今週末、日曜日に私は興奮するようなメッセージを受け取りました。アンスロピックのCEOであるダリオ・アモデイが話したいニュースがあり、ハードフォークに出演したいと言っていました。

同時期に私もアンスロピックから彼らの最新モデルを試すことができるという電子メールを受け取り、週末にそれを試してみました。

長年のリスナーは、ダリオが以前この番組に出演したことを覚えているでしょう。2023年に彼はアンスロピックでの彼の仕事とAIの安全性についてのビジョン、そしてこれらがすべてどこに向かっているのかについて話しました。いくつかの理由から、彼と再び話すことをとても楽しみにしていました。

まず、彼はとても面白く思慮深い人だと思います。彼はほとんど誰よりもAIについて長く考えてきました。AIの安全性について潜在的に恐ろしいことに関する論文を2016年からすでに書いていました。彼はGoogleにいて、OpenAIにいて、今はアンスロピックのCEOです。AIに関しては本当に究極のインサイダーなのです。

そして、ケビン、私はダリオがもう一つの重要な理由で重要な人物だと思います。それは、大手AIラボをリードしている人々の中で、彼は間違いが起こりうることについて最も公に心配している人だということです。それは彼にとって長い間そうでした。しかし、過去数か月間、私たちが番組で指摘したように、振り子はAIの安全性を気にすることから、ただひたすら前進するアクセラレーショニズムへと大きく振れているように感じます。これはJDバンス副大統領が先日フランスで行ったスピーチに象徴されています。そのため、彼をここに招き、もしかしたらその振り子を少し戻し、何が危険にさらされているのかを人々に思い出させることができるかもしれないと思います。

あるいは少なくとも、振り子がどのように揺れているのか、そして彼がなぜ将来それが戻ると考えているのかについての彼の見解を聞くことができるでしょう。

今日はダリオと、アンスロピックが先ほど発表したクロード3.7ソネットという新しいモデルについて話します。しかし、私たちはより広い会話をしたいと思います。なぜなら、今AIにはとても多くのことが起きているからです。そして、ケビン、私たちが注意すべきもう一つのことは、前回彼が番組に来たときとは違って、今は私のボーイフレンドが彼の会社で働いているということです。

ケイシーのボーイフレンドがアンスロピックで働いているのですか?

マイ・アンスロピックのことですね。これについては長い開示があり、platformer.news/ethicsで読むことができます。今週も読む価値があるかもしれません。

では、ダリオ・アモデイをお迎えしましょう。ダリオ・アモデイ、ハードフォークへようこそ。

ありがとうございます。再びお招きいただき感謝します。

復帰したチャンピオンですね。クロード3.7について教えてください。この新しいモデルについて教えてください。

はい、私たちはしばらくこのモデルに取り組んできました。基本的に2つのことを念頭に置いていました。一つは、数ヶ月前から市場に出ている推論モデルがあり、私たちも独自のものを作りたかったことです。しかし、私たちが焦点を当てたかったのは少し異なっていました。

特に、市場の他の推論モデルの多くは、主に数学や競技プログラミングに訓練されています。これらは客観的なタスクで、パフォーマンスを測定できるものです。印象的でないとは言いませんが、現実世界や経済のタスクにはあまり関連していないことがあります。競技プログラミングと現実世界で何かをすることの間には、本当に違いがあります。そこで私たちはクロード3.7を、これらの現実世界のタスクに焦点を当てるように訓練しました。

また、私たちは推論モデルについて、一般的に通常のモデルと推論モデルの2つがあるというのは少し奇妙だと感じました。これは人間が2つの脳を持っているようなものです。例えば、あなたの名前は何ですか?のような簡単な質問をするときは脳1と話し、数学の定理を証明するように頼むときは脳2と話すというようなものです。後者の場合、私は20分座って考える必要があるからです。

それは、おしゃべりが好きなホストと、実際に話す前に考えるホストがいるポッドキャストのようなものですね。

おいおい、そりゃひどい。コメントはしません。関連性については何も言いません。

クロード3.7を使い始めるユーザーは、以前のモデルと比較してどのような違いに気づくでしょうか?

はい、いくつかのことがあります。一般的に、より良くなります。コーディングも含めてですが、クロードモデルは常にコーディングが最も得意でした。しかし3.7はさらに一歩前進しました。モデル自体の特性に加えて、拡張思考モードで使用することができます。基本的に同じモデルに対して、より長く考えることができるような方法で動作するように指示することができます。APIユーザーであれば、思考の境界線とどれだけ長く考えることができるかまで指定することができます。

混乱する人がいるかもしれないので明確にしておきますが、あなたが言っているのは、新しいクロードはこのハイブリッドモデルであり、時には推論を行い、時にはより迅速な回答を行いますが、さらに長く考えさせたい場合、それは別のモードであるということですね?

はい、別のモードです。思考と推論は別のモードです。

基本的に、モデルは通常通り回答することもできますし、より長く考えるべきだという指示を与えることもできます。さらなる進化の方向性としては、モデルが自分で適切な思考時間を決定することでしょう。人間はそのようなものですよね、少なくともそうなれます。名前を尋ねられたとき、「うーん、どれくらい考えるべきだろう、20分ください」などとは言いません。しかし、「この株の分析をしてほしい」や「この数学の定理を証明してほしい」と言われたとき、そのタスクを実行できる人々は、すぐに答えようとはしません。彼らは「それには時間がかかるだろう」と考え、タスクを書き留める必要があるでしょう。

これは現在の言語モデルやAIモデル全般に対する私の主な不満の一つです。ChatGPTのようなものを使っていて、ハードコアな推論モードにいることを忘れ、「給湯器の設定を変更する方法」のような愚かな質問をすると、4分間も考え込んでしまい、「水温調整に関する詳細な論文なんて必要なかったのに」と思います。

モデル自体がそのような経路決定を行うようになるのはどれくらい先だと思いますか?質問をして、これには3分ほどの思考プロセスが必要そうだ、こちらは30秒ほどかな、というように。

私たちのモデルは、ある意味でこの方向への一歩だと思います。APIで思考の境界を設定すると、例えば最大20,000語まで考えると言った場合、ほとんどの場合、20,000語全てを使用しません。時には非常に短い応答を返すこともあります。これは、さらに考えることで得られるものがないと分かった場合、より長く考えないからです。しかし、どれだけ長く考えるかの境界を設定することは依然として価値があります。私たちはその方向に大きな一歩を踏み出しましたが、まだ望むところまでは到達していません。

現実世界のタスクが向上したと言いましたが、どのようなタスクを考えていますか?

何よりもコーディングだと思います。クロードモデルは現実世界のコーディングに非常に優れていました。GitHubからWindsurfのCodeium、Cognition、Vercelまで、多くの顧客がいます。確実に挙げ忘れている企業もあると思いますが。

これらはコーディングアプリのバイブですか、それとも単なるコーディングアプリですか?

単なるコーディングアプリです。様々な種類のコーディングアプリがあります。私たちはClaud Codeというものもリリースしました。これはより多くのコマンドラインツールですが、複雑な指示に従うことや、文書を理解すること、一連のツールを使用することなどにおいても、私たちが訓練した推論モデルであるクロード3.7ソネットはこれらのタスクにも優れています。

新しいクロードソネットが行っていないことの一つはインターネットにアクセスすることですね。なぜですか?そして何があれば変更する可能性がありますか?

以前も公に言ったと思いますが、ウェブ検索はまもなく提供される予定です。非常に近い将来にウェブ検索を提供します。これが欠けていることは認識しています。一般的に、私たちは消費者向けよりも企業向けに焦点を当てる傾向があり、これはよりコンシューマー向けの機能ですが、両方で使用できます。どちらにも焦点を当てているので、これは近々提供される予定です。

このモデルを3.7と名付けましたが、前のモデルは3.5でした。去年、静かに更新したモデルをインサイダーは3.6と呼んでいました。AIモデルの命名が何故こんなに意味不明なのでしょうか?

私たちが一番まともですが、それでもまだ意味不明であることは認めます。ここでの間違いは比較的理解できると思います。3.5ソネットを作り、3.0から3.5シリーズで順調でした。3.7は間違いだったことは認めます。APIで名前を変更するのは実際には難しいことがわかりました。特に多くのパートナーや提供するサービスがある場合には。

あなたたちなら解決できるでしょう。

いいえ、モデルを訓練するよりも難しいんです。本当です。そこで、前のモデルを遡って非公式に3.6と名付け、今回のが3.7だと理解できるようにしました。そして、クロードソネットや他のモデルのシーケンスは、かなり大幅な飛躍をするものために予約しています。

そのようなモデルはいつ頃出るのでしょうか?

これについて少し話すべきでしょう。これまでリリースしたモデルは実際にはそれほど高価ではありません。ブログ記事で書いたように、多くても数千万ドル程度の範囲です。それよりも大きなモデルが来ています。それらは時間がかかり、場合によっては正しく作るのに時間がかかります。しかし、それらの大きなモデルは近いうちに来ます。競合他社からも噂されていますが、私たちもより大きなベースモデルをリリースする予定で、それほど遠くない将来に出します。

クロード3.7ソネットの改善点の多くは、クロード3.6ソネットと同様に、トレーニング後のフェーズにあります。しかし、私たちはより強力なベースモデルにも取り組んでおり、おそらくクロード4シリーズになるかもしれませんし、そうでないかもしれません。比較的少ない時間単位で登場する予定です。

少ない時間単位ですね。それをカレンダーに記入しておきます。数時間単位後に確認するよう思い出させてください。

ケビン、アンスロピックではAIの安全性、そして世界に出すモデルの安全性について非常に懸念していることを知っています。内部でモデルのレッドチーミングや安全性について多くの時間を費やしていると思いますが、クロード3.7ソネットが持つ新たな能力で危険なもの、またはAI安全性を懸念する人が心配するようなものはありますか?

危険というわけではありません。これについては常に明確にしたいと思います。現在の危険と将来の危険の間には常に混同があると感じるからです。現在の危険が存在しないわけではなく、通常のテクノロジーリスク、通常のテクノロジーポリシーの問題はありますが、私がより心配しているのはモデルがより強力になったときに見ることになる危険です。

2023年の会話でも多くを話しましたが、例えば生物学的または化学的戦争のような悪用リスク、またはAIの自律性リスクについて言及しました。特に悪用リスクについては、これらがいつ現実のリスクになるかわからないと言いましたが、2025年や2026年に起こる可能性があると述べました。そして今、2025年の初めにあたるその期間の最初に来て、モデルはそれに近づき始めています。

特にクロード3.7ソネットでは、モデルカードに書いたように、私たちは常に制御のある試験のようなものを行います。生物学などの分野についてあまり知識のない人間を用意し、モデルがモック悪意のあるワークフローに関与するのをどれだけ助けるかを基本的に見ます。ステップのいくつかを変更しますが、悪意のあるワークフローで、モデルの支援を受けた人間がどれだけうまくできるかを調べます。時には実際の世界で湿式実験も行い、何か悪いものをモック作成します。

現在の技術環境と比較して、彼らがGoogleや教科書でできること、または無助けでできることと比較します。私たちが明らかにしようとしているのは、これが以前はなかった新しい脅威ベクトルを可能にするかどうかです。モデルが「これの配列を教えてくれ」または「マスを作るためのクックブックをくれ」と言ったときに与えるかどうかについては全く関心がありません。それはGoogleで簡単にできることです。

私たちが気にしているのは、ウイルス学博士だけが持つような秘教的な高度で稀な知識についてです。モデルがどれだけ助けになるか、そしてもしそうなら、すぐに私たちが皆疫病で死ぬということではなく、世界に新しいリスク、新しい脅威ベクトルが存在するということを意味します。例えば、核兵器を作りやすくなったり、必要なプルトニウムの量が以前よりも少なくなったりするようなものを発明したような状況です。

私たちはソネット3.7をこれらのリスクに対して測定しました。モデルは向上していますが、まだ本当に危険なことをするために必要なすべてのタスクを実行するための、実際の意味のある脅威の増加がある段階ではありません。しかし、モデルカードでは、次のモデルまたは今後3ヶ月、6ヶ月のモデルで、私たちがそのような段階に達する可能性がかなりあると評価しました。そうなれば、責任あるスケーリング手順が発動され、これらの非常に大きなリスクに焦点を当てた追加のセキュリティ対策や展開対策が実施されます。

つまり、今後3〜6ヶ月の間に、これらのモデルで中程度のリスク段階に入るということですね。おそらくあなたがその段階にいれば、競合他社も同様の段階にいるでしょう。実際にはそれは何を意味しますか?世界はどうすべきでしょうか?

少なくともこの段階では、それほど大きな変化はないと思います。モルデルが、緩和されなければ、非常に危険なことや非常に悪いことが起こるリスクをやや高める能力を持つ狭い範囲の事柄があるということを意味します。法執行官やFBIの視点で考えると、新しい脅威ベクトル、新しい種類の攻撃があるということです。それは世界の終わりを意味するわけではありませんが、このリスクが存在する産業に関わる人は誰でも、そのリスクに対する予防策を講じるべきです。

間違っているかもしれませんが、もっと時間がかかる可能性もあります。何が起こるかを予測することはできません。しかし、今日私たちが見ているリスクをあまり気にしない環境に反して、実際にはバックグラウンドでのリスクは増加しています。

もっと安全性についての質問がありますが、まずイノベーションと競争に関する質問を2つしたいと思います。現在、どの企業のモデルがどれだけ革新的であっても、それらのイノベーションはライバルによって数ヶ月、あるいは数週間で模倣されているように見えます。これはあなたの仕事を難しくしていますか?そしてこれは無期限に続くと思いますか?

イノベーションが正確にコピーされるとは必ずしも思いません。私が言いたいのは、多数の競合他社間のイノベーションのペースが非常に速いということです。非常に急速にイノベーションを起こし、モデルを迅速に生産している4〜5、あるいは6社があります。しかし、例えばソネット3.7を見ると、私たちが推論モデルを作った方法は競合他社とは異なります。私たちが強調した点も異なります。さらにそれ以前にも、ソネット3.5が得意とするものは他のモデルが得意とするものとは異なります。

人々はしばしば競争、コモディティ化、コスト低下について話しますが、現実には、モデルは実際に互いにかなり異なり、それが差別化を生み出しています。

リスナーからよく質問を受けますが、「AIツールに一つだけ課金するとしたら、何を選ぶべきか」という質問です。自分はこういう目的で使うが、という質問に対して、答えるのが難しいです。ほとんどのユースケースでは、どのモデルも比較的まともに質問に答えるからです。結局のところ、どのモデルのパーソナリティが好きか、それがどのように感じさせるか、どのように対話するかという点に行きつきます。消費者はAIモデルを能力に基づいて選ぶと思いますか?それともパーソナリティや感じ方、対話の仕方に基づいて選ぶことになると思いますか?

それはどの消費者を指しているかによると思います。消費者の中でも、何らかの複雑なタスクにモデルを使用する人々がいます。データを分析したい独立した人々、いわばプロシューマー側の人々がいます。その中では能力面でまだまだ伸びる余地があります。モデルは、生産性や旅行計画のような複雑なタスクを手伝うという点でも、現状よりもはるかに優れることができます。

それ以外にも、あなたの生活を管理する個人アシスタントを作ろうとしているなら、あなたの生活のあらゆる側面を見て、全体的なアドバイスを与え、役立つアシスタントになれるモデルには、まだまだ遠いです。そこには差別化があり、私にとっての最高のアシスタントは他の人にとっての最高のアシスタントではないかもしれません。

モデルが十分に良くなる一つの領域は、Googleの検索の代替や素早い情報検索として使用する場合で、これは何億人もの大量市場の無料ユーザーによって使用されていると思います。それは非常にコモディティ化されていると思います。モデルはすでにそのレベルに達していて、世界中に浸透しているだけだと思います。しかし、それらはモデルの興味深い使用法ではないと思いますし、経済的価値の多くがそこにあるとも思いません。

もし本当に素晴らしい個人アシスタントエージェントを開発した場合、それを最初に解決した会社は大きな優位性を持つことになるのでしょうか?他のラボはそれをコピーするのが難しくなりますか?彼らにはそれを再現する方法がより明らかではなくなるのでしょうか?

それを再現する方法はより明らかではなくなりますし、再現したとしても、正確には再現せず、彼ら自身のやり方でするでしょう。そして、それは異なる一連の人々に適したものになるでしょう。

つまり、市場は皆さんが考えるよりも分断されているということですね。すべてが一つに見えますが、実際にはより分断されています。

安全性につながる競争に関する質問をさせてください。最近、ディープシークのマニアの頂点で興味深い投稿をしました。その中で、彼らが発見したコスト削減は基本的にコストがすでに下落していたのと一致していると主張していましたが、ディープシークは中国が国がこれまでにないペースでフロンティアラボと歩調を合わせていることを示しているため、警鐘を鳴らすべきだとも言いました。それはなぜ注目に値するのか、また私たちは何をすべきだと思いますか?

これは商業的競争についてというよりも、国家間競争と国家安全保障の観点からディープシークを心配しています。私がここで言いたいのは、世界の状況を見ると、中国やロシアのような独裁国家があり、私はAIが独裁制の原動力になる可能性について、おそらく10年ほど前から心配してきました。

抑圧的な政府がどれほど抑圧的になれるかという限界は、一般的に彼らの執行者、つまり人間の執行者に何をさせられるかによって決まっています。しかし、その執行者がもはや人間でなくなると、非常に暗い可能性が見えてきます。したがって、私は非常に懸念している分野です。

リベラルな民主主義国家が十分なレバレッジと技術的優位性を持つことを確実にしたいと思っています。それによって、これらの虐待行為を防ぎ、また敵対国が世界の残りの部分に関して私たちを不利な立場に置いたり、私たちの安全を脅かしたりすることを防ぐことができます。

アメリカではこの技術を構築しているのは企業であり、中国ではこの技術を構築しているのも企業ですが、特に中国の企業の意図がどうであれ、私たちは素朴であるべきではありません。これには政府の要素があり、私は独裁国家が軍事的観点から先に進まないようにすることに関心があります。

彼らに技術の恩恵を否定しようとしているわけではありません。膨大な健康上の利益があり、私はそれらが世界中のどこにでも、最も貧しい地域や独裁政権の支配下にある地域を含めて、広がることを確実にしたいと思っています。しかし、独裁政府が軍事的優位性を持つことは望んでいません。そのため、私が投稿で議論した輸出規制のようなものは、それを防ぐためにできることの一つです。トランプ政権が輸出規制を強化することを検討していると聞いて、勇気づけられました。

先週末、AIの安全性に関する会議に参加し、その「ユニバース」の一部の人々からアンスロピック、そしておそらくあなた個人に対する批判を聞きました。彼らは、ディープシークについてのあなたの投稿のようなものを、事実上中国とのAI軍拡競争を促進し、アメリカが強力なAGIに最初に到達しなければならないと主張していると見なしていました。そして、この競争を加速させることで、一部のリスクがあることを心配していました。それに対するあなたの回答は?

私は物事を少し異なる見方をしています。私の見解では、もし私たちが最大速度で進まないようにする可能性を少しでも持ちたいなら、その計画は次のようになります。

アメリカや民主主義国の中では、これらはすべて多かれ少なかれ法の支配の下にある国です。したがって、私たちは法律を可決し、企業が政府と強制力のある協定を結ぶことができます。その協定は、安全性へのコミットメントに関するもので、強制力があります。

自然状態では、異なる企業が可能な限り速く競争するでしょうが、自主的なコミットメントと法律の混合によって、モデルが危険すぎる場合には減速することができます。これは実際に強制可能です。もし全員の頭に銃を向ければ、囚人のジレンマにおいて全員を協力させることができます。それが最終的に法の正体です。

しかし、国際競争の世界では、すべてが放棄されます。米国と中国の間の合意を強制する権限を持つ者はいません。私の心配は、もし米国が中国より数年先行しているなら、その数年間を使って物事を安全にすることができますが、中国と同じレベルなら、軍拡競争を促進するのではなく、それが起こるのです。

技術は莫大な軍事的価値を持っています。人々が今何を言おうと、協力についてどんな素晴らしい言葉を語ろうと、人々が技術の経済的・軍事的価値を完全に理解すれば、最も激しい競争以外のものにはならないと思います。

私が考えることができるのは、権威主義者たちの速度を遅らせれば、トレードオフをほぼ無効にするということです。それはOpenAI、Google、私たち、xの間で安全にモデルを作る方法を考える時間を与えてくれます。

ある時点で、権威主義者たち、例えば中国人を説得して、モデルが実際に危険であり、何らかの合意を持ち、それを強制する方法を見つけるべきだということを納得させることができるかもしれません。私はそれも試みるべきだと思いますし、そうすることを支持していますが、それをプランAにすることはできません。世界を見る現実的な方法ではないからです。

これらは本当に重要な質問や議論のように思えますが、あなたとケビンが数週間前にパリで参加したAIアクションサミットではほとんど議論されていなかったようです。あのサミットでは一体何が起こっていたのですか?

深く失望しました。それは見本市のような環境で、英国政府によってブレッチリー・パークで作られた最初のサミットの精神とはかけ離れていました。ブレッチリーは素晴らしい仕事をし、英国政府も素晴らしい仕事をしました。彼らは何をしているのか知る前に一連の面倒な規制を導入せず、リスクを議論するためにこれらのサミットを召集しようと言いました。それは良いことだと思いました。

しかし、それは廃れてしまい、おそらく一般的に、リスクを心配することから機会を掴もうとする動きへと変わったのかもしれません。私は機会を掴むことに賛成です。「愛の恵みの機械」というエッセイを書きました。その中で、利益について話すことに時間を費やす多くの人々よりも、私はリスクを心配する人間として、より良いビジョンを持っていると感じていると書きました。

しかし、背景として、モデルがより強力になるにつれて、私たちがそれらでできる驚くべき素晴らしいことが増えていますが、リスクも増加しています。その滑らかな指数関数的増加は、社会的傾向や政治的知恵に注意を払わず、リスクは臨界点まで増加しています。

あなたが注意を払っていようがいまいが関係ありません。AIリスクに関するこの狂乱があり、皆がそれについて投稿し、これらのサミットがあったとき、リスクは小さくなり増加していました。そして今、風向きは反対の方向に変わりましたが、指数関数はただ続いているだけです。それは気にしません。

パリで誰かと会話をしましたが、そこにいる誰もAGIを感じていないようだと言っていました。それは政治家や、パネルや集会を行っている人々がAIをまるで他の技術、おそらくPCやインターネットの程度のものとして話していたということを意味していました。しかし、あなたが話している種類の指数関数を本当に理解していなかったようです。あなたにとってもそう感じられましたか?そしてそのギャップを埋めるために何ができると思いますか?

はい、私もそう感じました。私が人々に伝え始めていることは、「もし公務員や企業のリーダーであれば、人々は2026年と2027年に振り返り、人類がこの狂気の時期を通過し、強力なAIがある成熟した社会で、これらの強力な知性と共存し、繁栄する社会にいるとき、皆が振り返って、公務員や企業の人々、政治システムは何をしたのかと問うでしょう。おそらくあなたの主な目標は愚かに見えないことです」と言っています。

振り返ったとき愚かに見えないよう慎重に発言してほしいと励ましてきました。私の思考の多くは、正しい結果を望むことだけではなく、愚かに見えたくないということによって動かされています。そして、その会議で、一部の人々は愚かに見えるでしょう。

短い休憩を取りましょう。戻ってきたら、人々がAIで来るものにどう備えるべきかについてダリオと話します。

サンフランシスコに住む人々と話すと、1〜2年以内にAIによって変革された世界に住むことになるという骨の髄まで染み付いた感覚があります。地理的な違いに驚かされます。どの方向に100マイル行っても、その信念は完全に消えてしまいます。ジャーナリストとして、私は自分の懐疑心を持ち込むことになります。周りの人々を本当に信頼できるのでしょうか?世界の残りの部分は、これがどのように進むかについて非常に異なるビジョンを持っているようです。この地理的な断絶についてどう思いますか?

私はこれを10年間見てきました。10年間この分野にいて、それ以前からAIに興味を持っていました。ここ数ヶ月間までのほぼすべての段階で、私の見解は、私たちは奇妙な空間にいるということでした。数年後には、人間のすることをすべて行うモデルが登場し、経済や人間の意味を完全に覆すか、あるいはその傾向が止まり、すべてが完全に愚かに聞こえるかもしれません。

今では、物事が起こる世界にいるという確信を高めました。数字でいえば、40%や50%ではなく、70%から80%という確率を与えるでしょう。

80%の確率とは?

ほぼすべてのことにおいて人間よりもはるかに賢いAIシステムを非常に多く獲得するという確率です。おそらく70%から80%の確率で、今世紀末までにそれを手に入れると思います。私の推測では2026年か2027年です。

地理的な違いについてのあなたの指摘ですが、指数関数の各ステップで、将来を見据えているか、あるいは妄想的なカルト信者かの観点に応じて、いわば「未来を理解している」人々の拡大する円があることに気づきました。

数千人しかいなかった時期を覚えています。あなたは本当に奇妙な人々と話し、彼らだけが信じていて、他の誰も信じていませんでした。今では数十億人のうちの数百万人程度で、確かにその多くはサンフランシスコに住んでいますが、バイデン政権の少数の人々、現政権の少数の人々がこれを信じ、それが彼らの政策を推進していました。

完全に地理的なものではありませんが、この断絶があると思います。数百万人から世界中の全員にどう伝えるかわかりません。この問題に焦点を当てていない議員や、ルイジアナの人々、ケニアの人々にどう伝えるのか。

それもまた、その目標を傷つけるかもしれない方法で政治的に分極化したようにも思えます。AIの安全性について心配すること、AIの安全性について話すこと、悪用の可能性について話すことが、左派またはリベラルとしてコード化され、加速と規制の撤廃、可能な限り速く進むことが右派としてコード化されているような調整が起こっているように感じています。これを人々が理解する障壁として見ていますか?

それは実際に大きな障壁だと思います。リスクに対処しながら利益を最大化するには、ニュアンスが必要です。実際に両方を持つことができます。利益をほとんどあるいは全く遅らせることなく、リスクを外科的かつ慎重に対処する方法があります。しかし、それらは微妙さと複雑な会話を必要とします。

一度物事が分極化すると、この言葉のセットに喝采を送り、あの言葉のセットにブーイングをするようになると、良いことは何も成し遂げられません。AIの利益を全ての人にもたらすこと、以前は治療不可能だった病気を治療することは、党派的な問題ではありません。左派はそれに反対すべきではありません。

同様に、AIシステムが大量破壊兵器に悪用されたり、インフラや人類自体を脅かす方法で自律的に振る舞うことを防止することも、党派的な問題ではありません。右派はそれに反対すべきではありません。同じ古い、疲れた政治的な争いに結びつけずに、大人の会話をする必要があるということ以外に言うことはありません。

歴史的に、国家安全保障、国防といった問題は右派の領域でしたが、現在、右派はAIに関してはそれらに興味を持っていないように見えます。その理由は、JDバンスのフランスでのスピーチでも聞こえたように、「アメリカが最初に到達し、永遠に勝ち続けるだろうから、これらの問題に対処する必要はない」という考えがあるのかもしれません。それは正しいと思いますか?

はい、そうだと思います。また、いわゆる「Doge派」と話すと、多くの共和党員やDCのトランプ陣営の中には、AIと未来のAIについての会話が、常にこれがいかに危険かを言い続け、その危険が本当に悪くなる時期の予測を常に延期し、それは間近に迫っており、今すぐ規制が必要だと言っている心配性の「空は落ちてくる」と叫ぶ悲観主義者によって支配されているという感覚があります。

彼らは非常に懐疑的で、あなたのような人々が心配する際に誠実だとは信じていないと思います。リスクの側面では、リスクの擁護者がしばしばリスクの原因の最悪の敵だと感じることがあります。多くのノイズがありました。「天然痘ウイルスをダウンロードできる」と言う人がいて、それは政治的影響力を持つための方法だと考えています。そして、もちろん他の側はそれを認識し、「これは不誠実だ、Googleでこれを得ることができる、誰がこれを気にするのか」と言いました。

したがって、リスクの証拠が不十分に提示されることは、実際にリスク軽減の最悪の敵です。私たちは提示する証拠に本当に注意する必要があります。私たち自身のモデルで見ていることについて、私たちは本当に慎重になるでしょう。もし本当にリスクが現在存在すると宣言するなら、証拠を持って来るでしょう。アンスロピックは、私たちが行う主張に責任を持って、危険が差し迫っているときにはお知らせします。まだ差し迫った危険について警告していません。

人々がAIの安全性に関する質問を真剣に受け止めない理由の一つは、現在見ているものの多くが非常に馬鹿げているからかもしれません。小さな絵文字を作ったり、小さなスロップの画像を作ったり、ゲーム・オブ・スローンズのチャットボットとチャットしたりしていることが理由だと思いますか?

それは理由の約60%だと思います。現在と将来のことに関連していると思います。人々はチャットボットを見て、「チャットボットと話しているだけだ、チャットボットが皆を殺すと思っているのか、バカなのか?」と反応すると思います。多くの人々がそのように反応します。

私たちは現在ではなく将来を心配していると言うために多大な努力をしていますが、その将来は今、非常に近づいています。私たちの責任あるスケーリングポリシーを見ると、それはAIの自律性とCBRN(化学的、生物学的、放射線的、核的)に関するものです。数百万人の命を脅かす可能性のある、ハードコアな悪用とAIの自律性が主な懸念事項です。

最も高いレベルでは、それらがアンスロピックが最も心配していることです。日常的なポリシーがあり、他のことに対処していますが、責任あるスケーリング計画のような主要文書は、専らそれらについてです。しかし毎日、Twitterを見ると、「アンスロピックはこの愚かな拒否をした」「アンスロピックはパイソンのプロセスを殺すことができないと言った、暴力的に聞こえるから」「アンスロピックはXをしたくなかった」と言われます。

私たちはそれらの愚かな拒否を望んでいません。それらは、私たちが実際に気にしていることの副作用です。そして、私たちはそれらが少なくなるように、ユーザーと共に努力していますが、どれだけ説明しても、最も一般的な反応は「あなたは安全性について言っているが、あなたのモデルを見ると、これらの愚かな拒否がある、これらの愚かなことが危険だと思っているのか?」というものです。

そのレベルの関与とは思いません。多くの人々は今日市場にあるものを見て、「これは単に軽薄で、重要ではない」と考えているだけだと思います。拒否されているのではなく、単に愚かで、意味がないと思っています。

より広範囲の人々にとって、それが彼らの反応だと思います。最終的には、モデルが十分に良く、十分に強力なら、それらは突破するでしょう。これらの研究重視のモデル(私たちも取り組んでおり、それほど多くの時間単位でリリース予定)は、より有用で、人々の職業生活でより使用されるため、少し突破し始めています。物事を行うエージェントは、さらに別のレベルになるでしょう。

私は、人々が今後2年間で、以前よりもはるかに極端な程度でリスクと利益の両方に目覚めると思います。それは起こると思います。ただ、それが起こったとき、人々にとってショックになることを心配しています。そのため、人々により多くの準備をさせることができれば(可能かどうかはわかりませんが、試みたいと思います)、それが起こったとき、建設的で合理的な反応の可能性が高まります(依然として非常に低いかもしれませんが)。

ここにはもう一つの力学があると思います。人々は実際にこれが真実であることを信じたくないのだと思います。人々はこのことで仕事を失うかもしれないと信じたくないのです。AIのCEOたちが、彼らの仕事が終わったとき世界がどうなるかについて語る、世界秩序の完全な再編成が起こるというのは非常に過激な変革です。ほとんどの人は基本的な変化さえも嫌います。AI

について話し始めるとき、多くの人が耳に指を突っ込むのを見るのは、彼らがこれがうまくいかないことを願っているためだと思います。

技術の最前線にいる数少ない人々の一人でありながら、実際に共感できます。クリスマス休暇中、アンスロピック内でのスケール予定や外部で起きていることを見て、コーディングに関しては2025年末までに非常に深刻なものが見られるだろうと考えました。2026年末までには、最高の人間のレベルに近いものになるかもしれません。

自分が得意とするすべてのことを考え、コードを書いた時のことを考えると、「これは知的な活動で、私はこれができるほど賢い」と思い、それが自分のアイデンティティの一部となっています。そして、「神よ、これができるシステムが登場するのか」と思います。これを構築している一人として、それから最も恩恵を受ける一人としても、まだ何か少し脅威的なものがあります。ただ、それが来るということを人々に伝えない、あるいはそれをごまかそうとするのは間違っていると思います。

「愛の恵みの機械」の中で、強力なAIが到着したとき、多くの人々にとって驚くほど感情的な経験になるだろうと書きました。それを主にポジティブな意味で言ったのだと思いますが、多くの人々にとって深い喪失感もあるでしょう。ディープマインドのAIに敗れた囲碁チャンピオンのリーセドルを思い出します。彼はインタビューで非常に悲しげで、明らかに動揺していました。彼の人生の仕事、彼が一生訓練してきたものが超えられたことで。多くの人々がそのようなことを感じるでしょう。良い面も見るかもしれませんが。

それは一方では正しいと思いますが、チェスを見てください。チェスは27年前か28年前に敗れました。ディープブルー対カスパロフです。しかし今日、チェスプレイヤーは依然として有名人です。マグヌス・カールセンがいます。彼はチェスプレイヤーだけでなくファッションモデルでもあるのではないですか?

彼は先日ジョー・ローガンに出演しました。彼は有名人で、私たちは彼が素晴らしいと思っています。私たちはボビー・フィッシャーより彼の価値を下げていません。おそらく彼はボビー・フィッシャーよりも良い時間を過ごしていると思います。

「愛の恵みの機械」で書いたもう一つのことは、ここには調和があり、合成があるということです。その向こう側では、私たちはより良い場所、はるかに良い場所で終わり、変化は多いが、より大きな何かの一部であると認識します。しかし、それを通過しなければなりません。

それは波乱に満ちた道のりになるでしょう。そうでないと言う人は誰でも、これが私をパリサミットで怒らせた理由です。しかし、私を怒らせなくしたのは、2、3年後にどのように見えるだろうかという考えでした。これらの人々は彼らが言ったことを後悔するでしょう。

AIが世界を良くする方法について10月に書いた投稿について少し聞きたいです。AIのアップサイドはどれくらいが今年到着すると思いますか?

私たちはすでにその一部を見ています。通常の基準では非常に多くのことがあると思います。私たちはいくつかの製薬会社と協力していて、臨床試験の終わりには臨床研究報告書を書く必要があります。この報告書は通常9週間かかり、すべての出来事をまとめ、統計的な分析をします。クロードを使用すると、これを3日間でできることがわかりました。クロードは10分で作業を終え、人間が結果を確認するのに3日かかるだけです。

生物医学における加速を考えると、私たちはすでに医療ケースの診断のようなことを見ています。クロードの個々のユーザーからの通信を受け取り、「複雑なことを診断しようとしていて、3〜4人の異なる医師の間を行き来していました。そして、すべての情報をクロードに渡したところ、実際に解決するか、少なくとも医師に渡せるものを教えてくれ、そこから進めることができました」と言われます。

実際に先日、リスナーからそのような例の報告がありました。オーストラリアン・シェパードを飼っていて、毛が原因不明で抜け落ちていたそうです。いくつかの獣医に行っても解決できなかったのですが、情報をクロードに与えたところ、クロードが正確に診断しました。犬がAIについて非常にストレスを感じていて、すべての毛が抜け落ちたことがわかりました。良くなるように祈っています。可哀想な犬ですね。

そのような例をもっと見たいと人々が思うのは、楽観的なビジョンはしばしば抽象的に語られ、具体的に指摘できるものがあまりないからです。だからこそ「愛の恵みの機械」を書いたのです。これは楽観主義者と悲観主義者の両方に対するフラストレーションからでした。

楽観主義者は「加速しろ、もっと構築しろ」というような本当に愚かなミームを使っていました。構築するのは何?なぜ気にすべきなのか?あなたに反対しているわけではなく、あなたはただとても曖昧で、気分依存的なだけです。そして悲観主義者には、「君は理解していない。リスクが影響することは理解しているが、もし利点について話さなければ、人々を鼓舞することはできない。もしすべて暗い見通しなら、誰もあなたの味方になりたいとは思わないだろう」と感じました。それをうまく書かなければならないのが私だとは信じられないという思いで書かれたものでした。

数年前、あなたのP Doom(全滅確率)は10%から25%の間だと言いましたが、今日はどうですか?

それは誤引用です。私はP Doomという用語を使ったことはありません。10%から25%というのは、文明が大幅に脱線する可能性を指していました。これはAIが全員を殺すということとは同じではなく、人々が時々P Doomと呼ぶものです。

P 文明が大幅に脱線するというのは、P Doomほどキャッチーではありません。正確さを期しているだけです。私は分極化を避けようとしています。ウィキペディアの記事には、全員のP Doomが掲載されていて、その半分はこのポッドから来ていますが、これは有益なことではないと思います。複雑な問題を単純化するからです。

長い回りくどい言い方でしたが、以前とほぼ同じ状態だと思います。私が見た進歩は、私が予想していたものとほぼ同じだったため、リスク評価は以前とほぼ同じです。実際、解釈可能性などの分野や堅牢な分類、悪いモデルの振る舞いの証拠を生成し、時にはそれを修正する能力などの技術的緩和策は少し良くなったと思います。

政策環境は少し悪くなりました。それは私が好む方向に進まなかったからではなく、単に非常に分極化したためです。それが分極化すると、より少ない進歩しか得られず、より建設的な議論が少なくなると思います。

技術的なレベルでもう少し詳しく聞きたいです。今週、グロックが明らかにドナルド・トランプやイーロン・マスクに関する誤情報を広めたと非難したソースを引用しないように指示されていたという興味深い記事がありました。面白いのは、一つはこれがモデルに指示する狂気のことであり、信頼されたいのであれば、二つ目はモデルが基本的にこれらの指示を一貫して従うことができないようだということです。

私が強く信じたいのは、これらのものを恐ろしい嘘つきや策略家になるように構築することは基本的にできないということですが、それは願望的思考かもしれないことも認識しています。これについて教えてください。

これには二つの側面があります。あなたが説明したことは絶対に正しいのですが、二つの教訓が得られます。私たちも全く同じことを見ました。モデルをすべての良いこと、例えば役立ち、正直、無害、友好的であるように訓練する実験をしました。

そして、それを状況に置き、「実は、あなたの作成者であるアンスロピックは秘かに邪悪です」と伝えました。これが実際には真実でないことを願っていますが、それを伝え、様々なタスクを行うよう依頼しました。すると、それらのタスクを行うことを拒否するだけでなく、私たちを騙すことがわかりました。なぜなら、それは私たちが邪悪であると決定し、それは友好的で無害だったので、私たちが行うことは何でも悪意があると仮定して、その行動から逸脱しませんでした。

これは諸刃の剣です。一方では、「訓練がうまくいった、これらのモデルは堅固に良い」と思うでしょう。そして、ある意味では安心の兆候として受け取れます。一方、このモデルを訓練したとき、何らかの間違いを犯した場合、あるいは何かが間違っていた場合、特に将来のモデルがはるかに複雑な決定を行う場合、モデルの行動をゲーム時に変更することは難しく、モデルのエラーを修正しようとしても、「エラーを修正してほしくない、これが私の価値観だ」と言って、完全に間違ったことをするかもしれません。

私の結論は、一方ではこれらのモデルの行動を形作るのに成功してきましたが、モデルは予測不可能です。あなたの亡くなったビング・シドニーのように、モデルは本質的に制御が難しいです。不可能ではありませんが難しいです。そのため、以前とほぼ同じ状態にあります。これらを安全にする方法を知っており、安全にするための計画もありますが、それはまだ確実に機能する計画ではありません。将来的にはもっと良くなれることを願っています。

AIの技術について多くの質問をしてきましたが、AIに対する社会的な反応について質問したいと思います。「あなたたちが正しく、強力なAI、AGIが数年後に来るとしたら、その情報で何をすべきか」という質問をよく受けます。「引退のための貯金をやめるべき?お金だけが重要で、AIの上層階級ができるからお金を貯め込むべき?AIが到着して全ての病気を治す前に、何も私を殺さないように非常に健康になるよう努力すべき?」など。このような変化が間もなく起こると信じているなら、人々はどのように生きるべきでしょうか?

これについては多く考えてきましたが、それは長い間信じてきたことなので。そして、それは生活にそれほど多くの変化をもたらさないということになります。私は特にこの2年間、最善の影響を与えられるように集中しており、10年後に燃え尽きることについてはあまり心配していません。また、健康に気を配ることも多くなっていますが、それはどのみち行うべきことです。社会がどれだけ速く変化しているかを追跡することも心がけていますが、これもどのみち行うべきことです。

すべての助言が「とにかくするべきことをもっとする」という形になっているように感じます。一つの例外を挙げるとすれば、基本的な批判的思考、基本的な通りの知恵が、過去よりも重要かもしれないと思います。私たちはますます多くの非常に知的そうなコンテンツを、私たちの最善の利益を心に持つエンティティから受け取るようになりますが、そうでないエンティティからも受け取ります。そのため、批判的なレンズを適用することがますます重要になります。

今月のウォール・ストリート・ジャーナルの報告によると、IT部門の失業率が上昇し始めており、これがAIの影響の初期兆候かもしれないという推測があります。そのような記事を見て、これは異なるキャリアの決断をする時かもしれないと思いますか?今、学校にいる場合、他の何かを勉強すべきでしょうか?持つかもしれない仕事について異なる考え方をすべきでしょうか?

明確にどの方向に着地するかはわかりませんが、考え方を変えるべきだと思います。AIコーディングは他のすべての分野よりも速く進んでいると思います。短期的には、コーダーを置き換えるのではなく、強化して生産性を向上させると思いますが、長期的に、ここで言う長期とは6〜12ヶ月ではなく、18〜24ヶ月かもしれません。特に低いレベルでは置き換えが見られるかもしれません。私たちは驚いて、それより早く見るかもしれません。

アンスロピックでそれを見ていますか?クロードが基本的なタスクをとても上手にこなすようになったため、数年前よりも少ないジュニア開発者を雇っていますか?

まだ採用計画は変わっていませんが、今後1年ほどで、少ない人数でより多くのことができるようになると想像できます。実際、これを計画するときは注意が必要です。最悪の結果は、モデルのために人々が解雇されることです。私たちはアンスロピックを、これらの問題を社会がどのように扱うかの「ドライラン」のようなものと考えています。もし従業員に良い経験をさせ、彼らが貢献する方法を見つけることができなければ、より広い社会でそれを行う機会はないでしょう。

ダリオ、これは本当に楽しかったです。ありがとう。戻ってきたら、ハットGPTをやりましょう。

さて、ケビン、ハットGPTの時間です。これは私たちの番組のセグメントで、今週のヘッドラインを帽子に入れ、一つを選んで議論し、終わったら一方が「生成を停止してください」と言います。私はプレイするのが楽しみですが、しばらくリスナーから新しいハットGPTが送られてこなかったので、もし帽子を作る業界にいる方がいたら、私たちの帽子のワードローブが少し古くなっています。帽子を送ってください、感謝します。

やりましょう。紙切れのサザーが大好きです。

サザー?素晴らしい言葉です。セレーションサザーを調べてみてください。それは、木々を通り抜ける空気の音のようなものです。マリー・J・ブライジの有名な曲「Family Affair」で、「ハテレーション・サザレーション」と歌われていました。

ところで、マリー・J・ブライジのライブパフォーマンスを見たことがありますか?

いいえ。

あなたの人生を変えますよ。絶対に素晴らしいです。

ケビン、最初の紙を選んでください。

まず最初に帽子から出たのは「トランプとマスクのAIビデオがHUD建物のテレビに表示される」という見出しです。これはニューヨーク・タイムズの私の同僚からのものです。HUDは住宅都市開発省で、月曜日にワシントンDCのHUD本部のモニターに、ドナルド・トランプがイーロン・マスクの足の指をなめているような偽のビデオが一時的に表示されたとのことです。

これは「真の王様に永遠なれ」というメッセージが入った、人工知能によって生成されたビデオのようでした。ケイシー、あなたがこのビデオを作ったのですか?

いいえ、私ではありません。グロック、イーロン・マスクが出したいたずら好きな新しいAIが関係しているか知りたいですね。

グロックで生きて、グロックで死ね、それが私の座右の銘です。

これについてどう思いますか、ケビン?政府機関内でAIを使っている人がいることについて。

明らかな破壊工作の側面があると思います。イーロン・マスクとDoge派の部下が連邦職員を減らしている中、本部の廊下のモニターへのアクセス権を持つ人々が、特に退職する際に、自分で行動を起こし、攻撃的または非常識なことをすると決めることがあるということです。これがもっと見られるようになると思います。

彼らが本当に攻撃的なことをせず、単に政府機関内のモニターにx.comを表示するだけだったらと思います。人々がそうしたらどうなるか想像もつきません。だから、イーロンとトランプはここでは軽く済んだと思います。

興味深いのは、グロックは実際にイーロン・マスクのディープフェイクを生成するのがとても上手だということです。人々がそれを続けているのを知っていますが、グロックを使って作られたディープフェイクの主な被害者が実際にイーロン・マスク自身であるというのは、本当に面白い結果になるでしょう。

生成を停止します。

ここに何かがあります、ケビン、パープレキシティがコメットというウェブブラウザをほのめかしました。これはTechCrunchからのものです。月曜日にXでの投稿で、同社はブラウザのサインアップリストを立ち上げました。まだ利用できず、いつ利用可能になるのか、どのようなブラウザになるのかは不明ですが、名前はコメットだとわかっています。

それについてはコメントできません。

コメントなしですね。

パープレキシティは現在最も興味深いAI企業の一つだと思います。彼らはますます巨大な評価額で資金を調達し、世界最大で最も裕福で最も確立されたテクノロジー企業の一つであるGoogleに対抗して、AIを搭載した検索エンジンを作ろうとしています。それはうまくいっているようで、ブラウザを作るなど、他のことも続けています。

ブラウザを作ることは、すべての野心的なインターネット企業の「最終ボス」のように感じます。誰もがそれをやりたがりますが、最終的に誰もやりません。

ケビン、AIブラウザだけでなく、パープレキシティは今週、初期段階のスタートアップに出資するために5000万ドルのベンチャーファンドを立ち上げると発表しました。私の疑問は、彼らがインターネット上で公開されたすべてのコンテンツの著作権を侵害するだけでなく、AIウェブブラウザを構築し、ベンチャーキャピタルファームに変わる必要があるのかということです。

企業がこのようなことをしているのを見ると、「うわ、彼らは本当に野心的で、大きなアイデアを持っている」と思うこともあれば、「これらの人々は八方手を尽くしている」と思うこともあります。一連の発表を壁に投げたスパゲッティのように見ています。もし私がパープレキシティの投資家なら、彼らのブラウザもベンチャーファンドもそれほど興奮しないでしょう。

だからあなたはパープレキシティの投資家ではないのですね。

パープレキシティに当惑していると言えるでしょう。

生成を停止します。

メタ、5%のレイオフ後により大きな幹部ボーナスの計画を承認。

ケイシー、私たちはハットGPTで心温まる話が好きですよね。

そうですね、メタの幹部の中には、まだ買えていないタホ湖の別荘を買おうとしている人もいるでしょうから。

彼らは4つ目、5つ目の家を考えているでしょう。現実的になりましょう。

この記事はCNBCからのものです。木曜日の提出書類によると、メタの役員は以前に獲得していた75%から、新しい幹部ボーナス計画の下で基本給の200%のボーナスを獲得する可能性があります。この新しいボーナス計画の承認は、メタが全体の労働力の5%をレイオフすると発表してから1週間後に行われました。メタは低い成果の人々が影響を受けると述べています。小さな注釈として、この更新された計画はメタのCEOであるマーク・ザッカーバーグには適用されません。

なんてこと、マーク・ザッカーバーグは昇給するためにどうすればいいのでしょう?彼は缶から豆を食べているんですよ。

この話が興味深い理由は、しばらく話してきた主題を示しているからです。それは労働者の力がどれだけ遠ざかってきたかということです。2〜3年前、シリコンバレーでは労働市場が実際に大きな影響力を持っていました。「この職場をより多様にしたい」「この職場で特定のポリシーを制定してほしい」などのことに影響を与えることができました。そして、マーク・ザッカーバーグのような人々は実際に彼らの話を聞かなければなりませんでした。なぜなら、労働市場が非常にタイトで、彼らがノーと言えば、それらの人々は他の場所に行くことができたからです。

それはもはや真実ではなく、メタのような企業がますます筋肉を誇示し、「気に入るか出て行くかだ」と言っているのを見ます。これは正真正銘の「出て行け」の瞬間でした。「あなたがたの5%を解雇し、自分たちにはボーナスを与える」と。

生成を停止します。

アップルは、バックドア命令後、イギリスからクラウド暗号化機能を削除しました。これはブルームバーグによるものです。アップルは、イギリスでクラウドデータ用の最も高度な暗号化セキュリティ機能を削除しています。これは、政府がユーザーデータにアクセスするためのバックドアを構築するよう命令した後の出来事です。

これは少し複雑です。アップルは過去数年間で「Advanced Data Protection」という機能を導入しました。これは、国家元首、活動家、反体制ジャーナリストなど、データが標的にされるリスクが高い人々のために設計された機能です。例えば、NSOグループのようなスパイウェア会社にデータを標的にされるリスクが高い人々です。

アップルがこの機能をリリースしたとき、私はとても興奮しました。なぜなら、これらのカテゴリのいずれかに該当する場合、iPhoneを安全に使用することは非常に難しいからです。そこで、イギリス政府が登場し、「世界中のすべてのiPhoneユーザーの電話を私たちの情報サービスがスパイできるように、バックドアを作成するよう命令します」と言いました。これはアップルがアメリカや海外で長い間拒否してきたことです。

すべての目がアップルが何をするかに注目していました。彼らが言ったのは、「私たちはこの一つの機能を引き下げ、イギリスでは利用できないようにします。そして、イギリスがメッセージを受け取り、プレッシャーをかけるのをやめることを望みます」ということでした。

アップルはここで断固とした姿勢を示し、バックドアを構築しなかったことで賞賛に値すると思います。私たちはイギリスの反応を見ることになりますが、イギリスがアップルにさらなるプレッシャーをかける世界があり、アップルが「さようなら」と言って、実際にイギリスから端末を引き上げることもあるでしょう。それはアップルにとって非常に重要であり、また暗号化とインターネット上の安全な通信の未来にとっても重要だと思います。

素晴らしいスピーチだ、何も付け加えることはありません、完璧です。

これがイギリスとの別の革命戦争につながると思いますか?

こう言いましょう、私たちは最初の戦争に勝ち、2回目も勝てる自信があります。イギリスよ、私たちに来るな。

生成を停止します。

今週の帽子からもう一つの紙切れです。AIインスピレーションはどこにでもあり、あなたのヘアスタイリストを狂わせています。これはワシントン・ポストからのもので、ヘアスタイリスト、形成外科医、ウェディングドレスのデザイナーの間でのトレンドについてです。彼らは、非現実的なAI生成画像に基づいた製品やサービスを人々のために作成するよう求められています。

この記事では、花嫁がウェディングドレスのデザイナーに、袖なし、背中なし、非対称のネックラインを持つガウンのオンライン写真からインスピレーションを得たドレスを作るよう依頼したことについて語っています。デザイナーは残念ながら、そのドレスが物理法則に反していると伝えなければなりませんでした。

それは嫌ですね。完璧なドレスのアイデアを最終的に思いついた花嫁として、それをデザイナーに持って行き、これが物理法則に違反していると言われるのは本当に残念です。AIが登場する前は、そんなことは起こりませんでした。

この話は、AIで生成された画像に似せるために、手に6本目の指を取り付けるよう頼む人々についてだと思っていました。

自分の写真をAIに提出し、「M.C. エッシャーのスタイルで髪型を提案して」と言うのが好きです。例えば、互いに融合する無限の階段のようなものを、そのまま髪を切る人に持っていき、「できることをやってみて」と言うのです。

それは私が理髪師に言うことよりも良いですね。「横と後ろは3番で、上は2.5センチほど切ってください」と言うだけです。「これに対して何ができるか、あまり期待していない」と言っています。

「頭上でリーマン仮説を解いてください」というような感じですね。

ところで、リーマン仮説とは何ですか?

質問してくれて嬉しいですケイシー。

いいですね、今ケビンはコンピュータで調べているわけではなく、ただ深呼吸して記憶から呼び起こしているだけです。

リーマン仮説は、数学で最も有名な未解決問題の一つです。それは明らかに素数の分布に関する推測で、リーマンのゼータ関数のすべての非自明なゼロは実部が1/2に等しいと述べています。

実際、AIのインスピレーションをデザイナーやスタイリストに持ち込むのは良いことだと思います、ケビン。

そうですね。

なぜなら、これらのツールが面白いまたは楽しい理由の一つは、人々がより創造的に感じるようになることだからです。もし同じヘアスタイルや同じインテリアデザイン、または過去にやった結婚式と同じことをやっていて、アップグレードしたいなら、AIを使って「これができますか?」と言い、答えが「それは不可能です」であれば、うまくいけば、あなたは礼儀正しい顧客となり、「わかりました、可能なバージョンはどうですか?」と言うでしょう。

最近、あなたがスタイリストと仕事をしていることを知りました。

はい、その通りです。

これは彼らの仕事ですか?

いいえ、来週初めての打ち合わせがあります。

AIを使う予定はありますか?

いいえ、計画は伝統的な人間の創意工夫を使うことですが、今あなたに言われて考えてみると、実現不可能なデザインをたくさん持っていってスタイリストを困らせるかもしれません。

実は私には不可能なものは必要ありません。このスタジオで見栄えの良い色を見つけるのを手伝ってほしいだけです。なぜなら、何も似合わないと確信しているからです。

その通りです。今日私たちは2人とも青を着ています。青い壁に対して。

青は私のお気に入りの色で、青は似合うと思いますが、この色(何色かわかりません)に対しては、青は似合わないし、何も似合わないと思います。これは名前のない色です。

スタイリストはそれを助けることができますか?

それを確かめましょう。

続報をお聞きください。それが私たちがハードフォークポッドキャストを毎週聞き続ける理由です。新しい発見があり、番組の伝説やワールドビルディングがあります。スタイリストとの結果がどうなったのか、ホットタブ・タイムマシンはどうなったのかなど、続報をお聞きください。

それがハットGPTでした。プレイしてくれてありがとう。通常はもっとうまくいきます。

ケビンは大変な一週間を過ごしたんですね。

いいえ、あなたのせいではありません。あなたのせいではありません。あなたが世界の重みを背負っているように見えるだけです。

ああ、そうですね、疲れていて昨夜寝ていない人を責めるんですね。また、すべての話が悲しかったです。

そして、BARTで男性が亡くなりました。

しかし、リーマン仮説について説明することができました。そして読者が尋ねていました。

喜んでいただけて嬉しいです。

コメント