4,566 文字

ほな、NVIDIAがまた一つ、めっちゃすごいことをやってくれはりました。つまり、単なるGPU製造会社やないっていうことを世界に示したんです。今や、主要なAI研究の最前線におるわけですな。これは最近の研究、GEARと呼ばれるものを指しとるんですけど、GEARいうのは、現実世界で汎用的な実施エージェントを構築するチームのことです。

GEARは「Generalist Embodied Agent Research(汎用実施エージェント研究)」の略で、仮想世界と現実世界の両方で、汎用的な能力を持つエージェントを構築することを目指しとります。

ほな、このGEARチームの目標について説明させていただきます。Dr. Jim FanとYuk Zuo教授が率いるNVIDIAのGEARチームは、仮想世界と物理的な世界における実施エージェントのための基盤モデルの構築を目指しとります。研究の範囲は幅広くて、計画立案や推論のためのLLMのような多モーダル基盤モデル、ビジョン大規模言語モデル、そしてインターネットスケールのデータソースで訓練された世界モデルを含んでます。

それに加えて、複雑な環境での堅牢な移動や器用な操作を可能にする汎用ロボット、ロボットモデル、システムの開発、さらに仮想世界における基盤エージェントと、異なるゲームやシミュレーション間で自律的に探索し、継続的に能力を向上させる大規模行動モデルの研究も行っとります。もちろん、シミュレーションのインフラと合成データの研究も含まれとります。

ほな、最近発表された研究について話をさせていただきます。これがほんまにすごいんです。ただ単に論文のスクリーンショットを見るだけの動画やないですよ。めっちゃすごいシミュレーションをお見せして、なんでこれがロボット工学の未来なんかを説明させていただきます。

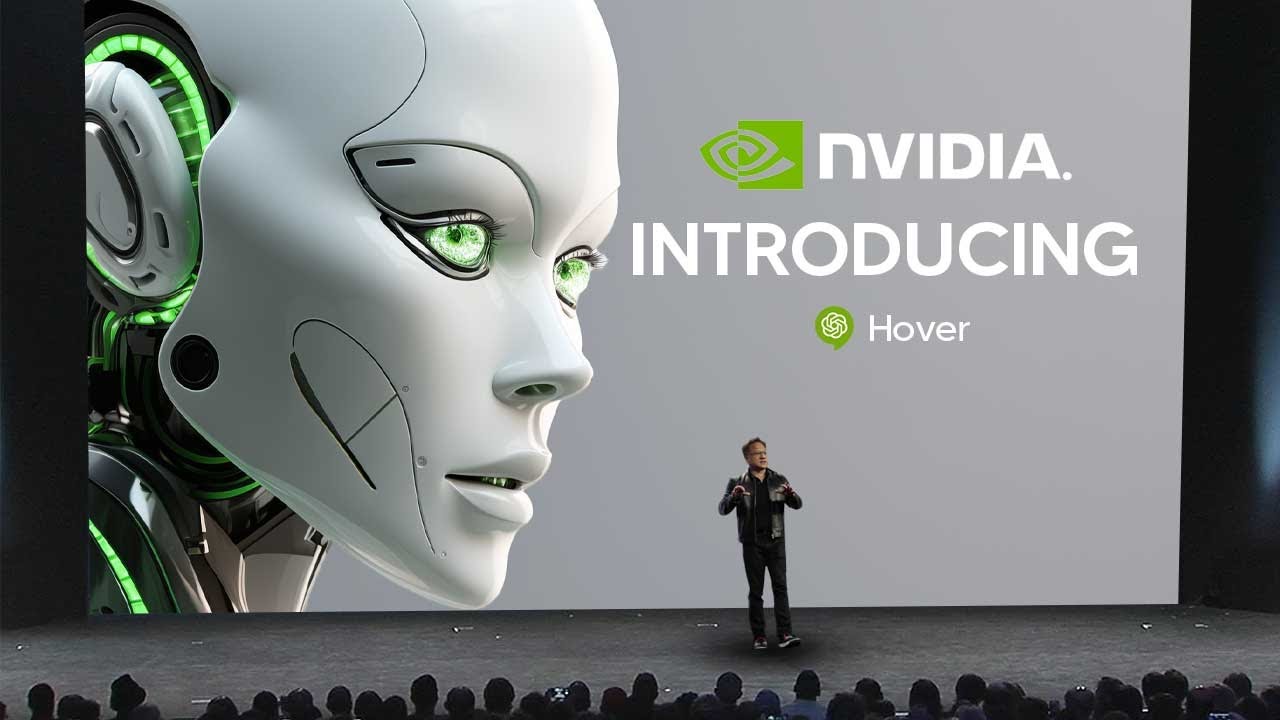

これは「Hover」と呼ばれるもので、正式名称は「Versatile Neural Whole Body Controller for Humanoid Robots(ヒューマノイドロボットのための多用途な神経全身コントローラー)」。簡単に言うと、すべてのロボットの動きを制御する一つの頭脳みたいなもんです。

ロボット工学には大きな問題があるんです。例えば、こんなふうに考えてみてください。優れた音楽家がピアノ、バイオリン、ドラムを演奏する様子を想像してみてください。その人の体は自然に各楽器に適応できますよね。でも、ロボットが同じことをしようとすると、スムーズにできずに、それぞれのタスクごとに頭脳をリブートせなあかんのです。

これが現在のロボット工学の実情なんです。歩行から物を掴む動作、ダンスに切り替えるたびに、まるで一からまったく新しい言語を学ぶようなもんなんです。ここでHoverの出番となるわけです。これは世界初の、ヒューマノイドロボット用の汎用コントローラーなんです。人間の直感のロボット版やと考えてもらえたらええと思います。

これまでは、ロボットは各タスクごとに異なる制御システムが必要でした。歩行用のシステム、物を掴むためのシステム、バランスを保つためのシステムと、まるで動作ごとに脳を切り替えるようなもんやったんです。これは当然、非効率的で扱いにくいシステムです。

このような断片的なアプローチは、ロボットの効率を下げるだけやなく、人間が自然に、考えることなくできる新しい状況への適応能力も制限してしまいます。従来のロボットには三つの大きな課題がありました。まず、転倒せずに歩くためだけに特別なプログラミングが必要で、多くのロボットが転倒したり、支えのロープが必要やったりしました。

次に、手で物を操作するには別のポリシーが必要です。これは人間なら簡単にできることですわ。そして、全身の動きを協調させるためにまた別のシステムが必要なんです。

これがいかにおかしいかというと、まるで車の運転で、ステアリング用、ペダル用、ギア変更用と、三人のドライバーが必要なようなもんです。でも、ここでHoverの出番です。これは人間のように学習する統合システムで、最新のAIとモーションキャプチャー技術を使って、人間の動きを観察し、自然に再現することを学習します。

異なる制御システムを切り替えるんじゃなく、Hoverは人間の脳のように働いて、完璧なバランスと精度を保ちながら、複数の動きを同時に調整します。これにより、より効率的なヒューマノイドロボットが可能になるんです。

人間がコーヒーを持ちながら歩いて会話できるように、Hoverはロボットに異なるアクションをスムーズに組み合わせることを可能にします。NVIDIAでGEARチームを率いるDr. Jim Fanが、この研究がなぜ信じられないほどすごいのかを示す、めっちゃ興味深いことを話してくれはりました。

彼は、すべての基盤モデルが巨大である必要はないと説明し、ヒューマノイドロボットの体を制御するために150万パラメータのニューラルネットワークを訓練したと語っています。人間が歩き、バランスを保ち、腕や脚を望む位置に動かすには、多くの無意識の処理が必要です。

そして、この無意識をHoverに取り入れたんです。これは、ヒューマノイドロボットの移動と操作をサポートするために、動きを調整する方法を学習する単一のモデルです。150万パラメータは少なく感じるかもしれませんが、結果を見たら驚かれると思います。

そして、これがめっちゃすごいのは、処理速度が10,000倍になったということです。NVIDIAのGPUシミュレーションを使うことで、10,000倍速い結果が得られるんです。例えば、ロボットに動きや特定のタスクを教えたい場合、現実世界で丸一年かけて訓練するのは、めっちゃ遅くて高くつきます。

でも、NVIDIAは「Isaac」と呼ばれる特別なコンピューターシミュレーションを使って、マトリックスのような仮想トレーニング環境を作り出したんです。このシミュレーションはめっちゃパワフルで、現実世界では1年かかる訓練を、たった50分で完了できます。つまり、テレビ番組1本見る時間で、マスターシェフになれるようなもんです。

このNVIDIAのシミュレーションは、現実の10,000倍の速さで動作します。つまり、私たちが一歩踏み出す間に、シミュレーション内のロボットはその一歩を10,000回練習できるということです。タイムマシンを持っているようなもんですね。何度も何度も練習して、失敗を重ねて、それを信じられないほど速くできるんです。

そして、これの一番すごいところは、完全にゼロショットやということです。つまり、ロボットが50分(シミュレーション内では1年分)の訓練を終えた後、このニューラルネットは微調整なしで、直接現実世界に転移できるんです。

純粋にシミュレーションで訓練されたロボットを物理的な環境に置いても、すぐに動作します。微調整も修正も必要ありません。これは本当に信じられないことです。微調整なしでゼロショット転移ができるなんて、めっちゃすごいことですわ。

そして、もっとすごいことがあります。これを聞いた時、私も「ほんまに進歩してきたな」と思いました。主任研究者の一人が語ったことですが、このHoverの汎用システムは、特定のモード用に訓練された専門的なポリシーよりも優れた性能を発揮するんです。

多くのことができるHoverが、一つの特定のタスク用に設計されたシステムよりも優れているんです。これは普通に考えたら逆説的です。通常、専門家は汎用家より優れているはずですからね。

研究者たちは、この優れた性能は、異なるモード間で共有される物理的な知識を活用しているからだと考えています。動きながらバランスを保つ方法など、あらゆる動作に適用される基本的な原則を学習しているようです。

ここでグラフを見ると、青で示された専門システムは、必要なポイントすべてに到達できていないか、十分な到達ができていません。一方、緑の領域はより包括的な範囲をカバーしており、これは本当に驚くべき結果です。

ほな、どうやって訓練したんか気になると思います。できるだけ簡単に説明させていただきます。この図は人間らしい動きのデータセットから始まります。左側に見えるのが、再ターゲット化されたモーションデータセットです。

このデータセットは、ロボットが学習すべき動作の完全なコレクションで、歩行、腕の動き、バランスなどが含まれています。次に、オラクルポリシーがあります。これは教師や専門家モデルのようなもので、多くのデータで訓練され、ロボットがどう動くべきかについての深い理解を持っています。

このポリシーは複雑で、まだロボットでの直接使用には適していません。次に、固有受容と命令マスキングがあります。システムが学習を助けるために、動きをより単純なタスクに分解するんです。

これには二つの方法があります。モードマスクは、学習者が集中すべき腕や脚の動きなど、特定の動作を決定します。そして、スパースマスクは、各動作の重要な部分だけを選択して、学習プロセスをより単純で扱いやすいものにします。

そして、監督付き学習があります。学習者はオラクルポリシーの動作をできるだけ正確にコピーしようとします。このコピーまたは監督付き学習により、学習者は動作が専門家と一致しないときにフィードバックを受け取ります。時間とともに、学習者は専門家のような動きができるようになります。

これらすべてが完了すると、Hoverポリシーがオラクルポリシーから十分に学習を終えた後、さらなる調整なしで、これらの学んだスキルを現実世界で使用できます。これが可能なのは、実際のロボットの動きに変換できる方法で訓練されているからです。

簡単に言うと、この図は専門家モデルがHoverポリシーに学習させ、それを実際のロボットに転移する方法を示しているんです。この画像は、ヒューマノイドロボット用の多用途な制御システムであるHoverの動作の仕組みを示しています。

ロボットが様々な制御デバイスからの異なるタイプの動作命令を処理できるようにします。上部では、システムがVRヘッドセット、カメラ、外骨格、ロボットアーム、さらにはジョイスティックなど、様々なデバイスから入力を受け取れることが分かります。

これらのデバイスは、頭、手、全身など、ロボットが実行すべき異なるタイプの動きに関する情報を送ります。そして、中央の行で見られるように、異なる体の部分からの異なるモードの追跡を開始します。

運動学的位置追跡では、体の各部分がどの位置にあるべきかに焦点を当てます。黄色で示されているローカルな関節角度追跡では、肘や膝などの関節の正確な角度を制御します。そして、ルート追跡では、全体的なバランスやトルソの動きなど、体の中心的な動きを管理します。

詳細には立ち入りませんが、簡単に言うと、この全体のセットアップにより、Hoverは複数のソースからコマンドを受け取り、ロボットのどの部分を動かすかを判断し、制御された協調的な方法でそれらの動きを実行できるんです。

コメント