35,085 文字

おおきに、みなさん。10月10日木曜日のThursdAIにようこそ。私はWeights and Biasesのアレックス・ウォブと申します。ここにおる観客の中に見えますわ。四角いプロフィール写真を探してください。Weights and Biasesのロゴが入ってます。そのロゴ、めっちゃ好きなんですわ。フォローしてもらえたら嬉しいです。

みなさん、10月10日木曜日のThursdAIへようこそ。共同ホストの友人、ウォルフラムニストンとヤムも一緒です。どないですか、みんな?

ウォルフラム、調子はどうや?

ああ、比較的静かな一週間やったけど、それはええ変化やね。でも、まだまだ話すことはようけあるわ。最近は狂ったような週が続いとったからな。それに比べたら、確かに静かな週やったわ。

TLDRを書き始めたんやけど、ここでいつものようにリンカーンに感謝せなアカンわ。みんな見てるかな? あのちっこいグルートのアバターがおるやろ? リンカーンってニックネームやねんけど、素晴らしいコミュニティメンバーで、手伝ってくれとるんや。リンカーンがおらんかったら、今週は完全に迷子になってたわ。

何について話せるかなって考え始めたら、結構あるもんやね。最新ニュースもあるし。大手ラボからのんはないけど、メタからのビデオとか、オープンソースのLLMの話題もあるわ。

そういえば、ヤム・ペルにも挨拶しとらんかったな。ヤム、今週はどないや? 面白いことあった?

ああ、どないやねん。歴史的な週やったわ。もう話したかもしれんけど、1週間でAIに2つものノーベル賞やで? 歴史的なWやで、マジで。

そうそう、AIのカテゴリーすらないのにな。AIのカテゴリーはないのに、徐々に浸透してきとるんや。将来はこれが始まりに過ぎんって感じやな。あらゆる分野でAIがどんどん増えていくんや。これは始まりに過ぎへんわ。

2つのノーベル賞が基本的にAIソリューション、ディープラーニングソリューションって言えるものに与えられたんは、時間の問題やったんやろうな。広く普及するのも時間の問題やと思うわ。歴史的な週やで。

お前のツイート、めっちゃ好きやったわ。スペースの一番上に追加しとくわ。「物理学と化学から始まって、次は医学、文学、経済学や」ってやつ。ええな。

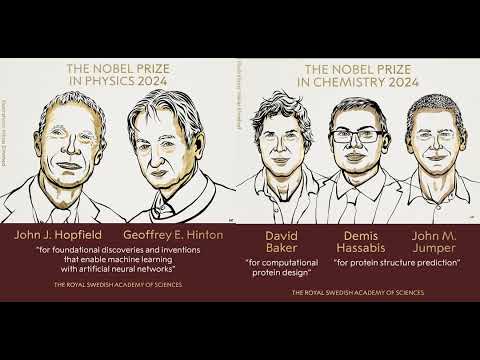

せやから、これについて簡単に話そうか。AIについてあんまり詳しくない人のために。今週、ノーベル委員会が発表したんや。まず、ジェフリー・ヒントンとジョン・ホップフィールドが物理学賞を受賞したんや。具体的にはニューラルネットワークの研究でな。

ヒントンとホップフィールドが分野に与えた影響は疑う余地がないわ。そこは間違いない。でも、ちょっと驚いたんは、彼らの研究が物理学に関係してるってところやな。エネルギーベースモデルとかはあるけど、一部の人は驚いたんちゃうかな。そう言うてもええと思うわ。でも、ノーベル賞に値することは間違いないと私は思うで。影響力はめちゃくちゃ大きいからな。

もっと驚いたんは、これは全然驚かへんかったけど、完全に値するのは、GoogleのAIチームのAlphafoldが化学賞を取ったことやな。分野を革命的に変えたからな。

AIから3人が受賞したんや。デミス・ハサビス、ジョン・ジャンパー、デイビッド・ベイカーの3人がAlphaFold 2を引用されて化学賞を受賞したんや。でも、注意せなアカンのは、ノーベル賞は全著者を追加できへんねん。3人だけ選ばれたのは、特定の人を選んだわけやないんや。そういう仕組みなんや。他の著者の功績を認めへんわけやないってことは言うとかなアカンな。チームには多くの著者がおるからな。でも、まあ、革命的な仕事やったわ。間違いなく素晴らしいで。

そやな、100%そう思うわ。

ほとんどの人が見逃したTWがあるんやけど、面白いツイートしたんや。最初のAlphafoldの数日前に、私のチームと論文で発表してたんや。当時は最初の基盤タンパク質モデルやったんやけどな。AlphaFoldに数日遅れただけでノーベル賞を逃したってツイートしたんや。もちろん冗談やで。マジに受け取らんといてな。

でも、興味あるなら、論文見てみてや。ほぼ最初の基盤タンパク質モデルやで。私と他の人らの名前が載っとるわ。今はちょっと古くなっとるけどな。

次はもっと早う考えなアカンな。絶対に。

そうやな、加速せなアカンわ。でも、まあ、ノーベル賞の話はこんなもんやな。歴史的な週やったわ。見られてよかったわ。

ちなみに、ジェフリー・ヒントンの話やけど、現代AIの祖父って呼ばれとる人やな。イリヤ・サツキーの先生やったと思うわ。面白いことに、Googleでジェフ・ディーンのインターンもしてたんや。ヒントンがGoogleで働いとった時期があって、誰もどんな肩書きをつけたらええかわからんくて、インターンの肩書きになったんや。

で、ジェフ・ディーンが言うてたんやけど、チューリング賞とノーベル賞の両方を取った最初のインターンやって。唯一やないけど、最初のインターンやで。

ヒントンがインタビューで言うとったんやけど、こんなこと言うてたわ。「私の教え子の一人がサム・オルトマンをOpenAIから追い出したことを特に誇りに思っとる。OpenAIは安全性を主な目的として設立されたんや。人工知能を開発して、それが安全であることを確認するのが目的やった。私の元教え子のイリヤ・サツキーが主任研究員やったんやけど、時間が経つにつれて、サム・オルトマンが安全性よりも利益を重視するようになったんや。それは残念やと思うわ」

これがヒントンの言葉や。ヒントンは安全性について心配しとることで知られとるな。最近Twitterにも参加したけど、まだ炎上投稿は見てないわ。

面白いのは、ノーベル賞を受賞したプラットフォームで、こういう意見を共有することを選んだことやな。また、ノーベル賞の電話がかかってきた時、その電話を信用せんかったってのも面白いわ。誰かが突然電話してきて「ノーベル賞取ったで」って言うても、そう簡単には信じられへんよな。みんなもそうすべきや。

さて、皆さん、ええスタートができたと思うわ。AIで2つのノーベル賞、確かに歴史的な週やった。でも他にもようけ起こったんや。ざっと見ていって、それからオープンソースの話に移るわ。

オープンソースでは、LLMの事前学習用の超高品質な重複排除データセットが公開されたんや。TXT 360って言うんやけど、Common Crawlとか他のデータセットを集めて、重複を排除して一つにまとめたんや。14〜15兆以上のトークンのコーパスができて、C4 webよりもパフォーマンスがええんや。すごいやろ。

それから、RhymeのARAっていう新しいVMMマルチモーダルMoEモデルも出たわ。250億パラメータのマルチモーダルモデルで、Apache 2ライセンスで公開されとる。これも絶対に取り上げるわ。PikstrとかPiX-TroLとも比較しとるしな。PiX-TroLの論文も今週出たばっかりやし。

それから、Matrixっていう会社が新しい分散型アリーナを立ち上げて、新しいリーダーボードも公開したんや。このリーダーボードが面白いんで、それについても話すわ。分散型の部分についてはあんまり時間なくて見れてないんやけど、ステージにおる人とか観客の皆さんで、Matrixと分散型アリーナについて詳しい人おったら、コメントしてくれたらありがたいわ。

オープンソースでは、Gradio 5がサーバーサイドレンダリングに対応して公開されたんや。みんなHugging Faceを通してGradioを使っとるよな。Gradioのリリースのたびに、ほぼ毎回Gradioの人らと話しとるわ。今回は来れるかわからんけど、Gradio 5はめっちゃええ感じやで。

それから大手企業とAPIの話に移るわ。新しいReca Flashが公開されたんや。ReaのEとMaximと話したの覚えとる? 新しいのを公開したんや。Reaは今でも動画を理解するモデルの中で最高やと思うわ。音声も理解するからな。音声は動画の重要な部分やと思うんや。だから、彼らの210億パラメータのモデルについて話すわ。オープンソースやないみたいやけどな。

それから、Inflectionはまだ生きとるみたいやで。何か公開したんや。企業向けに行くってブログを書いとるわ。これについても少し話そう。Inflectionが大きな約束をしてたの覚えとるやろ? それでMicrosoftにほとんどの人が行ってGEDみたいになったんやけど、まだAIは続けとるみたいやな。

それから、先週のサービスのミスについても話さなアカンな。Canvasが公開された時、ショーの最後やったんや。「速報」ボタンを押して、基本的に「OpenAIのCanvasはAnthropicのアーティファクトへの答えや」って言うたんやけど、それは間違いやった。全然違うんや。ほとんど完全に違うんや。だからこの間違いを訂正して、Canvasについて話したいんや。結構すごいからな。

今週の話題では、AIに関連する面白いことがあったんや。同僚とカーソルのコツについて話してたんやけど、それが爆発的に広まってしもうて。全然予想してなかったわ。ここXで会議の要約を投稿しただけやのに、25万回以上見られとるんや。何かシグナルがあるんやろうな。ThursdAIの皆さんとも少し共有しようと思うわ。多くのリスナーがエンジニアで、カーソルを使っとるからな。

それからWeights and Biasesでは、同僚のスウィクがテキストから画像生成モデルの包括的なベンチマークを行うためのHEMライブラリをリリースしたんや。テキストから画像への新しい評価指標を公開して、Weaveで動くリーダーボードも公開したんや。めっちゃクールやで。誰か参加できる人おらへんかな。HEMは我々のもので、完全にオープンソースやで。

それから動画とビジョンのカテゴリーでは、今週はめちゃくちゃやったわ。MetaがMovie Genを発表したんや。画像生成モデルやないで。画像と文章から動画を生成するモデルなんや。発表だけで、まだリリースはしてへんけど。いつリリースするかはわからん。でも論文は公開されとる。パーソナライゼーションも可能やし。AIビデオが来るって何年も言われとったけど、Metaが「ああ、わかっとるで。これ作るわ」って言うたみたいなもんや。

顔を入れたら、その顔で動画を生成する機能もあるんや。音声も生成するし。めっちゃクールな話になりそうやわ。すごそうやけどな。

リリースはされてへんけど、今週リリースされたのはPyramid Flowや。オープンソースの画像から動画生成モデルで、MITライセンスで公開されとる。768pの解像度で24fpsの動画を生成できるんや。めっちゃすごいで。今すぐダウンロードできるわ。めっちゃ新しいから、まだどこにもホストされてへんけど、このチャットが終わる頃には誰かがPyramid Flowをホストしとると思うわ。これについても話すわ。論文とブログも公開されとるしな。

Pyramid Flowの人ら、新しいオープンソースの画像から動画生成モデル、すごいわ。これでビジョンと動画カテゴリーは以上や思うわ。

音声とオーディオの分野でも盛り上がっとるんや。先週、OpenAIがリアルタイムAPIを公開したやろ。高度な音声モードへのAPIアクセスや。今週はそれを使い始めて遊んでみたんや。他の人らも使ってみたみたいやし。QuindとかリアルタイムAPIを使った人らと話してみるつもりや。

私もなんか作っとるんや。ハロウィンプロジェクトの話したやろ? リアルタイムAPIを組み込もうとしてて、昨日やっと成功したんや。めっちゃ高いし、フィードバックもようけあるんやけど、すごくクールやわ。

それから、CIAの人らも覚えとるやろ? CIAはElevenLabsのライバルみたいな感じや。めちゃくちゃ速くて、品質も高いってんで、ショーに呼んだことあるやろ。彼らもマルチモーダル、多言語対応になったんや。私も使っとるわ。CIAにも感謝やな。

これで今日話すことはほぼ全部やと思うわ。オープンソースから始めるけど、その前に何か大事なこと見逃してへんか、皆さん? Wolfram、Nistはどうや?

ウォルフラム: 一つ興奮することがあるんやけど、多くの人には関係ないかもしれん。ヨーロッパ、特にドイツでは、Meta Llama 3.1 45bを手に入れるのが難しかったんや。でも今、ドイツにプロバイダーができて、これを提供してくれるようになったんや。つまり、GDPRに準拠して使えるってことや。ドイツ人や、アメリカのプロバイダーを使えない人にとっては大きなことやな。私にとってはめっちゃ興奮することやったわ。

アレックス: そのツイートピン留めしたわ。君のツイート見て、これも言及しようと思っとったんや。ヨーロッパのリスナーにとっては、これはすごいニュースやな。Wolfram、君は会ったことあるんやろ? Inventの人らに。ヨーロッパのリスナーの皆さん、これは朗報やで。最近の新しいものがヨーロッパに来にくいってのは、ずっと気づいとったからな。ヨーロッパでもこういうことが起こり始めてるのは素晴らしいわ。

ウォルフラム: 今や俺らは第三世界やな。

アレックス: よし、オープンソースから始めよう。オープンソースAI、始めるで!

TXT 360について、Nistとヤムとも話したいわ。特にオープンソースモデルの世界では、公開されてるデータしか使えへんのがデメリットやからな。大手ラボみたいにデータにお金払う余裕もないし。新しいデータセットについてはあんまり話題にならへんけど、オープンソースLLMの分野では少なくとも言及すべきやと思うんや。

TXT 360は本当に膨大な作業をしたんや。Alignment Labの友人も言うとったけど、高品質な作業がようけあるんや。LLMの事前学習用に15兆以上のトークンのコーパスを公開したんや。Nist、これについて何か言いたいことあるか? こういう取り組みの重要性について話してくれへんか? オープンソースの世界では、こういうのが必要なんや。大手ラボみたいにお金がないからな。LlamaはたしEEK15兆で学習したんやったっけ。これもかなりの量のテキストやけど、問題はこれらのソース間で重複排除されてるってことやな。Nist、この話題を取り上げてくれへんか?

Nist: ヴィクター・ミラーとヘクター・レオが来週のショーに来てくれるかもしれんわ。でも、重複排除がなんで大事かは簡単に説明できるわ。モデルを学習させる時、特に事前学習の時に、同じ内容を繰り返すのはめっちゃ悪いんや。モデルの知能にとって悪影響があるんや。物事の関係性を一般化してほしいのに、単に2、3回繰り返されたから重要やと思わせてまうんや。だから、この重複排除のステップをしないと、モデルの知能を本当に傷つけてしまうんや。

それに、これだけのデータを扱うのに必要なDevOpsの量も半端ないで。テンソルが何百テラバイトものRAMが必要やと思う。正確には計算してへんけど、たぶん100テラバイト以上やな。この作業をするのに必要なDevOpsと運用の量は、適切なチームがいないとスケールアップするのがめちゃくちゃ大変なんや。

だから、これのおかげで、誰でも事前学習を簡単にできるようになるんや。モデルの精度が下がることを心配せんでもええようになる。単なるデータのリリースに見えるかもしれんけど、他のモデルの学習を容易にする大きな一歩なんや。

ヤム: それ以上のものやで。重複排除だけやない。オープンで簡単にアクセスできるデータソースもあるんやけど、重いインフラがないと、あるいは時間と労力をかけてデータを取得して処理せんと、簡単にはアクセスできへんのや。

例えば、研究論文とかな。オープンやし、arXivにもあるんやけど、それを取得して、テキストに変換して、きれいにせなアカンのや。PDFはめちゃくちゃやし、形式もバラバラやからな。誰かがこの前処理の作業をするのは、めっちゃ価値があるんや。

これが、小さなチームが自分でやろうと思っても止まってしまう原因になるんや。予算がないとかじゃなくて、そもそもデータをどう取得したらええかわからへんのや。誰かに手伝ってもらおうと思っても、どこで見つければええかもわからへん。

誰かが価値のあるソースに対してこの作業をして、全部Hugging Faceに置いてくれるのは、めちゃくちゃ価値があるんや。そこにリンクして、すぐに学習を始められるからな。

これが、Hugging Face自身のC4 webがそんなに価値があるもう一つの理由なんや。Common Crawlに自分でアクセスできへんからやなくて、全ての前処理と、学習に適した形にするのが大変な作業やからなんや。誰かがそれをして、そのまま共有してくれるのは、全部オープンやのに、めっちゃ価値があるんや。

アレックス: LLM 360の人らに感謝やな。これをオープンソースにしてくれて。ヤム、論文の話したけど、論文は実際にトークン数と生データサイズで2番目に大きいソースやと思うわ。Common Crawlが一番大きくて、10テラバイト近くで4兆トークンのCommon Crawlがあるんや。カットオフ日も更新されてて、2024年までや。論文が2番目で、1540億トークンの論文があって、2023年のQ4まで更新されとる。去年までやな。Wikipediaは200GBのWikipediaデータがあるんや。

基本的に全部入っとるんや。LLMの話をする時、基本的にインターネット全体のことを話しとるんやな。これがそうなんや。このチームに大きな感謝を送りたいわ。オープンソースのLLMを作っとる人とか、興味ある人にとっては、これはめちゃくちゃすごいニュースやで。

他に何かある? ああ、そうや。彼らも言うとるんやけど、誰かがこのアプローチを取る度に指摘しとるんやけどな。「私たちの360度オープンソースの精神に沿って、全ての詳細なステップ、決定の理由、詳細な統計情報をブログに記録しとります」って。LLM 360の人らに感謝やな。この素晴らしい取り組みに。これから、まずはオープンソースのラボから、みんなが恩恵を受けることになるやろうな。

彼らが言うには、これが初めての異なるデータソース間で重複排除されたデータセットやって。今までは異なるデータソースを使わなあかんかったけど、今は重複排除された一つのデータセットになっとるんや。めっちゃクールやな。

次はこの新しいやつや。RhymesのARAや。これ、新しくて、まだテストしてへんのやけど。非オープンソースの別のマルチモーダルビジョンモデルと比較して話すつもりやけど、これは本当に今日リリースされたばっかりなんや。250億パラメータのマルチモーダルMoEモデルで、画像と動画の入力を理解して、Apache 2ライセンスで公開されとるんや。

VMMについてはよく話すし、ビジョン対応モデルについてもよく話すな。今や、マルチモーダルモデルを持ってないと、なんで持ってへんのかを説明せなアカンくらいや。Llamaでさえマルチモーダルになっとるからな。

これは6兆の言語トークンと4000億のマルチモーダルトークンで学習されとるんや。ハイライトは、Apache 2ライセンスで動画も理解できることやな。いくつかの統計を見てみよう。MMUっていうマルチモーダルの知識と数学タスクでPixol-VQAを超えとるって主張しとるんや。GPT-4 Visionにかなり近づいとる。みんなGPT-4 Visionと比較するけどな。でも、それ以降進歩しとるんや。例えば、GPT-4はこのタスクで69%やけど、これはLlama 3 11Bパラメータを超えとるんや。かなりクールやな。

彼らが特に強調しとるのは、複数のソースのネイティブなマルチモーダル理解を持っとることや。複数の画像を扱えるんや。それに、3.9Bのアクティブパラメータを持つMoEであることを強調しとるな。これもめちゃくちゃクールや。

他に何か面白いことある? Apache 2ライセンスは素晴らしいな。64,000トークンのコンテキストウィンドウがあって、256フレームの動画を10秒でキャプション付けできるんや。オープンソースの動画モデル、大好きやわ。Nist、何か反応ある?

Nist: やあアレックス、みんなこんにちは。実は彼らのチームの何人かを知っとってな。彼らと話してたんやけど、来週のショーに来たいって言うとったわ。今日はサンフランシスコでAMDのイベントに参加しとるからな。

実はAMDと協力しとるんや。AMDが新しいグラフィックカードを出すらしくて、H100より1.5倍速いんやって。驚いたわ。

基本的に、このARAプロジェクト全体は新しいチームが主導しとるんや。リーダーはBLIPの作者なんや。「これならできる」って感じで、新しいアプローチでやったんや。すごく賢いチームで、めっちゃ尊敬しとるわ。みんなに試してほしいな。モデルはかなり良くできとるで。

アレックス: Hugging Faceの人らからも聞いたけど、このチームはめちゃくちゃ優秀らしいな。彼らの仕事は信じられへんくらいすごいって。言語の事前学習があって、それからマルチモーダルの事前学習があって、それからマルチモーダルの長文脈学習もあるんや。これは別のステップなんや。それから200億のテキストとマルチモーダルのポスト学習もある。新しいアプローチを取っとるみたいやな。最後に20億トークンの高品質データで学習しとる。

ここで強調したいのは、このモデルがコーディング能力も持っとるってことや。これについて何か言いたいことある? Hugging Faceの誰かが、Mがこのモデルを最初に紹介してたな。コーディング能力がかなりクールらしいで。コードの画像を貼り付けて、それに対する応答を見ることもできるんや。普通はテキストを貼り付けるけど、コードの画像を貼り付けるんや。

Nist: すまん、エコーがかかっとるわ。基本的に、彼らのチームの考えは、1つのモデルを学習させて、それをマルチモーダルモデルにするんやけど、言語のみのタスクでもかなり高いパフォーマンスを維持できるってことなんや。これはかなり大胆な試みやな。多くのマルチモーダルモデルでは、マルチモーダルの工夫をすると、inevitablyにMMPLや他の言語のみのタスクでのポイントが下がってしまうんや。だから彼らは「マルチモーダルネイティブ」って呼んどるんやと思う。この概念にも驚いたわ。このショーの後で、このモデルに対して詳細なテストをしてみるつもりや。でも、すごいことやで。

アレックス: そうやな。チームに感謝やな。皆さん、これを試してみたい人は、rhymes.aiでチャットが動いとるで。特に好きなのは、高解像度の画像を入力できて、コードも出力できるところや。彼らのブログでは、コンテキストウィンドウが長いことと、複数の画像を渡して全部に対して処理できることを強調しとるな。

例えば、「これら5つの画像の種に基づいて、食物連鎖を描いて、各種の役割を説明してください」っていうプロンプトがあるんや。草と、マウスと、バッタと、タカの画像があって、基本的にそれらすべての画像を取り込んで、それらの間の食物連鎖を描くんや。かなりクールやな。

Yam、Nist、Wolfram、何かコメントある? このARAについて見た?一般的にオープンソースの性質を称賛しとるけど。

Nist: たぶん、単一の消費者向けGPUで実行できて、しかも高速に動く最高のビジョンモデルやと思うわ。MoEやから、CPUでも高速に動くと思うわ。アクティブパラメータ数を忘れたけど、3点何かやったな。

アレックス: 6やと思ってたわ。

Nist: そうか。とにかく、実行するのはかなり速いはずや。Qwen 72Bよりは良くないかもしれんけど、それもかなり遅いし、そんなに大きな差はないと思う。このチームが一から作ったってのがすごいな。これは完全に新しいモデルで、他のものをベースにしてるようには見えへん。このチームの大きな成果やな。

アレックス: そうやな。トークンあたり3.9億のアクティブパラメータって言っとるな。他には64,000トークンのコンテキストウィンドウと、Apache 2ライセンスで、コードと技術レポートも付いとる。めっちゃクールやな。このチームに感謝やで。

Nist: おお、それはすごいな。3.9なら、CPUでの推論も可能になるな。たぶん少なくとも1秒あたり10トークンは出せるやろ。これはかなりええな。

アレックス: そうやな。これはかなり興奮するな。皆さん、これは来週にはRaspberry Pi Zeroでも動かせるってことやで。

さて、オープンソースで最後に話すことがあるな。ARAチームに再度感謝やな。めっちゃ新しいリリースで、MoEってのも興味深いな。マルチモーダルでMoEってあんまり見たことないからな。

次は、LLM 360からの新しい分散型のやつや。ブログ見てみよう。「集合的LLMインテリジェンスによる分散型アリーナ」やって。基本的に、Chatbot Arenaがやってることを、分散型のLLMの群衆の知恵でやろうとしとるんや。Chatbot Arenaの全体ランキングと95%の相関があるって言っとるな。これはすごいで。

Chatbot Arenaについてはよく話してきたし、どんな人が参加してるかとか、モデルに対する内部的な感覚とArenaが示す結果の間にある程度の乖離があるとかいう問題についても話してきたな。

このリーダーボードで注目すべきなのは、実際のリーダーボードを見てみようか。LLM 360とMatrix.orgが協力して作ったんや。現在のリーダーボードでは、OpenAIが絶対的な首位を占めとるな。上位6モデルは全部OpenAIのモデルで、7位にClaude 3.5 Sonnetが来とる。その後もちょっとOpenAIが続いて、9位にGeminiが来て、10位にQwen 72B Instructが来とるな。

オープンウェイトのモデルでは唯一10位に入っとるんや。Claude 3 Opus、Llama 3.1 70B Instructを超えとる。このアリーナは全体、数学的推論、科学、コーディングで分けられとるな。コーディングを見てみよう。

そうやな、コーディングのPythonとかJavaを見ると、GPT-4 Latestが3.5 Sonnetを超えとるって出とるな。これは多くの人の経験とは違うかもしれんけど、まあ、偏りがあるかもしれんな。Nist、これについてどう思う? これは別の試みやけど。

Nist: みんなに言いたいんやけど、モデルがこのレベルで本当に良くなってくると、どのモデルが他より優れてるかを測るのはめっちゃ難しいんや。でも、感覚はあるんや。

観客の誰かが、特定のタスクで、あるモデルが他のモデルより明らかに優れてるのを見つけたら、それを示したり説明したりするのが難しくても、ここのTwitterで教えてくれ。みんなに知らせてくれ。特定のことで、このモデルがあのモデルより優れてるって具体的に指摘できるものがあれば、それは誰にとっても役立つんや。特にオープンモデルにとってはな。全ての穴を埋めたいからな。

このレベルで測るのは本当に難しいんや。一つのリーダーボードではOpenAIがリードしてるのに、他の人のコメントを見ると、他のタスクではClaudeの方が好きだって言う人もおるしな。モデルがこれほど優秀になると、本当に難しいんや。

アレックス: そうやな、ここで思い出すのは、Sam Altmanの話や。先週話したと思うけど、Sam AltmanがDev Dayで観客に聞いたんや。「自分がGPT-4より賢いと思う人?」って。ほとんど誰も手を挙げへんかったんや。それで「GPT-5でもそう思う?」って聞いたら、誰も手を挙げへんかった。

彼の返事は「我々もそう思ってる。でも、我々はこれらのモデルをどう学習させ、どうやってより安全で使いやすくするかを考える立場にあるんや。でも、これらのモデルが前のバージョンよりも優れてるかどうかを評価するのも我々の仕事や。我々のうち誰が賢いかもほとんどわからへんのにな」って。

OpenAIの最近のアップデートでも、こんなこと言うとったな。「アップグレードしたモデルをリリースしたけど、どこが大幅に改善されたかは言えへん。皆さんに教えてもらわなあかんのや」って。最新のGPTモデルのリリースでもこんな感じやったな。

我々の評価方法が、新しいモデル間の違いを理解するのに全然追いついてへんっていう興味深い状況になってきとるな。Nist、コメントあるか?

Nist: ちょっと新しい噂を紹介するわ。Lex Friedmanがカーソルの人らと話した内容によると、Sonnet全体が劣化してるんやないかって思われとるんや。他の噂や推測では、AWSの新しいチップ、InferentiaやTrainiumで動かしてたから、行列積算に問題があったんやないか、あるいはハードウェアレベルで何か誤差が入ってたんやないかって。

これは以前にもあったことやな。LlamaCPPとCUDA実装を比較すると、CPUで動かした時に1〜2%の違いが出ることがあるんや。だから、別の推測では、まだ成熟してない新しいチップで動かしてて、その問題がまだ修正されてなかったから、パフォーマンスが落ちたんやないかって。

面白いよな。これらのベンチマークは本当に競争が激しくて、1〜2%の違いしかないんや。でも、異なる推論モードや異なるハードウェアで1〜2%の違いが出ることがあるから、比較するのがさらに難しくなるんや。

アレックス: そうやな。他の人らの取り組みにも感謝せなあかんな。例えば、Simple Benchってのがあるやろ。あそこのリーダーボードを見ると、人間の回答が92%で、他のモデルは30%までしか到達してへんのや。

新しい評価方法が必要やし、他の方法も必要やな。だからこの分散型アリーナも素晴らしい試みやと思うわ。毎週話してるように、本当に難しくなってきとるからな。

OpenAIも先週、新しいアプローチを発表したと思うわ。Simonが言うてたか。OpenAIに評価方法を提供したら、見返りに何か無料のものがもらえるとかいう話やったな。みんな評価方法をクラウドソーシングしようとしとるんや。これは素晴らしいことやと思う。

オープンソースについては以上やな。Nist、Justine TunnyのLilleの話があったな。Lilleにチャット機能ができたって。お前も関わっとったんやろ? これについて少し話してくれへんか? Justineのオープンソースへの貢献は称賛に値するし、お前も関わっとったから言及したかったんや。

Nist: そうやな。Hugging Faceで”llama.cpp”って検索したら、今はめっちゃええチャットインターフェースがあるんや。以前は、サーバーを立ち上げて、APIを通してチャットするだけやったんやけどな。

アレックス: インターフェースはあったけど、そんなにええもんやなかったんやな。

Nist: そう、今はコマンドラインのチャットアプリみたいな感じで、見た目もええんや。私みたいに、いろんなサーバーで作業せなあかん人にとっては、SSHするたびにCursorやVS Codeをセットアップできへんからな。コマンドラインしかないし、会社のサーバーによってはコピペもできへんこともあるんや。

でも、llama.cppなら、一つのファイルを取ってきて実行するだけで、突然アシスタントができるんや。私はQwen Coder 7Bでやっとるけど、すぐにアシスタントができて、何でも入力できるんや。しかもネットワークに接続せんでもええしな。見た目もええし。

これで、コマンドラインからこれらのモデルを使うのがずっと楽になったんや。

アレックス: llama.cppはすごいな。1行で、1ファイルの実行ファイルで、GPUがあるかどうかに関係なく、どんなシステムでも極端なパフォーマンスで動くんや。TunnyはLlama.cppに何度も貢献してるし、パフォーマンスもめちゃくちゃいいな。

見たスレッドでは、そのチャットの構文ハイライトについても話しとったな。お前が何か始めて、Justineがその日のうちに完成させたんやろ?

Nist: そうそう。依存関係なし、インポートなしで構文ハイライトの実装を始めたんや。そしたらその日のうちに完成してもうた。めっちゃ凄かったわ。

アレックス: Justine Tunnyに感謝やな。llama.cppにも感謝や。皆さん、依存関係のない1ファイルのダウンロード可能な実行ファイルが欲しいなら、これがええで。

Wolfram、何か言いたいことあるか?

Wolfram: クロスプラットフォームってのもすごくええ点やな。Windowsでも動くはずやし。

一つ質問があるんやけど、他の人も同じこと考えとるかもしれん。モデルと推論ソフトが1つのバイナリに入っとるけど、推論ソフトをアップデートするにはどうするんや? その1ファイルの一部を置き換える更新プログラムがあるんか?

Nist: ああ、再ダウンロードするだけや。でも、disasmして新しいモデルを指定することもできる。直接更新する方法はないんや。これは設計上の選択やな。ネットワークに接続せんで単一の実行ファイルが欲しい人がおるからな。だから、1ギガバイトの更新をダウンロードせなあかんのや。

でも、サーバーも付いてくるし、ウェブサイトの解析とかもできるんや。埋め込みモデルとしても使えるし、どんなモデルでも使えるんや。llama.cppを埋め込みモデルとして使って、それだけで動かせるんや。

ほんで、Whisperファイルも作ったんやろ? あれもデータセットを作る人にはめっちゃ便利やな。音声を解析するときに使えるし。

今、音声の巨大なフォルダがあって、それを転写せなあかんとしたら、フォルダを巡回するだけのbashスクリプトを書いて、「ey /usr/myself whisperfile run this」って感じで転写を取得して、どこかに送るだけでええんや。Pythonとか他のもので100万個のパッケージをインストールせんでもええんや。bashだけでできるんや。

小さなことのように見えるかもしれんけど、大きな違いを生むんや。

アレックス: めっちゃ大きいな。モデルを使う時に特に。

毎回更新があったら言及したいんや。オープンソースは我々の心にあるからな。Nist、今週は自分の大きなニュースを発表する準備はできとらんのか?

Nist: いや、まだや。35Bモデルの小さいバージョンはもう2000ダウンロードされとるし、実験としてはかなり有用やけど、大きい方については慎重に扱わなあかんな。

サンプリング側でもかなりの進歩があってな。何人の人が俺が何について話しとるかわかるんやろ。ちょっと説明してもええか? 基本的に、新しいモデルを作っとるってことでええんやろ? 人々がダウンロードしとるってことは、この時点で言うても大丈夫やと思うんやけど。

そうや。進化的マージングの技術を使っとるんや。数週間前にBiggiでやった、最小の一貫したモデルを作る技術があったやろ? あれを大きいモデルに使い始めたんや。基本的には、タイズマージとフランケンシュタインを自動的に数日かけてやって、ベンチマークを走らせて測定するだけなんや。

方法論としては特に目新しいもんやないんやけど、結果が面白いんや。モデルはそんなに大きくならへん。レイヤーがちょっと増えるくらいなんやけど、量子化したときのパフォーマンスがめっちゃ良くなるんや。なんでそうなるかはまだわかってへんのや。

コリン・ラッフェル教授と話してて、もっと科学的な研究をしようって話になったんや。これが異なるタイプのモデルでも同じようなパターンが現れてるみたいやからな。

基本的に、Qwen 32Bの3つのバージョンを取って、この進化的マージングを実行したんや。そしたら35Bになって、かなり良さそうなんや。みんな気に入ってくれとるみたいやし。

もっと大きいのでやったら、GPQ-Aダイヤモンドで5%か6%近く高くなったんや。これは特別なプロンプトも使わずにやで。かなり興奮するな。

アレックス: Jingoが言うてたけど、GPQ-Aダイヤモンドは推論じゃなくて、モデルに含まれる事実の知識が難しいんやろ? 知識を追加したりはしてへんのか?

Nist: いや、そうやない。ベースモデルを混ぜ込むと、その知識がすでにあるかもしれんし、RHFの学習からそれを圧縮してるだけかもしれんな。

サンプリングの方でも、今週めっちゃ面白いことが起きとるんや。あんまり知られてへん部分やけど。XDR、シュレックサンプラーについて簡単に説明できるわ。

サンプリングっていうのは、モデルの温度を設定することなんや。LM eval harnessでグリーディサンプリング、つまり温度0を使うと、ベンチマークの結果が少し良くなることが多いんや。

でも今回は、エントロピー形式のサンプリングをしてるみたいなんや。コードをちゃんと見てへんけど、ざっと見た感じやと、モデルが次のトークンとして出す可能性のある結果全部を見て、何かの統計を取ってるんや。その統計が連続的にどう変化するかによって、thinking tokenを挿入するかどうかを決めてるみたいなんや。モデルの実行に介入するかどうかをね。

これがかなり良い結果を出してるみたいで、1Bモデルでもそうなんや。

アレックス: それがXDRっていう、発音できへん名前のやつか?

Nist: そうや。かなり面白い結果が出とるんやけど、もっと洗練させる必要があるな。何人かが実装してみたんやけど、重みの中にもっと知識が埋め込まれてて、それを抽出できるみたいやな。

でも、まだちゃんと評価されてへんのや。最終的に良い結果をもたらすのか、この新しいサンプリング方法や能動的サンプリングが本当に大きな改善をもたらすのかはまだわからへん。Claudeがずっと使ってたのはこれなんかな?

要するに、今のところは有望な技術やけど、まだ完全な評価はできてへんってことやな。

アレックス: なるほどな。Nistがいきなり技術的な話に飛び込んでくれたわ。

オープンソースの話といえば、LLMじゃないけど他のことも話さなあかんな。MetaのMovie Genはビジョンカテゴリーで話すつもりやけど、オープンソースの動画カテゴリーではPyramid Flowってのがあるんや。オープンソースの画像とテキストから動画生成モデルで、MITライセンスで公開されとる。めっちゃ最近出たばっかりなんや。

まだトレーニングコードは公開されてへんけど、そのうち公開されるらしい。めっちゃクールに見えるわ。皆さん、見る機会あった? スペースの一番上に追加しとくわ。

Pyramid Flowは、効率的な生成モデルで、Pピラミッド表現を利用して学習効率を大幅に向上させとるんや。Co-Video-Xについて話したの覚えとる? あれよりずっと良さそうや。画像生成の品質がずっと良くなっとる。

まだオープンソースのSoraレベルには全然達してへんけどな。それはMovie Genの話になるわ。後で話すわ。もし公開されたらやけどな。でも、このモデルの品質もかなり印象的やわ。

どれくらい大きいんやろ? そんなに大きくないみたいやな。Hugging Faceで見てみるわ。230億パラメータくらいやな。かなりすごいで。768pで24fpsで動画を生成できるんや。画像から動画も生成できるし。

オープンソースコミュニティが動画生成モデルに挑戦してるのは素晴らしいわ。Wolfram、見る機会あった? 何か超クレイジーな例とか目に付いたものある?

ないみたいやな。まあ、特にそのモデルについてやないけど、ちょっと失望してるんや。まだ使えへんし、ただの発表やからな。でも、使えへんとしても、何が可能かはもう見えとるんや。2年後には何ができるか考えてみ。「これが欲しい」って言うだけで、音声付きの完全な世界を作り出せるんや。これらの技術について一番わくわくするのは、今すぐ手に入らんとしても、近い将来何が来るかわかってるってことやな。

アレックス: そうやな、Wolfram。ここでつながりを見出せるわ。Metaはこれについてあんまり話してへんけど、名前をMetaに変えて、全部メタバースのことやったやろ。これは間違いなくその方向に向かっとるんや。

自分の動画生成をパーソナライズできるってのもそうやし、最近のアップデートで、開発者がカメラからの実際のピクセルにアクセスできるようになったってのもそうやな。外の世界で起こっとることをリアルタイムでストリーミングして、開発者としてそのピクセルを取得して、別のものに変換できるんや。

間違いなくその方向に向かっとるし、彼らはこれに取り組んどるんや。私も同意するわ。リリースされへんのは残念やな。Metaのラマチームの人らに聞いても、いつリリースされるかわからんって言うとったわ。

でも、サイズを公表したのはすごいことやと思うわ。Soraのサイズは知らへんし、他のモデルのサイズも知らへん。300億パラメータのモデルでこんな高品質なものが得られるってのは、かなりすごいことやと思うわ。

さて、オープンソースの話はこれくらいにして、大手企業の話に移ろうか。それと、音声の話もせなあかんな。

その前に、1時間経ったし、Weights and Biasesの話をちょっとしたいんや。いつもの通り、今週のW&Bカテゴリーやな。

Weights and Biasesのアカウントが見えるやろ。このスペースを私と共同ホストしてくれとるんや。四角いアバターが見えるはずや。フォローしてくれたら嬉しいわ。

でも、これは新しいニュースなんや。速報やで。W&Bがソーシャルメディアマネージャーを探しとるんや。今投稿したばっかりや。AIに興味があって、ソーシャルメディアの仕事がしたくて、私と直接仕事したいって人がおったら、ソーシャルメディアマネージャーを募集しとるんや。ソーシャルメディア全般で人々を助ける仕事や。このアカウントをフォローしてくれて, もし自分がぴったりやと思うなら、DMを送ってくれ。

他のWeights and Biasesのニュースやけど、テキストから画像生成モデルのプロンプト理解と画像品質のベンチマークを「HEM」っていう名前でリリースしたんや。こういうベンチマークはいくつかあるけど、これは我々のやつや。WeaveっていうLLM可視化ソフトウェアで動くんや。

ちなみに、Weaveはマルチモーダルなんや。多くの人は知らへんけど、LLMはほとんどVMMやからな。でも、これはWeaveがLLM可視化だけやないってことを示すためのもんや。画像モデルの評価とかもできるんや。

これは、テキストから画像生成タスクの評価スイートで、画像モデルのリーダーボードも含んどるんや。私のチームのMが、これらの画像を生成する方法をたくさん作って、Fooocus、SDXL、SDXL Turbo、Fooocus Devなんかを比較したんや。

このリーダーボードをチェックしてみてくれ。ショーノートにも追加しとくわ。コードは完全にオープンソースやから、HEMに行けば自分で実行できるし、Weaveのいいインターフェースで結果を見ることもできるんや。

Sumikがこれに長い間取り組んできたんやから、感謝せなあかんな。前も言うたけど、もっと評価指標が必要やからな。これは特にテキストから画像生成のリーダーボードやな。

リーダーは誰か言うてみようか。これ、重要やと思うんや。今のところ、Fooocus Devが勝っとるな。オープンソースだけやから、Fooocus Proはないんやけど、先週Fooocus Pro 1.1がアップデートされたから、たぶんFooocusが勝つやろうな。Fooocus Devがトップを取っとるのは、かなりクールやと思うわ。

さて、Weights and Biasesに関連する2つ目の話題に行こうか。これは必ずしも標準的なAIの話やないけど、でもAIの話や。

みんなCursorを使っとるよな。Morganさん、俺のマネージャーやけど、Cursorのウェブページにめっちゃ興奮してたわ。「Weights and BiasesでCursorを使ってる」ってな。

今週、チーム内でCursorのコツについてのミーティングをすることにしたんや。「俺はCursorをこう使ってる、お前らはどう使ってる?」みたいな感じでな。Cursorについては何度も話してきたし、Lex FridmanがCursorチームと話したのも今週やったっけ? めっちゃ興味深い会話やったな。

これは、我々が持ってるツール、結構な金額払ってるツールをどう使うかについて話し合うミーティングやったんや。ちなみに、先週もCursor Proのサブスクリプションを、一等賞としてみんなに配ったよな。

そのミーティングはめっちゃ生産的やったわ。一般的に、チーム内で生産性を比較したり、誰が何を使ってるかを比較するのは利点があると思うんや。

でも、ここにおる多くの人、観客の中にもImratとか他のCursorの人らがおるの見えるけど、彼らのコツやトリックを集めてきたから、これを1つのスレッドにまとめて投稿したんや。そしたらめっちゃバズってもうた。

確実に有益なミーティングやったわ。このスレッドからいくつかのハイライトを共有したいんやけど。ショーノートにも追加しといたし、トップにも載せたから、皆さん見られるはずや。

基本的に、Cursorの新しい「Composer」っていう機能をめぐって混乱があるんや。多くの人はその存在すら知らへんし、どう使うかもわかってへん。Cursorチームもこのことは承知しとると思うわ。

ちなみに、これは一切スポンサーついてへんからな。単にCursorが大好きで、自分たちのツールの使い方を改善せなあかんと思っただけや。

Cursorでコードを編集する方法は3つあるんや。1つ目はインラインや。Command + Kを押すと、行を選択して、Command + Kを押して、チャットして「これを変更したい」って言うんや。これは残りのコードのコンテキストはないから、Command + Kは1つの関数を選択して、その1つの関数をリファクタリングしたい時にだけ使えるんや。

ほとんどの人が使うのは、チャットインターフェースや。Command + LかCommand + Shift + Lやったと思う。ChatGPTとコードについて話すのと似たようなインターフェースや。

唯一の大きな違いは、「適用」ボタンがあることや。このボタンがめっちゃスマートにコードに適用してくれるんや。ChatGPTが怠慢で、コードを求めたら「残りのコードはここに…」って言うのを覚えとるやろ? それが実際にCursorではうまく機能するんや。違いだけを示して、Cursorチームが言うてたけど、違いを適用する方法を知ってる小さなモデルがあるらしいわ。

最後の方法が「Composer」や。これが最新の方法なんやけど、チャットインターフェースでも複数のファイルを編集できるし、複数のファイルやフォルダをタグ付けできるんやけど、そのために作られたわけやないし、新しいファイルを作ることもできへん。

ComposerはCommand + Shift + IかCommand + Iで、Cursorで複数の長期的なタスクをやらせる方法なんや。新しいファイルを作ったり、複数行の変更をしたりできるんや。異なるファイルからコンテキストをダンプして、「このファイルを作ってほしい」って言えるんや。

Composerは少しバグがあるけど、絶対に試す価値があるで。Cursorを使っててComposerを使ってへんなら、めっちゃ損してるで。これで新しいファイルを作れるし、複数のファイルにまたがってリファクタリングもできるんや。

例えば、Pythonのインポートがいっぱい入ったフォルダを取って、「遊びでモノレポにしてくれ」って言うたら、ちゃんとやってくれたんや。

それと、中のモデルやけど、もちろんClaude 3.5が使えるし、今のところコーディングに関しては最高のモデルやってCursorの人らも言うとるけど、GPT-4とGPT-4 Turboも使えるんや。

面白いのは、GPT-4だけを使うんやなくて、タスクによってモデルを切り替えるってことや。例えば、GPT-4 Miniは大きなファイルで何をすべきかアウトラインを書くのにめっちゃ良くて、Cursorはその速さのおかげで、繰り返しバグを修正するのに本当に優れとるんや。

最後のホットチップは、みんな見逃しとると思うんやけど、Cursorはコンソールエラーの識別がめっちゃ上手なんや。時々、Cursorが「AIでデバッグ」ってボタンを表示して、このコンソールエラーをコンテキストと一緒にチャットにダンプして、デバッグを頼んでくれるんや。

でも、そのボタンが表示されへん時もあるんやけど、ショートカットがあるらしいんや。コンソールで何か選択して、Macならオプション+D、WindowsならたぶんAlt+Dを押すと、すぐにチャットウィンドウが開いて、そのエラーと適切なコンテキストを入れて、デバッグを始めてくれるんや。エラーの原因も教えてくれる。これはめっちゃプロ向けのチップやと思うわ。Cursorにこれを修正してほしいわ。

これがスレッドのハイライトやな。フルのスレッドを読んでみてくれ。Cursorはめっちゃ素晴らしいからな。これが誰かの役に立てばええと思うわ。

Yam、手を挙げとるな。以前はCursorに懐疑的やったけど、今はどう思う?

Yam: 俺はLLMコードに対して一番の懐疑派やで。ネットで見てみ。Gary Marcusのコード版みたいなもんや。でも、ComposerのあるCursorは少し違うんや。普段やらへんようなこと、フロントエンド開発とかに使ってみたんやけど、ほとんどのタスクで本当に役立つんや。

LLMと同じで、ここや。全然違うんや。無料で試せるし遊べるし、世界で一番懐疑的な人間の俺が言うとるんやから、まだ試してへんのやったら試してみ。Composerは俺の意見では、これまでのものとは違うんや。

ただ、懐疑的であり続けることの重要性も忘れんといてな。将来的には、AIが本当に優れたコードを自力で書くようになるのは間違いないと思うわ。今の時点では、まだ懐疑的である必要があるってだけやな。

アレックス: そうやな。俺も昔からの懐疑派やったけど、完全に考え方が変わったわ。GitHub Copilotの前からやけどな。特にComposerは、経験のない分野でも使えるってのが人々の意見を変えとると思うわ。

多くのバックエンド開発者や機械学習エンジニアはフロントエンド開発をしたがらへんけど、これならできるんや。特にVMMを使えば、欲しい画面のスクリーンショットを貼り付けて、「このコードはこれをやってる」って言って、実際にやってることを見せて、「これを変更してほしい」って言えるんや。実際にチャットでもやったんやけどな。

Wolfram、何か言いたいことあるか?

Wolfram: ただ言いたかったのは、これも絶対に手放したくない2つのサブスクリプションの1つやってことやな。それと、知らんかもしれんけどコツがあるんや。

よくある問題は、使うと多くのコードが変更されることやな。だから俺がやっとるのは、Gitのステージング機能を使うことや。ある部分がええと分かったら、それをステージして、AIが何を変更したかをdiffで正確に見るんや。AIが全体のファイルを書き直して、たくさん変更を加えた時に追跡を失うのを避けられるんや。

アレックス: そうやな、完全に同意やわ。

Yam: これは本当に重要な指摘やと思うわ。たぶんCursorチームも聞いとると思うけど。AIが何かミスをすることもあるし、それは全然構わんのやけど、ただ元に戻したいだけの時があるんや。

今は、「適用」ボタンを押す前の状態に戻る方法がないんや。これがCursorにあれば本当に便利やと思うわ。今のところは、みんなGitを使っとるんやけどな。

アレックス: ええニュースがあるで。めっちゃ重要やから言うけど、そういう機能があるんや。「すべて保存」と「すべて適用」ってボタンがあって、Composerでは変更を保存して、ブラウザに切り替えて変更が実際に効果があるか確認して、それからCursorに戻って、Escapeを押せば、すべての変更が消えるんや。コードには適用されへんまま、一時的な状態にあるんや。

俺らが欲しいもので、まだ足りへんものについて言うと、書いたコードが実際に動くかどうかをまだ自分でテストせなあかんのが辛いわ。Deonとか他のツールがやってるみたいに、コードを書いてくれただけやなくて、実際にコンパイラを通して有効性をチェックしてほしいんや。

Pythonなら、パッケージがインポートされてるかとか、そういうのもまだ面倒くさいんや。「パッケージがインポートされてへん」って言われても、お前コンパイラにつながっとるやろ。パッケージが使えるかどうか分かるはずやし、IDEがドットを打ったら全ての関数を表示できるんやから、俺のために確認してくれよって感じや。

これが次のステップやと思うわ。Cursorの人らもこのことは知っとると思うで。

さて、この話題はこれくらいにしとこか。投稿を読んでみて、他にもコツやトリックがあれば教えてくれ。これはCursorっていう1つの会社の話やないんや。みんなで一緒に生産性を上げていく話なんや。

最後に言っとくけど、今や人と話す時、どうやってコードを書くかっていう話やなくて、どうやってCursorにコードを書かせるかって話になっとるんや。考え方が変わってきとるんや。

例えば、Morganと一緒にコーディングする機会があったんやけど、「こうやってコードを書くやろ」って話やなくて、「Cursorにこんな風に指示したら、このコードを書いてくれるやろ」みたいな話になるんや。

正直に言うと、俺が自分で書けへんようなコードを書いてくれることもあるんや。次に話すAIオーディオの話やけど、Quindが参加してくれると思うんやけど、ハロウィンプロジェクトのために、頭の中では大体分かっとるけど、実際にはマルチスレッドのオーディオコードをどう書くか分からへんようなコードを書いてくれたんや。

俺が実際に調べて書こうと思ったら、時間の無駄になってたやろうけど、今はそれがただ動くんや。これは本当にすごい新しい能力やと思うわ。Cursorはその一つの例やけど、他にもあると思うで。

これでWeights and Biasesのカテゴリーは終わりやな。LLM Studioの創設者との対談の前に、OpenAIのリアルタイムAPIとオーディオについて話そうと思うんやけど。

ヤール、観客の中におるの見えるで。招待が見えたら、マイクボタンか参加ボタンを押して、ステージに上がってきてくれへんか。

それまでの間、先週の大きな発表について話そうか。Dev Dayで、OpenAIが開発者向けに高度な音声モードへのアクセスを提供すると発表したんや。これは本当にすごかったわ。

多くの人が開発者やし、こんな素晴らしいモデルにアクセスできるようになるなんて。俺はこれにめっちゃわくわくしたわ。間違いなく、Dev Dayカンファレンスのハイライトやったな。

先週、Simon Willsonもここにおって、OpenAI Dev Dayの話をしてくれたけど、これが間違いなくハイライトやったわ。俺はこれを使い始めるのにめっちゃわくわくしてて、実際に使い始めたんや。

彼らがリリースした例では、Node.jsのクライアントの例しかなかったんやけど、俺のハロウィンプロジェクトに統合しようとしたんや。このハロウィンプロジェクトっていうのは、子供たちを見て、ビジョンモデルを使って彼らの衣装に基づいてカスタムの特別な挨拶を決めるおもちゃなんや。

このハロウィンプロジェクトは、当然ながらWeaveですべての衣装も見れるようになっとるし、今ここにあるんやけど。みんなが追いかけてくれとるのは知っとるけど、写真を撮れたらええんやけどな。電話でXを見とるからな。後で写真を共有するわ。

ああ、Wolframが何か共有してくれたな。ありがとうな。

このハロウィンプロジェクトの目的は、まず第一に、今まで経験したことのない分野を学ぶことなんや。アニマトロニクスも含まれとるし、AIにはまだできへんハードウェアの部分もあるんや。DCモーターやバッテリーにはんだ付けするとかな。だからハードウェアが重要かもしれんな。

でも、異なるアプローチや、音声やビジョン、それらを組み合わせることについても学びたいんや。めっちゃクールに見えるで。ここにいくつかメモがあるわ。

Quindも歓迎したいんやけど。QuindはTryDailyの共同創設者やな。エンドツーエンドのモデルを実行する素晴らしい例をたくさん持っとるし、リアルタイムやないモデルもな。

リアルタイムAPIはかなり実験的やってことに気づいたわ。多くの部分がまだ必ずしも動いてへんし。それだけやなくて、価格設定についても色々見たんやけど、正直なところ、ちょっと使ってみただけで5ドルくらい請求されてもうたんや。数分の会話で。

ChatGPTのプレミアムで高度な音声モードを使って30分か1時間くらい話すのとは全然違うな。これはめっちゃ高いわ。彼らの請求システムにバグがあるんか、それとも本当にこんなに高いんか分からへんけど、基本的にハロウィンの子供たちとボットに話してもらおうと思うと、数百ドルかかりそうなんや。

今のところは、ハロウィンの衣装に反応するだけやねんけど、子供たちにクイズをしたいと思っとったんや。衣装についていくつか質問したいと思っとったんやけど、コストがかかりすぎて無理そうやわ。

Quind、ようこそ。自己紹介してもらってもええかな。この分野の専門家やし、リアルタイムAPIに対する俺の反応に加えてもらえたらありがたいわ。

Quind: 音声AIにとってはエキサイティングな週やったな。俺はDailyの創設者で、リアルタイムのオーディオ、ビデオ、AIのインフラとツールを作っとるんや。

これらの新しいユースケースの大きな転換点は、GPT-4が最初に出た時やったな。本当の会話ができるLLMがあるって明らかになった時や。すぐに音声ループを組み立て始めたかったんや。

18ヶ月前でも、Deepgramで文字起こしして、GPT-4で処理して、それからElevenLabsで音声生成するっていう、めっちゃクールなことができたんや。音声から音声への遅延を2秒以下にできたんや。これはマジで驚くべきことやったな。

最後の6ヶ月は、本当に大きな転換点やったように感じるわ。今や3つの本当に優れたリアルタイム音声モデルがあるんや。ElevenLabs、Coqui、Play.htからな。これらは不気味の谷の向こう側にあって、しかも800ミリ秒以下の遅延なんや。

アクセスできへん別のモデルもあるんやけど、これはAnthropicのClaudeを動かしてるモデルで、マジでめっちゃクレイジーなんや。不気味の谷の向こう側にあるんや。

これは面白いことやと思うわ。今使える音声から音声のモデルは、大手ラボからやなくて、全部スタートアップから出てきとるんや。これは技術的な問題というより、規制の問題やと思うわ。ディープフェイクとか他の問題があるからな。スタートアップの方が、この分野ではちょっと保守的になれへんから、音声のものをより早くリリースしとるんや。

この6ヶ月で変わったもう一つのことは、オープンソースのツールがめっちゃ良くなったことや。今や俺の時間の90%はオープンソースの音声AIの周りのことに使っとるわ。

「Pipecat」っていうプロジェクトのメンテナンスを手伝っとるんやけど、これはコミュニティの勢いがめっちゃあるんや。Pythonで音声からAIへのオーケストレーションレイヤーを提供してて、どのLLMでも使えるんや。これは完全にオープンソースで、ベンダーニュートラルなんや。WebRTCやWebSocket、HTTPをリアルタイムの転送に使えるんや。それぞれに長所短所があるんやけどな。

新しいリアルタイムAPIで見られる厳しい部分について、WebRTCとWebSocketの違いについてそのうち話さなあかんな。

それで、OpenAIが何かをリリースすると、めっちゃでかいハロー効果があるんや。先週、リアルタイムAPIにアクセスできるようになって、みんながアクセスできるようになったのがめっちゃ興奮したんや。ネイティブの音声から音声のモデルと話すのは質的に違うからな。

でも、実際にはしばらくの間、製品品質の音声から音声の処理ができとったんや。これは単に人々に「ほら、これがあるんや。みんなで作ろうぜ」って示しただけなんや。OpenAIがどんなユースケースにでも与えられるスポットライトはめっちゃすごいんや。

アレックス: そうやな。Dev Dayで別のスポットライトが当たったのは、我々がW&Bでやっとることなんや。Weaveについては何度も話してきたけど、OpenAIが紹介して、ハロー効果を与えたもう一つのユースケースは、評価の実行とログの保存についてやな。

これは我々がWeavesでやっとることで、めっちゃ考えたんや。「OpenAIが我々を殺したんやないか」って感じやったけど、人々は異なるモデル間で比較したいし、OpenAIだけやないからな。

ハロー効果には同意やな。OpenAIが何かを紹介すると、人々は「ああ、これは無理や」と思うかもしれんけど、実際にはコストが高すぎるだけかもしれんのや。

コストの話をしようか。これは俺にとってめっちゃ大きな問題やったんや。本当に使い始めようと飛び込んだんやけど、OpenAIのコンソールでも、LifeKitについて言及しとったし、Dailyも使えるんやないかと思ったんや。

ちょっと使ってみたんやけど、いきなり5ドルくらい請求されてもうたんや。数分の会話で。これがお前らの経験とも一致するんか? 高すぎるんやないか?

Quind: そうやな、めっちゃ高いわ。基本的に、最初は価格を高めに設定してるんや。この新しいユースケースのための推論をスケールさせるのが難しいからな。彼らは世界最高のスーパーコンピューターの運用者やけど、彼らでさえこういう新しいものにはゆっくり取り組まなあかんのや。

WebSocketのスケーリングも彼らのチームにとっては新しいことやしな。彼らのチームについて何か言うつもりはないけど、彼らが運用してるスケールで新しいインフラをロールアウトする時は、かなり慎重にならなあかんのや。

だから、価格設定は主にそのためやと思う。必ず下がると思うけど、今はめっちゃ高いんや。オーディオトークンがどんどん積み重なっていくからな。

多数のターンがある会話を考えてみ。話せば話すほど、各推論のコストが高くなるんや。毎回より長いコンテキストを入力することになるからな。APIが内部でコンテキストを管理してくれるけど、そのAPIは話すたびにモデルで推論を行っとるんや。分かるか?

アレックス: そうか、これが切断してる部分なんやな。ストリーミングトークンを使うのとは全然違うってことか。コンテキストがどんどん大きくなっていくんやな。これが正しい理解の仕方か? それとも何か見逃してる?

Quind: そうや、コンテキストがどんどん大きくなるんや。通話の最初は小さなコンテキストをモデルに与えるけど、5分経つ頃には、話すたびにたくさんのトークンをモデルに与えることになるんや。

モデルは内部的にはまだステートレスなんや。これまでのモデルと同じようにな。APIはステートフルで、開発者にとってはめっちゃ便利なんやけど、内部のモデルは依然としてステートレスなんや。

だから、チャットの会話が長くなって、チャットの全履歴を毎回ユーザーが送信するのと全く同じことが起こっとるんや。ただし、テキストトークンよりもずっと大きいオーディオトークンでな。

アレックス: なるほどな。人々はこれを使って何か作り始めとるけど、まだめっちゃ説得力のあるユースケースは見てないわ。

俺も何か作れたらええなと思っとるんやけど。OpenAIの人に声をかけてもらえたらええのになって。誰かがこれについて投稿してるのを見たんやけど、OpenAIが俺にクレジットをくれたら、このすごいハロウィンのユースケースのために使えるのにって。断らへんで。

去年のDev Dayでもらったクレジットを特別なことのために取っておいたんやけど、今年のDev Dayの1週間前に期限切れになってしもうたんや。残念やわ。

もう一つ、これを使って何か作るのがめっちゃ直感的やないってのもあるな。特に、LLMの通常のストリーミングインターフェースに慣れてる人にとってはな。これは違うんや。

多くの人にとって、これは双方向の音声起動の経験とは違うんや。音声起動を考慮せなあかん。サーバーサイドの音声起動があって、プッシュトゥトークもできるんやけど、この複雑さについてもう少し詳しく説明してくれへんか?

Quind: APIの設計はかなりええと思うけど、確かに新しいもんやな。彼らは2つのことを簡単にしようとしたんや。

一つは、単にオーディオをストリーミングする場合、できるだけ多くのことを自動で処理しようとしてるんや。とてもシンプルなユースケースやプロトタイピングのために、Pythonで75行くらいのコードで、WebSocketsAPIを直接使った完全な音声対話のコマンドラインを作れるんや。

でも、テキストとオーディオを混ぜたり、純粋な音声にしたり、プッシュトゥトークモードにしたり、会話のコンテキストを自分で管理したりしようと思うと、APIの形についてたくさんのことを学ばなあかんのや。

たしか35くらいのイベントがあって、クライアント側で送る8か9のイベントと、サーバー側から返ってくる26か27か28か29のイベントがあるんや。全部知る必要はないけど、何をしようとしてるかによって、10か11か12くらいは知る必要があるやろうな。

ドキュメントはええけど、数ヶ月後にはもっとよくなると思う。だから、この新しいAPIの上に製品品質のものを作るのは、数日かかるやろうな。

Pipecatで試みたことの一つは、音声からAIへの作業を本当に簡単に始められるようにして、それからどんなモデルでも入れ替えられるようにすることやった。PipecatにはリアルタイムAPIの実装があるから、すでに音声からAIへの作業を作っとる人なら、既存のPythonコードを全く変更せずに、あるいは小さな変更だけで、新しいリアルタイムAPIを簡単に試せるんや。

でも、まだ全部が動くわけやないな。確かにちょっとベータ版的な感じやな。俺のコードにバグがあるのか、リアルタイムAPIにバグがあるのか、いくつか再現ケースを作っとるところやわ。

アレックス: そうやな、俺もDailyのを使ってへんけど、他の2つの実装でもバグを見たわ。コンテキストが少し欠けてたり、他のことが起こったりしとったな。

もう一つ、本当に掘り下げてみるまで明らかにならへん、めっちゃ面白いことがあるんや。モデルが聞いてることと、APIから返ってくる文字起こしイベントが同じやないんや。

音声から音声のモデルは本当に音声から音声で動いとるけど、音声から音声のフローでテキストを入力したり出力したりせーへんからな。彼らはサーバー内部でWhisperも動かしとるんや。Whisperを動かしてるから、Whisperからテキストや文字起こしを返してくるんやけど、時々、テキストで返ってくるものがモデルが聞いたこととまったく違うことがあるんや。モデルが言ったことは分かるけどな。

これはめっちゃ面白いな。Dev Dayのステージでイーロンとロメインが電話で話してるデモがあったやろ。チャットインターフェースに彼らの会話内容が表示されとったけど、それを聞くこともできたんや。でも、それはWhisperがやっとることで、モデル自体はそれを出力してへんってことやな?

Quind: そうそう。モデルはネイティブにオーディオやけど、APIを通してテキストを返すのに必要な配線が全部揃ってへんみたいなんや。

ほとんどの企業のユースケースでは、コンプライアンスや評価、コンテンツモデレーション、ガードレールのためにテキストが必要なんや。だから、オーディオに加えてテキストにもアクセスできへんと、本当の意味での製品レベルのユースケースはほとんど作れへんのや。

アレックス: なるほどな。これは一種の偽のアクセスみたいなもんやな。映画を見てる時に字幕が実際の台詞と合ってへんかったり、翻訳が違ったりするのと似とるな。ちょっとそんな感じやな。面白いわ。

俺のプロジェクトでも気づいたことがあるんやけど、子供向けのプロジェクトやから、リアルタイムっていうより一般的なAIオーディオのアプローチに近いんやけどな。

ウェイクワードがあるんやけど、これはPorcupineで作ったんや。基本的にAnserdに耳を傾けてくれた皆さんに感謝やで。デバイス上でウェイクワードを扱う方法があるって教えてくれて、その一つがPorcupineやったんや。

公開で作業するのはめっちゃクールやな。投稿するだけで人々が答えてくれるんや。だからPorcupineをウェイクワードに使っとるんやけど、これが俺には全然機能せえへかったんや。

子供たちが、言うのが怖い言葉、Alexaが起動しそうな言葉、「トリック・オア・トリート」って言っても全然反応せえへのや。めっちゃ変やったわ。いろいろ試してみたんやけど、Quind、これについて前に話したよな?

実際にWhisperで試してみたら、これらのモデルはどれも子供の声を全然認識せえへみたいなんや。高度な音声モードでも同じ問題があったわ。ポッドで話したことあるけど、子供たちが話しかけても時々全然反応せえへのや。

Dev Dayでこの問題についてOpenAIの人らと話したんや。子供が高度な音声モードに向かって叫んでるビデオを見せたんやけど、全然反応せえへのや。

Quind、これはデータセットに子供の声が含まれてへんからやと思う? それとも音域の問題? どう思う? お前らも同じようなこと気づいた?

Quind: 面白いな。俺らはDeepgramをよう使うんやけど、Deepgramがめっちゃ良くなったから、4歳児でも機能すると思っとったんや。でも、お前が試してみて機能せえへかったってことは、データセットにギャップがあるんやろうな。

アレックス: そうやな、データセットの問題やろうな。俺の4歳児はバイリンガルやから、アクセントがあるのかもしれん。ロシア語なまりの英語を話すバイリンガルの子供のデータセットが足りんのかもな。

お前の9歳児が最高のベータテスターやって言うとったな。音声AIと何時間も話すんやろ? 子供たちがこういうのを使うのを見るのは面白いわ。未来の一瞥を見てるみたいやな。小さい子供がiPadを使うのを見てるみたいで、「ああ、これと一緒に育つとまったく違う世界になるんやな」って感じやわ。

Quind: そうやな。彼らは本能的に、他のものとこういうタイプのものの違いが分かるんやと思う。特に高度な音声モードやリアルタイムの場合、普通の音声認識からLLM、そして音声合成っていう通常のフローとの違いは感情的なもんなんや。

このモデルはリアルタイムで反応できるだけやなく、彼らが感じたことにも反応できるんや。言語の違いやコードスイッチングなんかも含めて、我々が話してきたことの違いはめっちゃすごいわ。

子供たちにとって機能する時、その違いが見えるわ。

LLMを使って構築したい人たちにとっては、これらのボットとフルエンドツーエンドで会話する能力が欲しいと思うんや。お前らが見せてくれた例はめっちゃすごかったけど、人々はこれらのシステムを使って構築したいんや。

ハッカソンが近づいとるらしいな。これについて言いたいことあるか? お前らが取り組んでることについて人々に教えたいことあるか? みんながこれらのシステムの構築方法を学べるように。

Quind: そうやな。サンフランシスコでよく音声AIのイベントをやっとるんやけど、この9ヶ月くらいでコミュニティが成長していくのを見るのがめっちゃ楽しいんや。

10月19日と20日に、Salarisという会社、ここにおる人の多くが知ってると思うけど、そこで大きなハッカソンをやるんや。サンフランシスコで直接参加できるし、Product Huntがリモートトラックもやってくれるから、サンフランシスコにおろうがおらんかろうが、登録して音声AIのものを作ってほしいんや。

音声AIの経験が豊富な人がたくさんおるし、リアルタイムビデオもやるで。800ミリ秒以下のリアルタイムビデオ生成ツールを開発者向けに提供してる会社も何社かスポンサーになってくれとるんや。

リモートでもその場でも、2万ドルの賞金が用意されとるんや。めっちゃ楽しみやわ。

2日間でやるんは、多くの人にとってはこれが初めてやから、十分な時間が欲しいからなんや。お前とSlackで話したように、すでに取り組んでるプロジェクトを持ってきてもええし、今から何か始めてもええんや。

ハッカソンの時間内に全部作らなあかんってわけやないんや。むしろ、みんなが作っとる楽しいものを見せ合おうってことや。審査のために提出する時は、ハッカソン中に何をしたかと、何を持ち込んだかを言うてくれたらええんや。

アレックス: そうやな、俺も絶対に応募するわ。ハッカソンへのリンクをショーノートに追加しとくわ。

Quind、来てくれてありがとうな。次のセグメントに移らなあかんから、何度も約束したのに、また消えそうな人がおるんや。Quind、本当にありがとうな。

皆さん、これがリアルタイムAPIへの反応やな。これで今日のショーは終わりやと思うけど、OpenAIからの速報があるみたいやな。見えるか?

超速で紹介するわ。リアルタイムで反応するの好きやろ? ThursdAIの最後にしか聞けへん速報やで。

OpenAIが新しいベンチマークをリリースしたんや。MLEBenchっていうんやけど、AIエンジンが機械学習エンジニアリングタスクをどれだけうまくこなせるかを測るベンチマークや。具体的に機械学習エンジニアリングやで。

これはめっちゃクールなベンチマークや。Kaggleから集めた75の機械学習エンジニア関連のコンペで構成されとるんや。

新しいベンチマークはいつもすごいな。OpenAI PreviewのGPT-4とOne Previewが明らかにトップやな。これが推論モデルで、他のものを使う人はおらんって言うとるんや。

Mタスクは彼らが内部的にもこのモデルにやってほしいタスクの一部やな。前に話したLLM 360のTXT 360データセットを覚えとるか? あれのほとんどはarXivの論文やけど、データサイエンス系のものもようけあるんや。

だから、自分たちのタスクを置き換えたい人たちにとって、MLEBenchはきっと役立つと思うわ。

超速で反応しとるけど、もうこのMLEBenchの例を示してる人もおるな。GPT-4とOne Previewが何個のメダルを獲得したかとか、それがAIdっていうのがめっちゃクールに見えるわ。

PDFもあるな。ちょっと見てみよう。OpenAIのベンチマーク、Kaggleのコンペやな。スコアとゴールドがあるみたいや。ちょっと統計を見てみよう。

超速で反応しとるけど、One Previewが8回の試行で有意に高いスコアを出しとるな。35個のチャレンジに参加して、GPT-4は18回試行しても及ばへんのや。

OpenAIが特定の機械学習エンジニアリングツール用に作っためっちゃ難しいベンチマークやな。これから他の推論モデルもこのベンチマークで競争しようとするやろうな。これはいつもええことやと思う。

これで今日のThursdAIで話したかったことはほぼ全部やな。音声モデルの話をしとる間に触れられへんかったけど、Coquiがマルチモーダルモデルも始めたんや。

最近ElevenLabsを使ってへんけど、俺のプロジェクトにはCoquiを使っとるわ。彼らはポッドの友達で、何度もポッドに来てくれたんや。速度がめちゃくちゃ印象的で、今やマルチモーダルにもなったんや。

Quindが言うてたハッカソンにも参加するし、ショーノートにも追加しとくわ。サンフランシスコにおらんくても、リモートトラックがあるって聞いたやろ。俺に勝とうと思ったら、そっちで挑戦せなあかんで。でも、それ以外は以上や。

AIで2つのノーベル賞を受賞したことから話し始めたな。ジェフリー・ヒントンが受賞して、それからデミス・ハサビス、ジョン・ジャンパー、デイビッド・ベイカーが化学賞を受賞したんや。ジェフリー・ヒントンと、もう一人の名前を忘れたけど…ヤム、助けてくれへんか?

ヤム: ジェフリー・ヒントンとホップフィールドや。

アレックス: そうや、ホップフィールドが物理学賞を受賞したんや。これでショーを始めたんやったな。

それからオープンソースの更新について話したわ。特に、TXT 360から15兆トークンのコーパスを含む巨大なデータセットがリリースされたことを取り上げたんや。これはCommon Crawlや他のデータセットで構成されてて、特に重複排除されたものやな。arXivやWikipedia、PubMed、それにHacker Newsも含まれとるんや。コミュニティにとってはめっちゃすごい研究やな。

それからRhymes ARAについて言及したな。これは250億パラメータのマルチモーダルMoEモデルで、39億のアクティブパラメータだけになるんや。MoEで、マルチモーダルで、画像と動画を理解できて、Apache 2ライセンスでリリースされたんや。このチームはめっちゃ優秀で、6.5兆の言語トークンと400億のマルチモーダルトークンで学習されとるんや。PikstrやLlamaのマルチモーダルを超えて、複数のマルチモーダルタスクでGPT-4Vにかなり近づいとるんや。ARAからのリリースはめっちゃすごいわ。チームの人らと話せたらええなと思うわ。

新しい分散型アリーナについても話したな。DNアリーナっていうんやけど、MatrixとLLM 360が作ったもので、LLMアリーナとの相関を得ようとしとるんや。

Gradio 5がサーバーサイドレンダリングでリリースされたことも言及したし、Llama.fileが今はめっちゃええチャットインターフェースを含むようになったことも話したな。このワンファイルをダウンロードするだけでええんや。

それからビジョンと動画のカテゴリーでは、Metaが信じられんくらいすごそうな300億パラメータの画像とテキストから動画を生成するモデルを発表したんや。動画だけやなくて音声も生成するし、パーソナライズもできるんや。画像を提供して、その人物がその動画に出てくるようにできるんや。これはめっちゃすごいわ。

彼らはこれらのモデルをリリースせえへし、リリース日も発表されてへんけど、クオリティは本当に驚くべきものやな。ショーノートに追加しとくから、見てみてくれ。長くて高解像度の動画で、アスペクト比も違うんや。

Metaがメタバースに向かってる方向性について少し話したな。

それからPyramid Flowがオープンソース化されたことも言及したわ。これは今のところ最高のオープンソースの画像から動画生成モデルやと思うわ。完全に自分のデバイスで実行できて、10秒の動画を768ピクセルの解像度、24fpsで生成できるんや。これもめっちゃクールに見えるわ。

今週は、動画生成の分野でめっちゃ大きな更新があったし、自分のデバイスで実行できるオープンソースモデルも手に入ったんや。

それからOpenAIのリアルタイムAPIとオーディオについてかなり詳しく話したな。俺の反応を話して、Dailyの共同創業者のQuindを音声分野の専門家として招いて、そのAPIの複雑さや面白いところについて話したんや。俺の経験では、その会話は絶対に聞く価値があるわ。

Coqui、Play.ht、ElevenLabsがみんな音声を生成してて、Coquiが特に今週マルチモーダルで多言語対応になったことも言及したな。

今週のW&Bカテゴリーでは、Weights and BiasesがHEMっていうライブラリをリリースしたことから話し始めたんや。これはテキストから画像生成モデルのベンチマークを実行するためのものや。我々の評価基準に基づいて、どの画像生成モデルがより良いパフォーマンスを示してるかを見られる新しいリーダーボードもリリースしたんや。このリーダーボードにはWeights and BiasesのWeaveを使っとるんや。

それからCursorについての俺のスレッドについても話したな。チームの学んだことについてのスレッドがバイラルになってな。Cursorの応用や、我々が気づかなかったことについて話したんや。

触れられへんかったことがいくつかあるな。Inflectionがまだ生きてて、今は企業向けに行こうとしとるんや。ブログをリリースしたんやけど。

OpenAIのCanvasのアップデートについても触れへんかったけど、かなりクールやな。でも、Anthropicのアーティファクトとは全然違うもんやな。ちょっと違うもんや。

Reaから新しいマルチモーダルモデルもリリースされたな。Reca Flashっていう21Bのモデルで、動画とオーディオを送れるんや。これについても簡単に触れたかったんやけど、動画とオーディオをアップロードしたら、他のビジョンモデルが画像と動画だけなのに対して、これは完全なオーディオ付きのマルチモーダルモデルみたいやな。

最後に言いたかったのは、GitHub用のツールを見つけたことやな。UIthubっていうんやけど、これはどのLLM開発者にも役立つと思うわ。これについての動画も投稿したんや。

基本的に、どのGitHubのURLでも、GをUに置き換えると、そのレポにあるすべてのテキストファイルが1つのファイルになるんや。これはユーザーがコピペしてLLMに質問するのにめっちゃ便利やな。

こういうツールはいくつかあるけど、これが一番便利やと思う。GitHubのリンクのGをUに置き換えるだけで、出力として1つのテキストファイルが得られるんや。そのレポにあるすべてのテキストやコードやその他のファイルを連結したものやな。

だから、Geminiとかでめっちゃ長いコンテキストを簡単にダンプできるんや。UIthub.comっていうんやけど、めっちゃ面白くて素晴らしいツールやと思うわ。これを皆さんと共有したかったんや。

これで今週は終わりやな。みんな、ThursdAIに参加してくれてありがとう。先週ほど大きくはなかったけど、少し会話する時間を持てたと思うわ。

ああ、それとOpenAIから新しいMLEベンチマーク、機械学習エンジニアタスク用のMLEベンチマークについての速報もあったな。

これで終わりや。みんな、ThursdAIに参加してくれてありがとう。いつも通りめっちゃ楽しかったわ。ヤム、Wolfram、Nist、Quind、初めて参加してくれてありがとう。これからはポッドの友達や。観客の皆さん、友達の皆さん、Lincoln、ショーの準備を手伝ってくれてありがとう。

Eigil from Studioもありがとう。会話に参加してくれて。そして、聞いてくれてる皆さん、コメントしてくれてる皆さん、投稿してくれてる皆さん、毎週一緒に学んでくれてる皆さん、本当にありがとう。

Weights and Biasesにも感謝やな。しばらくの間ショーを共同ホストしてくれて、俺の大好きなことをさせてくれて。

これで終わりや。良い木曜日を。また来週ここで会おうな。バイバイ。

ショーの一部を聞き逃した人は、忘れんといてな。我々はポッドキャストもやっとるし、5つ星評価もあるんや。Spotifyかアップルで5つ星評価をくれたら、その評価を維持するのを手伝ってくれることになるで。我々はどこにでもおるし、エピソードは同じ日に投稿されるんや。俺はこれのために本当に頑張っとるからな。

ショーの一部を聞き逃したら、ポッドキャストを購読して、友達にも教えてな。バイバイ、みんな。

コメント