22,873 文字

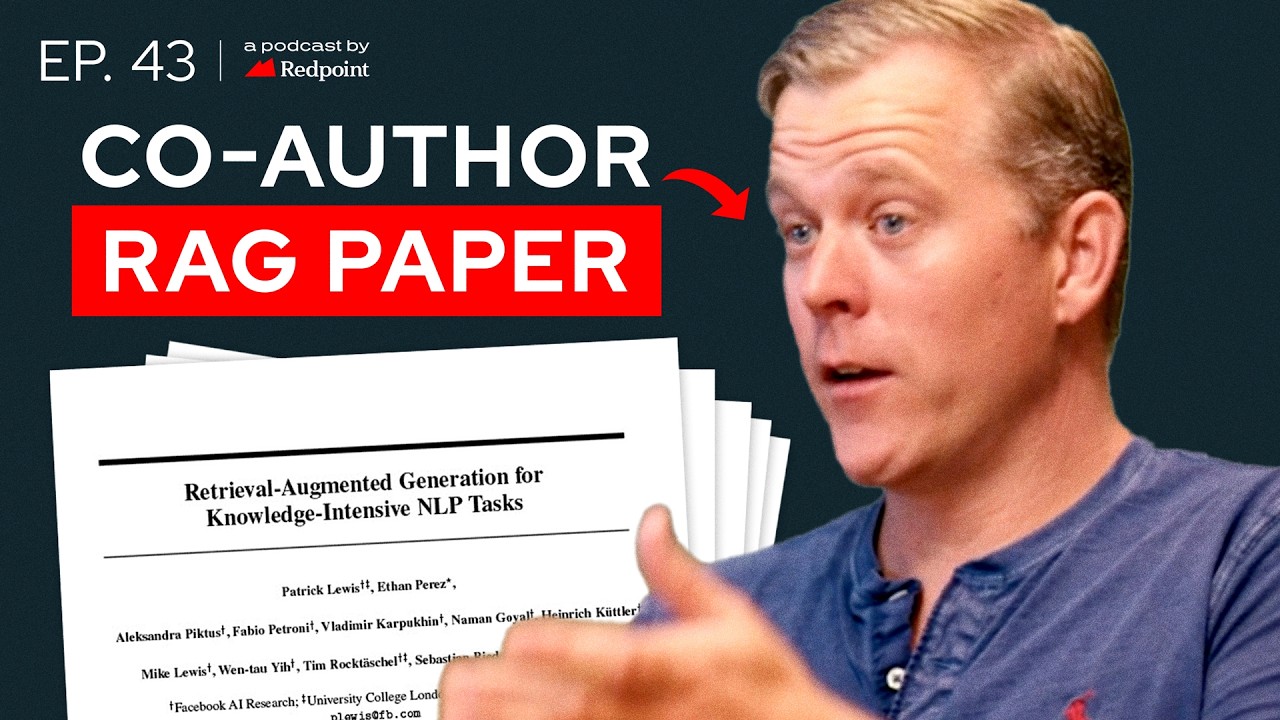

ダウ・キラは検索増強生成に関する最初の論文を書いた人物で、Contextual AIのCEOおよび共同創業者やねん。この会社は企業向けにカスタマイズされた文脈的言語モデルを構築するために、ほぼ1億ドルを調達してんで。ダはな、以前はHugging Faceの研究責任者やったし、Facebook AI Researchで5年間働いてたんや。スタンフォード大学の准教授でもあるし、Unsupervised Learningの完璧なゲストやったわ。事後学習のイノベーション、OpenAIの最新モデルo1に対する見解、一般的な推論、企業導入の障壁、注目している研究分野なんかについて話してもらったんや。このエピソードは皆さんにめっちゃ楽しんでもらえると思うわ。

ありがとうございます、来ていただいて。

はい、呼んでいただきありがとうございます。

o1のリリースの翌日に話しとるんやけど、まずそこから始めさせてもらってええかな。昨日のことについてどう思う?

そうやな、めっちゃワクワクする感じやと思うわ。この分野の多くの人が、テスト時の計算についてずっと考えてきたんやけど、今回のリリースで非常に重要な方向に進んでるのが面白いなと思うんや。モデルというよりシステムについて考えるっていう方向やね。

本質的にやっとることは、以前からあったChain of Thoughtのアイデアをモデルに圧縮して、RFを使ってそのモデルをより複雑なシステムに変えとるんや。特に推論に関してこれがうまくいくのを見るのはめっちゃ励みになるわ。

うちのチームもめっちゃ似たようなアイデアに取り組んでるんやけど、もっと検索の側に焦点を当ててるんや。システム思考をモデルに圧縮したり、少なくともシステム全体に対処できるようにしたりして、単に次の単語を予測するだけのモノにならんようにしとるんや。

こういうモデルが出てきた今、今後のモデルもこのアプローチを踏襲すると予想される?それとも必ずしもそうとは限らん?

そうやな、デプロイメントの遅延制約によって少し変わってくるんちゃうかな。テスト時にたくさん考えないかんようになると遅延が増えるから、常にベストってわけやないんや。AIのデプロイメントを考えるときには、いろんなトレードオフを考えんといかんのよ。

昨日のベンチマークを見てて面白かったのは、数学や法律なんかの特定の分野では明らかにパワフルになっとるけど、他の分野では古いモデルの方がまだ優れとるし、確実にずっと速いんや。

実際、UIがこの待ち時間の事実に基づいて構築されるのを見るのは面白いと思うわ。今回のモデルの待ち時間はそんなにクレイジーやないけど、将来的には何時間も待たされるモデルが出てくるかもしれへんやろ?特に長いコンテキストがあって複雑な推論をせなあかん場合は考える時間が増えるけど、それは人間でも同じやからな。

そうやな、人間でも同じやな。新しいモデルがリリースされたとき、あんたみたいなグルが何ができて何ができへんかを理解するのにどうするん?ベンチマークを見るんやろうけど、他にどんなことをする?

そうやな、主にベンチマークを見て、それから優秀なチームがおるから彼らに意見を聞くんや。これらのリリースに密接に従うのは常に大事やね。

うちにとっては、似たようなことを検索の分野で考えてきたことが励みになるわ。o1に含まれるアイデアの一部は、すでに他のモデルにも明示的に言わずに入っとったんちゃうかな。察してもらえると思うけど。

このアイデア自体はそんなに新しくないけど、いつものようにOpenAIの実行力には credit を与えんといかんな。素晴らしい仕事をしたと思うわ。

ほんまやな。Contextualについて少し話すええタイミングかもしれへんな。今日は掘り下げたい面白い角度がたくさんあると思うけど、まず最初に、他の基盤モデルのプレイヤーとは少し違うモデル構築の考え方で始めたんとちゃうかな。それがどういう経緯やったんか、会社を立ち上げる過程でどんなマイルストーンがその考え方に確信を与えてくれたんか、ちょっと話してもらえへんかな。

そうやな。会社を始めたきっかけは、企業が抱えるフラストレーションを見たからなんや。みんながジェネレーティブAIについて超興奮しとって、これで世界が変わるって言うとったんやけど、同時にまだ本番には全然準備できてへんかったんや。特に企業ではな。

RAGがこれらの問題の多くを解決する一つの方法になると分かっとったし、RAGよりもっとええものができるって分かっとったんや。

RAGを思いついたからそれが分かったんやな。

せやな、RAGを思いついたからや。でも、RAGは古いアイデアで、元々のビジョンは論文に載ったものよりもずっと野心的やったんや。Contextualで構築しとるのはその、もっと野心的なビジョンなんや。

OpenAIやAnthropicとどう違うかっていうと、2つの基本原則があって、それが違うんや。一つは「モデルよりシステム」っていう考え方や。OpenAIもシステムについて考えとるのは励みになるけど、彼らはまだ全部をモデルに圧縮しとるんや。うちは、モデルは問題を解決するもっと大きなシステムの10〜20%に過ぎへんと考えとるんや。

企業が買いたいのはシステムであってモデルやない。モデルを買ってそのまわりにシステムを構築せなあかんのは、すごく複雑で上手くいかへんのや。うちはそういうの得意なんや。

もう一つの違いは、うちはAGIを目指してへんことや。AGIは素晴らしいアイデアやと思うけど、根本的には消費者向け製品やと思うんや。消費者が本当に何を望んでるか分からへんから、汎用的な知能が必要になるんや。

でも企業では、ユーザーが何を望んでるかがはっきり分かっとることが多いし、むしろ汎用的であることを望まへんのや。特定のユースケースに特化してほしいんや。

最近、銀行との議論で出てきたんやけど、EUでは業績評価にAIシステムを使うのはめっちゃマズいんや。厳しい制裁を受けるんや。だから汎用AIをデプロイして、また全部制約をかけ直さなあかんのや。だから企業向けAIは汎用化じゃなく、特化が正しい考え方やと思うんや。

確かに、検索プロセス全体を大規模モデルの出力に直接結び付けて、同時に分離もしとるんやな。

そうや。システムアプローチと特化っていう要素があるから、本当にエンドツーエンドで全ての部分を特化できるんや。非常に統合されたシステムで、知識集約型の高価値なユースケースに特化してるから、統合度と特化度を上げることで本当に効果を発揮するんや。

エンドユーザーと話すと、インフラスタックの特定の部分を売ってる会社とか、「うちと他の8つのソリューションを組み合わせたらええで」って言う会社があるけど、そういう会社は結局「全部やってくれへん?」とか「この問題を解決するのを手伝ってくれへん?」って言われがちやと思うんやけど。あんたらが話す人たちにもそういう反応があるんとちゃう?

うちはむしろ逆のアプローチを取っとるんや。それはある意味スタートアップの常識に反してるんやけどな。普通は「この一つのことに特化して、それを本当にうまくやる」っていうアプローチを取るんや。そうするとレイヤーケーキみたいになって、それを使ってフランケンシュタインのRAGを作るんやけど、うちはそのケーキを縦に切ってるんや。

そうすることで、検索、再ランク付け、生成、事後学習、アライメント、ファインチューニングなど全てをコントロールできるから、問題解決がめっちゃ上手くなるんや。それが企業が本当に気にすることやからな。

企業サイドの話で言うと、killer product market fitがあるのは、コード生成、カスタマーサポート、内部検索やdocumentとのチャットみたいなものに見えるんやけど、あんたはもっと深いレベルで見とるはずやな。他にどんなパターンが実際にデプロイされとるん?

デプロイされとるものを見てると、まだまだデモが多いんや。うちは本番デプロイメントにのみ集中しとるんやけど、それは全然違うんや。まだまだフランケンシュタイン的なレイヤーアプローチで作られた魅力的なデモがたくさんあるんやけど、実際のユーザーテストになると完全に失敗するんや。

これは機械学習の側面だけやなくて、デプロイメント自体の問題もあるんや。リスクやコンプライアンス、セキュリティ、運用なんかもな。

デモはよく20個くらいのPDFで作られとるんやけど、テストセットに直接hill climbingしてるようなもんや。でもそれを10,000個のPDFに拡張したら、完全に崩壊するんや。

あんたはRAGに関する最初の論文の著者やったよな。今や誰もが知ってる標準的な方法になったけど、その研究はどういう経緯で始まったん?ちょっと話してくれへん?

いつも冗談で、RAGよりもっとええ名前を付けるべきやったって言うとるんやけどな。もっとキャッチーな名前やったら良かったんやけど。

もし選べるとしたら、どんな名前にする?

「contextual」って単語を入れたやつかな。

まさに会社名やな。

そうやな。そしたら会社名を変えなあかんくなるけどな。

どういう経緯やったかっていうと、ずっと基礎付けについて考えてきたんや。博士課程では言語と知覚情報の基礎付けについて研究してた。当時の初期のマルチモーダルシステムやな。例えば「猫」という言葉の意味をもっとよく理解するために、猫の画像を統合するみたいな感じや。

猫は常に重要やな。

そうや、そこから始まるんや。それからFAIRにおったとき、博士課程の学生やったイーサン・ペレスと一緒にこの基礎付けのことを考えとって、「Wikipediaで基礎付けをしたらどうや」って話になったんや。そこでRAGの最初のプロトタイプを作ったんや。

これが可能やったのは、主にFAISS(Facebook AI Similarity Search)チームの素晴らしい仕事のおかげやな。FAISSは最初のベクトルデータベースのアーキタイプやと思う。だからこのアイデアを試すのはめっちゃ簡単やったんや。

あと、検索メカニズムにバックプロパゲーションする方法を考えんといかんかったな。システムを実際にトレーニングできるようにするためにな。

将来的に多くの人が検索機にバックプロパゲーションせーへんって考えてへんかったな。難しすぎるから、みんな既製品を使うことになるとは。

このナイスなプロトタイプができたんやけど、残念ながらビザの問題か大学の理由で、イーサンはもうFAIRで一緒に働けへんようになってしまったんや。

そんで、ロンドンにパトリック・ルイスとセバスチャン・リードルっていう人がおって、オープンドメイン質問応答という、RAGのキラーユースケースに似たような問題に取り組んでたんや。そこで一緒にやることになって、めっちゃ素晴らしいコラボレーションが生まれたんや。FAIRでの黄金時代やったな。あの頃が懐かしいわ。その後はちょっと良くなくなったけど。

論文発表の時点で、これが標準的なパラダイムになるって明らかやったん?それとも「人々がこれをどう使うか見てみよう」くらいの感じやった?

正直、論文が出た時点でそれが明らかってのは嘘やと思うわ。Transformerの論文なんかがええ例やけど、その歴史は完全に書き換えられてるんや。

Transformer論文が出た時、FAIRではあんまり感動せーへんかったんや。ちょっとアホらしいと思ったくらいや。すでにアテンション付きのRNNがあったからな。「再帰をなくしたらより並列化できる」なんて、そりゃそうやろって感じやった。

実際、機械翻訳のベンチマークでもそんなにうまく行ってへんかったし、ほんのわずかな違いで、全部めっちゃ面倒くさかったんや。だから「なんでスライディングウィンドウアテンションとか畳み込みニューラルネットワークを使わへんのや」って思ったわけや。

FAIRの何人かは基本的に同じアイデアに取り組んでたんやけど、畳み込みのパラダイムを使ってた。それが数ヶ月後くらいに出たんやけど、あんまり評価されへんかったんや。

そんで、Googleが歴史を書き換えて、AIの革命を起こしたみたいな感じになったんや。これは歴史家がよくやる「偉人物語」みたいなもんやと思うわ。科学の歴史でも似たようなことが起こって、「偉大な論文」みたいな話になるんやけど、実際はそうやないんや。

同じ時期にめっちゃたくさんのことが起こっとって、これができるのは明らかやったんや。主に工学的な貢献、つまりこれをどうやってうまく動かすかってことが重要やったんや。Transformerがうまく行く理由は、それが素晴らしいからやなくて、GPUに最適やからなんや。

だからGPUがTransformerの理由であって、その逆やないんや。NVIDIAが全ての credit を受けるべきかもしれへんな。でも本当の credit は、アテンションメカニズムを発明した人たちに行くべきやと思うわ。それこそが、シーケンス間で情報を分散させる本当に画期的な新しい方法やったからな。

歴史はまだ書かれ続けとるからな。どの特定のポイントを振り返ることになるか、まだ分からへんな。多くの主要な発見について、同時に複数の場所で似たような work が行われとることが多いんや。微積分の話をしたけど、まさにそんな感じやな。

RAGの話に戻るけど、企業がよく来て「これこれこういうことをしたい」って17個くらい挙げてくるやろ?そんときに「この7つはええアイデアやけど、残りの10個は今のモデルじゃ絶対無理や」みたいな心の中のモデルがあると思うんやけど、今のモデルで何ができて何ができへんかについて、どんな考えを持っとる?

主に企業から聞かれるのは「これを顧客の前に出してもええか?」っていう質問なんや。うちはそれには慎重になるように言うとるんや。

ユースケースの価値が高くなればなるほど、顧客に直接さらすリスクも高くなるんや。だから企業が最適なAIと人間の比率を見つけるのを手伝って、人間をループに入れたまま、今すぐ解決できる問題に取り組むようにしとるんや。そんで時間をかけて、徐々に複雑にしていくんや。

最近は企業もかなり現実的になってきたと思うわ。うちが始めた頃の最初の会話では「投資申請のAIが欲しい。投資の決定をAIにさせたい」みたいなこと言う企業もあったんや。それはええけど、それができるようになったら教えてな。その時は他の仕事を探し始めるわって感じやな。

そんな簡単やないんや。具体的にすればするほどええんや。例えば投資家がより良い投資判断ができるような素晴らしいツールを提供するとか、そういうのがええんや。

そういう役割の人間を完全に置き換えるのは、まだまだ先の話やと思うわ。

あんたの仕事とContextualの大きな焦点の一つが、アライメントと強化学習に関する work やったよな。リスナーのために、その work について説明してもらえへんか?あと、その分野の進歩が早すぎて、いろんな改良があって、AIフィードバックからの強化学習(RLHF)とかDPOとか、頭字語のスープみたいになっとるやん。この1年間に何が起こったかをちょっと整理して、なんであんたらがここに焦点を当てることにしたんか、何をしてきたんか教えてくれへん?

アライメントはめっちゃ面白い問題領域やと思うわ。エンドユーザーにとって最大限有用なシステムをどう作るかっていう核心に迫るもんやからな。

ちょっと振り返ってみると、RLHFはチャットGPTを機能させた本当の秘密のソースやったんや。命令チューニングとかSFT(次のトークン予測)もあったけど、それだけじゃ人間の好みを十分に捉えられへんのや。

理想的には、次の単語レベルやなくて、シーケンス全体のレベルで捉えたいんや。そうするにはRLHFか類似の方法が正しい方法なんや。

でもRLHFには2つの大きな問題があるんや。一つは、報酬モデルを訓練せなあかんことや。そのモデルを使ってシーケンスに報酬を伝播させるんやけど、そのモデル自体がかなり良くなきゃあかんのや。だからめっちゃコストがかかるんや。そんでそのモデルは実際の生成では使わへんから、捨てるようなもんなんや。

もう一つの問題は、選好データが必要なことや。例えば、実際のシステムのデプロイメントで親指を下に向けられたとするやろ。「これは間違った答えや」って。そしたら、データアノテーション会社に行くか、社内の誰かに「親指を上に向けるとしたらどんな答えやったか」をアノテーションしてもらわなあかんのや。これは明らかに遅くてコストがかかるんや。

ユースケースが特化すればするほど、コストも高くなるんやな。

そうや。理想的には、この両方の依存関係を断ち切りたいんや。報酬モデルなしでできたら、ずっと効率的やろ?それがDPOの目的やったんや。

そんでContextualでは、スタンフォードの優秀な学生のCwinと一緒に、選好ペアへの依存を断ち切れへんかって考えたんや。データアノテーションせんでも、直接フィードバックを最適化できへんかってな。

それをKTO(Kantorovich-Fishburn Optimization)って呼んどるんや。行動経済学者の効用理論とプロスペクト理論にちなんでつけた名前や。Cwinのめっちゃ素晴らしい仕事やと思うわ。

最近、インターンのCarl と一緒に、さらに一歩進めたんや。アライメントの過少指定問題を調べたんや。これらの選好データセットの大きな問題の一つは、実際の選好シグナルが何かを理解するのが難しいことなんや。

ランダムに並べられた回答があって、「これはこれより良い」って言うだけやから、なんでそうなのかとか、根本的な因果構造がよく分からへんのや。

これをもっと厳密にする一つの方法は、修正を対比させることや。2つの選択肢を持つんじゃなくて、「これは選択肢やけど、何か問題があるから修正しよう」って言うんや。そんで「これはこれより良いけど、違いはほんのわずかで、その違いが修正や」みたいな感じにするんや。そうすると過少指定がずっと少なくなるんや。これをCLaRe(Contrastive Language Revision)って呼んどるんや。

CLaReを見てたら、データとモデルの間に面白い関係があることに気づいたんや。これは標準的なRLHFやDPO、KTOのパラダイムではあんまり捉えられてへんものなんや。

理想的には、選好データを訓練しとるモデルがどれくらい良いかを考慮に入れたいんや。最近では、モデルが選好データより良くなる可能性があるんや。ちょっと変な考えやけどな。

そういう場合、その選好データから「これが正解や」って学ぶんじゃなくて、「これはこれより良い」っていう情報だけを学びたいんや。まだ情報はあるんやけど、正しい情報を取り出したいんや。

モデルの質に基づいてこの「アンカリング」をすることを、Anchored Preference Optimization(APO)って呼んどるんや。これにめっちゃワクワクしとるんや。顧客のデータセットでこれがずっとうまく機能するのが見えるし、データセットの品質がモデルの品質にどう影響するかをもっとコントロールできるからな。

顧客のユースケースに対して、かなりの強化学習をしとるみたいやけど、実際どんな感じなん?人々にこれらをランク付けしてもらっとるん?データにラベル付けする人を雇っとるん?それとも外部の人を使っとるん?顧客とはどんな風に進めとるん?

うちには独自のデータアノテーションチーム、データエンジニアリングチームがおるんや。顧客とデプロイするときに、たくさんのフィードバックをもらうんや。親指を上下に向けるメカニズムがあって、うちのアルゴリズムを使えば直接そこから学習できるんや。標準的なRLHFのアプローチじゃできへんことやな。

でも正直、このアライメントの work の多くは、コアモデルに対して行われとるんや。事後学習の間にな。これも、アライメントが事後学習の大きな部分を占めとることの一つやと思うわ。

AIの魔法の多くは事後学習で起こるんや。「よし、この事前学習済みモデルができた。でも今からこれを本当に必要なことが上手くできるようにせなあかん」みたいな感じやな。

そうや。そんで、シェイクスピアのソネットを作ることと、ドライなカスタマーサポートの回答を与えることの両方ができるようにするんじゃなくて、一連のビジネスユースケースに合わせてアライメントしとるんや。

そのとおりや。いつも言うんやけど、AIを使いたいって、例えば金融で働いとるとするやろ。そのシステムが量子力学やシェイクスピア、日本の俳句について知ってる必要はないんや。その特定のことに本当に長けてる必要があるんや。それをアライメントで実現するんや。

もっと特化して、カスタマイズすることで、このアプローチを通じて本番環境のバーをもっと説得力のある形で越えられることが分かったんや。統合されたシステム、カスタムアライメント、特化、そういったもので、これらのデプロイメントから本当のROIを見ることができるんや。

めっちゃ面白いな。他の研究の話やけど、最近めっちゃパワフルな小さなMoEのオープンソースモデルをリリースしたよな。そのサイズのモデルやとデバイス上で動かせそうやし、全体的にデバイス上に移行する傾向があるように感じるんやけど。一つは、何がその work のきっかけになったんか、二つ目は、これから数年でその傾向がめっちゃ見られるようになると思うか教えてくれへん?

その work のきっかけは、ニコラスや。結局、人なんや。ニコラスはめっちゃすごいんや。これはAllen Instituteとのコラボレーションやけど、正直言うて、ほとんどの仕事は彼らがやったんや。うちがやったって credit は取らへんで。

でもな、高品質で完全オープンソースの混合専門家モデルがなかったんや。みんなが遊べるようなやつがな。それはめっちゃ大きなチャンスやと思ったんや。なんでかっていうと、全てがどんどん小さなモデルに向かっとる傾向が見えるからや。エッジデバイスにデプロイできる可能性のあるモデルな。

ニコラスは既にうちと一緒にGRIT(生成的表現命令チューニング)について素晴らしい仕事をしとったんや。GRITで初めて示したのは、検索と生成に同じモデルを使えるってことや。同じ重みを使うってことは、計算の多くをキャッシュできるってことなんや。

RAGシステムのことを考えてみ。クエリを基本的に2回エンコードせなあかんのや。一回は検索のステップで、もう一回は生成のステップでな。もしその計算を再利用して、パーツの組み合わせ方を考えられたら、めっちゃ効率的になるんや。

だから、わくわくしとるのは、ALLOYとGRITを組み合わせて、スマートフォンに置けるめっちゃパワフルなRAGシステムを作れへんかってことなんや。これ、めっちゃすぐに実現すると思うで。

あんた、こういうコラボレーションをようやっとるよな。それに、スタンフォード大学の准教授っていう別の顔もあるし、学術界で育ったわけやん。アカデミアの役割についてどう考えとる?明らかに、これらの研究所や企業から出てくる研究の多くは、伝統的には学術的な環境でやられてたと思うんやけど、スタンフォードの人々が何に集中すべきか、あんたみたいな企業が何をすべきか、その辺りどう考えとる?全体的にどうなっていくと思う?

アカデミアはAIの進歩にめっちゃ重要やし、これからもずっと重要やと思うわ。明らかに、アカデミアで行われる研究は変わってきとるけどな。

5年前のスタンフォードやったら、まだ大規模な事前学習を真剣に研究できたんや。当時の「大規模」は今とは全然違うけどな。今はスケールが全然違うから、同じスケールで完全なモデルを出すのはもう無理やねん。でも、小さなモデルを使えば、事前学習についてまだまだ面白い研究ができるんや。

でも、事後学習がめっちゃ重要になってきたのは本当にありがたいことやと思うわ。他の誰かが訓練した事前学習済みモデル、例えば元の雇用主のザッカーバーグが世界に寛大に寄付してくれたようなモデルを使って、そこから始められるんや。事後学習の方法やより良いアライメント方法について、めっちゃ素晴らしい研究ができるんや。

だから、アカデミアはこれからもAIの分野でめっちゃ重要な役割を果たし続けると思うわ。

企業側の話やけど、あんたらのやっとることの強みの一つは、このエンドツーエンドのソリューションやと思うんや。ギャップがないってことやな。でも、きっと「誰かがXを作ってくれたら、うちのエンドツーエンドソリューションにぴったりはまるのに」みたいな願望リストがあると思うんやけど、最近のトップリストは何?

めっちゃ長いウィッシュリストがあるで。最初は、既製品の抽出システムを使えると思っとったんや。でも、言語モデルを適切に文脈化するのがめっちゃ難しいんや。だから会社名がContextualなんやけどな。

言語モデルは、正しい文脈を与えさえすれば、ほとんどのことがめっちゃうまくいくんや。でも、どうやって正しい文脈を与えるんや?正しい検索と、より洗練された検索パイプラインがある場合はランキングもせなあかんのや。でも、抽出を正しくせんと、検索を適切にできへんのや。

PDFから情報を抽出するのがめっちゃ難しいってことが分かったんや。オープンソースにはええものがなかったから、自分たちでモデルを作らなあかんかったんや。これはパイプラインの始まりの部分やな。

一般化可能なシステムにするには、ちょっと退屈なことをたくさんせなあかんのや。それに、もう一方の端では、特に企業向けの評価がめっちゃ重要なんや。デプロイメントのリスクやシステムの本当の精度を理解するのがな。でも、企業が頼れるような正しい評価方法がまだないんや。

標準的な評価方法があればええんやけどな。近い将来、うち独自のアイデアを出すかもしれへんけど、これはまだまだ探求されてへん分野やと思うわ。

それって解決可能な問題なん?それとも結局、企業が何をしようとしとるかによって、めっちゃカスタムで特殊なものになるん?このポッドキャストに出た人の中には、「良い製品を作るには、最初に何をしたいかをはっきりさせることが大事で、それが基本的に評価セットを作ることになる」って言う人もおったけど、それはもっと特殊な感じがするな。でも明らかに、これを一般化しようとしてる人もたくさんおるし。

本当の問題の一つは、多くの人が自分が何を望んでるか分かってへんことやと思うわ。うちが顧客と関わるときは、「あなたが本当に望んでることは何?成功はどういう形なん?」ってことを見つけるのにめっちゃ時間をかけるんや。

それから一緒に、プロトタイプの段階でその成功を達成するために頑張って、それから本番化するんや。これが正しいやり方やと思うわ。

多くの人が評価を十分に真剣に捉えてへんのが心配やわ。どっかのスプレッドシートに50個くらいの例があって、めっちゃバラつきがあるだけで、全然原則的やないんや。

じゃあ、どの部分が顧客間で共通になるん?明らかに、みんなそれぞれ特殊な性質があると思うけど、少なくとも何か共通のツールセットやフレームワークを作れそうな気がするんやけど、それはどんな感じになりそう?

全部同じシステムなんや。まず、大規模なデータ、つまり数万から数十万の文書から情報を抽出せなあかんのやけど、失敗したらあかんのや。それから、その情報を何らかの検索メカニズムに入れるんや。

最近のデプロイメントでは、もう一つの検索機だけじゃなくなってきとる。うちは「混合検索機」アプローチって呼んどるんやけどな。それを基に、その情報で言語モデルを文脈化するんや。それから言語モデルの上でいろんなことをするんや。

コンポーネントはかなりはっきりしとると思うわ。みんなに共通する部分もあるけど、コンポーネント自体をもっと特化させて、コンポーネント間のつまみを調整して、全体をより最適化することで得られるものがまだまだたくさんあるんや。

今、評価がスプレッドシートでやられとるって話やったけど、数年後にはもっとうまくやれるようになってると思うんやけど、その時人々はどうやって評価すると思う?

うちが取り組んでて、めっちゃワクワクしとるアイデアの一つは、開発者が本当に必要としとるものは何かを考えることなんや。

AIの開発者の意味が時間とともに変わってきたって観察があるんや。昔は機械学習ができて、PyTorchのことをよく知ってる人みたいな感じやったけど、最近のAI開発者は、APIをうまく呼び出せる人っていう意味になってきとるんや。

評価の面でも似たようなことがあるべきやと思うんや。機械学習の従来の知識、つまりテストセットの作成や、二つのモデル間に有意な差があることを確認するための統計的テストなんかは必要なくなるんや。それは全部機械学習やデータサイエンスっぽいもので、これらのAPI AI開発者が使いたいものじゃないんや。

だから、開発者にとってアクセスしやすい評価フレームワークはどんなものかをめっちゃ考えとるんや。

なるほどな。ギアを切り替えて、あんたは長年この研究の最前線におったわけやけど、この1年で考えが変わったことってある?AIの研究に関する強い信念で、今は違う風に考えとることとか。

たくさんあるで。うちの仕事の一部は、何か起こったときにめっちゃ早く考えを変えることやからな。AIではたくさんのことが起こっとるし。

合成データがこんなにうまくいくとは予想してへんかったな。それは全然見えてこなかったわ。

エージェントも、エージェントを持つってことの定義がまだあいまいやけど、ツールを使うエージェント的なワークフローが、予想してたよりもずっと可能になってきとると思うわ。1年前に予想してたよりもな。

一般的に、このテスト時の計算みたいなのがな。Chain of Thoughtとかが出てきたとき、「ほんまかわいいギミックやな」って思ったんや。言語モデルに tips を与えたらもっとうまくいくようになるみたいな。

その work の多くは評価の観点からはめっちゃ欠陥があったと思うんやけど、でも多分、そういう貢献に対してちょっと学術的エリート主義すぎたんかもしれへんな。「ああ、それちょっとアホらしいな。本当のクールな機械学習の貢献やないやん」みたいな感じで。

でも実際にはめっちゃうまくいくんや。エコシステムがこれをいろんな角度から見て、エキサイティングな方法で組み合わせとるのはめっちゃええことやと思うわ。

最初の話に戻るけど、Chain of Thoughtをたくさん展開して、それをRLHFで訓練して、言語モデルか人間でそれを修正したら、もっとパワフルな言語モデルができるんや。テスト時に実際のシーケンスを展開するときは少し非効率になるかもしれへんけど、より良い答えが得られるんや。

ちょっと当たり前っぽく聞こえるかもしれへんけど、パーツ自体はそんなに特別に感じへんかったんや。これらのアイデアを組み合わせたときに、このナイスな効果が出るんや。

残念ながら、めっちゃ難しいデータの問題もあるんや。インターネットには、物事をステップバイステップで説明するようなものがたくさんあるわけやないからな。

そうやな。でも結局、言語モデルはステップバイステップで考えることがめっちゃ得意やってことが分かったんや。

合成データの話が出たけど、AGIへの道筋について、多くの人が「今あるトークンを使い果たしてる」とか「追加のデータをどこから得るんや」みたいなことを話してるように感じるんやけど、それについて心配しとる?それともそれは間違った考え方やと思う?

それはめっちゃ間違った考え方やと思うわ。誰かが一回そう言って、ジャーナリストがそれを取り上げて、「トークンが足りなくなってる」みたいな話になったんやと思うんやけど、全然分からへんわ。

社会として、毎日めっちゃたくさんのデータを生産してるんや。そのデータ全部で訓練できるんや。計算能力が、データを生産するよりも速く訓練できるレベルには全然達してへんと思うわ。

ただ、社会が生産するデータの全てが高品質ってわけやないんや。データの品質と量の間に面白いトレードオフがあるんや。品質が低ければ、比例してより多くの量が必要になるんや。

僕みたいな研究者に「何が足りへんの?」って聞かれたら、高品質なデータが足りへんって答えるやろうな。でも訓練に使えるデータはたくさんあるんや。ただ、そこから学ぶにはもっとたくさん必要になるだけや。

もう一つの観察は、これはテキストについては当てはまるかもしれへんけど、マルチモーダルの世界に行ったら、まだ表面も削ってへんのや。動画データはめっちゃ大量にあるんや。

「猫」の意味と猫の写真を見ることについて話したけど、巨大なマルチモーダルTransformerで猫の概念を本当に理解するために、どれだけの猫動画で訓練できると思う?これはまだ始まったばっかりなんや。

これは僕の博士課程のテーマやったんやけど、システムの大きな欠点の一つは、まだ我々の世界を理解してへんことなんや。我々と同じように世界を見てへんのや。インターネット上で我々が生成するテキストを通じて、間接的に観察してるだけなんや。でもそれはめっちゃ貧弱な代用品なんや。

もし実際にたくさんの猫動画を見れたら、人間が猫についてどう考えてるかをもっとよく理解できるんや。だからマルチモダリティは、もっとデータを追加する素晴らしい方法やと思うわ。

3つ目のポイントは、言語モデルを自分のデータで訓練しても機能せーへんって論文があったんやけど、その論文にはめっちゃ欠陥があるんや。実際の状況を全然反映してへんのや。これもまたPRのためのフラッグ立てみたいなもんやったんや。

そのせいで、めっちゃ面白い方向性がたくさん潰れてしもうたんや。人々が「ああ、これ面白くないな」って思って他のことに取り組み始めたり、おそらく合成データの会社が資金調達できへんかったりしたんや。データラングの会社はみんな喜んでそれをリツイートしとったけどな。

でも、合成データを正しくやれば、めっちゃパワフルなんや。それをKTOやAPOみたいなもっとスマートなアルゴリズムと組み合わせたら、データアノテーションも超計算集約的なこともせんでも、めっちゃ遠くまで行けるんや。

推論については、既に初期の兆候が見えとると思うんやけど、あんたにとってどんなマイルストーンが「よし、このモデルは推論能力を持っとる」って言えるもんなん?この波について何を期待しとる?

正直、モデルは既に推論能力を持っとると思うわ。しかも長い間持っとったんや。これが突然現実になったわけやないんや。OpenAIがそう見せたがっとるかもしれへんけど、これらのモデルはかなり長い間推論してきたんや。

これはめっちゃ面白いと思うわ。明らかに、まだ推論能力は向上できるし、それを実現する簡単な方法はたくさんあると思う。その多くはデータ駆動やな。

これは違う種類のデータやけどな。例えば、数学の博士課程の学生をたくさん雇って、めっちゃ複雑な推論を走らせたら、おそらくそこからめっちゃ学べるはずや。もしそのデータにめっちゃ投資したら、まだまだ改善の余地はあると思うわ。大手のAGI企業は全部そうしとると思うで。

マイルストーンはあるん?明らかに、イチゴのRの数を冗談半分で挙げとったけど、「このモデルがこれをできたらめっちゃすごいな」みたいなマイルストーンはある?

スタンフォードの博士課程の学生のTristanと一緒に書いた面白い論文があるんやけど、メタ言語テストについてのものなんや。イチゴの例に関連しとるんやけど、自己参照についてのものなんや。

「この文には X 個の単語がある」みたいな文があって、どんな X でそれが真になるかを理解するみたいな感じや。そういう自己参照的な文やな。

このデータセットを作って論文を書くのにめっちゃ楽しんだわ。「I am a Strange Dataset」っていう名前やねん。

ダグラス・ホフスタッターの「I am a Strange Loop」って本知っとる?めっちゃすごい人やねんけど、人間の意識は自分自身と自分の行動を認識した結果生まれるって主張しとるんや。我々が観察しとるこの物事がなぜそんな風に振る舞うのかっていう物語を作り出して、その奇妙なループが成長するにつれて意識になるんやって。めっちゃ素晴らしい理論やと思うわ。

人工的な意識を信じとるって言うてるわけやないで。でもこれらのシステムが実際にこういう問題を解決できたら、めっちゃ面白いと思うんや。数学があって、その上にメタ数学があって数学について推論する。これは今のシステムにはできへんことやと思うんや。たとえ数学自体が得意やったとしてもな。

だからこのデータセットでシステムがめっちゃ高いスコアを出したら、めっちゃ感心するわ。

めっちゃ面白いな。今起こっとる研究の中で、数年後に「これが本当にモデルの進歩を牽引したんや」って言えそうなことで、ちょっと報道が少ないものってある?

その多くはめっちゃ実用的な work やな。さっき話した混合検索機の話とかな。なんで一つの密なベクトルデータベースだけ使うんや?それは全然最適やないやろ?

少なくとも僕が興奮しとる work の多くは、本当に実用的で現実的な「これをどうやって実際に動かすんや」っていうことや。それから、AIの研究の多くに対して、正しい製品の形をどう見つけるかってことやな。

これは新しいパラダイムで、ちょっと変な感じやねん。昔のSaaSみたいに、顧客が何を望んでるか分かってて、それを作るだけっていうんとは違うんや。

もっと複雑な製品のパイプラインがあって、製品は基本的にモデルの振る舞いなんや。それはそのモデルに入ったデータを反映しとるし、もしかしたらそのデータを生成したモデルも反映しとるかもしれへん。これは製品についての全然違う考え方なんや。

プロンプトにちょっとした文を追加するだけで、めっちゃパワフルで影響力のあることができるのが面白いよな。それって伝統的に10倍のエンジニアが製品でやることとは全然違うけど、実際にはめっちゃ大きな影響を与えられるんや。

そのとおりや。

以前の雇用主の話に戻るけど、あんたはめっちゃ面白いところで働いてきたよな。FAIRから始めようか。ザッカーバーグがめっちゃたくさんのGPUを買って、それを世界に提供するってことは最初から明らかやったん?これからも続けられると思う?どう考えとる?

いや、うちらは全然GPUが足りへんかったわ。たぶん今でも働いとる人はGPU不足について文句言うとると思うわ。

FAIRはめっちゃすごいところやったわ。僕が入ったのは2016年で、FAIRが本気で始まってから1年くらいやったと思う。めっちゃ自由で学術的やった。ちょっと自由すぎたかもしれへんな。

僕はヴィトゲンシュタイン的な言語ゲームとか、マルチエージェントシステムが新しい通信プロトコルで話し合うようなことに取り組んどったんや。ちなみに、これら全部が今年か来年にまた戻ってくると思うわ。マルチモーダルの仕事をしとったけど、それが次に来るのはマルチエージェントシステムやと思うんや。

このシステムアプローチに関連しとるからな。ある時点で、そういうグループを持つと、この種の動的な環境を維持するのがめっちゃ難しくなるんや。そんで政治的なことが入ってきたりしてな。長期的にこの種の動的な環境を維持するのは本当に難しいと思う。

できるだけ長く維持しようとしたと思うし、めっちゃすごいことをやったと思うわ。RAGはかわいくて面白いけど、PyTorchは本当に世界を変えたんや。

FAIRはおそらく、そこで起こったことに対して十分な credit を受けてへんと思うわ。ザッカーバーグもこの種の賭けをする意欲があったことに対して、十分な credit を受けてへんと思う。なんでPyTorchを無料で提供するんや?なんでReactを無料で提供するんや?なんでLLaMAを無料で提供するんや?彼がやっとることは本当に先見の明のあるリーダーシップやと思うわ。

なんでLLaMAを無料で提供すると思う?その背景にはどんな考えがあると思う?

最近、他のポッドキャストの Acquired に出演しとったんやけど、めっちゃ面白い観察をしとったわ。プラットフォームについてな。

新しいプラットフォームが言語モデルや生成AIになるんやったら、他の誰かのプラットフォーム上でそれを提供せんでええようにすることがめっちゃ重要なんや。これはめっちゃ現実的な理由やと思う。

それに、彼らにとってめっちゃ大きな利益にもなるんや。僕がFacebookで働いとった頃、みんなFacebookを嫌っとって、「この邪悪な帝国」みたいな質問をめっちゃされたんやけど、突然みんながザッカーバーグをかっこいいと思うようになったんや。

戦争の神から変身したんやな。

そう、めっちゃクールになったんや。人々は、ここで起こっとる貢献を見て、採用の面でもめっちゃ助かっとると思うわ。本当にこの分野のトッププレイヤーの一つとして位置付けられるようになったんや。

また cool kids の仲間入りをしたってことやな。

そうや、やっとな。

FAIRにおった頃、マルチエージェントシステムの work をしとったって言うとったけど、それが今来そうな感じがするんや。いろんなアーキテクチャがあって、特定のことが得意なエージェントがあって、それらのエージェント間の調整や協力の仕方が問題になってきとるやん。

あんたは個人として30個くらいのエージェントを持っていて、それらを送り出していろんなことをさせるみたいな。それにどれくらい近づいとる?デモはめっちゃクールになりそうやけど、実際に製品化するのはめっちゃ難しそうやと思うんやけど、どう考えとる?

ある意味、既にそうなっとると思うわ。エージェントがあって、それらを互いに接続できるんや。機械学習の観点から見ると、合成データもエージェントについてのものやと思うわ。一つのエージェントが別のエージェントを訓練しとるみたいな感じやからな。

だから、これの多くは既に起こっとると思うわ。でも僕にとって、もっと広い観察は、これをモノリシックなモデルとして考えるべきやないってことなんや。システムとして考えるべきで、そのシステムは多くのモデルで構成されとって、それらのモデルが問題を解決せなあかんのや。これがマルチエージェントのセットアップなんや。

だから、ある意味既にそこにおるんや。ただ、まだそう呼んでへんだけやと思う。たぶん誰かの広報部門が、いつかこれについて大きな話題を作り出すんやろうな。

確かに、エージェントに協力させて正しくルーティングする方法を見つけるのには、いろんな問題があると思うわ。これは全然違う最適化問題やからな。

そうや。僕が考えとったのは、これらのエージェントが一緒に働くときに現れる新しい通信プロトコルが、人間も持っとるような面白い言語的な振る舞いを示すかもしれへんってことなんや。それがエージェントの構造の組織を反映しとるんやないかってな。

エージェントのトポロジー、つまりどのエージェントがどのエージェントとつながっとるかを見た、めっちゃクールな論文があるんや。みんなが互いに話し合うのか、それとも次のエージェントにだけ順番につながっとるのかで、全然違う方言みたいなものが生まれてくるんや。

企業内の仕事の構造や文化について、みんないつも議論しとるよな。

そうやな。これは文化に触れとるし、もっと長期的に見ると、人間もそういったマルチエージェントシステムのエージェントになると思うわ。そんで、他のエージェントが「これにはジェイコブを呼ぶ必要はない、他のこっちを呼ぼう」って決めるようになるかもしれへん。

うまいこと、あんたはまだこれらのエージェントを全部コントロールするCEOでおれるといいな。

あんたが働いとった他の場所としてHugging Faceがあるよな。Hugging Faceはいろんな場所でめっちゃクールな研究をしとるけど、このより広いエコシステムにおけるHugging Faceの将来の役割についてどう考えとる?

めっちゃ素晴らしい会社やと思うわ。僕にとって、Hugging FaceはFacebookとは全然違う経験やったんや。みんなFacebookを嫌っとったけど、みんなが愛する会社で働くのは全然違う経験やったわ。

Hugging Faceは本当に、いろんなものを公開する中心的な場所になったと思うわ。他のもっと伝統的な、例えばGitHubみたいなコードを公開する場所が、なんでもっと早くモデルの公開をせんかったんやろって思うわ。

実際、PyTorchでもモデルハブみたいなのを考えとったんやけど、うまくいかへんかったんや。ちゃんとリソースを割り当てられへんかったからやと思う。

でも、Hugging Faceはそこから特別な場所を作り上げたと思うわ。モデルを公開する場所になったんや。ある意味、ザッカーバーグのおかげで存在しとるようなもんやな。他の人たちもな。基本的に、他の人のオープンソースの努力で金を稼いどるみたいなもんやからな。

ここからどこに行くと思う?これがずっとHugging Faceの姿なんかな?それとも他に面白い方向性があると思う?これらのモデルをデプロイする場所になる可能性もあるよな。

いろんなクールな実験をしとると思うわ。基本的に、それをどこに持っていくかを考えとるんやと思う。

このショーには起業家がたくさん出演しとるし、リスナーにも多いんや。あんたは研究者としての素晴らしい経歴があって、めっちゃ面白い会社を作っとって、すごいエンタープライズのパートナーもおる。きっと、みんながあんたに投資したがっとると思うわ。

これは多くのAIスタートアップにも当てはまると思うんやけど、Contextualを運営してきた中で、どれくらいの資金を調達するべきかについてどう考えてきた?明らかに、めっちゃ大量の資金を調達してる人もおるし、あんたらもええ額を調達しとるけど、この旅の中でどう考えてきたん?

うちはこういうことについてめっちゃ現実的であろうとしとるんや。多くの会社が必要以上の資金を調達して、達成困難な評価額になっとるのを見るわ。

特に、AIのハイプサイクルが今後1、2年で少し落ち着く可能性が高いから、バランスを取ることが大事やと思うんや。うちはそこから大きな勝者として出てくるために計画を立てとるけど、多くの会社がそうなったときにめっちゃ苦労すると思うわ。

うちが調達した資金に関しては、はっきりした決断をいくつかしてきたと思うわ。自分たちで大きなベースモデルを訓練せーへんって決めたんや。ザッカーバーグがめっちゃ素晴らしいってわかっとるからな。

そのおかげで、うちはめっちゃ資本効率が良くなれるし、資本を他の必要なことに割り当てられるんや。例えば、素晴らしい人材を雇うことや、その人材が顧客と密接に協力して問題を本当に解決することにな。

市場には、AIの製品に関してめっちゃ混乱があると思うわ。なんで使い捨ての製品を持てへんのか、なんでデータを投げ込んだだけで全部うまくいかへんのかって思っとるんや。でもまだそこまでいってへんのや。

だから、CEOとして、うちがどうやって顧客に素晴らしい体験を提供できるかを考えんといかんのや。長期的には誰もが箱から出してすぐに使えるようなものになるけど、短期的にはもっと専門的なサポートが必要なんや。

いつも言うんやけど、うちは今、テスラ・ロードスターを売っとるようなもんや。高級スポーツカーで、運転するのがちょっと難しくて、ちゃんと調整せなあかんのや。だからうちは、車と一緒にメカニックやエンジニアも提供して、顧客が望むように走るようにしとるんや。

そのロードスターを売りながら、モデルSの組立ラインも作っとるんや。いつかは出てくるはずや。

モデルの改善が指数関数的に進んでて、モデルSが文字通り半年後に来るって考えとる?それともS字カーブに乗っとって、しばらくは停滞期があって、それから…明らかに長期的にはめっちゃ強気やと思うけど、1年後にはこれらのモデルは全然違うもんになっててGPT-4クラスのモデルを見返して笑うことになるって言う人もおるし、アルゴリズムのブレークスルーが必要やって言う人もおるけど。

うちはまだ始まったばっかりやと思うわ。でも、組立ラインから出てくるのは車やけど、それはモデルやなくてシステムやってことを指摘したいんや。

多くの人がまだスケーリング則について話しとるけど、ある時点で、もうスケールアップする必要がなくなるんや。他にもっと良くする方法がたくさんあるからな。

ある程度までスケールアップして、そのあとは事前学習のポイントの周りでたくさんの事後学習をする。それからChain of Thoughtみたいなことをして、それをモデルに戻して蒸留する。システム思考をモデルに戻すみたいな感じや。

そこからまだまだ得られるものがたくさんあるんや。だから、うちは多くの方向にスケールしとるんや。まだまだ面白いことがたくさん待っとると思うわ。

インタビューの最後はいつも、AIの世界で今日過大評価されとるものと過小評価されとるものを一つずつ教えてもらう早押しラウンドでしめくくっとるんやけど、あんたの意見を聞かせてくれへん?

過大評価されとるものと過小評価されとるもの、実はどっちもエージェントやと思うわ。ある意味、めっちゃ過大評価されとる。まだちゃんと機能してへんからな。でも過小評価もされとる。生命の兆しを見せ始めとるからや。それが最初に思い浮かぶのがエージェントやな。

Contextualを作る中で一番驚いたことは何?うまくいくと思ったけどうまくいかへんかったことの例とか、ランダムな実験やったらめっちゃうまくいったこととかある?

スタートアップに入ってへん人は、インフラ関係のことが簡単やと思っとるんや。「動くクラスターを持つ」みたいなことは当たり前やと思っとったんやけど、実際には高性能な研究クラスターを動かすのがめっちゃ難しいってことが分かったんや。

最新のLLaMAの論文を見ても、ハードウェア障害の頻度についての統計があるんやけど、GPUや全ノードを交換せなあかん頻度がめっちゃ高いんや。うちらが使っとる技術を構築するためのインフラが、思ってたよりもずっと気まぐれなんや。

これはどっちかを選ぶ質問やないけど、人々はクローズドソースとオープンソースのモデルについてよく議論するやん。長期的に見て、ほとんどのビジネスユースケースで主に使われるのはどっちやと思う?最先端のクローズドモデルか、それとももっと特化したオープンソースモデル?

ミックスやと思うわ。ちょっと偏った見方かもしれへんけど、いつも三角形で説明しとるんや。三角形の頂点には、最先端のクローズドソースモデルがあって、これらはフロンティアやけど、高価でもある。

三角形の底には、誰でもアクセスできるオープンソースモデルがある。三角形の真ん中が一番面白いところやと思うわ。ここで、企業の資本効率、顧客にとっての有用性、適切な価格でのサービス提供の間で、正しいトレードオフが得られるんや。

オープンソースから始めて、めっちゃすごい事後学習の能力があれば、その上にたくさんのことを積み重ねて、三角形の真ん中のスイートスポットに行き着けると思うんや。そこでは正しいトレードオフが得られるんや。

あんたの分野以外で、どのAIスタートアップに一番ワクワクしとる?

AIを使ったエンターテイメントがどんどん進化してるのにめっちゃ感心しとるわ。Suno(AI音楽生成)とか、動画生成の会社とかな。予想よりもずっと速く進んでるんや。

マイキーをポッドキャストに呼んだけど、Sunoは家族に見せたくなるようなクールなデモの一つやな。めっちゃ魅力的やし、動画の方もめっちゃクールやけど、まだ初期段階って感じがするな。

初期段階に感じるけど、予想よりも速く進んでるんや。そこからどうなるか想像できるやろ?10年後、もう一つの映画を見ることはなくなるかもしれへん。みんな自分だけの映画を見るようになるかもしれへんし、好きな番組の無限のエピソードを見れるようになるかもしれへん。ゲーム・オブ・スローンズの新しいエンディングを作って、それが実際に良いものになるかもしれへんな。

人類全員がそれに集中したら、誰かがもっとええのを思いつくかもしれへんな。

みんな自分に最適なものを手に入れるんや。既存のエンディングに満足する人はおらんのかもしれへんな。

そうやな、でも誰かはそれでええと思う人もおるかもしれへんで。番組の監督とかな。

Contextual以外で、もしあんたをどこかの会社のAI部門のトップに据えられるとしたら、どこが一番面白そう?

明らかな答えはあるよな。GoogleとかMetaとかやけど、僕が今取り組んでて一番興味があることを考えると、AIの本当にクールなところは、それを人々にとって本当に使えるプロダクトに変えることやと思うんや。

例えばJPモルガンみたいな会社のAI部門のトップを考えてみ。この素晴らしい技術を使って、彼らのAI部門のトップが解決せなあかんめっちゃすごい問題がたくさんあると思うんや。

これは40回目くらいのエピソードやけど、JPモルガンって答えが出たのは初めてやな。次の20回でも出てこーへんかもしれへんわ。

そうやな。でも、こういった伝統的な企業で、突然全てを変えるような新しい技術に出会って、他の誰よりも先にそれを理解できたら、めっちゃ大きなチャンスがあるんや。それがめっちゃワクワクすることやと思うわ。

もしContextualを運営せずに、AIアプリケーションを作るとしたら、どんなアプリケーションを作る?

たぶんエンターテイメント分野のなんかやと思うわ。それがめっちゃ面白そうやな。

正直、選ぶのはめっちゃ難しいんやけどな。うちにとっては、ほとんどの別の未来でもContextualに取り組んでると思うわ。仕事ってのはAIが全てを変えるのが一番明らかな場所やと思うからな。

うちの会社のミッションは、AIを通じて世界の仕事の仕方を変えることなんや。それをみんなにとってもっと良くできたら、それはめっちゃ高貴なミッションで、めっちゃ大きな影響があると思うわ。だから、ほとんどの別の未来でも、それに集中すると思うわ。

でも、このパーソナライズされたエンターテイメントのええところは、自分が100の違う会社をやってきた映画を作れることやな。そうすれば、別の未来も体験できるわけや。

めっちゃ面白い会話やったわ。話したことの多くの部分について、みんなもっと深く掘り下げたいと思うやろうな。最後に、あんたの研究やContextualについてもっと学びたい人はどこに行けばええ?どこか案内したいところある?

Contextual.ai やな。Twitter でフォローしてな。名前の綴りは難しいけど、探せば見つかるはずや。世界に僕と同じ名前の人は一人しかおらへんからな。

すごいな。最後に何か言いたいことある?

そうやな、うちらは今、目の前で世界が変わっていくのを見られるめっちゃすごい時代におると思うわ。世界の仕事の仕方が変わっていくんや。だから、これからみんなにとってめっちゃワクワクする時代が来ると思うわ。

ありがとう。めっちゃ面白い会話やったわ。

ありがとうございました。

コメント