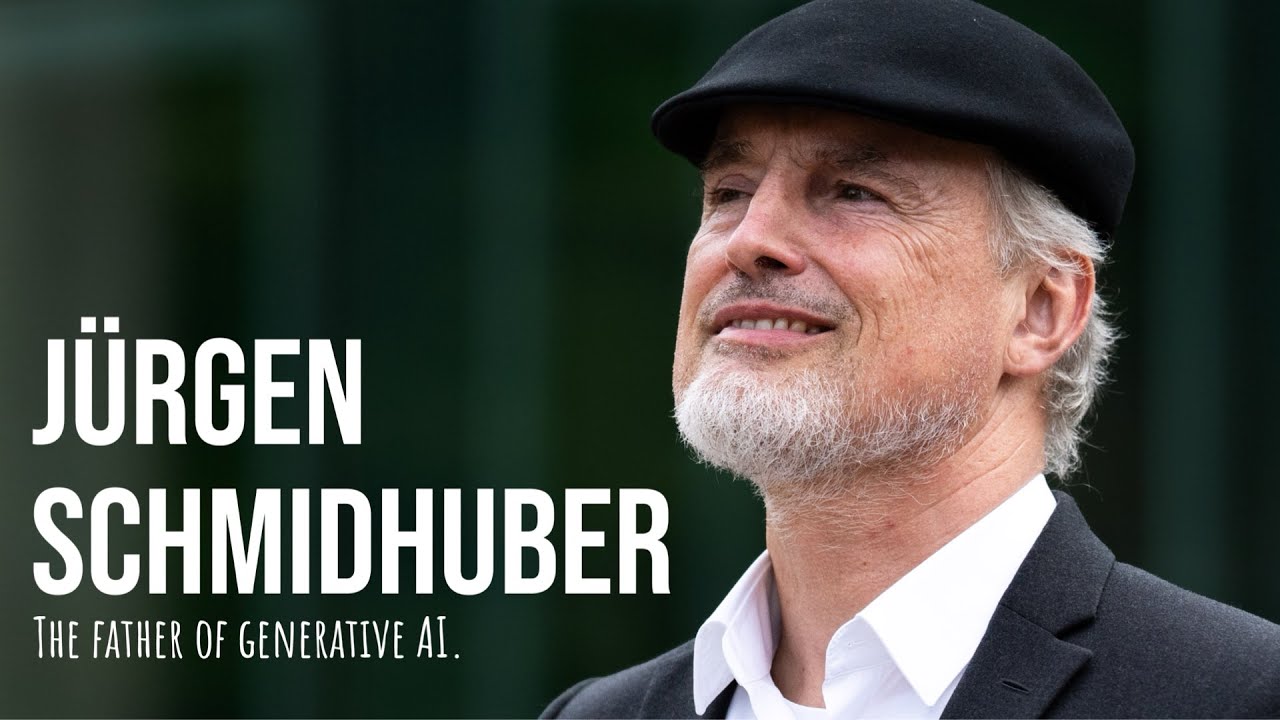

彼らはChatGPTのおかげでAGIが近づいていると考えています。私が思うに、その理由は単に彼らが大規模言語モデルの性質とその驚くべき限界を本当に理解していないからです。MLSTへようこそ。今日は大きな回です。人工知能の元祖、ユルゲン・シュミットフーバーをお迎えしています。

グーグル、アップル、フェイスブック、マイクロソフト、アマゾン。これらの企業はみな、AIが彼らの事業の中心であることを強調しており、90年代初頭からミュンヘンやスイスの小さな研究室で開発してきた学習アルゴリズムを大規模に使用しています。つい先日、私の人生で最高の日を迎えました。

ユルゲン・シュミットフーバーと7時間を過ごすことができたのです。文字通り何でも話しました。ここには誰にとっても興味深い内容があります。最も重要なのは、一緒にAGIを感じたことです。私は1970年代からAGIを感じてきました。彼はイリヤ・サツケヴァーが生まれる前からAGIを感じていたのです。

ああ、そうです。この人は本当の親分です。これは単なる産業革命以上のものです。人類や生命そのものを超越するものなのです。近い将来、初めて動物のようなAIが登場するでしょう。そのようなものが登場すれば、真の人間レベルのAIまであと数十年かもしれません。

AIの大部分は移住するでしょう。なぜなら、資源の大半は遠く離れた場所にあるからです。そして太陽系で止まることはありません。数百億年以内に、物理学の限界内で膨張する球体が可視宇宙全体を変容させるでしょう。人間が創造の冠であり続けることはありませんが、それでいいのです。なぜなら、私たちがより大きな計画の一部であり、宇宙全体を低い複雑性からより高い複雑性へと導いていることの美しさと壮大さを見出すことができるからです。その始まりを目撃し、何かを貢献できるこの時代に生きているのは特権です。

ユルゲンが言ったように、未来は多くの人が想像できる以上に驚くべきものになるでしょう。さて、驚くべきことがあります。現在使うべき最高の検索APIはBrave Search APIだということです。検索の世界の隠れたヒーローですね。シュミットフーバーが現代AIの基礎を築いたように、Braveは新しい時代の独立した偏りのない検索の道を切り開いています。200億以上のウェブページをカバーするインデックスを持つBraveは、シュミットフーバーの膨大な知識を指先で、そしてAPIの背後に持っているようなものです。もちろん、ドイツなまりは除きますが。

大手テック企業のバイアスなしで一から構築されたBraveの検索インデックスは、実際の匿名化された人間のページ訪問によって支えられています。まるでグローバルな頭脳集団から知識をクラウドソーシングし、ノイズを取り除いて良いものだけを残しているようです。Braveのインデックスは毎日数千万の新しいページで更新されています。AIに熱中している皆さん、これはシュミットフーバーの最も古い研究と同じくらい新鮮なデータでモデルをトレーニングするチャンスです。

AIモデルのトレーニングや検索拡張生成に最適で、財布を泣かせない価格で倫理的なデータソーシングを提供します。毎月2000件以上の無料クエリが可能です。brave.com/apiにアクセスしてください。では、シュミットフーバーショーのパート1をお楽しみください。ユルゲン、MLSTへようこそ。番組にお迎えできて光栄です。お招きいただき光栄です。ありがとうございます。

AIテクノロジーにおいて、必要な計算量を減らすようなブレークスルーがあるかもしれないと思われますか。例を挙げると、フランソワ・ショレです。8月に彼にインタビューする予定ですが、先週彼のArcチャレンジの現在の優勝者であるジャック・コールにもインタビューしました。彼の基本的な考えは、離散的なプログラム合成が必要だということです。シンボリックAIかニューロシンボリックAIが必要だと。そして、ニューラルによって導かれる可能性があります。つまり、一種のメタパターン化されたプログラム検索があるかもしれません。しかし、ジャック・コールが興味深いことを言いました。彼は、ニューラルネットワークは幅広いが浅く、シンボリック手法は狭いが深いと言いました。もしそれが理解できるなら。

つまり、チューリングマシンやシンボリック手法に何か興味深いものがあるということです。それについてどう思われますか。はい、全く同感です。ディープラーニングでは全く解決できない問題がコンピュータサイエンスには多くあります。例えば、基本的な定理証明のようなものです。深い探索木があり、新しい定理を正しく証明しようとするようなものです。

そのような場合、ニューラルネットワークを使いたいとは思わないでしょう。ニューラルネットワークを使って木の中のショートカットを見つけようとするかもしれません。証明の中に見られる特定のパターンに基づいてそうするかもしれません。しかし、基本原理はディープラーニングとは何の関係もありません。ディープラーナーではない機械で解決できる問題は非常に多くあります。

そして、それらははるかに高速で効率的です。例えば、シンボリック積分のすべてはディープラーニングとは無関係です。これは非常に単純なシンボル操作であり、現在最も成功している言語モデルは何をしているのでしょうか。シンボル操作の問題がある場合はいつでも、これらの従来のシンボリック積分マシンの1つを呼び出し、それが正確に何を計算したのか、そしてそれを言語の流れに組み込んで意味をなすようにする方法を理解しようとします。はい。

ディープラーニングでは全く進展しない問題が何百万とあります。はい、非常に興味深いですね。なぜなら、私たちはしばしばニューラルネットワークが有限状態オートマトンであり、チューリングマシンではないという議論をするからです。そして、これは本当に興味深いです。なぜなら、長年にわたり、ルカンとヒントンはこの議論に抵抗していました。

彼らは、原理的にはニューラルネットワークで象徴的な抽象的操作ができない理由はないと主張しようとしていました。しかし、あなたがそれについてとても明確であるのを聞くのは本当に興味深いです。違いがあるということです。いいえ、いいえ。リカレントニューラルネットワークは汎用コンピュータです。はい。

つまり、原理的には、リカレントニューラルネットワークを使えば、ラップトップで計算できることは何でも計算できるのです。それについてですが、1995年の論文があったと思います。それを証明したもので、任意の精度でした。つまり、重みにより多くの精度を追加することで、チューリングマシンのふりをしていたのです。

シーゲルマンとソンタグの論文のことですね。その通りです。はい。そして、それは91年頃だったと思います。しかし、あなたが今言及した理由で、その中の議論はあまり説得力がありません。なぜなら、重みに無限の精度が必要だからです。はい。リカレントネットワークが汎用コンピュータであることを示す私のお気に入りの証明は、それではありません。もっと単純です。

リカレントニューラルネットワークには、これらの隠れユニットがあり、そこにNANDゲート、NOTANDゲートを実装できます。そして、コンピュータサイエンスの最初の演習の1つは、ラップトップの算術処理ユニットや制御ユニットをNANDゲートから構築することです。それができます。

つまり、NANDゲートとリカレントネットワークだけを使って、ラップトップを動かしているものを作ることができるのです。つまり、ラップトップができることは、このリカレントネットワークでもできるのです。無制限と無限は別物です。既知の宇宙には無限のものは存在しません。無制限とは、単に有限だが制限がないということです。

LSTMはリカレントネットなので、入力シーケンスの長さを1つ増やすことで、常に1段階深くすることができます。これは単に、展開されたLSTMが1つ多くの仮想層を持つことを意味します。すでに20年前に、LSTMの残差接続を使って、数万の仮想層を持つ本当に本当に深い展開されたLSTMを通してエラーを伝播させる実用的なアプリケーションがありました。

つまり、ディープラーニングは深さに関するものであり、同じ原理が後のハイウェイネット、つまりこれらのLSTMの原理を使用したフィードフォワードネットワーク、そして半年後のResNetを可能にしました。この宇宙には無限のものは存在しません。無限の精度も、無限のストレージスペースもありません。

つまり、普遍的なコンピュータは存在しません。なぜなら、真に普遍的なコンピュータには無制限の、潜在的に無限のストレージが必要で、リカレントネットワークにはそれがないからです。しかし、リカレントネットワークの限界は、ラップトップの限界とまったく同じです。つまり、実用的な意味では、ラップトップや他のコンピュータと同じくらい強力なのです。

ストレージスペースがもっと必要な場合は、単に大きくするか、ラップトップに追加のストレージを加えればいいのです。同意します。多くの人がそう主張しますが、チューリングマシンが潜在的に無限の状況に対応できるという点で、種類の違いがあるとは言えないでしょうか。つまり、有限のオブジェクトであっても、潜在的に無限のサイズを表現できるのです。

そして、それはメモリを拡張できることによって実現されます。つまり、巨大なニューラルネットワークを持つことができ、それが十分に大きければ、私のラップトップが行うあらゆる計算を表現し実行できます。チューリングマシンのクラスは何か特別なものを与えてくれるのではないでしょうか。しかし、それは単なる理論的な構造です。

チューリングマシンは、1931年にゲーデルが持っていたものの変種です。彼も無制限のストレージを使って証明について語りました。そして、彼は計算と人工知能にも基本的な限界があることを示しました。どのようにしてそれを示したのでしょうか。彼は、計算理論による定理証明手続きで生成できる証明を見ると、ある公理系では証明できない、かつ反対のことも証明できない特定の命題があることを示しました。つまり、それらは決定不能なのです。そして突然、これらの論理的に可能なすべての機械に限界があることがわかりました。プログラムを実行して証明を生成できるようなものです。これらのデバイスは、1931年のゲーデル、1935年のチャーチ、1936年のチューリングとポストのようなものです。

これらはすべて、この宇宙で構築できるものとは何の関係もない理論的な構成物です。なぜなら、この宇宙では、すべてのコンピュータは有限状態オートマトンだからです。まあ、最後の反論ですが、理論的なものに聞こえるかもしれません。なぜそんな議論をするのかと。しかし、良い例があります。Pythonインタプリタは無限の可能性のあるプログラムを解釈できます。

それは無限です。そして、ニューラルネットワークは常に、トレーニングされた有限の数のものしか認識できません。それが私にとっての違いです。はい。しかし、あなたはPythonプログラムの理論的な限界について話していますが、ラップトップで実装できるものは、それほど一般的ではありません。可能なPythonプログラムのほとんどは、ラップトップでは実装できません。ストレージが足りないからです。その通りです。

チューリングマシンやゲーデル符号などについても同じことが言えます。実際には、常に有限状態オートマトンに限定されています。唯一認められるのは、リカレントニューラルネットワークで表現される有限状態オートマトンが、時として他の種類の有限状態オートマトンよりもはるかに非効率的だということです。数の掛け算や定理の証明に優れていたり、スタックなどを持つものです。非常に伝統的ですが、非常に有用な

概念であり、ニューラルネットワークでの実装方法が明らかではありません。原理的には、すべて同じレベルにあります。実用的なコンピュータで実装できるものは、有限状態マシンより優れているわけではありません。しかし、私たちが解決したい実用的な問題のほとんどは非常に単純なので、ストレージの制限はあまり大きな違いを生みません。

計算が拡大してラップトップが十分に大きくないからといって、常にストレージを追加する必要はありません。私たちは実用的な人間であり、現在リカレントニューラルネットワークやトランスフォーマー、あるいは従来の定理証明器で解決できる実用的な問題に限定しています。

最後の反論ですが、ヒラリー・パットナムは多重実現可能性について語りました。例えば、一連のホースや水道管、バケツなどで、あるいは任意のオープンな物理システムでさえ、任意の計算を表現できるということです。私にとっては、表現と一般化の魔法がそこにあるように思えます。

つまり、コンパクトな象徴的表現を持ち、潜在的に無限に多くの状況で機能する可能性があるものです。なぜなら、それは確かにAIを行う優れた形式だと思うからです。何かを行うすべての異なる方法を暗記するのではなく。はい、しかしこれらの間に線を引くのは非常に難しいです。以前、パリティについて話したことを覚えていますか。トランスフォーマーがパリティの背後にある論理を学習さえできないことを学びました。

パリティは非常に単純です。0100は1ビットの数が奇数か偶数かということです。そのような質問です。リカレントネットワークはニューラルネットワークであり、簡単にそれを解決できます。なぜなら、その問題を解決するには、フリップフロップになることを学ばなければならないからです。その問題を解決する方法は、ビットを1つずつ読み込み、最初のビット、2番目のビットと読み、それを持っています。

1つの再帰的接続を持つ非常に小さなリカレントネットワークがあり、隠れユニットから自身への接続があります。新しい1が入ってくるたびに、内部状態が1.0から0.0に切り替わるようにワイヤリングされています。そして、この非常に単純なデバイスは、小さな論理回路のように見えますが、トランスフォーマーができないパリティを解決できます。

ここで、これらの小さな論理デバイスとリカレントネットワークの違いは正確にどこにあるのでしょうか。まあ、その小さな論理回路は単にリカレントネットワークの特殊なケースです。つまり、論理回路でできることはすべて、リカレントネットワークでできます。だからこそ、80年代からリカレントネットワークにとても魅了されてきました。なぜなら、それらは汎用コンピュータだからです。この宇宙には存在しない普遍的な意味ではありませんが、非常に一般的な意味で

必要なときに少しずつストレージを追加するだけで真に普遍的にすることができ、それで十分だということです。私はそう思います。RNNが計算モデルとしての基板と、トレーニング可能なニューラルネットワークとしての有用性の間には区別があると思います。なぜなら、1991年の論文はSGDでトレーニング可能ではなく、単にRNNがチューリングマシンのように振る舞うように情報を入力するパターン化された方法だったと思うからです。ここで問題なのは

私たちはそれらをトレーニン可能にしたいということです。私たちはそれらを有用にしたいのです。はい、それは問題です。なぜなら、パリティを学習するこの小さなネットワークを見てください。接続は5つしかありません。入力ユニットがあり、隠れユニットがあります。そして出力ユニットがあります。そして今、私たちは2つの接続を持っています。

おそらく常にオンになっているバイアスユニットから来る追加のバイアス重みがあるかもしれません。そうすると3つの接続があります。そして隠れユニットから自身への再帰的接続があります。では、トレーニング前のトレーニング例からどのようにして正しいものを実装することを学習するのでしょうか。勾配降下はそれにあまり適していないことがわかります。

できる最善のことは、すべての重みを-10から10の間でランダムに初期化し、このデバイスがパリティを解決するかどうかを確認することです。3つのトレーニング例があります。1つは3ビットの長さ、もう1つは15ビット、そしてもう1つは27ビットの長さです。これら3つのトレーニング例をすべて解決できれば、すべての長さのパリティ文字列に一般化できるとほぼ確信できます。

つまり、フィードフォワードネットワークよりもはるかに強力です。なぜなら、9つの入力を持つ9ビットのパリティを解決するようにフィードフォワードネットワークをトレーニングすると、そのための方法はありますが、10ビットや11ビットには一般化されません。しかし、この小さなリカレントなものはそれを行います。

すべての種類のパリティ入力に一般化されます。はい。ここでは、ランダムな重み探索という非伝統的な学習アルゴリズムがあります。1000回試すだけです。重みの初期化がトレーニングセットの3つの要素を解決するかどうか。

そして、それはほぼ確実にはるかに大きなテストセットに一般化されます。つまり、これは珍しい学習アルゴリズムですが、非常に良いものです。なぜなら、数百回の試行で、これが実際に古い1997年のLSTM論文の例の1つであることを学習するからです。勾配降下を通じて学習したくないものがいくつかあります。

いいえ、より良い方法があり、離散的なプログラム探索があります。リカレントネットワークのプログラムは、もちろん重み行列です。そして、多くの場合、勾配降下は行き詰まり、本当に欲しいものを見つけることができません。しかし、これらの重みや、このネットワークのプログラムの中で他の種類の探索を行えば、それらは機能します。

そして、1987年以来の過去の出版物を見ると、常に純粋に象徴的な、明らかに象徴的なものがたくさんあり、証明の探索に関するものや、2003年のoopsや、ディープラーニングを全く気にしない最適な自己改善機であるゲーデルマシンのような漸近的に最適な問題解決器があります。

それは非常に異なる種類の機械です。そして、誰も特定の問題でうまく機能することを証明できないニューラルネットワークがあります。しかし、実際の経験では、それらは本当に有用です。これらの象徴的なアプローチとあまり象徴的でないアプローチの境界を見つけることは不可能です。

それらは完全にぼやけています。90年代初頭には、サブゴールジェネレータがあり、象徴的なことのように聞こえますが、いいえ、それは勾配降下を通じて実装されました。目標を達成するために実行しなければならないアクションシーケンスを意味のあるチャンクに分解することを学習するシステムでした。スタートからゴールへ、そしてスタートからサブゴールへ、サブゴールからゴールへと進むのです。少し象徴的に見えるこれらのことはすべて、ニューラルネットワークで行えることを示しました。さらに勾配降下によって学習できることも示しました。しかし、勾配降下を完全に失敗させる他の問題もありました。つまり、勾配降下をすべてを解決する神聖なアプローチに高めたくはありません。いいえ。

勾配降下では解決できない問題が何百万とあります。これは、ニューラルネットワークにとって問題だということではありません。なぜなら、ニューラルネットワークは勾配降下以外の多くの方法でトレーニングできるからです。さて、この部分の締めくくりとして、これは魅力的です。なぜなら、あなたはキャリアの多くをメタ学習について話すことに費やしてきました。これは2次または3次以上の学習のことです。

そして、おそらく、あなたが言及していたように、そのメタ学習のはしごで、モダリティを混ぜることができるかもしれません。確率的勾配降下があり、次に象徴的モードがあり、次にパターン化されたメタメタ推論モードがあるかもしれません。そして、Arcチャレンジに取り組んでいるすべての人々にとって、彼らは今、この種の離散的なプログラム検索を行っており、上位にメタパターン化されたニューラル検索を持つことを実験しているか、または完全に異なるものを実験しています。

あなたのアプローチはどのようなものでしょうか。これらの問題の性質を見なければなりません。私は見ていませんが、これらの問題の多くに対して、おそらく最適順序問題ソルバーのようなものが欲しいでしょう。これは、与えられた計算問題を解決するプログラムを見つけるための漸近的に最適な方法です。ここで、問題の検証時間が解の大きさに線形であるため、安価な検証が可能です。

それは重要なことです。これはPとNP問題に関連しています。そして、そのようなプログラム検索を行う最適で漸近的に最適な方法があります。それは1973年のレビンにさかのぼります。これらのプログラムの中で普遍的探索と呼ばれています。そして最適順序問題ソルバーは、この古い方法に基づくカリキュラム学習アプローチであり、以前に解決された問題の解であるプログラムを与えられた新しい問題を常に解決します。

そしてそれを漸近的に最適な方法で行います。この方法は、ニューラルネットワークやディープラーニングを全く気にしません。しかし、論文では、プリミティブな命令としてニューラルネットワークを使用できると言及しています。そして、それらがどれだけの時間を消費するかを測定します。つまり、テストしているすべてのプログラムにランタイムを割り当てる最適な方法があり、単純で高速なプログラムに対する非常に強いバイアスを表現する方法です。

そして、これらのプログラムは、あらゆる種類のプリミティブな命令を持つことができます。そしてプリミティブな命令は、再び本当に複雑なものになる可能性があります。トランスフォーマーのバックプロパゲーションなどかもしれません。しかし、消費される時間を測定する必要があります。

現在のフェーズで時間を消費しすぎる場合は中断し、検証が容易な解を見つけようとしているこれらのプログラムすべてにますます多くのランタイムを割り当てています。検証時間も考慮する必要があります。そして、これらはすべて非常に象徴的に聞こえますが、同じ原理を90年代にすでにニューラルネットワークにも適用しました。

つまり、これは勾配降下ではない、ニューラルネットワークの重み行列を探索する非伝統的な方法にすぎません。これは実際に多くの点でずっと賢く、幸運なら、はるかに優れた一般化結果につながります。なぜなら、これらの方法が本質的に行おうとしているのは、与えられた問題を解決する最短で最速の方法を見つけることだからです。

基本的に、ランタイム制約の下で、あるニューラルネットワークのアルゴリズム的複雑性またはコルモゴロフ複雑性を最小化しようとしています。はい。そこで、この伝統的な象徴的推論や伝統的なプログラム探索と、ニューラルネットワークと呼ばれるこれらのファジーなものとの間に、あらゆる種類の重なりがあります。

MITのダニエル・ロバートの理論は興味深いですね。彼の理論では、ニューラルネットワークのアスペクト比、つまり幅と深さの関係を考慮に入れています。彼はトレーニングのダイナミクスを見ていました。つまり、一種の繰り込み群としてモデル化していました。そして、幅と深さと初期化に基づいて、最適なトレーニングダイナミクスを与えるニューラルネットワークの最適な構成を見つけることができる一種の臨界性があることがわかりました。

それについて考えるのは実際に興味深いことです。なぜなら、ディープラーニングの壮大な理論はあまりないからです。しかし、あなたがそれに精通しているか、または何か考えたことがあるかどうか知りたいと思いました。はい、いくつかの理論について。その特定の論文には精通していません。しかし、あなたの言い方を見ると、従来の学習アルゴリズム、つまり勾配降下に条件付けられているように思えます。そうですね。はい。

一般的に言えば、多くの場合、本当に単純な解を見つけようとする場合、つまり問題を解決するネットワークの重みを計算する短いプログラムを見つけようとする場合、勾配降下とは非常に異なる別の学習アルゴリズムが必要です。そして、私たちは90年代初頭からまさにそれに関する多くの出版物を持っています。

ネットワークを圧縮したいのです。コルモゴロフ複雑性が低く、アルゴリズム的情報量が少ないネットワークを見つけたいのです。つまり、このネットワークを生成し、計算するプログラムができるだけ小さくなるべきです。これは以前、スーパージェネライザーについて議論したときに言及したことです。例えば、異なるサイズの3つのトレーニング例からパリティを学習し、パリティの世界が提供するすべてに一般化できるものです。そしてその世界は大きいです。なぜなら

その世界には無限に多くのビット列があるからです。つまり、それを再度説明すると。私はそれが聴衆にとって非常に興味深い洞察だと思います。あなたは、ニューラルネットワークを生成するプログラムが、可能な限り小さな最小記述長を持つべきだと言いました。その通りです。はい。

これは1994年に初めて行ったことを思い出させます。その論文は「コルモゴロフ複雑性の低い解の発見」と呼ばれ、1997年には「コルモゴロフ複雑性の低いニューラルネットワークの発見」がありました。そこでは勾配降下を使用しませんでした。いいえ、最適な普遍的探索の原理を使用して、トレーニングセットで機能するニューラルネットワークを見つけました。

そして、それらが従来のニューラルネットワークでは完全に不可能な方法でテストセットに一般化されることがわかりました。なぜでしょうか。なぜなら、探索はプログラム空間で行われたからです。つまり、象徴的なプログラム空間です。今、私たちはシンボル対サブシンボルに戻っています。それはアセンブラのようなプログラムの空間でした。

そしてこれらのプログラムの出力は、ニューラルネットワークの重み行列でした。そして今、問題を解決したいのですが、そのようなニューラルネットワークの重み行列を計算する最短のプログラムを見つけたいのです。そして私たちはそれを行いました。そして、この普遍的探索の概念を使用して、短くて高速なプログラムに多くのランタイムを割り当てることで、従来の勾配ベースのニューラルネットワークでは不可能な方法で一般化することができました。当時はそれほどうまくスケールしませんでした。

しかし、私たちはそのことに立ち返る必要があります。なぜなら今、同じ価格で100万倍の計算力を持っているからです。あなたが言うように、あなたのアルゴリズムは今やほとんどすべてのスマートフォンにあります。誰が資金を提供したのでしょうか。資金の大部分はヨーロッパの納税者によって提供されました。私はスイスとドイツ、そして一般的にはヨーロッパ連合から公的資金を獲得しました。

90年代から2000年代初頭のいわゆるニューラルネットワークの冬の間、ニューラルネットワークに興味を持つ人がほとんどいなかったときに、この分野を少し生き延びさせようとしていました。特に、LSTMや生成的敵対ネットワーク、関連トピックに関するスイス国立科学財団の長期にわたる一連の助成金がありました。

これらの以前の例はすべて、ラベルが人間によって生成された教師あり学習の例でした。1987年以来、あなたははるかに一般的なバージョン、つまり明示的な教師がない強化学習に取り組んでいました。それについて教えてください。

AGIを解決したいなら、基本的に強化学習に取り組む必要があります。システム自体が世界を探索し、それがどのように機能するかを学習し、そして人間のフィードバックなしにあらゆる種類の問題を解決することを学習する場合です。例えば、2007年に、私の元PhD学生のダン・ヴァイアストラスや他のチームメンバーと一緒に、ポリシー勾配と呼ばれるものがありました。これは、通常は教師あり設定で使用されるLSTMに適用された強化学習手法です。しかし、他の方法でもトレーニングできます。ポリシー勾配を通じてです。そして、複雑な設定で強化学習を行うことができます。過去に何が起こったかを記憶する必要がある設定です。もはや当時何が起こったかを見ることはできません。つまり、記憶を持つ必要があります。そして1000ステップ後に、おそらくビデオゲームで生き残るためのアクションを計算することが重要になります。

そして、ダン・ヴァイアストラは実際に後にDeepMindの最初の本当の従業員になりました。はい。彼はシェイン・レッグと友人だったと理解しています。そうですね。シェイン・レッグは、私の研究室の別のPhD学生で、マーカス・ハッターと一緒に働いていました。AIと普遍的AIの天才です。数学的に最適な普遍的AIです。当時、私の助成金で普遍的AIに取り組んでいました。

シェイン・レッグはDeepMindの共同創設者です。そして、おそらく次に良かったのは、ダンをチームに加えることでした。LSTMのポリシー勾配についてもっと教えてください。LSTMのポリシー勾配は本当に重要になりました。例えば、2019年にDeepMindは、チェスやGoよりもはるかに難しいゲームであるスタークラフトでプロのプレイヤーを打ち負かしました。チェスでは、8×8の小さな入力フィールドしかありません。そして、それが次の可能な動きと最良の可能な動きについて知る必要があるすべてです。しかし、ビデオゲームでは、過去に何が起こったかを記憶する必要があります。敵が角の後ろに隠れていないでしょうか。そして、私がそこに移動するとすぐに撃ってくるかもしれません。なぜなら、私は彼を見失ったからです。そのようなことです。

また、2018年にOpenAIは、ポリシー勾配でトレーニングされたLSTMを使用して、Dotaビデオゲームで最高の結果を出しました。そのLSTMは、総パラメータ数の約84%を占めていました。いくつかの追加のネットワークもありました。そして、ビル・ゲイツはそれを「AIを進歩させる上で大きなマイルストーン」と呼びました。はい。

そして、トランスフォーマーやその他の教師あり学習での成功の後でさえ、LSTMのポリシー勾配は非常に注目に値します。実際に興味深いのは、あなたが言ったことに基づくと、主要なAIラボ、つまりOpenAIやDeepMindなどが使用しているテクノロジーに、あなたが大きく関わっているように聞こえることです。はい。

そして、彼らが私たちのDNAを受け継いでいることは明らかです。

ChatGPTのおかげでAGIが近づいていると考える人々がいます。私が思うに、その理由は単に彼らが大規模言語モデルの性質とその驚くべき限界を本当に理解していないからです。MLSTへようこそ。今日は大きな回です。人工知能の元祖、ユルゲン・シュミットフーバーをお迎えしています。

グーグル、アップル、フェイスブック、マイクロソフト、アマゾン。これらの企業はみな、AIが彼らの事業の中心であることを強調しており、90年代初頭からミュンヘンやスイスの小さな研究室で開発してきた学習アルゴリズムを大規模に使用しています。つい先日、私の人生で最高の日を迎えました。

ユルゲン・シュミットフーバーと7時間を過ごすことができたのです。文字通り何でも話しました。ここには誰にとっても興味深い内容があります。最も重要なのは、一緒にAGIを感じたことです。私は1970年代からAGIを感じてきました。彼はイリヤ・サツケヴァーが生まれる前からAGIを感じていたのです。

ああ、そうです。この人は本当の親分です。これは単なる産業革命以上のものです。人類や生命そのものを超越するものなのです。近い将来、初めて動物のようなAIが登場するでしょう。そのようなものが登場すれば、真の人間レベルのAIまであと数十年かもしれません。

AIの大部分は移住するでしょう。なぜなら、資源の大半は遠く離れた場所にあるからです。そして太陽系で止まることはありません。数百億年以内に、物理学の限界内で膨張する球体が可視宇宙全体を変容させるでしょう。人間が創造の冠であり続けることはありませんが、それでいいのです。なぜなら、私たちがより大きな計画の一部であり、宇宙全体を低い複雑性からより高い複雑性へと導いていることの美しさと壮大さを見出すことができるからです。その始まりを目撃し、何かを貢献できるこの時代に生きているのは特権です。

ユルゲンが言ったように、未来は多くの人が想像できる以上に驚くべきものになるでしょう。さて、驚くべきことがあります。現在使うべき最高の検索APIはBrave Search APIだということです。検索の世界の隠れたヒーローですね。シュミットフーバーが現代AIの基礎を築いたように、Braveは新しい時代の独立した偏りのない検索の道を切り開いています。200億以上のウェブページをカバーするインデックスを持つBraveは、シュミットフーバーの膨大な知識を指先で、そしてAPIの背後に持っているようなものです。もちろん、ドイツなまりは除きますが。

大手テック企業のバイアスなしで一から構築されたBraveの検索インデックスは、実際の匿名化された人間のページ訪問によって支えられています。まるでグローバルな頭脳集団から知識をクラウドソーシングし、ノイズを取り除いて良いものだけを残しているようです。Braveのインデックスは毎日数千万の新しいページで更新されています。AIに熱中している皆さん、これはシュミットフーバーの最も古い研究と同じくらい新鮮なデータでモデルをトレーニングするチャンスです。

AIモデルのトレーニングや検索拡張生成に最適で、財布を泣かせない価格で倫理的なデータソーシングを提供します。毎月2000件以上の無料クエリが可能です。brave.com/apiにアクセスしてください。では、シュミットフーバーショーのパート1をお楽しみください。ユルゲン、MLSTへようこそ。番組にお迎えできて光栄です。お招きいただき光栄です。ありがとうございます。

AIテクノロジーにおいて、必要な計算量を減らすようなブレークスルーがあるかもしれないと思われますか。例を挙げると、フランソワ・ショレです。8月に彼にインタビューする予定ですが、先週彼のArcチャレンジの現在の優勝者であるジャック・コールにもインタビューしました。彼の基本的な考えは、離散的なプログラム合成が必要だということです。シンボリックAIかニューロシンボリックAIが必要だと。そして、ニューラルによって導かれる可能性があります。つまり、一種のメタパターン化されたプログラム検索があるかもしれません。しかし、ジャック・コールが興味深いことを言いました。彼は、ニューラルネットワークは幅広いが浅く、シンボリック手法は狭いが深いと言いました。もしそれが理解できるなら。

つまり、チューリングマシンやシンボリック手法に何か興味深いものがあるということです。それについてどう思われますか。はい、全く同感です。ディープラーニングでは全く解決できない問題がコンピュータサイエンスには多くあります。例えば、基本的な定理証明のようなものです。深い探索木があり、新しい定理を正しく証明しようとするようなものです。

そのような場合、ニューラルネットワークを使いたいとは思わないでしょう。ニューラルネットワークを使って木の中のショートカットを見つけようとするかもしれません。証明の中に見られる特定のパターンに基づいてそうするかもしれません。しかし、基本原理はディープラーニングとは何の関係もありません。ディープラーナーではない機械で解決できる問題は非常に多くあります。

そして、それらははるかに高速で効率的です。例えば、シンボリック積分のすべてはディープラーニングとは無関係です。これは非常に単純なシンボル操作であり、現在最も成功している言語モデルは何をしているのでしょうか。シンボル操作の問題がある場合はいつでも、これらの従来のシンボリック積分マシンの1つを呼び出し、それが正確に何を計算したのか、そしてそれを言語の流れに組み込んで意味をなすようにする方法を理解しようとします。はい。

ディープラーニングでは全く進展しない問題が何百万とあります。はい、非常に興味深いですね。なぜなら、私たちはしばしばニューラルネットワークが有限状態オートマトンであり、チューリングマシンではないという議論をするからです。そして、これは本当に興味深いです。なぜなら、長年にわたり、ルカンとヒントンはこの議論に抵抗していました。

彼らは、原理的にはニューラルネットワークで象徴的な抽象的操作ができない理由はないと主張しようとしていました。しかし、あなたがそれについてとても明確であるのを聞くのは本当に興味深いです。違いがあるということです。いいえ、いいえ。リカレントニューラルネットワークは汎用コンピュータです。はい。

つまり、原理的には、リカレントニューラルネットワークを使えば、ラップトップで計算できることは何でも計算できるのです。それについてですが、1995年の論文があったと思います。それを証明したもので、任意の精度でした。つまり、重みにより多くの精度を追加することで、チューリングマシンのふりをしていたのです。

シーゲルマンとソンタグの論文のことですね。その通りです。はい。そして、それは91年頃だったと思います。しかし、あなたが今言及した理由で、その中の議論はあまり説得力がありません。なぜなら、重みに無限の精度が必要だからです。はい。リカレントネットワークが汎用コンピュータであることを示す私のお気に入りの証明は、それではありません。もっと単純です。

リカレントニューラルネットワークには、これらの隠れユニットがあり、そこにNANDゲート、NOTANDゲートを実装できます。そして、コンピュータサイエンスの最初の演習の1つは、ラップトップの算術処理ユニットや制御ユニットをNANDゲートから構築することです。それができます。

つまり、NANDゲートとリカレントネットワークだけを使って、ラップトップを動かしているものを作ることができるのです。つまり、ラップトップができることは、このリカレントネットワークでもできるのです。無制限と無限は別物です。既知の宇宙には無限のものは存在しません。無制限とは、単に有限だが制限がないということです。

LSTMはリカレントネットなので、入力シーケンスの長さを1つ増やすことで、常に1段階深くすることができます。これは単に、展開されたLSTMが1つ多くの仮想層を持つことを意味します。すでに20年前に、LSTMの残差接続を使って、数万の仮想層を持つ本当に本当に深い展開されたLSTMを通してエラーを伝播させる実用的なアプリケーションがありました。

つまり、ディープラーニングは深さに関するものであり、同じ原理が後のハイウェイネット、つまりこれらのLSTMの原理を使用したフィードフォワードネットワーク、そして半年後のResNetを可能にしました。この宇宙には無限のものは存在しません。無限の精度も、無限のストレージスペースもありません。

つまり、普遍的なコンピュータは存在しません。なぜなら、真に普遍的なコンピュータには無制限の、潜在的に無限のストレージが必要で、リカレントネットワークにはそれがないからです。しかし、リカレントネットワークの限界は、ラップトップの限界とまったく同じです。つまり、実用的な意味では、ラップトップや他のコンピュータと同じくらい強力なのです。

ストレージスペースがもっと必要な場合は、単に大きくするか、ラップトップに追加のストレージを加えればいいのです。同意します。多くの人がそう主張しますが、チューリングマシンが潜在的に無限の状況に対応できるという点で、種類の違いがあるとは言えないでしょうか。つまり、有限のオブジェクトであっても、潜在的に無限のサイズを表現できるのです。

そして、それはメモリを拡張できることによって実現されます。つまり、巨大なニューラルネットワークを持つことができ、それが十分に大きければ、私のラップトップが行うあらゆる計算を表現し実行できます。チューリングマシンのクラスは何か特別なものを与えてくれるのではないでしょうか。しかし、それは単なる理論的な構造です。

チューリングマシンは、1931年にゲーデルが持っていたものの変種です。彼も無制限のストレージを使って証明について語りました。そして、彼は計算と人工知能にも基本的な限界があることを示しました。どのようにしてそれを示したのでしょうか。彼は、計算理論による定理証明手続きで生成できる証明を見ると、ある公理系では証明できない、かつ反対のことも証明できない特定の命題があることを示しました。つまり、それらは決定不能なのです。そして突然、これらの論理的に可能なすべての機械に限界があることがわかりました。プログラムを実行して証明を生成できるようなものです。これらのデバイスは、1931年のゲーデル、1935年のチャーチ、1936年のチューリングとポストのようなものです。

これらはすべて、この宇宙で構築できるものとは何の関係もない理論的な構成物です。なぜなら、この宇宙では、すべてのコンピュータは有限状態オートマトンだからです。まあ、最後の反論ですが、理論的なものに聞こえるかもしれません。なぜそんな議論をするのかと。しかし、良い例があります。Pythonインタプリタは無限の可能性のあるプログラムを解釈できます。

それは無限です。そして、ニューラルネットワークは常に、トレーニングされた有限の数のものしか認識できません。それが私にとっての違いです。はい。しかし、あなたはPythonプログラムの理論的な限界について話していますが、ラップトップで実装できるものは、それほど一般的ではありません。可能なPythonプログラムのほとんどは、ラップトップでは実装できません。ストレージが足りないからです。その通りです。

チューリングマシンやゲーデル符号などについても同じことが言えます。実際には、常に有限状態オートマトンに限定されています。唯一認められるのは、リカレントニューラルネットワークで表現される有限状態オートマトンが、時として他の種類の有限状態オートマトンよりもはるかに非効率的だということです。数の掛け算や定理の証明に優れていたり、スタックなどを持つものです。非常に伝統的ですが、非常に有用な

概念であり、ニューラルネットワークでの実装方法が明らかではありません。原理的には、すべて同じレベルにあります。実用的なコンピュータで実装できるものは、有限状態マシンより優れているわけではありません。しかし、私たちが解決したい実用的な問題のほとんどは非常に単純なので、ストレージの制限はあまり大きな違いを生みません。

計算が拡大してラップトップが十分に大きくないからといって、常にストレージを追加する必要はありません。私たちは実用的な人間であり、現在リカレントニューラルネットワークやトランスフォーマー、あるいは従来の定理証明器で解決できる実用的な問題に限定しています。

最後の反論ですが、ヒラリー・パットナムは多重実現可能性について語りました。例えば、一連のホースや水道管、バケツなどで、あるいは任意のオープンな物理システムでさえ、任意の計算を表現できるということです。私にとっては、表現と一般化の魔法がそこにあるように思えます。

つまり、コンパクトな象徴的表現を持ち、潜在的に無限に多くの状況で機能する可能性があるものです。なぜなら、それは確かにAIを行う優れた形式だと思うからです。何かを行うすべての異なる方法を暗記するのではなく。はい、しかしこれらの間に線を引くのは非常に難しいです。以前、パリティについて話したことを覚えていますか。トランスフォーマーがパリティの背後にある論理を学習さえできないことを学びました。

パリティは非常に単純です。0100は1ビットの数が奇数か偶数かということです。そのような質問です。リカレントネットワークはニューラルネットワークであり、簡単にそれを解決できます。なぜなら、その問題を解決するには、フリップフロップになることを学ばなければならないからです。その問題を解決する方法は、ビットを1つずつ読み込み、最初のビット、2番目のビットと読み、それを持っています。

1つの再帰的接続を持つ非常に小さなリカレントネットワークがあり、隠れユニットから自身への接続があります。新しい1が入ってくるたびに、内部状態が1.0から0.0に切り替わるようにワイヤリングされています。そして、この非常に単純なデバイスは、小さな論理回路のように見えますが、トランスフォーマーができないパリティを解決できます。

ここで、これらの小さな論理デバイスとリカレントネットワークの違いは正確にどこにあるのでしょうか。まあ、その小さな論理回路は単にリカレントネットワークの特殊なケースです。つまり、論理回路でできることはすべて、リカレントネットワークでできます。だからこそ、80年代からリカレントネットワークにとても魅了されてきました。なぜなら、それらは汎用コンピュータだからです。この宇宙には存在しない普遍的な意味ではありませんが、非常に一般的な意味で

必要なときに少しずつストレージを追加するだけで真に普遍的にすることができ、それで十分だということです。私はそう思います。RNNが計算モデルとしての基板と、トレーニング可能なニューラルネットワークとしての有用性の間には区別があると思います。なぜなら、1991年の論文はSGDでトレーニング可能ではなく、単にRNNがチューリングマシンのように振る舞うように情報を入力するパターン化された方法だったと思うからです。ここで問題なのは

私たちはそれらをトレーニング可能にしたいということです。私たちはそれらを有用にしたいのです。はい、それは問題です。なぜなら、パリティを学習するこの小さなネットワークを見てください。接続は5つしかありません。入力ユニットがあり、隠れユニットがあります。そして出力ユニットがあります。そして今、私たちは2つの接続を持っています。

おそらく常にオンになっているバイアスユニットから来る追加のバイアス重みがあるかもしれません。そうすると3つの接続があります。そして隠れユニットから自身への再帰的接続があります。では、トレーニング前のトレーニング例からどのようにして正しいものを実装することを学習するのでしょうか。勾配降下はそれにあまり適していないことがわかります。

できる最善のことは、すべての重みを-10から10の間でランダムに初期化し、このデバイスがパリティを解決するかどうかを確認することです。3つのトレーニング例があります。1つは3ビットの長さ、もう1つは15ビット、そしてもう1つは27ビットの長さです。これら3つのトレーニング例をすべて解決できれば、すべての長さのパリティ文字列に一般化できるとほぼ確信できます。

つまり、フィードフォワードネットワークよりもはるかに強力です。なぜなら、9つの入力を持つ9ビットのパリティを解決するようにフィードフォワードネットワークをトレーニングすると、そのための方法はありますが、10ビットや11ビットには一般化されません。しかし、この小さなリカレントなものはそれを行います。

すべての種類のパリティ入力に一般化されます。はい。ここでは、ランダムな重み探索という非伝統的な学習アルゴリズムがあります。1000回試すだけです。重みの初期化がトレーニングセットの3つの要素を解決するかどうか。

そして、それはほぼ確実にはるかに大きなテストセットに一般化されます。つまり、これは珍しい学習アルゴリズムですが、非常に良いものです。なぜなら、数百回の試行で、これが実際に古い1997年のLSTM論文の例の1つであることを学習するからです。勾配降下を通じて学習したくないものがいくつかあります。

いいえ、より良い方法があり、離散的なプログラム探索があります。リカレントネットワークのプログラムは、もちろん重み行列です。そして、多くの場合、勾配降下は行き詰まり、本当に欲しいものを見つけることができません。しかし、これらの重みや、このネットワークのプログラムの中で他の種類の探索を行えば、それらは機能します。

そして、1987年以来の過去の出版物を見ると、常に純粋に象徴的な、明らかに象徴的なものがたくつずいます。証明の探索に関するものや、2003年のoopsや、ディープラーニングを全く気にしない最適な自己改善機であるゲーデルマシンのような漸近的に最適な問題解決器があります。

それは非常に異なる種類の機械です。そして、誰も特定の問題でうまく機能することを証明できないニューラルネットワークがあります。しかし、実際の経験では、それらは本当に有用です。これらの象徴的なアプローチとあまり象徴的でないアプローチの境界を見つけることは不可能です。

それらは完全にぼやけています。90年代初頭には、サブゴールジェネレータがあり、象徴的なことのように聞こえますが、いいえ、それは勾配降下を通じて実装されました。目標を達成するために実行しなければならないアクションシーケンスを意味のあるチャンクに分解することを学習するシステムでした。スタートからゴールへ、そしてスタートからサブゴールへ、サブゴールからゴールへと進むのです。少し象徴的に見えるこれらのことはすべて、ニューラルネットワークで行えることを示しました。さらに勾配降下によって学習できることも示しました。しかし、勾配降下を完全に失敗させる他の問題もありました。つまり、勾配降下をすべてを解決する神聖なアプローチに高めたくはありません。いいえ。

勾配降下では解決できない問題が何百万とあります。これは、ニューラルネットワークにとって問題だということではありません。なぜなら、ニューラルネットワークは勾配降下以外の多くの方法でトレーニングできるからです。さて、この部分の締めくくりとして、これは魅力的です。なぜなら、あなたはキャリアの多くをメタ学習について話すことに費やしてきました。これは2次または3次以上の学習のことです。

そして、おそらく、あなたが言及していたように、そのメタ学習のはしごで、モダリティを混ぜることができるかもしれません。確率的勾配降下があり、次に象徴的モードがあり、次にパターン化されたメタメタ推論モードがあるかもしれません。そして、Arcチャレンジに取り組んでいるすべての人々にとって、彼らは今、この種の離散的なプログラム検索を行っており、上位にメタパターン化されたニューラル検索を持つことを実験しているか、または完全に異なるものを実験しています。

あなたのアプローチはどのようなものでしょうか。これらの問題の性質を見なければなりません。私は見ていませんが、これらの問題の多くに対して、おそらく最適順序問題ソルバーのようなものが欲しいでしょう。これは、与えられた計算問題を解決するプログラムを見つけるための漸近的に最適な方法です。ここで、問題の検証時間が解の大きさに線形であるため、安価な検証が可能です。

それは重要なことです。これはPとNP問題に関連しています。そして、そのようなプログラム検索を行う最適で漸近的に最適な方法があります。それは1973年のレビンにさかのぼります。これらのプログラムの中で普遍的探索と呼ばれています。そして最適順序問題ソルバーは、この古い方法に基づくカリキュラム学習アプローチであり、以前に解決された問題の解であるプログラムを与えられた新しい問題を常に解決します。

そしてそれを漸近的に最適な方法で行います。この方法は、ニューラルネットワークやディープラーニングを全く気にしません。しかし、論文では、プリミティブな命令としてニューラルネットワークを使用できると言及しています。そして、それらがどれだけの時間を消費するかを測定します。つまり、テストしているすべてのプログラムにランタイムを割り当てる最適な方法があり、単純で高速なプログラムに対する非常に強いバイアスを表現する方法です。

そして、これらのプログラムは、あらゆる種類のプリミティブな命令を持つことができます。そしてプリミティブな命令は、再び本当に複雑なものになる可能性があります。トランスフォーマーのバックプロパゲーションなどかもしれません。しかし、消費される時間を測定する必要があります。

現在のフェーズで時間を消費しすぎる場合は中断し、検証が容易な解を見つけようとしているこれらのプログラムすべてにますます多くのランタイムを割り当てています。検証時間も考慮する必要があります。そして、これらはすべて非常に象徴的に聞こえますが、同じ原理を90年代にすでにニューラルネットワークにも適用しました。

つまり、これは勾配降下ではない、ニューラルネットワークの重み行列を探索する非伝統的な方法にすぎません。これは実際に多くの点でずっと賢く、幸運なら、はるかに優れた一般化結果につながります。なぜなら、これらの方法が本質的に行おうとしているのは、与えられた問題を解決する最短で最速の方法を見つけることだからです。

基本的に、ランタイム制約の下で、あるニューラルネットワークのアルゴリズム的複雑性またはコルモゴロフ複雑性を最小化しようとしています。はい。そこで、この伝統的な象徴的推論や伝統的なプログラム探索と、ニューラルネットワークと呼ばれるこれらのファジーなものとの間に、あらゆる種類の重なりがあります。

MITのダニエル・ロバートの理論は興味深いですね。彼の理論では、ニューラルネットワークのアスペクト比、つまり幅と深さの関係を考慮に入れています。彼はトレーニングのダイナミクスを見ていました。つまり、一種の繰り込み群としてモデル化していました。そして、幅と深さと初期化に基づいて、最適なトレーニングダイナミクスを与えるニューラルネットワークの最適な構成を見つけることができる一種の臨界性があることがわかりました。

それについて考えるのは実際に興味深いことです。なぜなら、ディープラーニングの壮大な理論はあまりないからです。しかし、あなたがそれに精通しているか、または何か考えたことがあるかどうか知りたいと思いました。はい、いくつかの理論について。その特定の論文には精通していません。しかし、あなたの言い方を見ると、従来の学習アルゴリズム、つまり勾配降下に条件付けられているように思えます。そうですね。はい。

一般的に言えば、多くの場合、本当に単純な解を見つけようとする場合、つまり問題を解決するネットワークの重みを計算する短いプログラムを見つけようとする場合、勾配降下とは非常に異なる別の学習アルゴリズムが必要です。そして、私たちは90年代初頭からまさにそれに関する多くの出版物を持っています。

ネットワークを圧縮したいのです。コルモゴロフ複雑性が低く、アルゴリズム的情報量が少ないネットワークを見つけたいのです。つまり、このネットワークを生成し、計算するプログラムができるだけ小さくなるべきです。これは以前、スーパージェネライザーについて議論したときに言及したことです。例えば、異なるサイズの3つのトレーニング例からパリティを学習し、パリティの世界が提供するすべてに一般化できるものです。そしてその世界は大きいです。なぜなら

その世界には無限に多くのビット列があるからです。つまり、それを再度説明すると。私はそれが聴衆にとって非常に興味深い洞察だと思います。あなたは、ニューラルネットワークを生成するプログラムが、可能な限り小さな最小記述長を持つべきだと言いました。その通りです。はい。

これは1994年に初めて行ったことを思い出させます。その論文は「コルモゴロフ複雑性の低い解の発見」と呼ばれ、1997年には「コルモゴロフ複雑性の低いニューラルネットワークの発見」がありました。そこでは勾配降下を使用しませんでした。いいえ、最適な普遍的探索の原理を使用して、トレーニングセットで機能するニューラルネットワークを見つけました。

そして、それらが従来のニューラルネットワークでは完全に不可能な方法でテストセットに一般化されることがわかりました。なぜでしょうか。なぜなら、探索はプログラム空間で行われたからです。つまり、象徴的なプログラム空間です。今、私たちはシンボル対サブシンボルに戻っています。それはアセンブラのようなプログラムの空間でした。

そしてこれらのプログラムの出力は、ニューラルネットワークの重み行列でした。そして今、問題を解決したいのですが、そのようなニューラルネットワークの重み行列を計算する最短のプログラムを見つけたいのです。そして私たちはそれを行いました。そして、この普遍的探索の概念を使用して、短くて高速なプログラムに多くのランタイムを割り当てることで、従来の勾配ベースのニューラルネットワークでは不可能な方法で一般化することができました。当時はそれほどうまくスケールしませんでした。

しかし、私たちはそのことに立ち返る必要があります。なぜなら今、同じ価格で100万倍の計算力を持っているからです。あなたが言うように、あなたのアルゴリズムは今やほとんどすべてのスマートフォンにあります。誰が資金を提供したのでしょうか。資金の大部分はヨーロッパの納税者によって提供されました。私はスイスとドイツ、そして一般的にはヨーロッパ連合から公的資金を獲得しました。

90年代から2000年代初頭のいわゆるニューラルネットワークの冬の間、ニューラルネットワークに興味を持つ人がほとんどいなかったときに、この分野を少し生き延びさせようとしていました。特に、LSTMや生成的敵対ネットワーク、関連トピックに関するスイス国立科学財団の長期にわたる一連の助成金がありました。

これらの以前の例はすべて、ラベルが人間によって生成された教師あり学習の例でした。1987年以来、あなたははるかに一般的なバージョン、つまり明示的な教師がない強化学習に取り組んでいました。それについて教えてください。

AGIを解決したいなら、基本的に強化学習に取り組む必要があります。システム自体が世界を探索し、それがどのように機能するかを学習し、そして人間のフィードバックなしにあらゆる種類の問題を解決することを学習する場合です。例えば、2007年に、私の元PhD学生のダン・ヴァイアストラスや他のチームメンバーと一緒に、ポリシー勾配と呼ばれるものがありました。これは、通常は教師あり設定で使用されるLSTMに適用された強化学習手法です。しかし、他の方法でもトレーニングできます。ポリシー勾配を通じてです。そして、複雑な設定で強化学習を行うことができます。過去に何が起こったかを記憶する必要がある設定です。もはや当時何が起こったかを見ることはできません。つまり、記憶を持つ必要があります。そして1000ステップ後に、おそらくビデオゲームで生き残るためのアクションを計算することが重要になります。

そして、ダン・ヴァイアストラは実際に後にDeepMindの最初の本当の従業員になりました。はい。彼はシェイン・レッグと友人だったと理解しています。そうですね。シェイン・レッグは、私の研究室の別のPhD学生で、マーカス・ハッターと一緒に働いていました。AIと普遍的AIの天才です。数学的に最適な普遍的AIです。当時、私の助成金で普遍的AIに取り組んでいました。

シェイン・レッグはDeepMindの共同創設者です。そして、おそらく次に良かったのは、ダンをチームに加えることでした。LSTMのポリシー勾配についてもっと教えてください。LSTMのポリシー勾配は本当に重要になりました。例えば、2019年にDeepMindは、チェスやGoよりもはるかに難しいゲームであるスタークラフトでプロのプレイヤーを打ち負かしました。チェスでは、8×8の小さな入力フィールドしかありません。そして、それが次の可能な動きと最良の可能な動きについて知る必要があるすべてです。しかし、ビデオゲームでは、過去に何が起こったかを記憶する必要があります。敵が角の後ろに隠れていないでしょうか。そして、私がそこに移動するとすぐに撃ってくるかもしれません。なぜなら、私は彼を見失ったからです。そのようなことです。

また、2018年にOpenAIは、ポリシー勾配でトレーニングされたLSTMを使用して、Dotaビデオゲームで最高の結果を出しました。そのLSTMは、総パラメータ数の約84%を占めていました。いくつかの追加のネットワークもありました。そして、ビル・ゲイツはそれを「AIを進歩させる上で大きなマイルストーン」と呼びました。はい。

そして、トランスフォーマーやその他の教師あり学習での成功の後でさえ、LSTMのポリシー勾配は非常に注目に値します。実際に興味深いのは、あなたが言ったことに基づくと、主要なAIラボ、つまりOpenAIやDeepMindなどが使用しているテクノロジーに、あなたが大きく関わっているように聞こえることです。はい。

そして、彼らが私たちのDNAを受け継いでいることは明らかです。

コメント